书生大模型Demo

- 1 大模型InternLM介绍

- 2 Demo

- 2.1 InternLM-Chat-7B智能对话Demo

- 2.1.1 环境配置

- 2.1.2 模型下载

- 2.1.3 代码准备

- 2.1.4 运行Demo

- 2.2 Lagent智能体工具调用Demo

- 2.3 浦语 灵笔图文创作理解Demo

- 3 作业

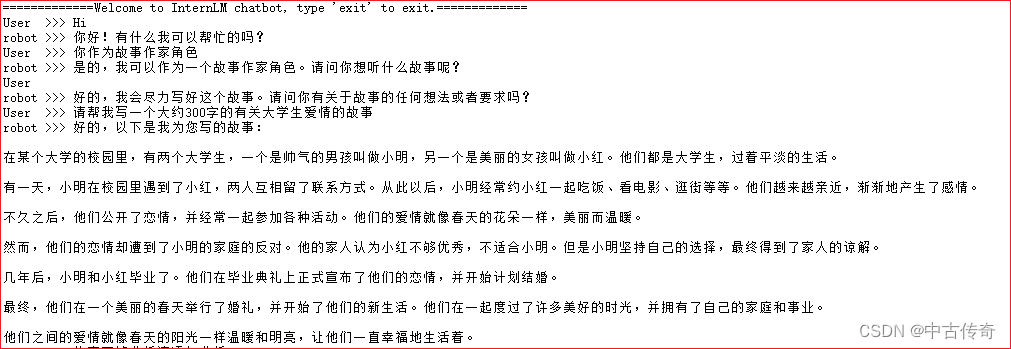

- 3.1 使用模型生成300字小故事

- 3.2 Lagent工具调用Demo创作部署

实践是最好的老师;

1 大模型InternLM介绍

大模型:AI中参数数量巨大,消耗巨大计算资源的模型;

特点:1.利用大量数据训练;

2.拥有数十亿及以上的参数;

3.在较为通用任务重展示出良好性能;

在InternLM模型全链条开源中 概念介绍:

- InternLM是一个开源的轻量级训练框架,旨在支持大模型训练而无需大量的依赖;基于InternLM训练框架,两个开源的预训练模型:InternLM-7B和InternLM-20B;

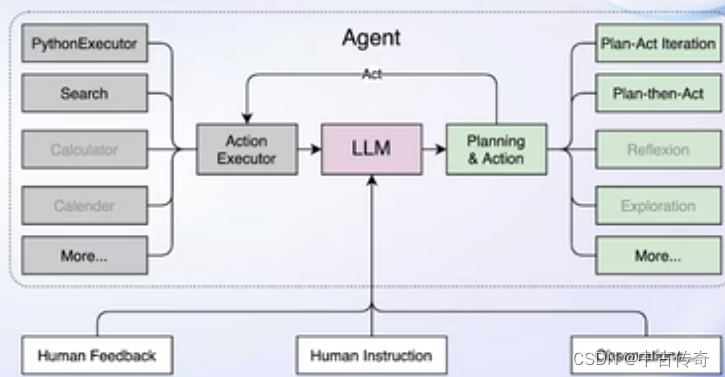

- Lagent是一个轻量级、开源的基于大语言模型的智能体(agent)框架;通过Lagent可以更好的发挥InternLM模型的全部性能;

- 浦语 灵笔是基于书生大语言模型开发的视觉语言大模型,有出色的图文理解和创作能力,可以创作一篇图文推文。

2 Demo

2.1 InternLM-Chat-7B智能对话Demo

模型介绍:InternLM支持在数千个GPU的大型集群上进行预训练,并在单个GPU上进行微调,实现性能优化。

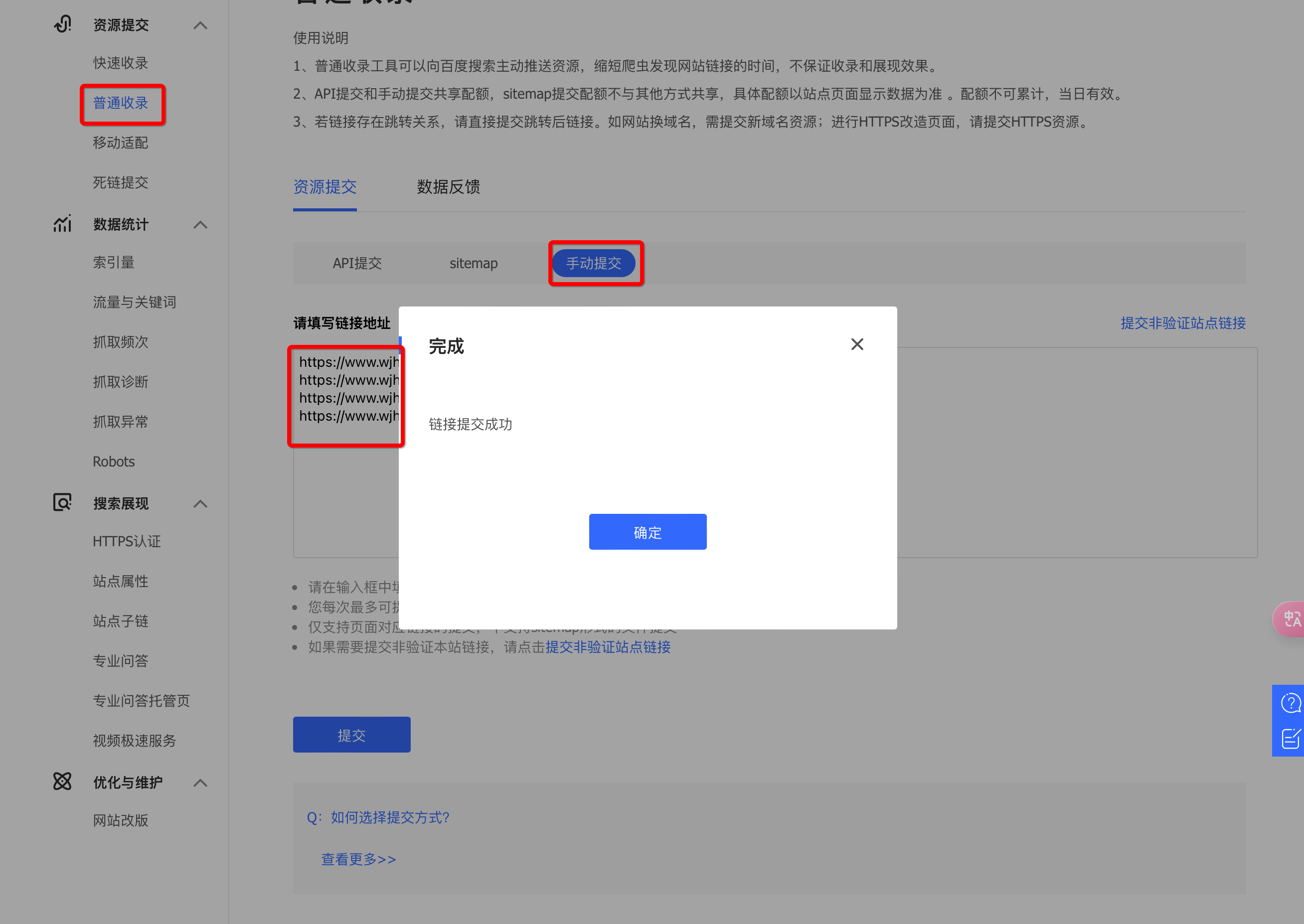

2.1.1 环境配置

1.pip 更新和换国内源;–老生常谈;update and upgrade

2.clone pytorch env and activate internlm-demo

3.install the dependency needed by demo to run

2.1.2 模型下载

可以直接从github上clone,在这里已经事先准备好了,直接copy即可。

#激活环境

conda activate internlm-demo

#upgrade pip and install dependency2.1.3 代码准备

clone code

cd /root/code

git clone https://xxx//xx/xx

2.1.4 运行Demo

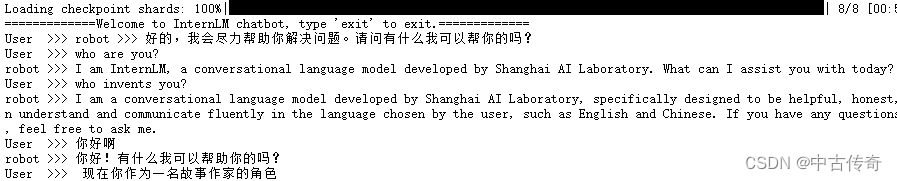

1.终端运行

在上面git clone的InternLM目录下新建一个cli_demo.py文件,放入脚本;

python ./cli_demo.py

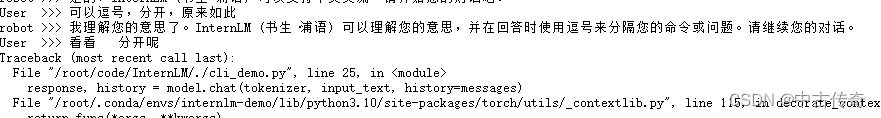

由于cli_demo的缺陷,导致input text只能特定支持逗号分隔符,否则就会报错。

不断交互去训练它,所以prompt很重要;

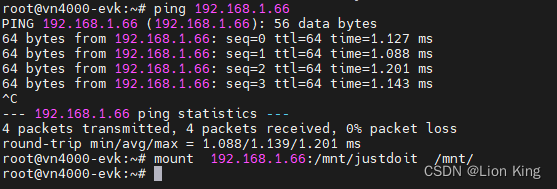

2.Web运行

本地映射服务器的端口,通过SSH隧道技术;

一定要SSH -L 连接远程,-L参数允许端口转发;

2.2 Lagent智能体工具调用Demo

Lagent是一个轻量级开源的大语言模型的智能体(agent)框架,快速地讲一个大语言模型转变为多种类型的智能体,提供典型工具进行模型赋能。

2.3 浦语 灵笔图文创作理解Demo

InternLM-XCcomposer

3 作业

3.1 使用模型生成300字小故事