背景

有一个任务 yyyy写成了YYYY,导致年份不对触发告警

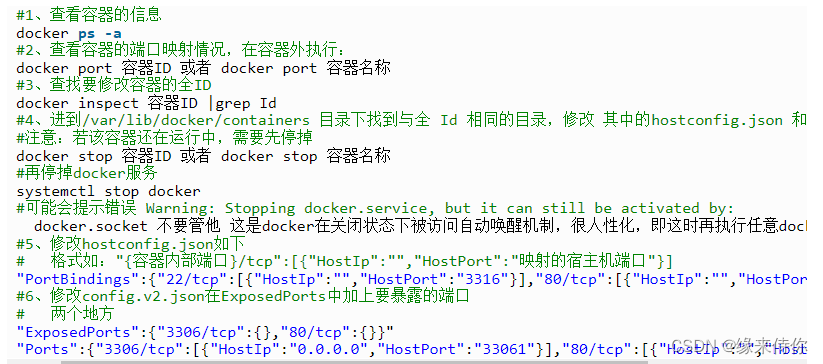

select from_unixtime(unix_timestamp(),'YYYY-MM-dd HH:mm:ss')

第一时间用spark dateformat搜索下看看官网,发现spark 官网也没有描述YYYY的信息

Datetime patterns - Spark 3.5.0 Documentation

从源码找原因

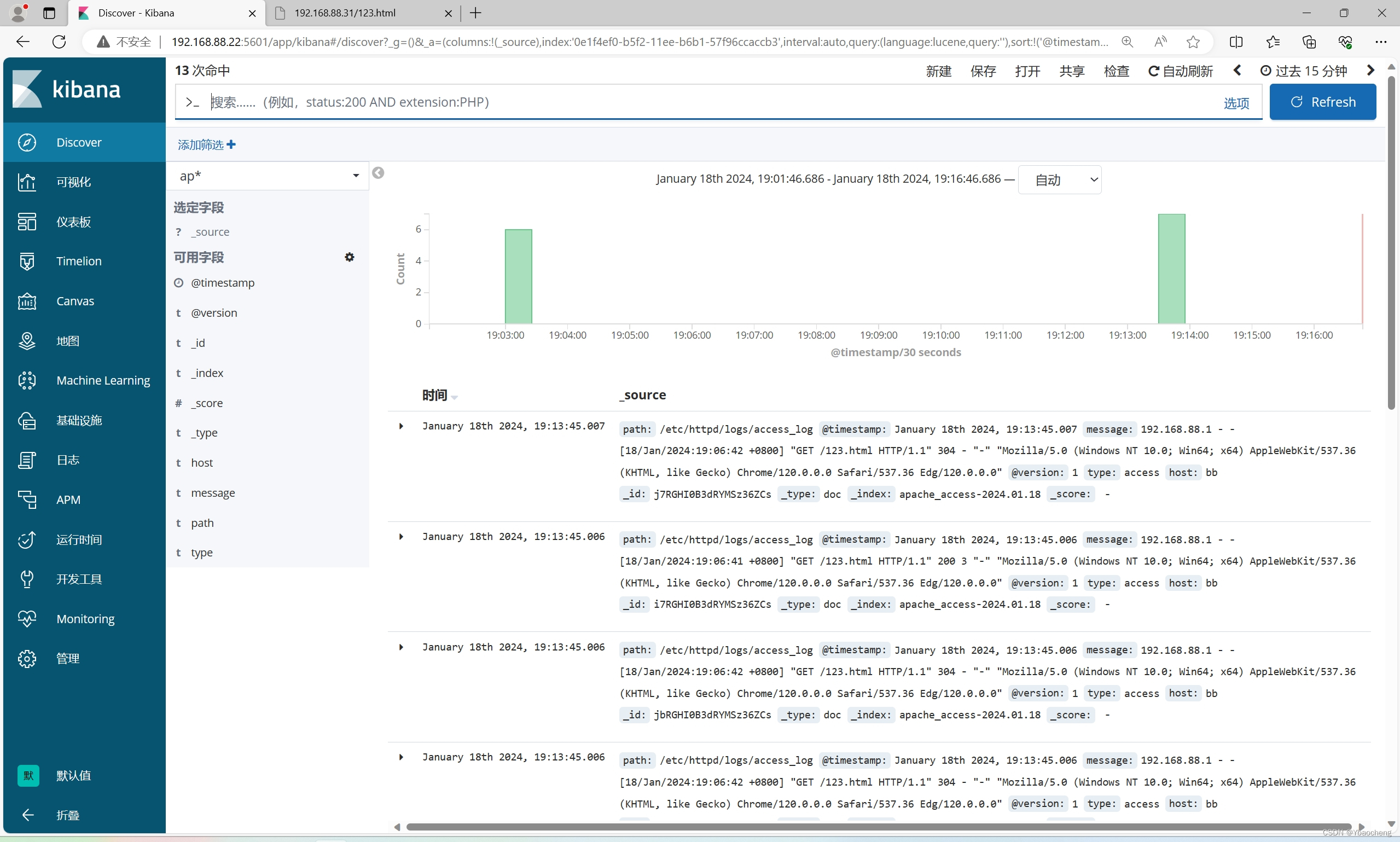

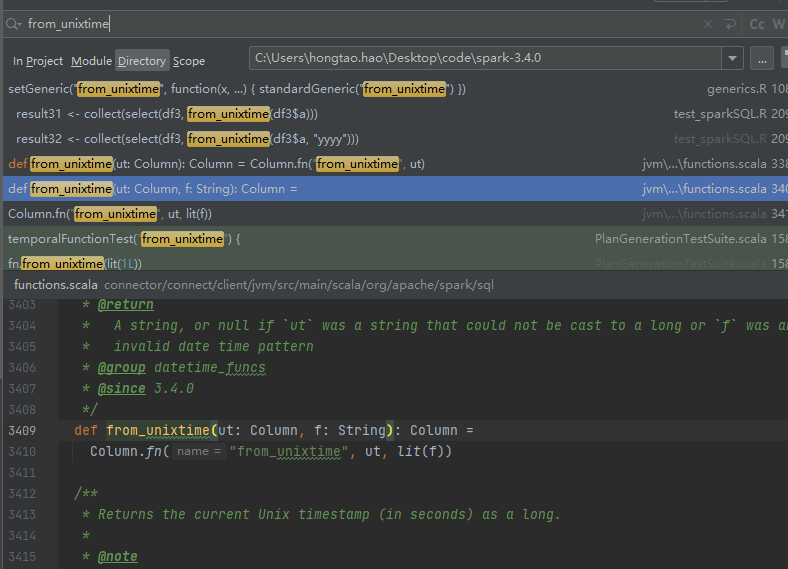

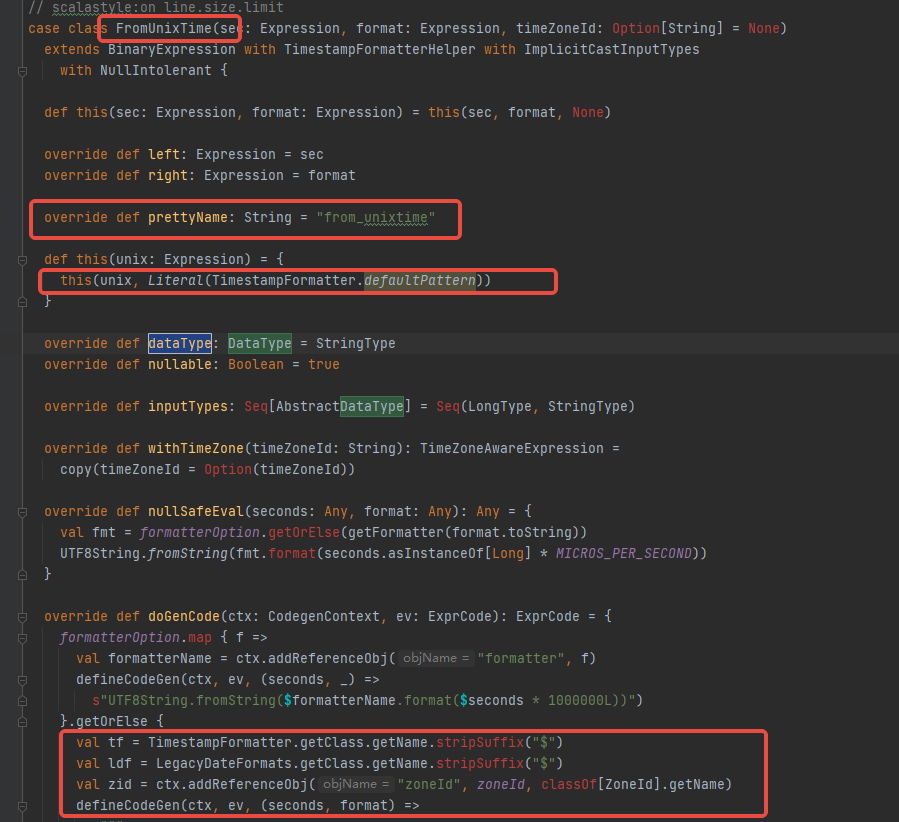

先搜下from_unixtime函数

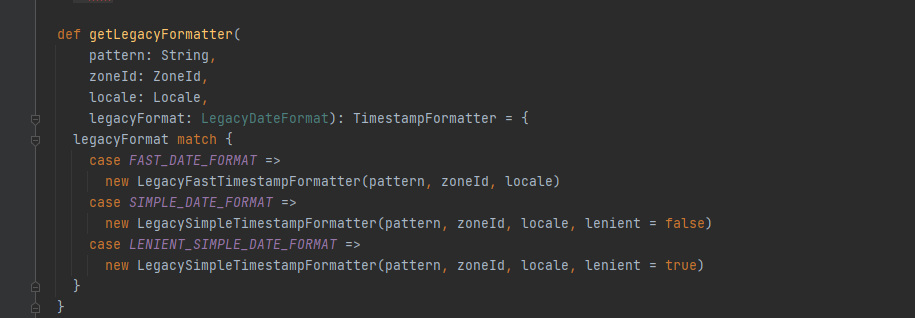

然后找到这个函数,一直点进去

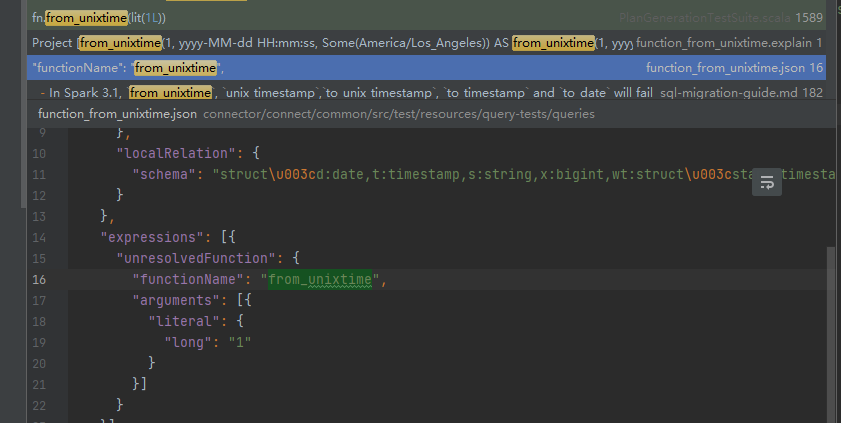

接着点进去,找到这段

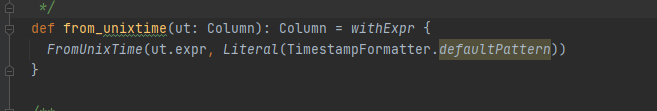

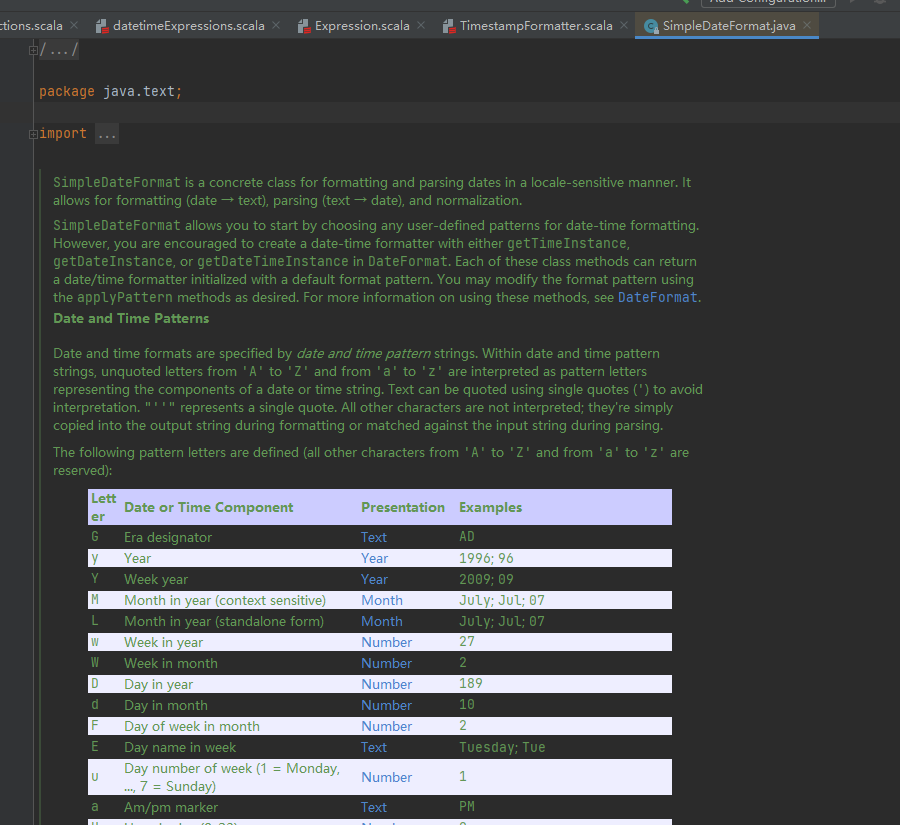

随便找一个 SimpleDateFormat 点进去

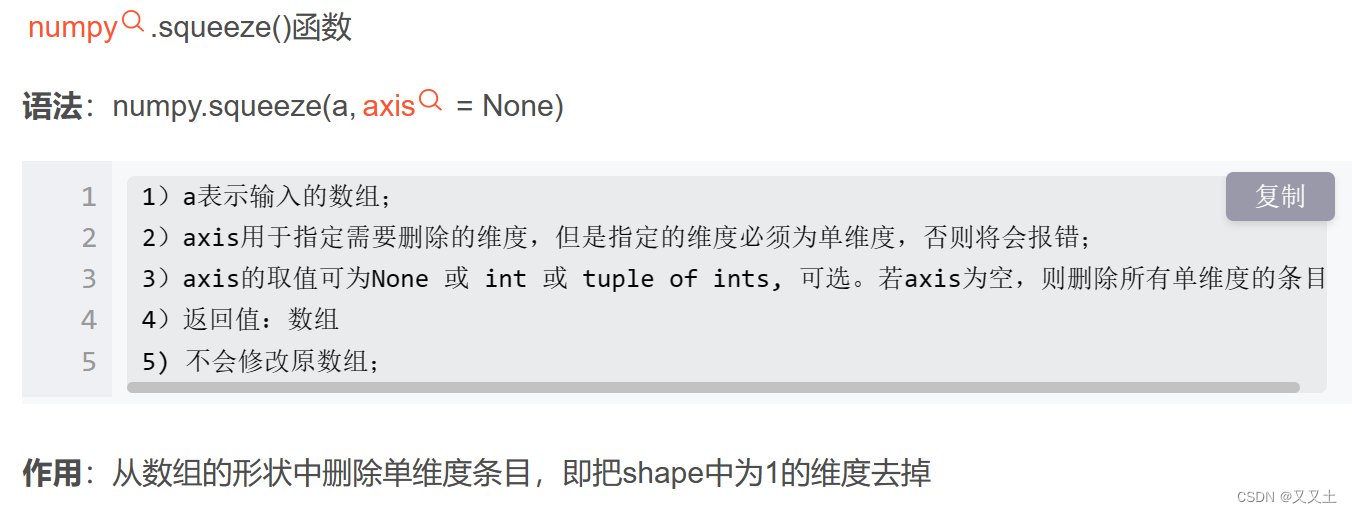

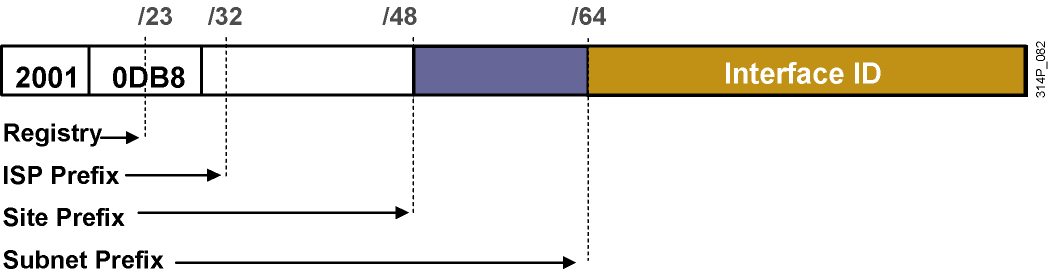

这个其实还是用的jdk的format,这个Y是代表了Week year ,确实里面很多都没用过