核心结论

1:LLM模型的性能主要与计算量C,模型参数量N和数据大小D三者相关,而与模型的具体结构 (层数/深度/宽度) 基本无关。三者满足: C ≈ 6ND

2. 为了提升模型性能,模型参数量N和数据大小D需要同步放大,但模型和数据分别放大的比例还存在争议。(参见下篇文章)

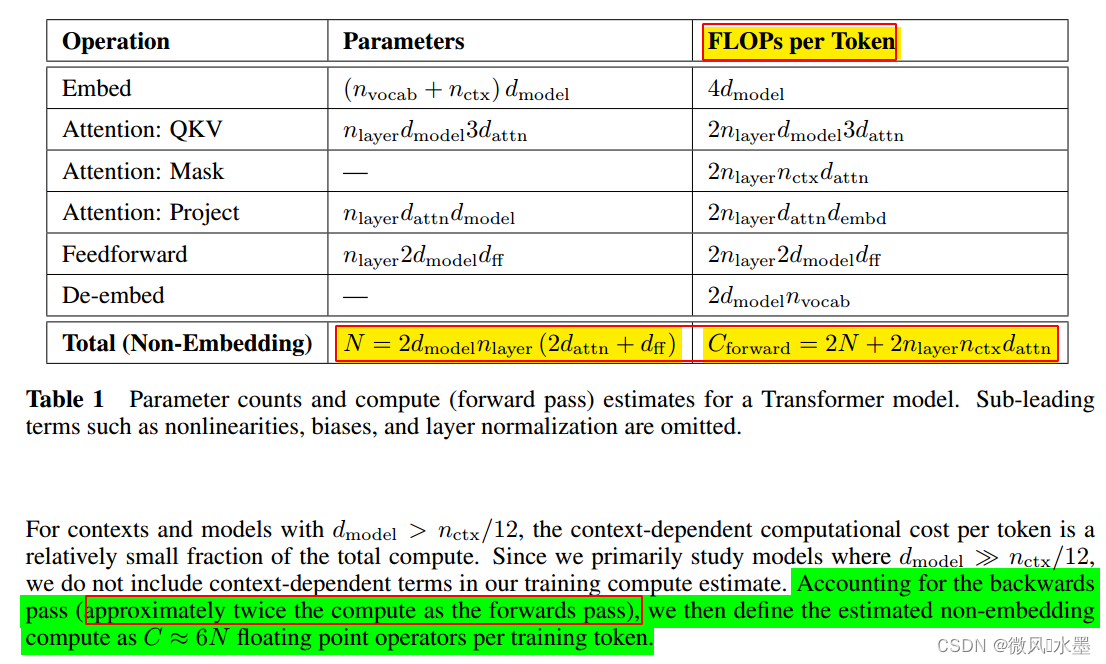

首先看一下核心结论1是怎么推导得到的。

针对transformer结构:Parameters 参数量(不含embedding层)为N,每个Token前向传播消耗运算量C 约为 2N,反向传播的运算量又是前向传播运算量的两倍,所以每个Token需要花费的运算量C 约为 2N + 2*(2N) = 6N。现在Token的数量为D,所以总的运算量为C = 6N*D。

核心公式:本部分来自参考2.

- 第一项

是指无法通过增加模型规模来减少的损失,可以认为是数据自身的熵(例如数据中的噪音)

- 第二项

是指能通过增加计算量来减少的损失,可以认为是模型拟合的分布与实际分布之间的差。

根据公式,增大 (例如计算量C),模型整体loss下降,模型性能提升;伴随

(例如计算量C) 趋向于无穷大,模型能拟合数据的真实分布,让第二项逼近0,整体趋向于

结论验证

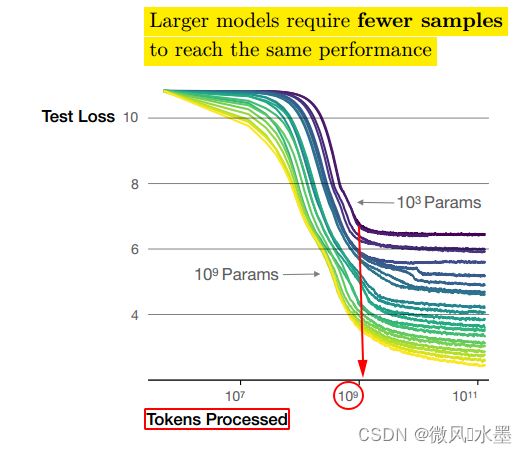

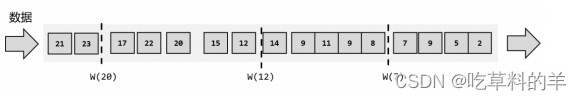

从图上可以看出:

1:当模型的参数量 N 为时(图中紫色的线),在 Token 数量达到

后(图中红色的圈),模型基本收敛,继续增加训练的 Token 数量,纵轴的Test Loss 并没有明显下降。

2:如果此时,增加模型的参数量N:->

。 纵轴的Test Loss:从6.x->3.x。可以看出:提升模型参数量带来的收益更大。

思考一个问题:基于上图,当模型的参数量 N 为时(图中紫色的线)

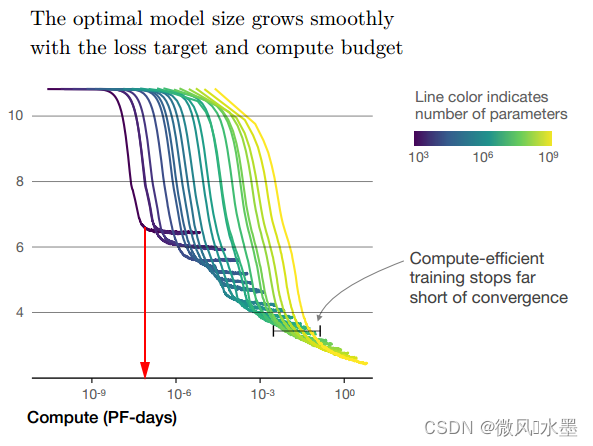

(1)模型达到收敛状态时需要消耗的算力C是多少?

(2)模型达到收敛状态时的耗时是多久呢?

先看答案:下图红色箭头指向位置,也就是图中紫色线的拐点。

1:算力消耗:

2:耗时:

如果没做实验,怎么知道上面的答案呢?

根据核心公式1,得到:

Tips:

PF-days: 如果每秒钟可进行1015次运算,就是1 peta flops,那么一天的运算就是1015×24×3600=8.64×1019,这个算力消耗被称为1个petaflop/s-day。

再看个例子:

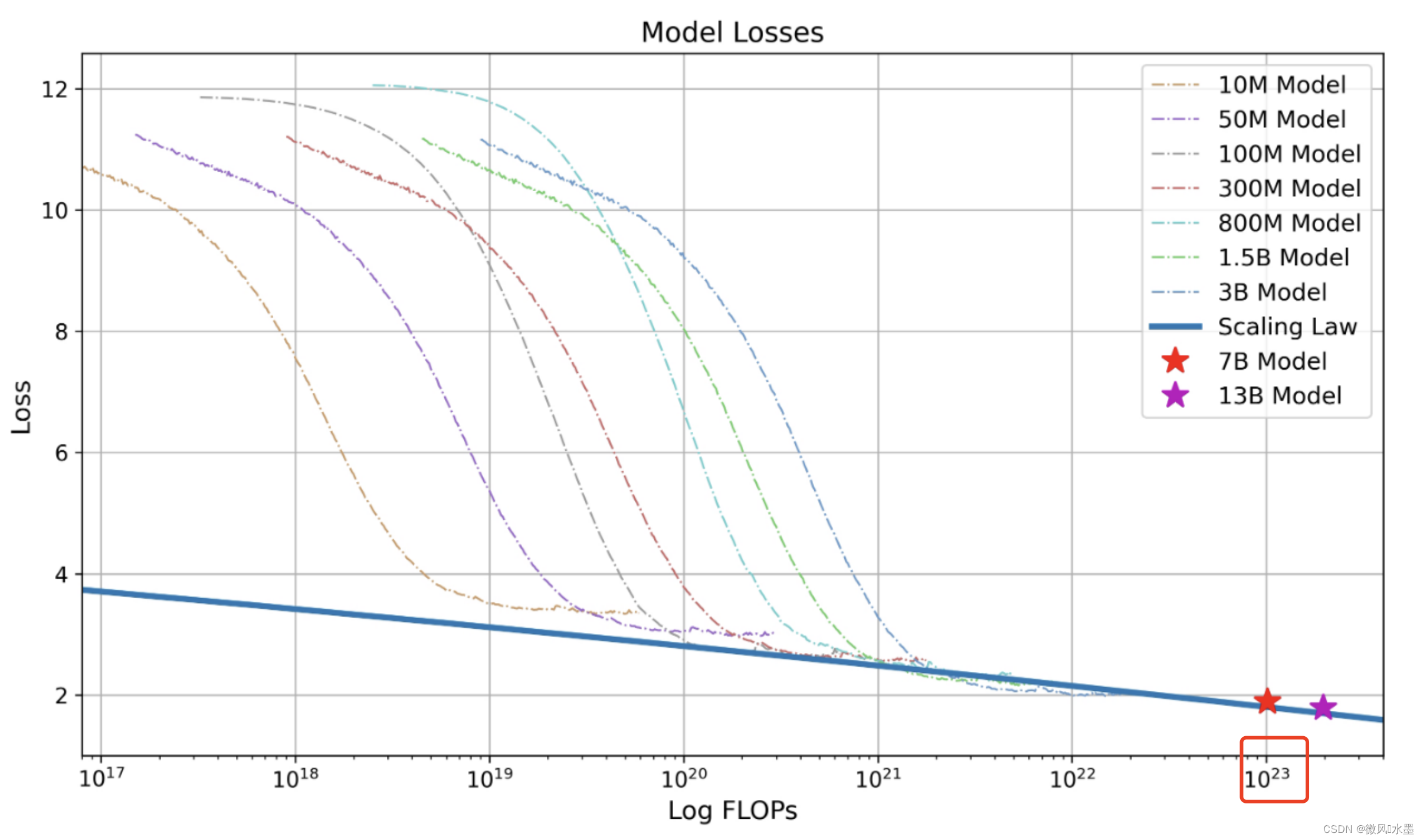

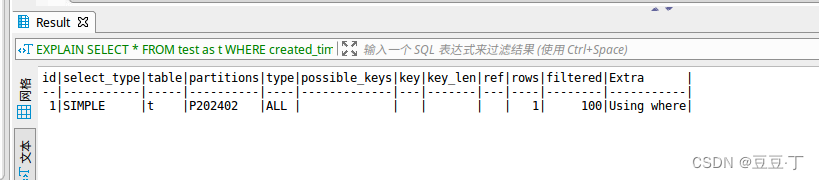

下图是Baichuan-2技术报告中的Scaling Law曲线。基于10M到3B的模型在1T数据上训练的性能,可预测出最后7B模型和13B模型在2.6T数据上的性能。

问题1:在1T的数据上,训练的10M-3B的模型,是怎么推算训练7B/13B需要2.6T数据呢?

2.38T 是理论数值,与 2.6T基本一致了。

问题2:7B/13B模型的理论损失是多少呢?

将10M->3B不同尺寸的模型,训练到收敛状态,即上图,将每个模型的loss拐点记录进行拟合,得到幂函数(上图中蓝色粗线-scaling law),将C = 带入拟合函数,就可以得到7B/13B模型的理论预期Loss了。

参考

1:介绍一些Scaling Laws - 知乎

2:解析大模型中的Scaling Law - 知乎

![[一]ffmpeg音视频解码](https://img-blog.csdnimg.cn/direct/e87df84551d44320aa1e464c35f7b8fb.png)