前言:Hello大家好,我是小哥谈。YOLOv8是一种目标检测算法,它是YOLO(You Only Look Once)系列算法的最新版本。本节课就带领大家如何基于YOLOv8来训练自己的目标检测模型,本次作者就以安全帽佩戴检测为案例进行说明,让大家可以轻松了解整个模型训练过程!~🌈

目录

🚀1.算法介绍

🚀2.数据标注

🚀3.模型训练

🚀1.算法介绍

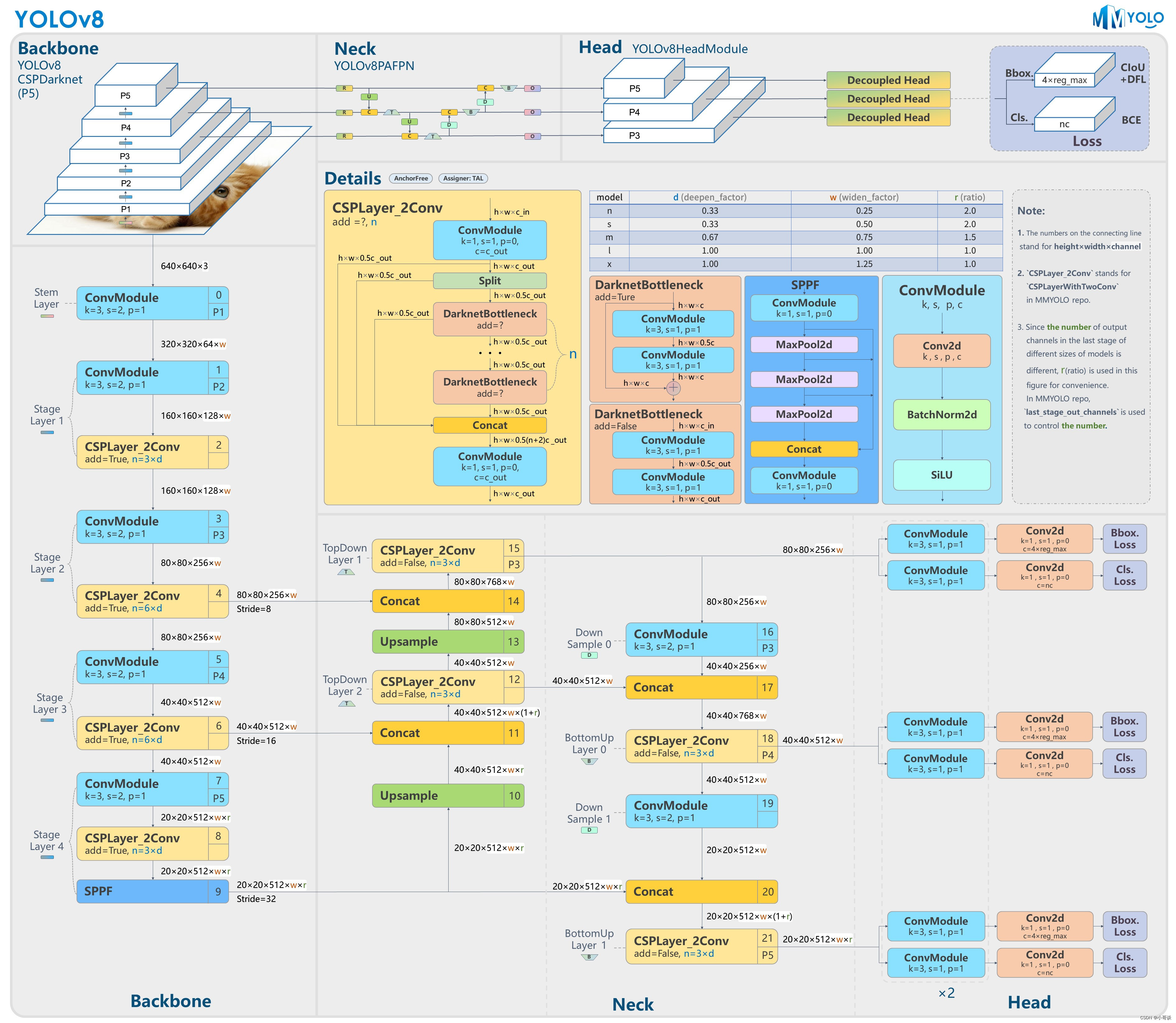

YOLOv8是一种目标检测算法,它是YOLO(You Only Look Once)系列算法的最新版本。YOLOv8采用了一种单阶段的检测方法,可以实时地在图像或视频中检测出多个目标物体的位置和类别。YOLOv8的核心思想是将目标检测任务转化为一个回归问题,通过一个卷积神经网络将输入图像映射到一个固定大小的特征图上,并在特征图上进行目标的位置和类别的预测。相比于传统的两阶段方法,YOLOv8具有更快的检测速度和更高的准确率。

YOLOv8的网络结构采用了Darknet作为基础网络,通过多个卷积层和池化层提取图像特征,并通过全连接层进行目标的位置和类别的预测。此外,YOLOv8还引入了一些技巧来提升检测性能,如使用多尺度特征图进行目标检测、使用Anchor Boxes来处理不同尺度的目标等。

YOLOv8的主要特点包括:

- 高速度:YOLOv8能够实时地进行目标检测,达到了非常快的检测速度。

- 高准确率:YOLOv8在保持较快速度的同时,也具备较高的检测准确率。

- 多尺度检测:YOLOv8可以在不同尺度的特征图上进行目标检测,从而能够检测到不同大小的目标物体。

- 多类别检测:YOLOv8可以同时检测多个不同类别的目标物体。

总结来说,YOLOv8是一种高效准确的目标检测算法,可以广泛应用于实时物体检测、视频监控、自动驾驶等领域。

YOLOv8官方仓库地址:

GitHub - ultralytics/ultralytics: NEW - YOLOv8 🚀 in PyTorch > ONNX > OpenVINO > CoreML > TFLite

作者在官网下载后,将含有预训练权重文件的YOLOv8完整源码进行了上传,大家可自行下载。

🚀2.数据标注

利用labelimg或者make sense软件来标注数据,关于如何使用labelimg或者make sense软件来为自己的数据集打上标签,请参考作者专栏文章:

说明:♨️♨️♨️

数据标注工具的使用教程:

YOLOv5入门实践(1)— 手把手教你使用labelimg标注数据集(附安装包+使用教程)

YOLOv5入门实践(2)— 手把手教你使用make sense标注数据集(附工具地址+使用教程)

🚀3.模型训练

第1步:准备数据集

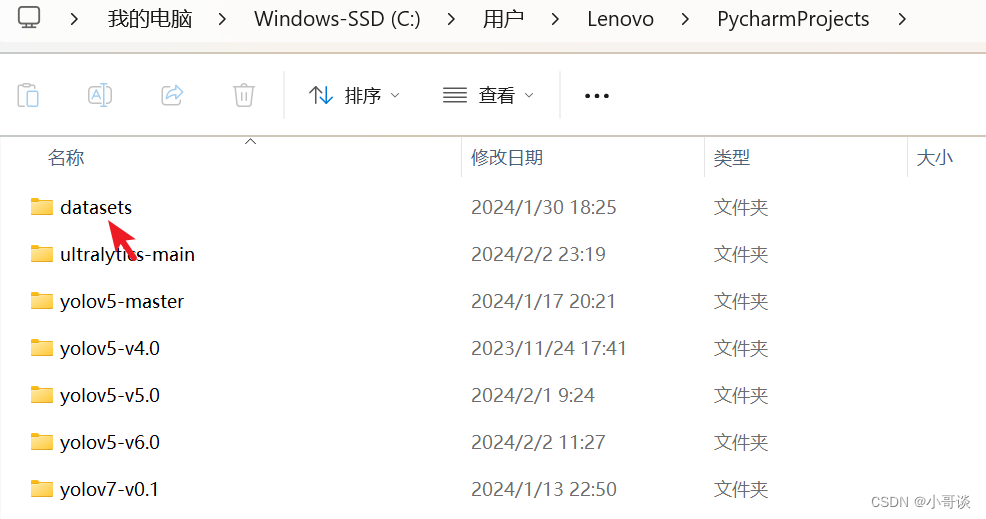

将数据集放在datasets文件夹中。datasets属于放置数据集的地方,位于PycharmProjects中,C:\Users\Lenovo\PycharmProjects中(这是我的电脑位置,跟你的不一定一样,反正位于PycharmProjects中,如果没有,可自行创建),属于项目的同级文件夹。具体如下图所示:

打开datasets文件夹,可以看到本次安全帽训练所使用的数据集。

安全帽佩戴检测数据集是我手动标注好的,可以在我的博客“资源”中下载。

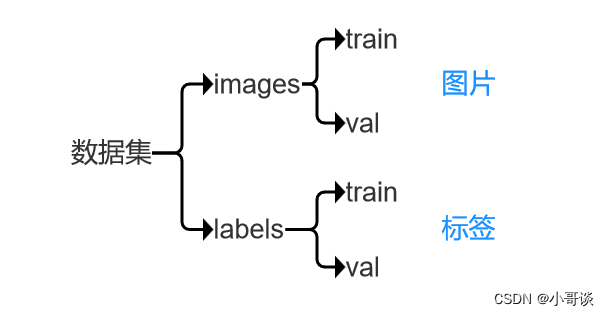

打开数据集文件,我们会看到数据集文件包括images和labels两个文件夹,其中,images放的是数据集图片,包括train和val两个文件夹,labels放的是经过labelimg标注所生成的标签,也包括train和val两个文件夹。

关于此处数据集的逻辑关系,用一张图总结就是:⬇️⬇️⬇️

第2步:创建yaml文件

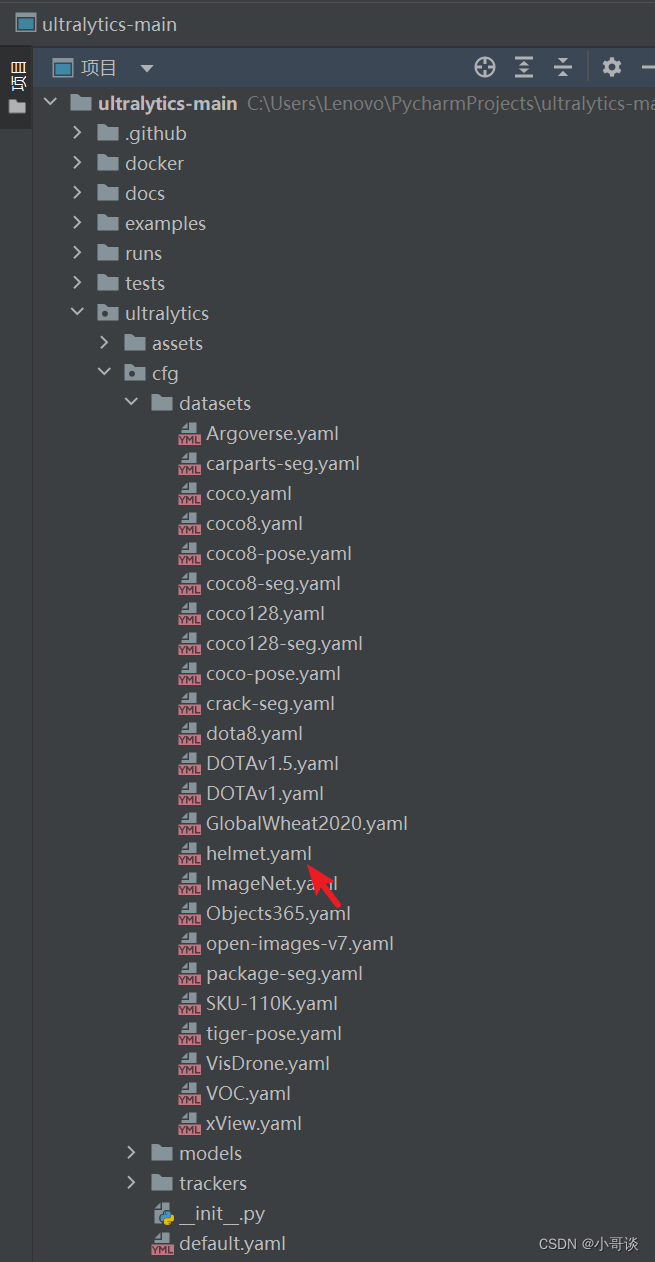

打开pycharm,选择YOLOv8项目源码文件,在ultralytics\cfg\datasets下新建一个helmet.yaml,如下图所示:

打开helmet.yaml,按照如下图所示的进行配置:

说明:♨️♨️♨️

1.train和val为绝对路径地址,可根据自己数据集的路径地址自行设置。

2.nc指的是分类,即模型训练结果分类,此处为在用labelimg或者make sense为数据集标注时候确定。

3.由于本次进行的是安全帽佩戴检测模型训练,所以分两类,分别是:helmet(佩戴安全帽)和nohelmet(不佩戴安全帽)

打开coco128.yaml文件,可以看到里面写的是相对路径,和我们的写法不同,但是都可以使用,据我所知还有很多种数据集读取方式:

# Ultralytics YOLO 🚀, AGPL-3.0 license

# COCO128 dataset https://www.kaggle.com/ultralytics/coco128 (first 128 images from COCO train2017) by Ultralytics

# Documentation: https://docs.ultralytics.com/datasets/detect/coco/

# Example usage: yolo train data=coco128.yaml

# parent

# ├── ultralytics

# └── datasets

# └── coco128 ← downloads here (7 MB)# Train/val/test sets as 1) dir: path/to/imgs, 2) file: path/to/imgs.txt, or 3) list: [path/to/imgs1, path/to/imgs2, ..]

path: ../datasets/coco128 # dataset root dir

train: images/train2017 # train images (relative to 'path') 128 images

val: images/train2017 # val images (relative to 'path') 128 images

test: # test images (optional)# Classes

names:0: person1: bicycle2: car3: motorcycle4: airplane5: bus6: train7: truck8: boat9: traffic light10: fire hydrant11: stop sign12: parking meter13: bench14: bird15: cat16: dog17: horse18: sheep19: cow20: elephant21: bear22: zebra23: giraffe24: backpack25: umbrella26: handbag27: tie28: suitcase29: frisbee30: skis31: snowboard32: sports ball33: kite34: baseball bat35: baseball glove36: skateboard37: surfboard38: tennis racket39: bottle40: wine glass41: cup42: fork43: knife44: spoon45: bowl46: banana47: apple48: sandwich49: orange50: broccoli51: carrot52: hot dog53: pizza54: donut55: cake56: chair57: couch58: potted plant59: bed60: dining table61: toilet62: tv63: laptop64: mouse65: remote66: keyboard67: cell phone68: microwave69: oven70: toaster71: sink72: refrigerator73: book74: clock75: vase76: scissors77: teddy bear78: hair drier79: toothbrush# Download script/URL (optional)

download: https://ultralytics.com/assets/coco128.zip

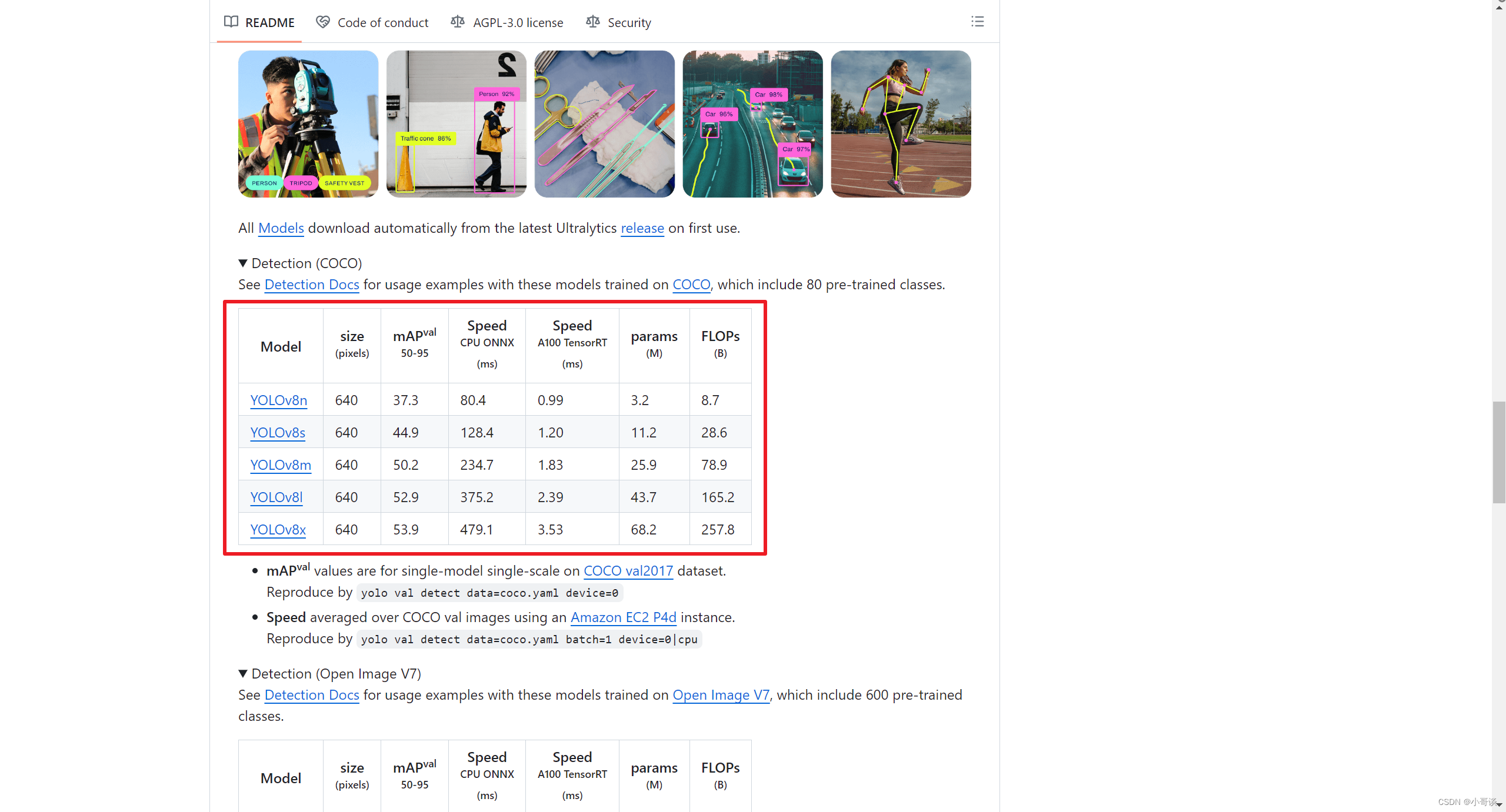

第3步:下载预训练权重

打开YOLOv8官方仓库地址,可以根据需要下载相应的预训练权重。

预训练权重下载地址:GitHub - ultralytics/ultralytics: NEW - YOLOv8 🚀 in PyTorch > ONNX > OpenVINO > CoreML > TFLite

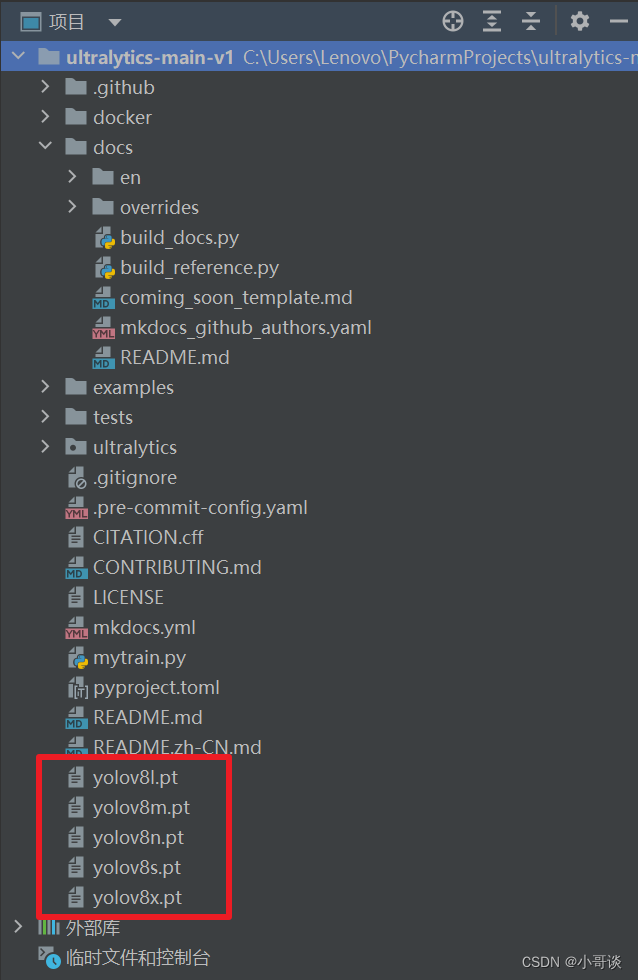

下载完毕后,即可将其复制粘贴到YOLOv8源码的主目录下。具体如下图所示:

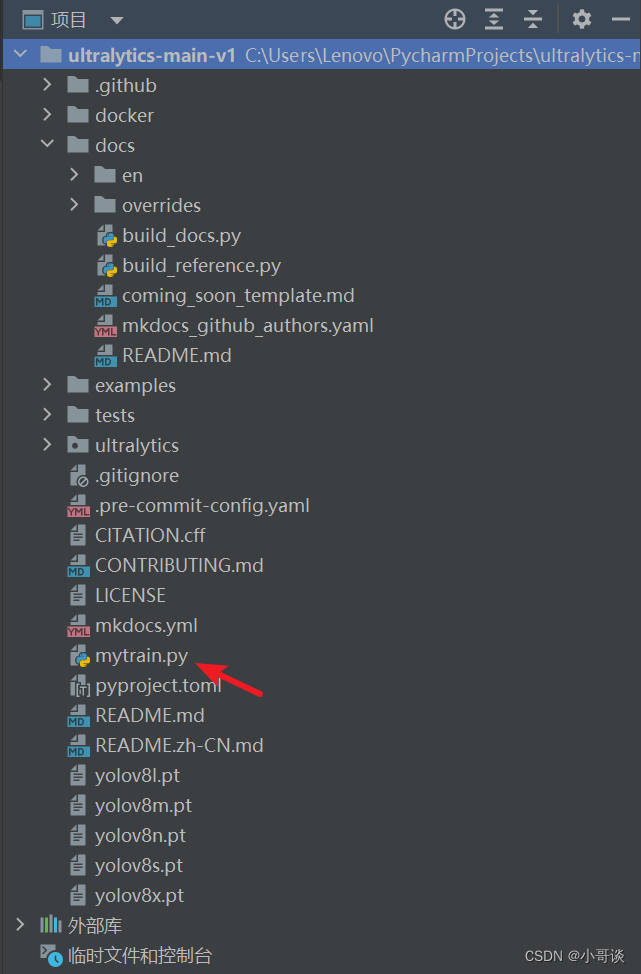

第4步:新建Python文件

通过查看YOLOv8官方文档可知,YOLOv8提供CLI和python两种训练方式。区别在于:

- 方式1:CLI就是直接在终端运行指令

- 方式2:python需要你新建一个python文件,然后运行代码

YOLOv8官方文档地址:Home - Ultralytics YOLOv8 Docs

本次训练作者采用方式2。

在YOLOv8源码目录下新建Python文件,命名为mytrain.py。具体如下图所示:

本次案例,我的mytrain.py文件内容如下所示,大家可自行调整路径地址。

from ultralytics import YOLO

import wandbwandb.init(project="YOLOv8")# Load a model

model = YOLO(r"C:\Users\Lenovo\PycharmProjects\ultralytics-main-v1\ultralytics\cfg\models\v8\yolov8.yaml") # build a new model from scratch

model = YOLO(r"C:\Users\Lenovo\PycharmProjects\ultralytics-main-v1\yolov8s.pt") # load a pretrained model (recommended for training)# Use the model

model.train(data=r"C:\Users\Lenovo\PycharmProjects\ultralytics-main-v1\ultralytics\cfg\datasets\helmet.yaml", epochs=100) # train the model

metrics = model.val() # evaluate model performance on the validation set

#results = model("https://ultralytics.com/images/bus.jpg") # predict on an image

#path = model.export(format="onnx") # export the model to ONNX format说明:由于本次案例不需要导出模型,我将相关代码注释了,大家后续可根据实际情况进行调整。

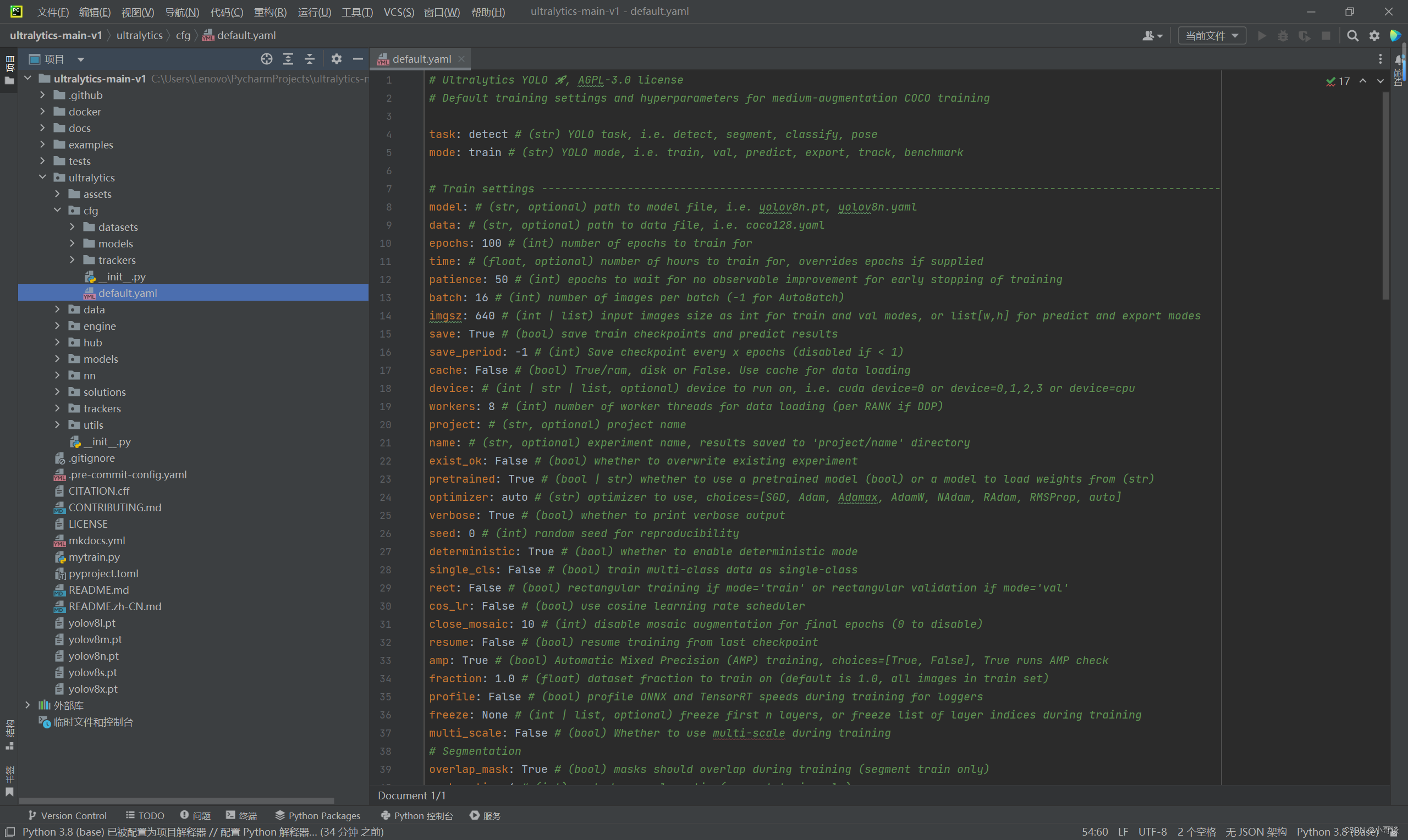

第5步:调节参数

YOLOv8关于模型的各种参数都在ultralytics/cfg/default.yaml中,这是与先前版本最大的不同,通过调节这些参数我们就可以实现各种我们所需的操作。

第5步:开始训练

当参数调节完毕之后,即可点击“运行”。具体运行结果如下图所示:

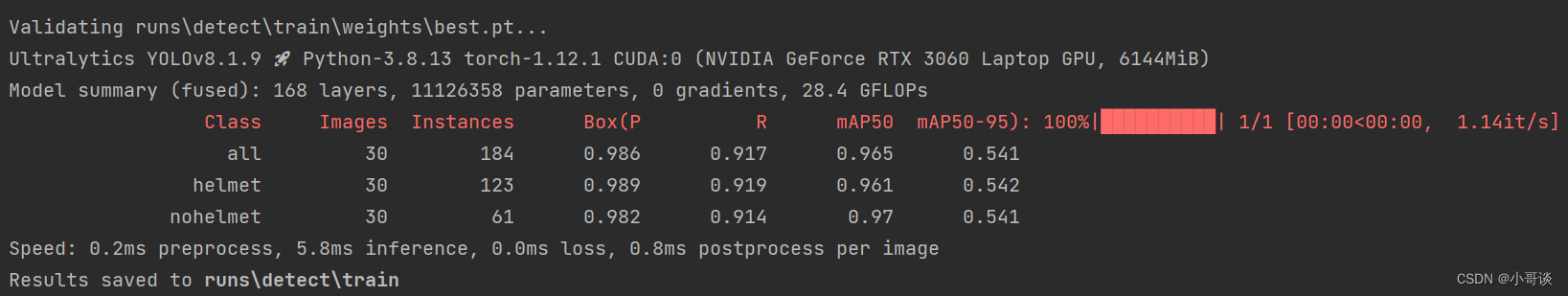

训练结束后,训练结果如下所示: