一、引言

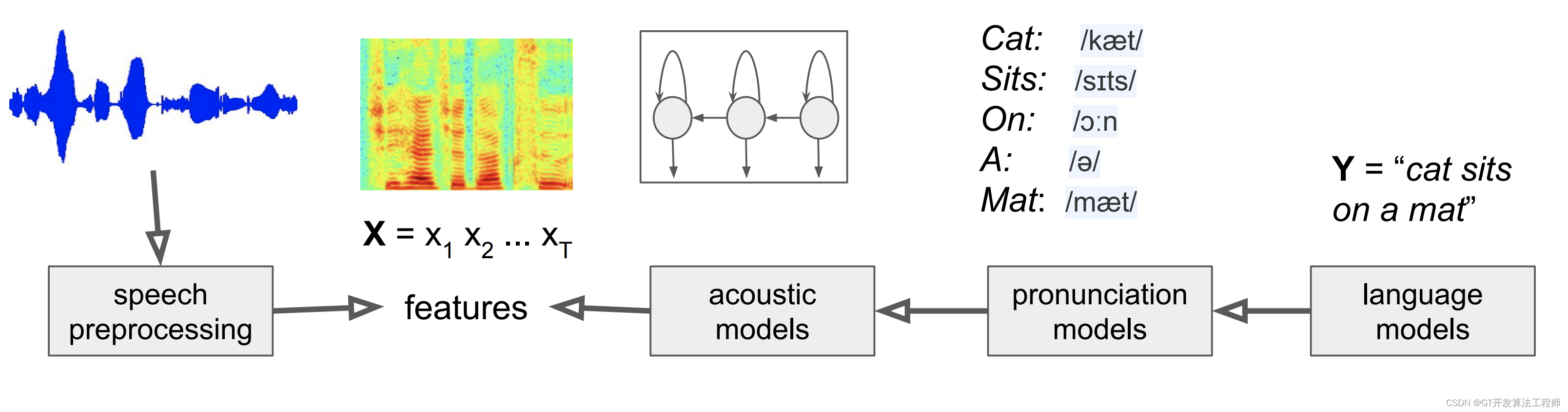

随着人工智能技术的日益成熟,深度学习在语音识别领域取得了显著的突破。本博客将介绍如何使用TensorFlow框架,结合LibriSpeech数据集,构建一个高效的语音识别系统。

目录

一、引言

二、环境准备

为了运行本示例代码,你需要准备以下环境:

三、代码实现

接下来是改进后的代码示例,该代码展示了如何加载LibriSpeech数据集、构建LSTM模型,并进行训练。

总结

为了进一步优化模型性能,可以尝试以下措施:

二、环境准备

-

为了运行本示例代码,你需要准备以下环境:

- 操作系统:推荐使用Linux或macOS操作系统,它们对TensorFlow的支持更为稳定。

- Python版本:Python 3.x 是最佳选择,因为它提供了更丰富的功能和更好的性能。

- TensorFlow库:确保安装了最新版本的TensorFlow库。你可以使用以下命令安装:

pip install tensorflow- 其他依赖库:为了处理音频文件和文本数据,你可能需要安装

librosa和numpy等库。可以使用以下命令安装:

pip install librosa numpy- 数据集:下载LibriSpeech数据集。LibriSpeech是一个大规模的英文语音识别数据集,包含了多种不同条件下的语音数据。请从官方网站下载并解压到指定目录。

三、代码实现

-

接下来是改进后的代码示例,该代码展示了如何加载LibriSpeech数据集、构建LSTM模型,并进行训练。

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, LSTM, Dropout

from tensorflow.keras.preprocessing.sequence import pad_sequences

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.audio import load_wav_file, mfcc

from tensorflow.keras.utils import to_categorical

import numpy as np

import os

import librosa # 数据预处理函数

def preprocess_data(audio_dir, text_file, sample_rate=16000, frame_length=2048, hop_length=512): texts = [] mel_specs = [] with open(text_file, 'r') as f: lines = f.readlines() for line in lines: audio_file, transcript = line.strip().split(' ', 1) audio_path = os.path.join(audio_dir, audio_file) # 加载音频文件并提取MFCC特征 y, sr = librosa.load(audio_path, sr=sample_rate) mfccs = librosa.feature.mfcc(y=y, sr=sr, n_mfcc=13, hop_length=hop_length) mfccs = np.mean(mfccs.T, axis=0) mel_specs.append(mfccs) texts.append(transcript) # 对文本进行编码 tokenizer = Tokenizer() tokenizer.fit_on_texts(texts) word_index = tokenizer.word_index texts = tokenizer.texts_to_sequences(texts) # 对音频特征和文本序列进行填充和编码 mel_specs = np.array(mel_specs) texts = pad_sequences(texts, maxlen=max([len(text) for text in texts])) texts = to_categorical(texts, num_classes=len(word_index) + 1) return mel_specs, texts, word_index # 构建LSTM模型

def build_model(input_shape, num_classes): model = Sequential() model.add(LSTM(128, input_shape=input_shape, return_sequences=True)) model.add(Dropout(0.2)) model.add(LSTM(64)) model.add(Dropout(0.2)) model.add(Dense(num_classes, activation='softmax')) model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy']) return model # 训练模型

def train_model(model, mel_specs, texts, epochs=10, batch_size=32): model.fit(mel_specs, texts, epochs=epochs, batch_size=batch_size) # 主函数

def main(): audio_dir = 'path_to_librispeech_audio' # LibriSpeech音频文件目录 text_file = 'path_to_librispeech_text' # LibriSpeech转录文本文件路径 # 预处理数据 mel_specs, texts,word_index = preprocess_data(audio_dir, text_file) # 设置模型输入和输出维度 input_shape = (mel_specs.shape[1], mel_specs.shape[2]) num_classes = texts.shape[1] # 构建模型 model = build_model(input_shape, num_classes) # 训练模型 train_model(model, mel_specs, texts) # 保存模型 model.save('librispeech_model.h5') # 评估模型性能(可选) # test_data = load_test_data(test_audio_dir, test_text_file) # test_mel_specs, test_texts = preprocess_test_data(test_data) # test_loss, test_accuracy = model.evaluate(test_mel_specs, test_texts) # print(f'Test Loss: {test_loss}, Test Accuracy: {test_accuracy}') # 运行主函数

if __name__ == '__main__': main()总结

- 通过上述步骤,我们成功使用TensorFlow构建了一个基于LibriSpeech数据集的语音识别系统。这个系统使用了LSTM网络结构来处理音频数据的时序特性,并通过MFCC特征提取音频的有效信息。经过训练,模型可以识别并转录英文语音。

为了进一步优化模型性能,可以尝试以下措施:

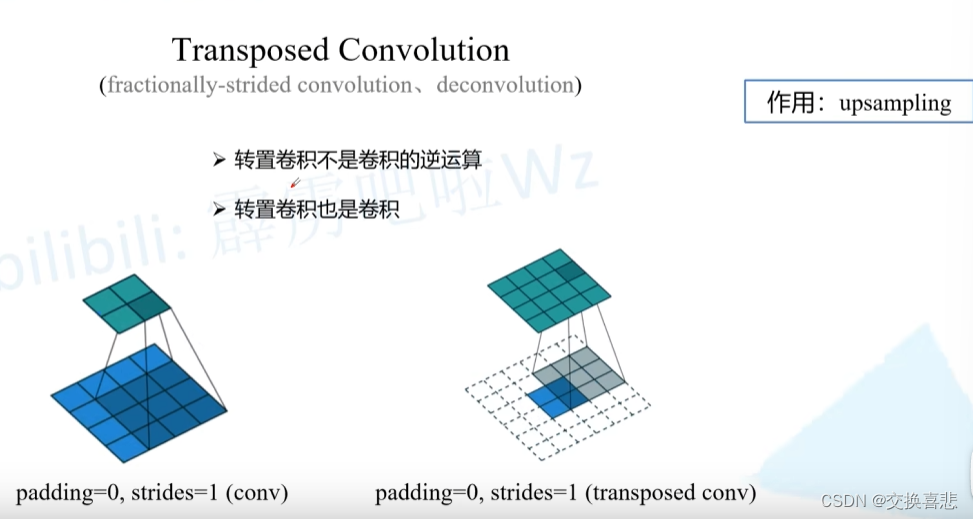

- 使用更复杂的网络结构,如卷积神经网络(CNN)与LSTM的结合(ConvLSTM)。

- 增加数据预处理步骤,如噪声抑制、语音增强等。

- 使用更先进的特征提取方法,如滤波器组特征(Filter Bank Features)。

- 调整模型参数,如学习率、批大小、迭代次数等。

-

通过上述方法,我们可以进一步提高语音识别的准确性和鲁棒性。