注意力是一个有助于提高神经机器翻译应用程序性能的概念。在这篇文章中,我们将看看Transformer,一个使用注意力来提高这些模型训练速度的模型。Transformer在特定任务中优于谷歌神经机器翻译模型。最大的好处来自于Transformer如何使自己适合并行化。

在这篇文章中,我们将尝试简化一些内容,并逐一介绍概念,希望能够让没有深入了解主题的人更容易理解。

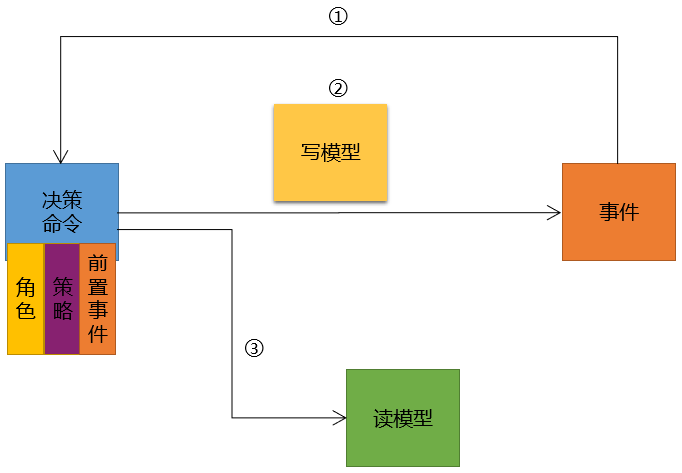

A High-Level Look

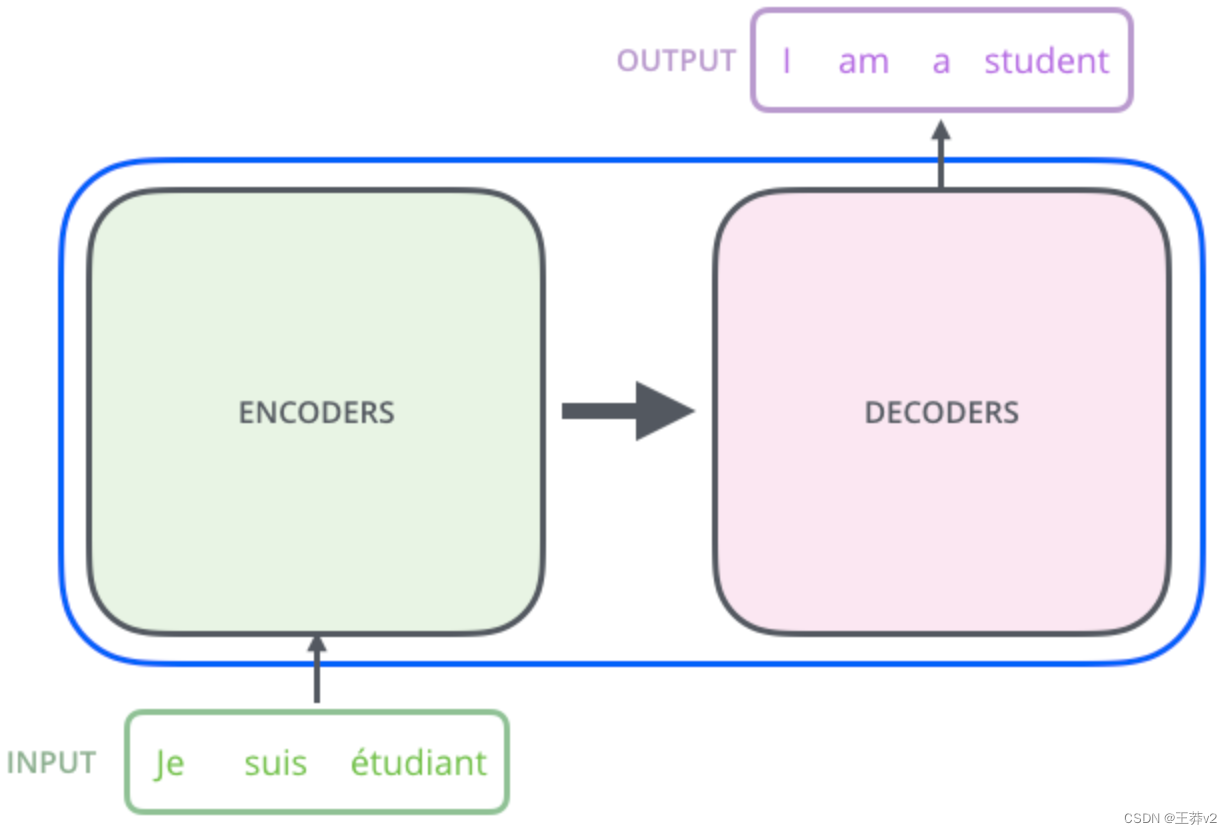

让我们首先将模型视为一个单一的黑盒。在机器翻译应用程序中,它将以一种语言获取句子,并以另一种语言输出其翻译。

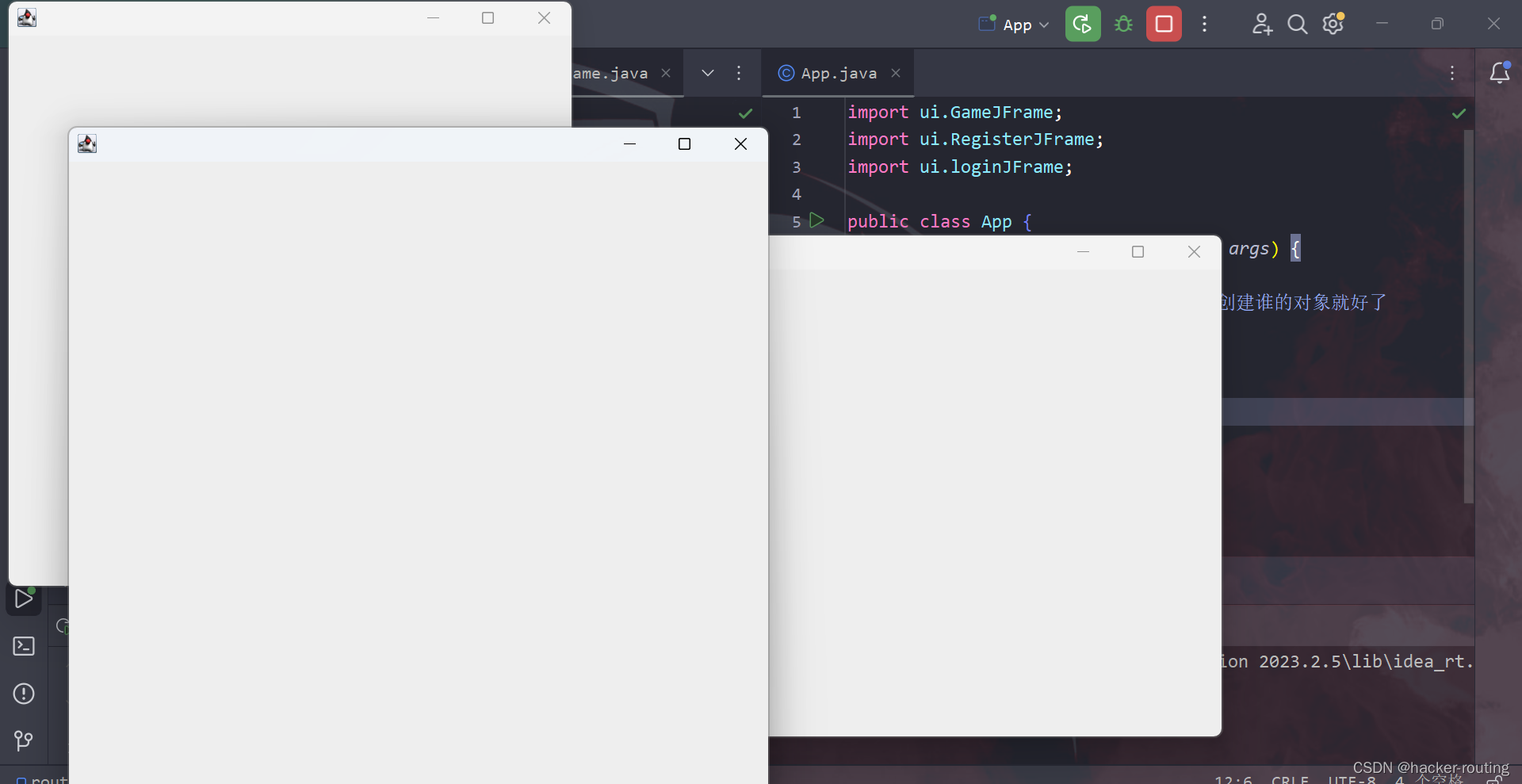

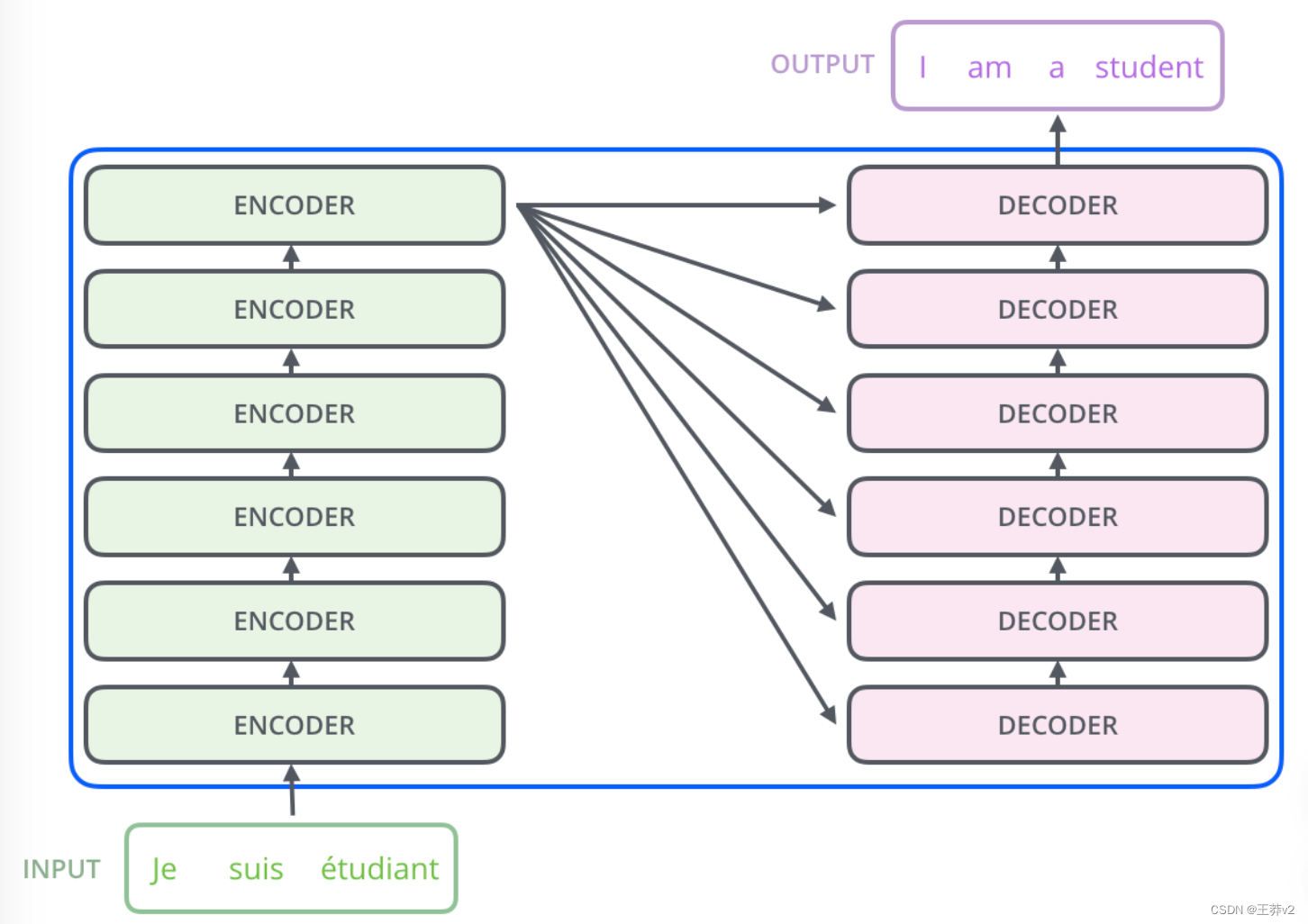

打开它,我们看到一个编码组件,一个解码组件,以及它们之间的连接。

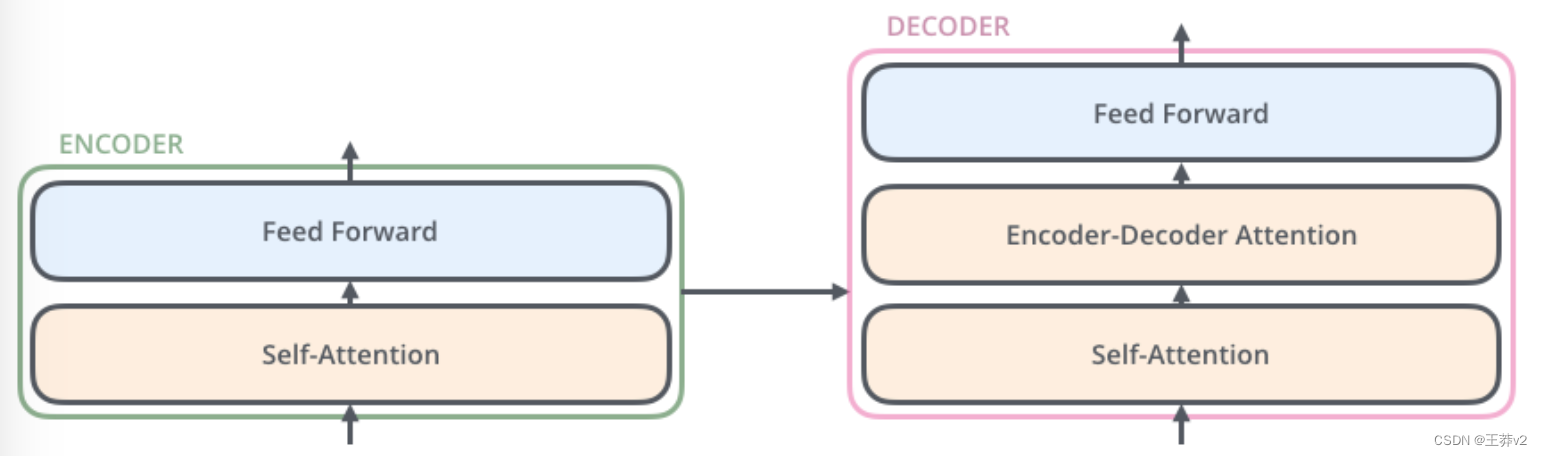

编码组件是一堆编码器(6个编码器堆叠在一起,数字6没有什么神奇的,你可以尝试其他的排列方式)。解码组件是一堆相同数量的解码器。

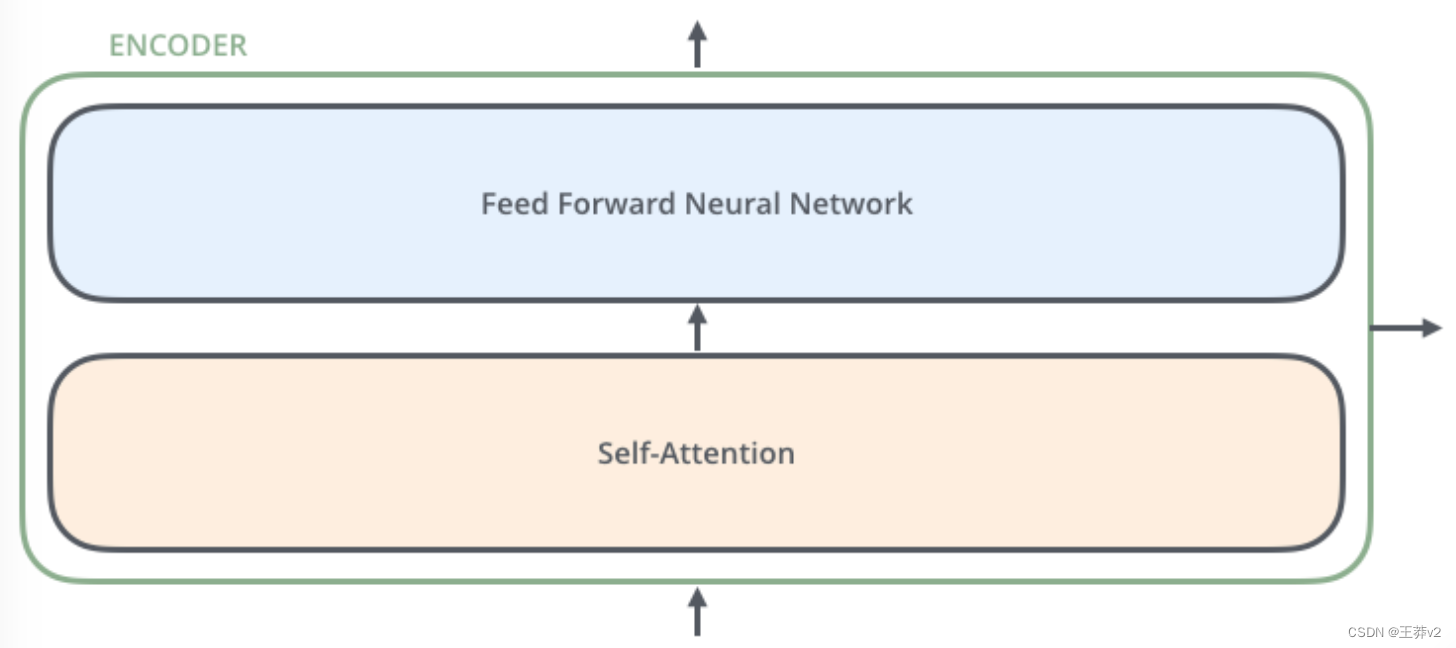

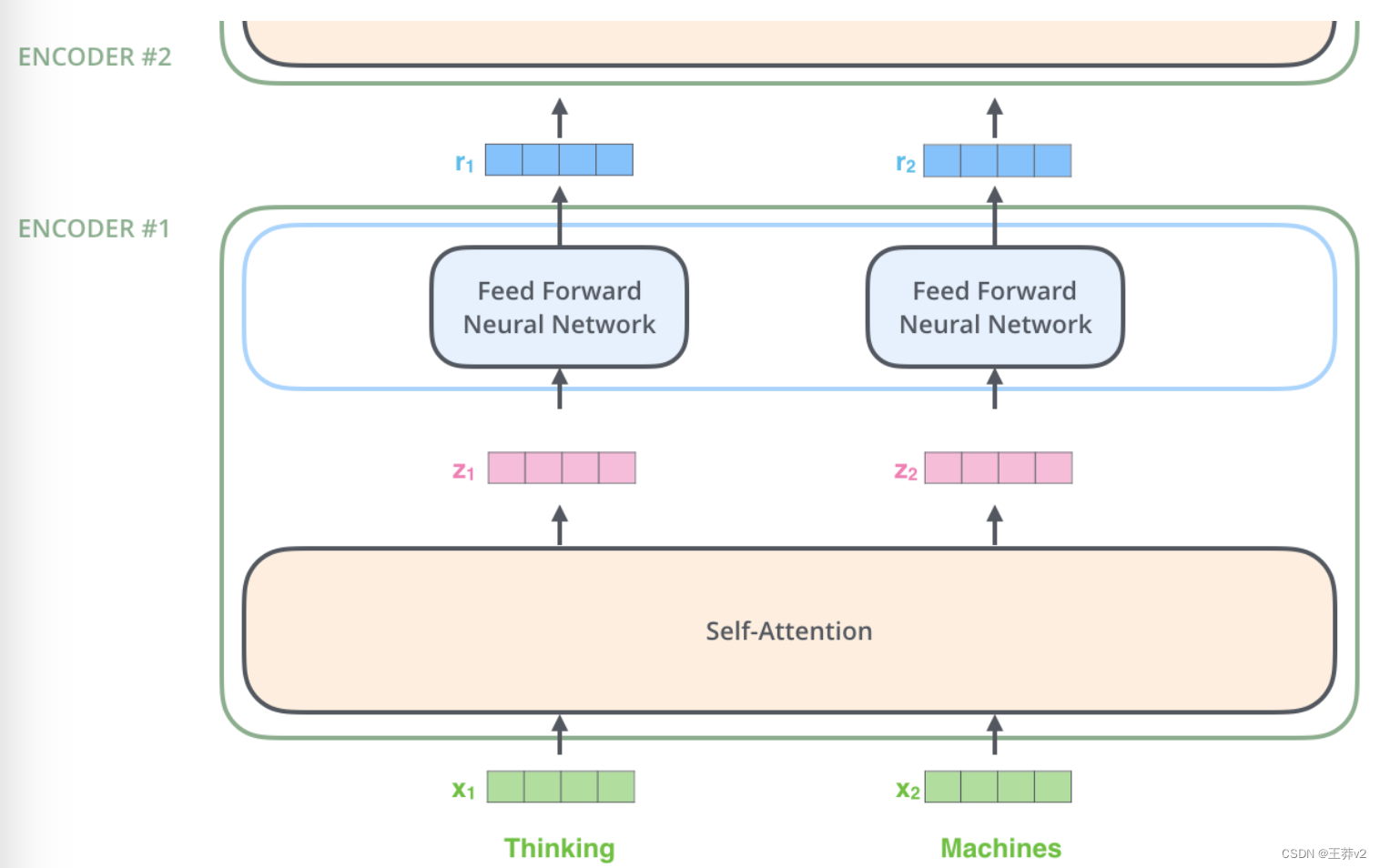

编码器在结构上都是相同的(但它们不共享权重)。每一层都被分解成两个子层

编码器的输入首先通过自注意层,这一层帮助编码器在编码特定单词时查看输入句子中的其他单词。我们将在后面的文章中详细介绍自我关注。

自注意层的输出被馈送到前馈神经网络。完全相同的前馈网络独立应用于每个位置。

解码器有这两个层,但在它们之间是一个注意力层,它帮助解码器专注于输入句子的相关部分(类似于注意力在seq2seq模型中的作用)。

把张量带入图像

现在我们已经看到了模型的主要组件,让我们开始看看各种向量/张量,以及它们如何在这些组件之间流动,将训练模型的输入转换为输出。

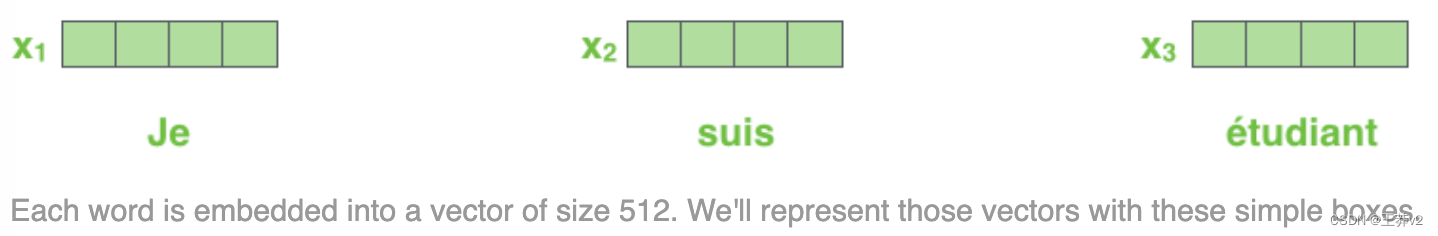

与一般的NLP应用程序一样,我们首先使用嵌入算法将每个输入词转换为向量。

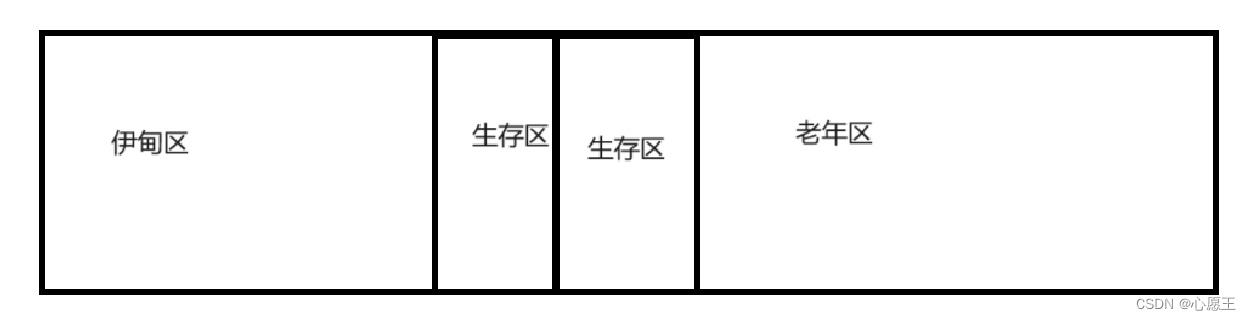

嵌入只发生在最底部的编码器中。所有编码器的共同抽象是,它们接收一个大小为512的向量列表,在底部的编码器中,这将是单词嵌入,但在其他编码器中,它将是编码器直接在下面的输出。这个列表的大小是我们可以设置的超参数,基本上它是我们训练数据集中最长句子的长度。

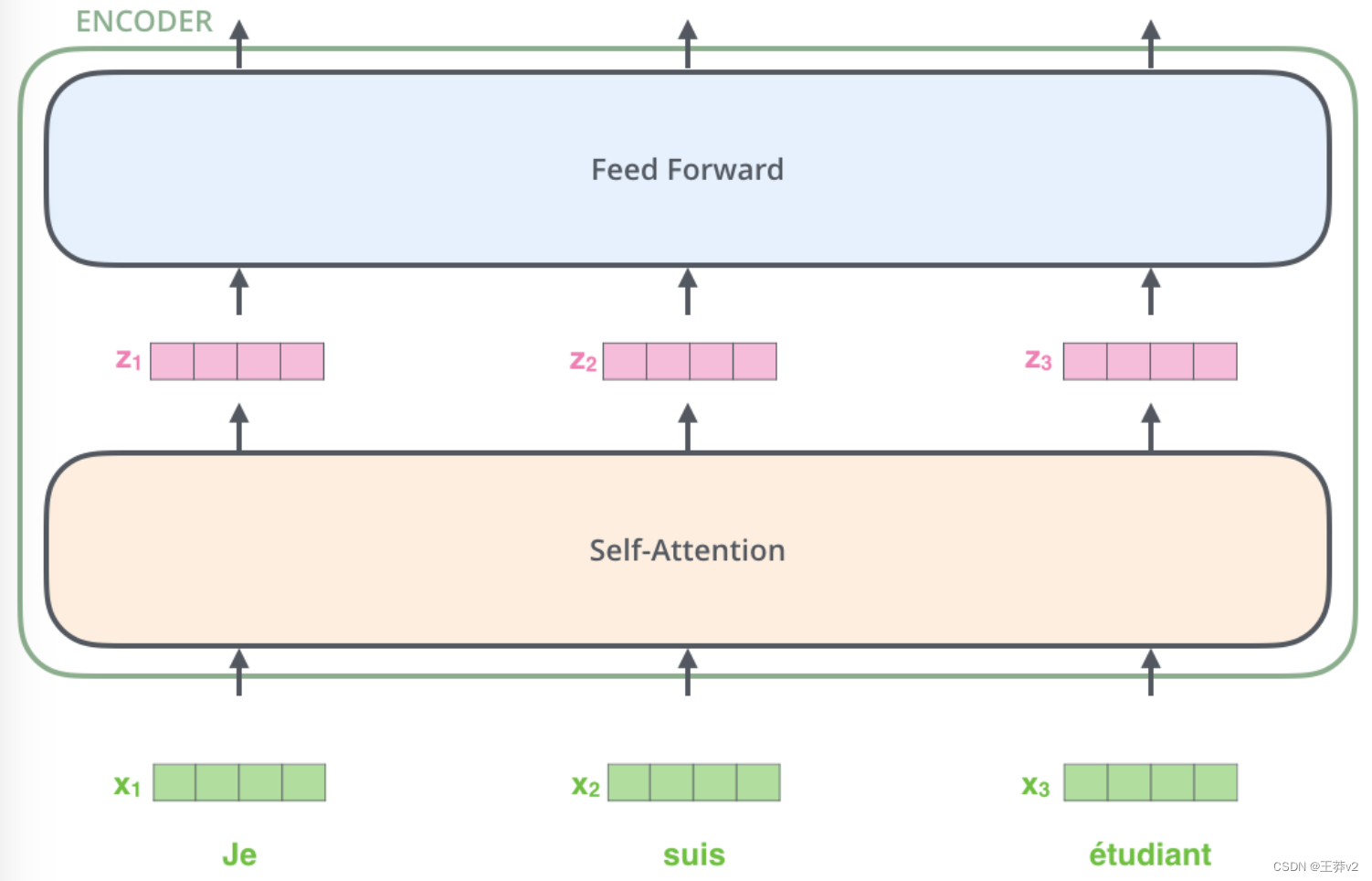

这里我们开始看到Transformer的一个关键属性,即每个位置上的单词在编码器中流经自己的路径。在self-attention层中,这些路径之间存在依赖关系。但是,前馈层没有这些依赖关系,因此,在流经前馈层时,各种路径可以并行执行。

接下来,我们将把示例转换为更短的句子,并查看编码器的每个子层中发生了什么。

Now We’re Encoding!

正如我们已经提到的,编码器接收一个向量列表作为输入。它通过将这些向量传递到 self-attention 来处理这个列表,然后进入前馈神经网络,然后将输出向上发送到下一个编码器。

每个位置的单词都经过一个 self-attention 的过程。然后,它们分别通过一个前馈神经网络——完全相同的网络,每个向量分别流过它。

Self-Attention at a High Level

不要被我抛出的“self-attention”这个词所迷惑,好像它是每个人都应该熟悉的概念一样。在阅读《Attention is All You Need 》这篇论文之前,我个人从未接触过这个概念。让我们提炼一下它是如何工作的。

假设下面的句子是我们想要翻译的输入句子

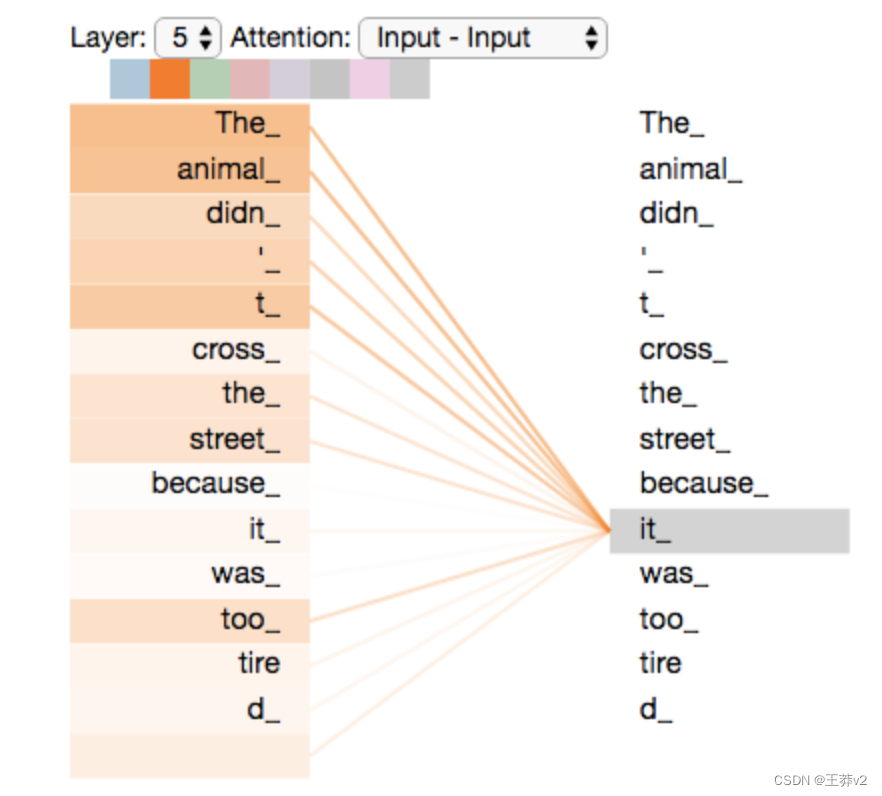

”The animal didn’t cross the street because it was too tired”

“it” 在这个句子里指的是什么?它指的是街道还是动物?这对人类来说是一个简单的问题,但对算法来说就不那么简单了。

当模型处理单词“it”时,self-attention 允许它将其与动物联系起来。

当模型处理每个单词(输入序列中的每个位置)时,self-attention 允许它查看输入序列中的其他位置,以寻找有助于对该单词进行更好编码的线索。

如果您熟悉RNN,请考虑维护隐藏状态如何允许RNN将其之前处理的单词/向量的表示与正在处理的当前单词/向量的表示相结合。self-attention 是 Transformer 用来将其他相关单词的“理解”烘焙成我们目前正在处理的单词的方法。

当我们在编码器#5(堆栈中的顶部编码器)中编码单词“it”时,部分注意力机制集中在“动物”上,并将其部分表示放入“it”的编码中。

一定要查看Tensor2Tensor笔记本,在那里您可以加载Transformer模型,并使用这个交互式可视化来检查它。

Self-Attention in Detail

让我们首先看一下如何使用向量来计算自注意力,然后继续看一下如何使用矩阵来实际实现它。

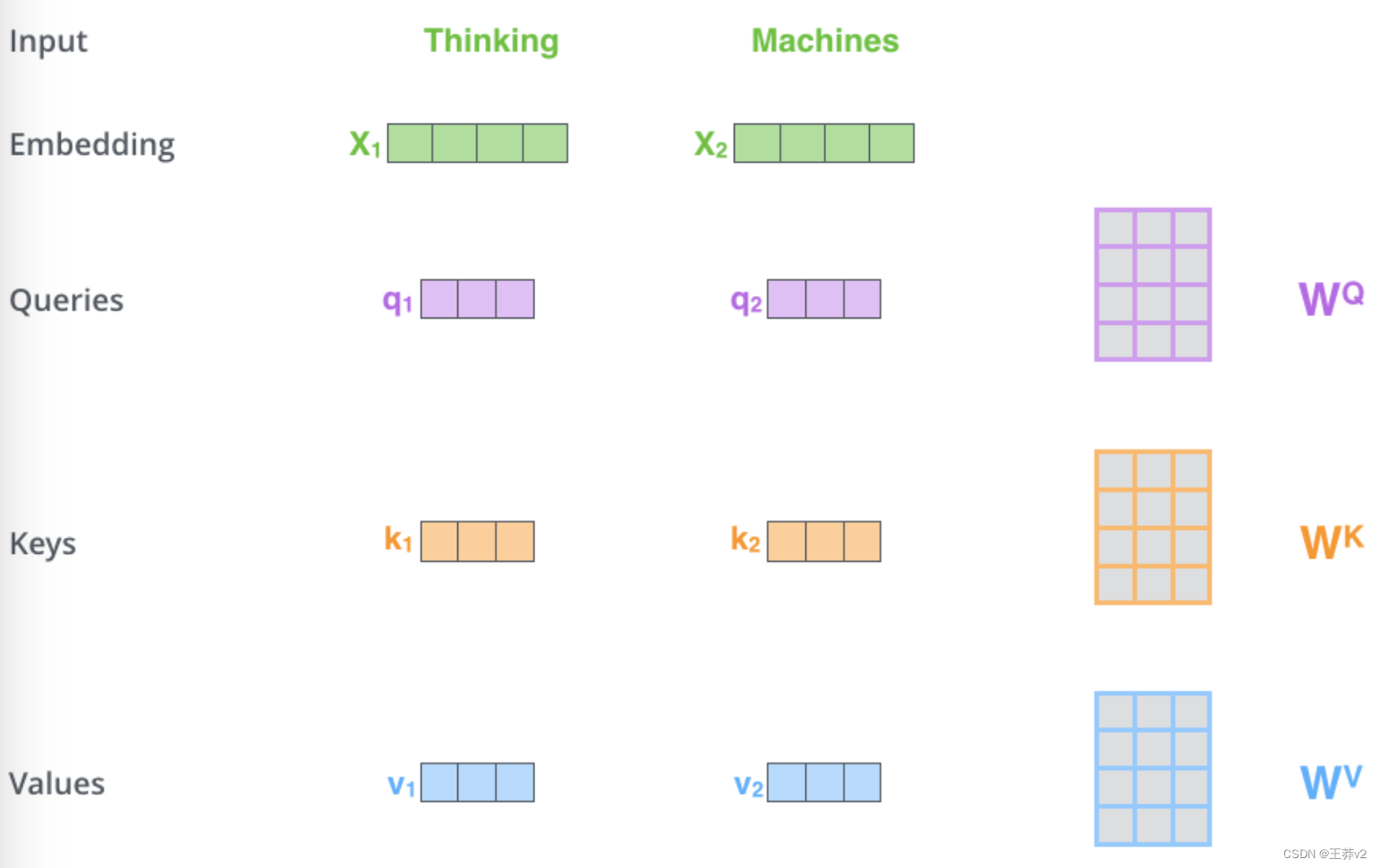

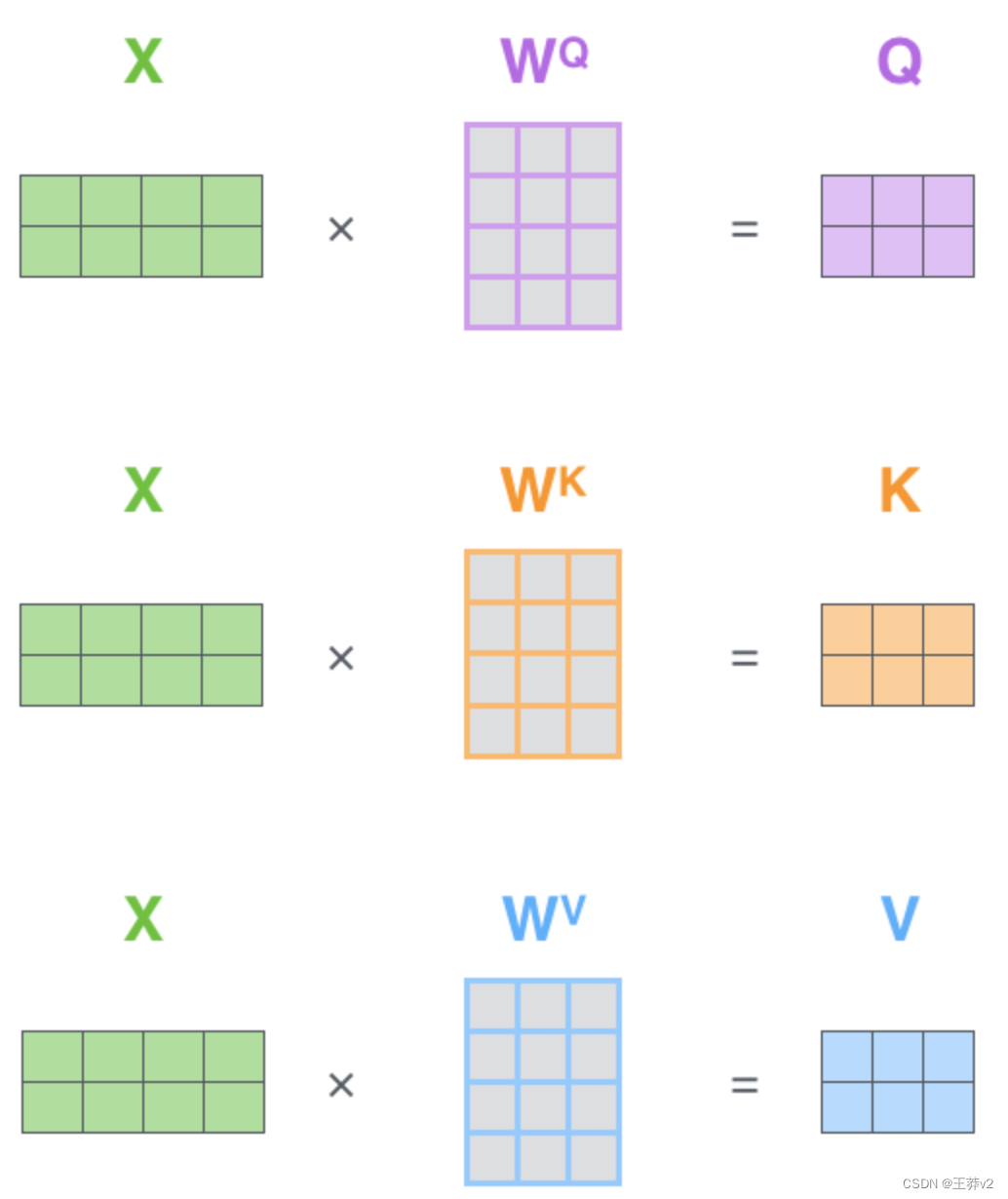

计算自注意的第一步是从每个编码器的输入向量(在本例中是每个单词的嵌入)中创建三个向量。因此,对于每个单词,我们创建一个 Query 向量、一个 Key 向量和一个 Value 向量。这些向量是通过将嵌入乘以我们在训练过程中训练的三个矩阵来创建的。

请注意,这些新向量的尺寸比嵌入向量小。它们的维度为64,而嵌入和编码器输入/输出矢量的维度为512。它们不必更小,这是一个使多头注意力(大多数)的计算保持不变的架构选择。

将x1乘以WQ权重矩阵得到q1,即与该单词相关的“query”向量。我们最终为输入句子中的每个单词创建了一个“query”、一个“key”和一个“value”投影。

什么是query、key和value?

它们是对计算和思考注意力有用的抽象概念。一旦你继续阅读下面的注意力是如何计算的,你就会知道所有你需要知道的关于这些向量所扮演的角色。

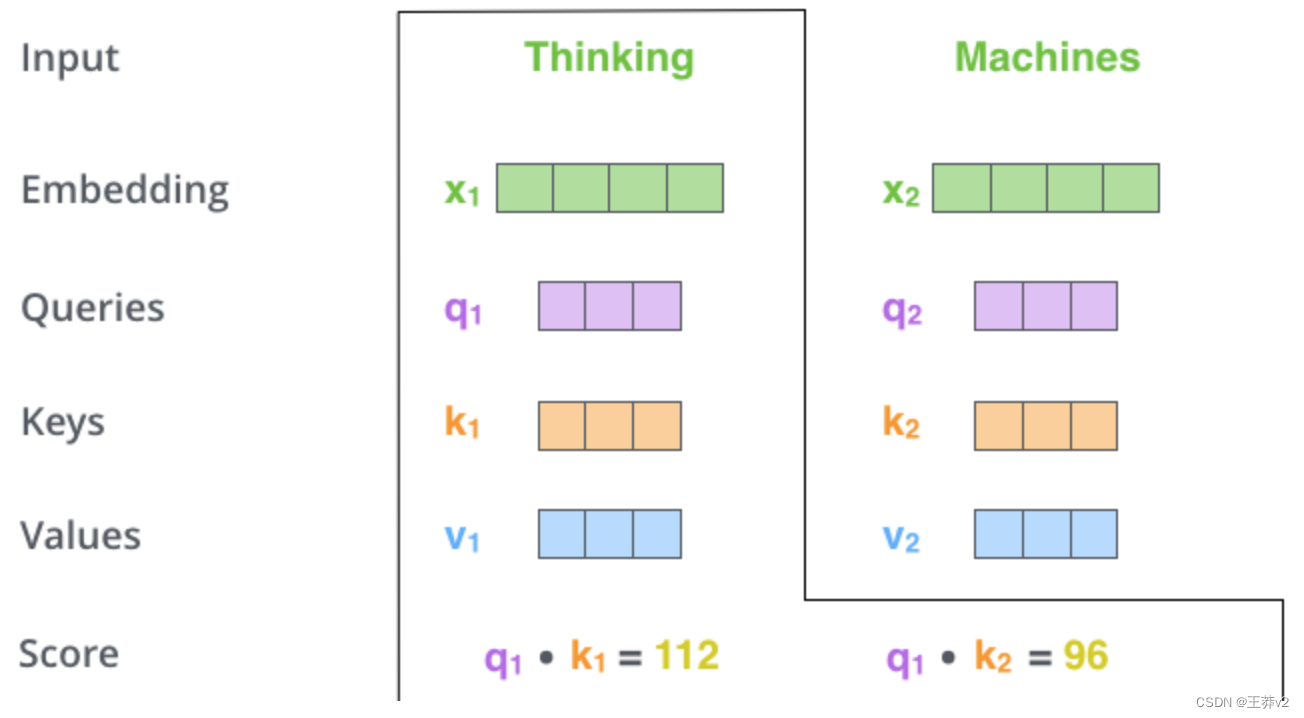

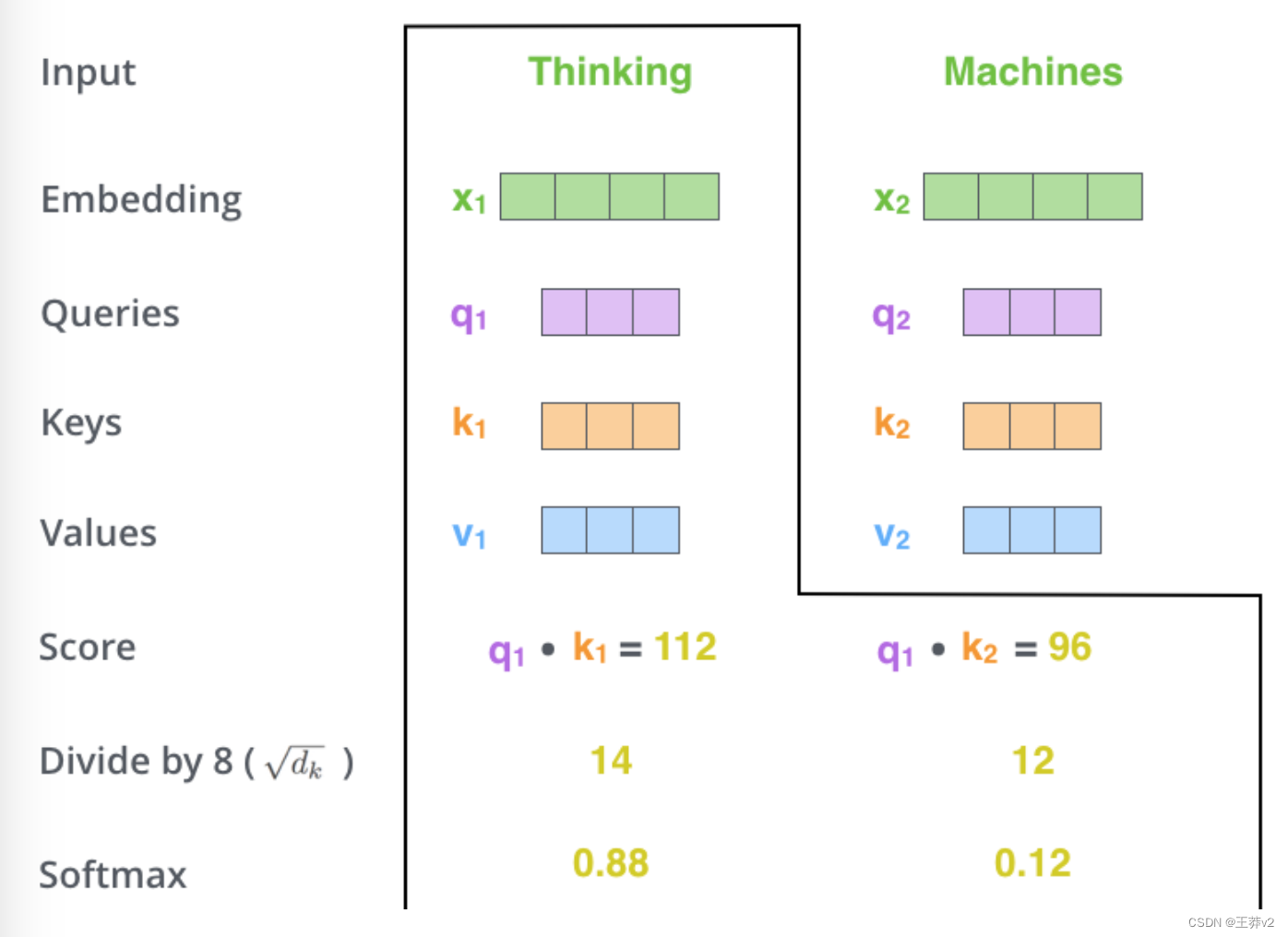

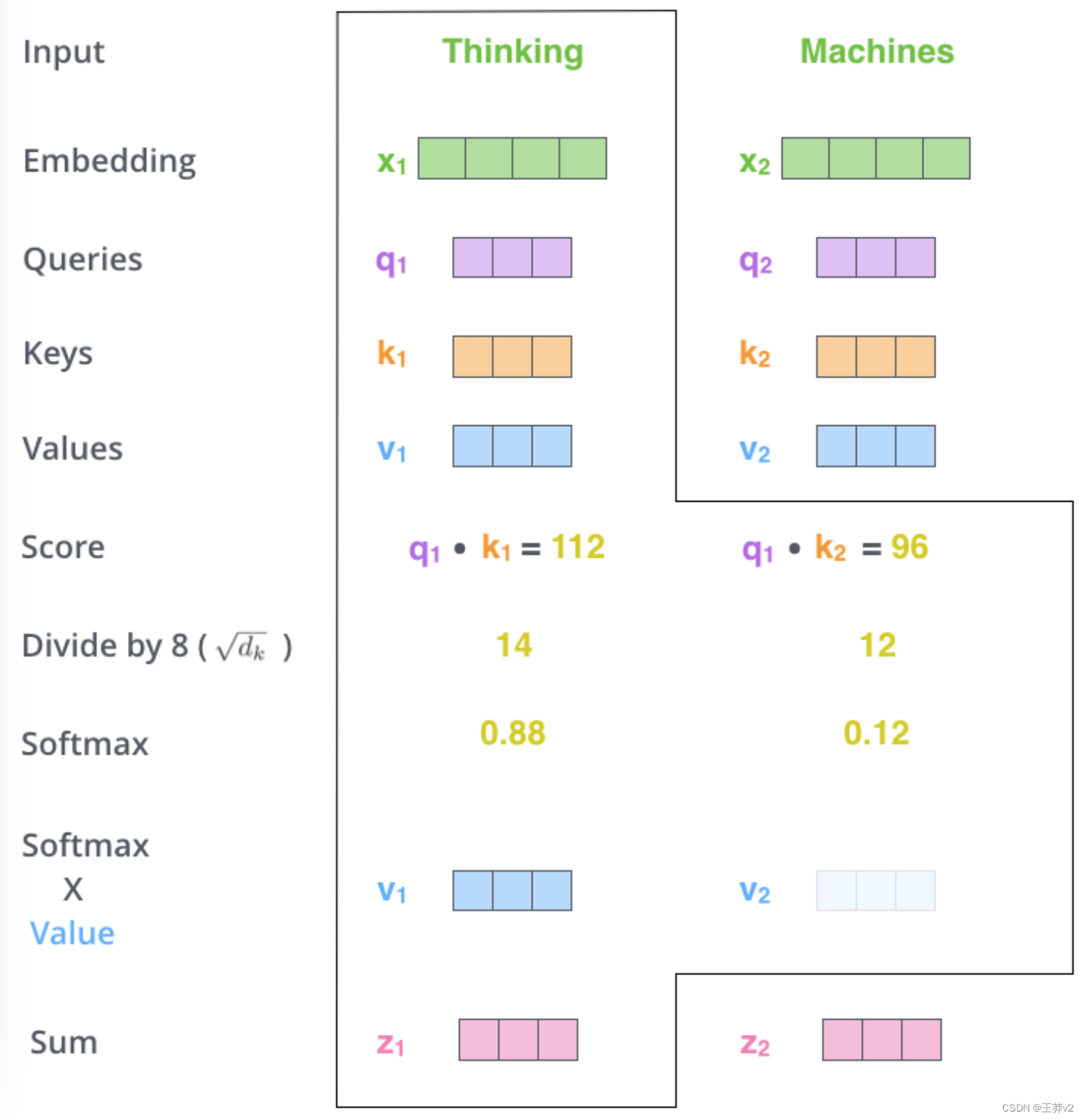

计算 self-attention 的第二步是计算分数。假设我们正在计算本例中第一个单词“Thinking”的self-attention。我们需要对输入句子中的每个单词与这个单词进行评分。分数决定了当我们在某个位置编码单词时,对输入句子的其他部分的关注程度。

分数是通过将 query vector 与我们正在评分的相应单词的 key vector 进行点积来计算的。因此,如果我们重新处理位置 #1 的单词的自注意,第一个分数将是 q1 和 k1 的点积。第二个分数是 q1 和 k2 的点积。

第三步和第四步是将分数除以8(论文中使用的key向量维度的平方根)。这将导致更稳定的梯度。这里可能有其他可能的值,但这是默认值),然后通过softmax操作传递结果。Softmax将分数归一化,所以它们都是正的,加起来等于1。

这个softmax分数决定了每个单词在这个位置表示多少。很明显,在这个位置的单词将有最高的softmax得分,但有时注意与当前单词相关的另一个单词是有用的。

第五步是将每个 value vector 乘以 softmax 分数(准备将它们相加)。这里的直觉是保持我们想要关注的单词的值不变,并淹没不相关的单词(例如,通过将它们乘以像0.001这样的小数字)。

第六步是对加权值向量求和。这就产生了自注意层在这个位置的输出(对于第一个单词)。

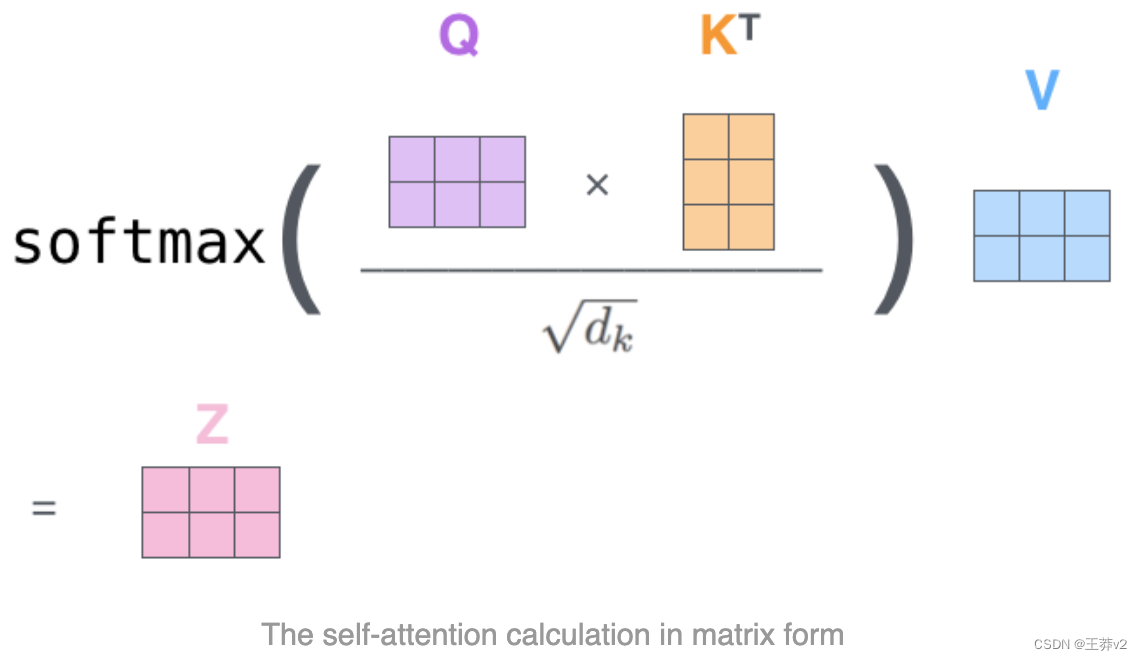

self-attention 计算到此结束。得到的向量是我们可以发送给前馈神经网络的向量。然而,在实际实现中,为了更快地处理,这种计算是以矩阵形式完成的。因此,既然我们已经看到了单词层面计算的直觉,让我们来看看这一点。

Matrix Calculation of Self-Attention

第一步是计算Query、Key和Value矩阵。我们通过将我们的嵌入打包到矩阵X中,并将其乘以我们训练的权重矩阵(WQ, WK, WV)来做到这一点。

X矩阵中的每一行都对应于输入句子中的一个单词。我们再次看到嵌入向量(图中的512或4个框)和q/k/v矢量(图中的64个或3个框)的大小差异

最后,由于我们处理的是矩阵,我们可以将步骤2到步骤6浓缩成一个公式来计算自关注层的输出。

Reference

https://jalammar.github.io/illustrated-transformer/