在RKNN模型部署前,需要注意以下几点:

(1)硬件平台兼容性:

确保你的开发板与 RKNN Toolkit Lite2 兼容。目前,RKNN Toolkit Lite2 支持 Rockchip RK3566、RK3588、RK3399 等平台。

确认开发板的 NPU 型号和版本与 RKNN 模型的 NPU 算子兼容。

(2)模型转换:

使用 RKNN Toolkit 或 RKNNConverter 工具将 PyTorch、TensorFlow 等框架模型转换为 RKNN 模型。

转换时,需要指定目标硬件平台和 NPU 型号。

确保模型转换成功,并生成相应的 RKNN 模型文件。

关于模型转换的教程,参考我另外一篇博文:Pytorch转RKNN模型

(3)部署环境:

在开发板上安装 RKNN Runtime 和相关依赖库。

确认开发板的系统版本和编译环境与 RKNN Toolkit Lite2 兼容。

(4)模型加载:

使用 RKNN Toolkit Lite2 提供的 API 加载 RKNN 模型。

需指定模型文件路径以及其他参数。

(5)模型推理:

使用 RKNN Toolkit Lite2 提供的 API 进行模型推理。

需提供输入数据和相关参数。

(6)性能优化:

可以使用 RKNN Toolkit Lite2 提供的性能分析工具分析模型性能。

根据分析结果,可以对模型进行优化,以提高推理速度和降低功耗。

目录

- 一、源码包准备

- 二、环境准备

- 2.1 安装Miniconda

- 2.2 新建虚拟环境

- 2.3 安装rknn_toolkit_lite2包

- 2.4 安装OpenCV包

- 三、推理

- 3.1 代码

- 3.2 开发板推理结果

- 四、总结

一、源码包准备

本配套源码包的获取方式为文章末扫码到公众号「视觉研坊」中回复关键字:RKNN Lite2开发板部署。获取下载链接。

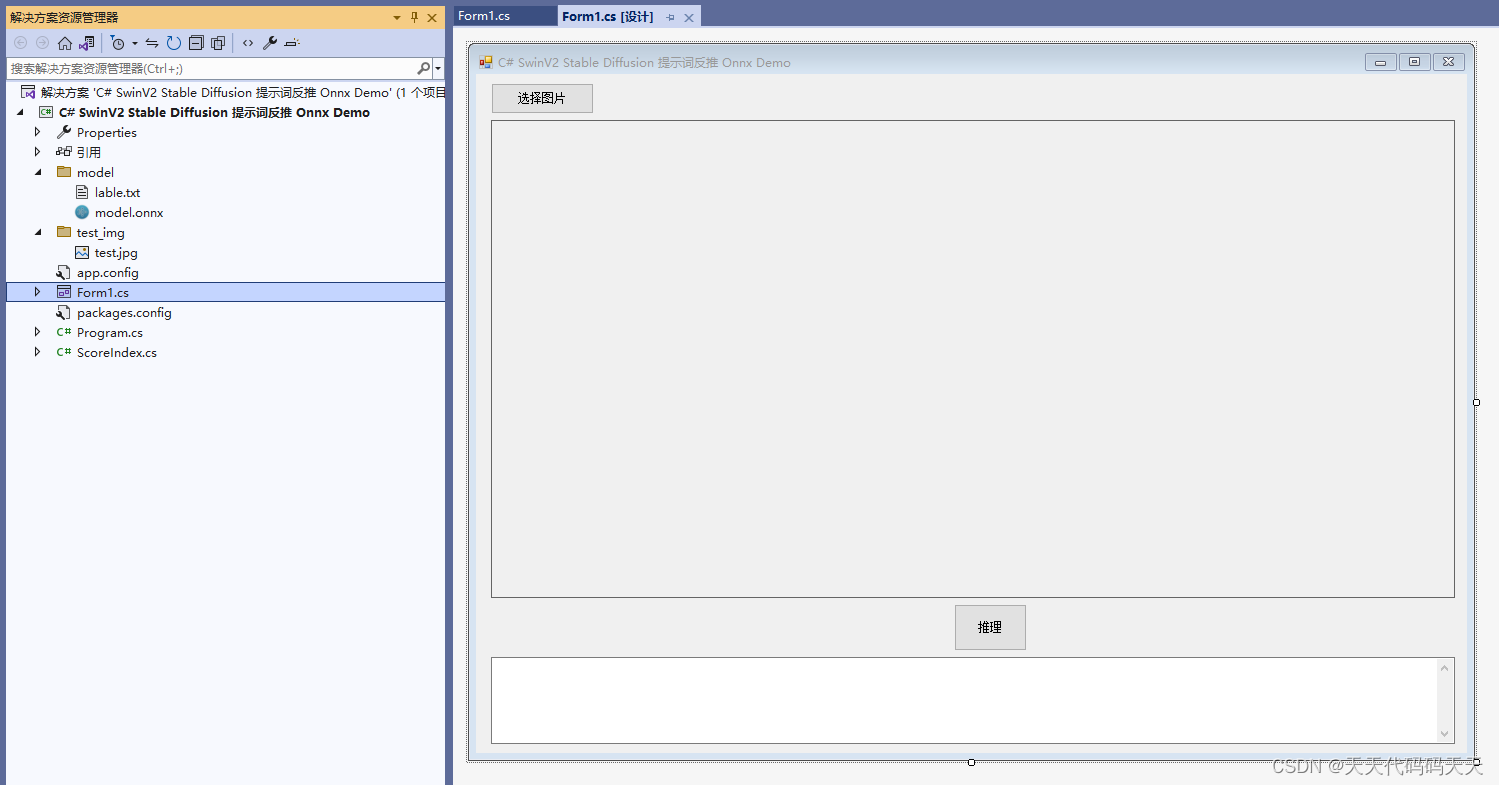

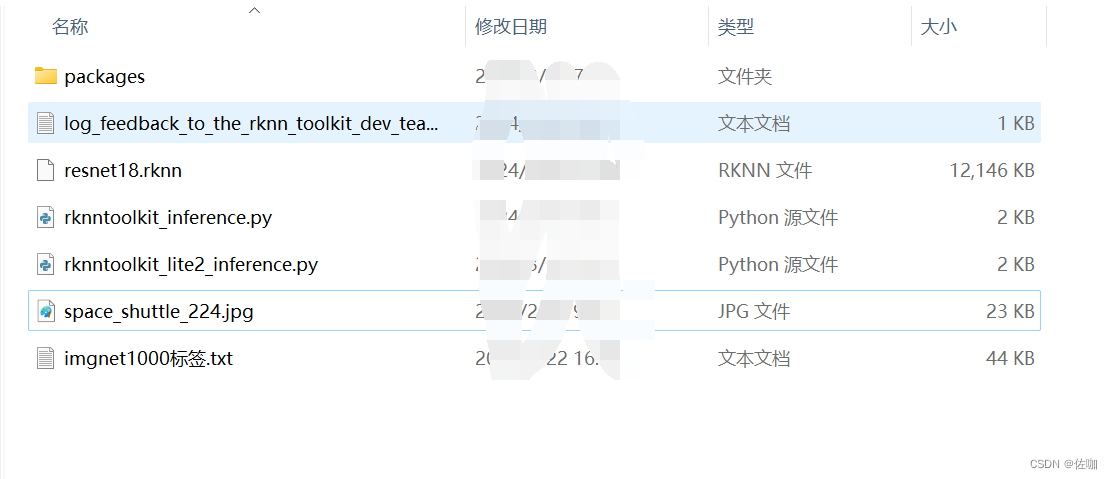

下载解压后的样子如下:

二、环境准备

先在开发板上运行rknn_server,通过adb连通开发板,在开发板系统上安装python编译环境。

2.1 安装Miniconda

在开发板系统上安装Miniconda的详细教程,见我另外一篇博客:Miniconda安装

2.2 新建虚拟环境

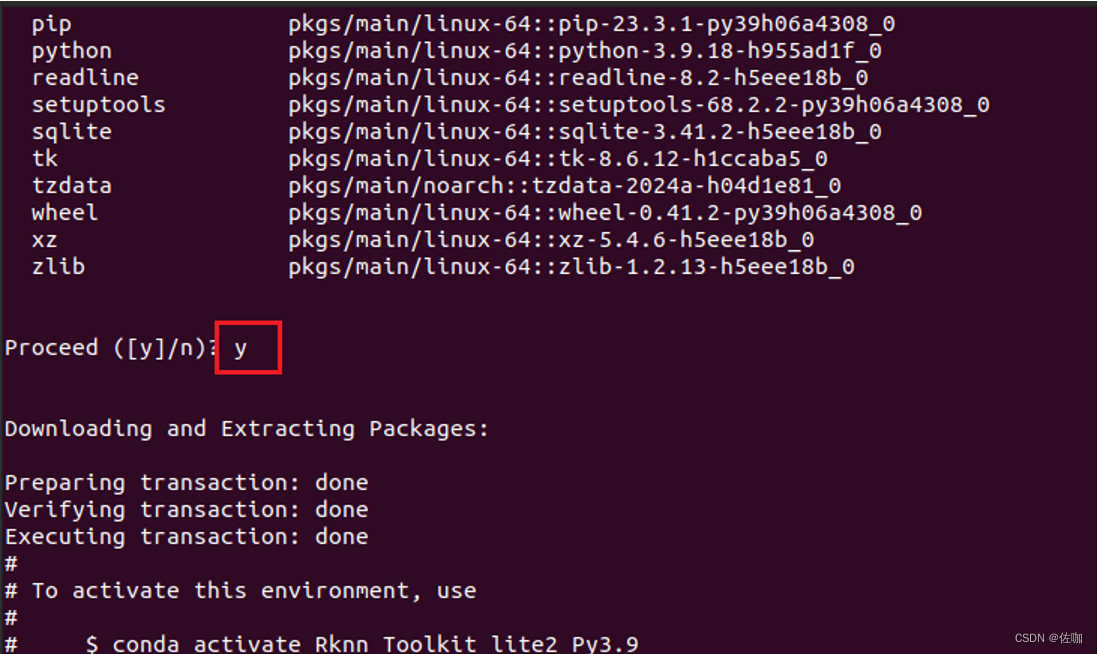

上一步Miniconda安装好后,在此基础上安装一个新的虚拟环境,如下,:

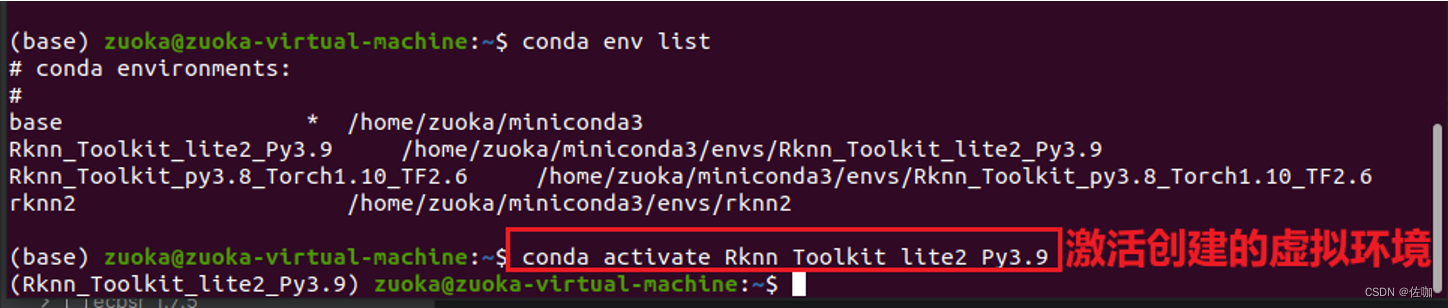

查看已有虚拟环境命令为:

conda env list

创建新虚拟环境命令为:

conda create -n name python=3.9

上面步骤创建好后激活虚拟环境,如下:

激活命令为:

conda activate name

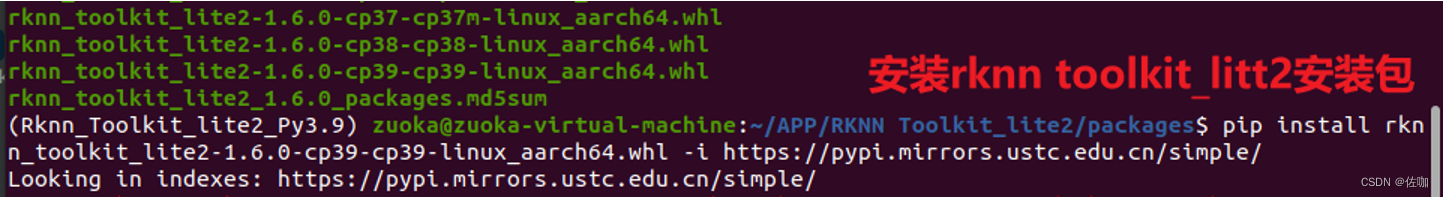

2.3 安装rknn_toolkit_lite2包

rknn_toolkit_lite2包的轮子文件,在我提供源码包中的packages文件夹中,如下:

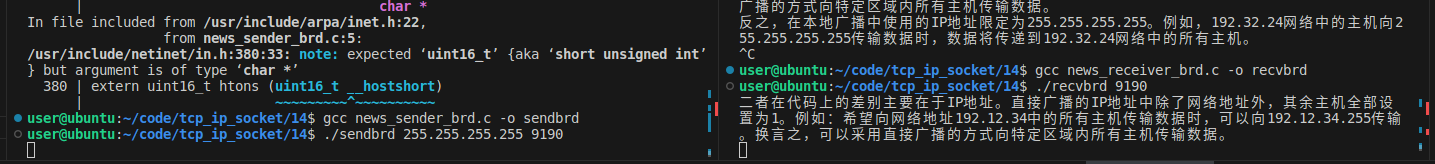

在激活的虚拟环境中,进入到存放轮子文件目录下,使用下面命令安装:

pip install rknn_toolkit_lite2-1.6.0-cp39-cp39-linux_aarch64.whl -i https://pypi.mirrors.ustc.edu.cn/simple/

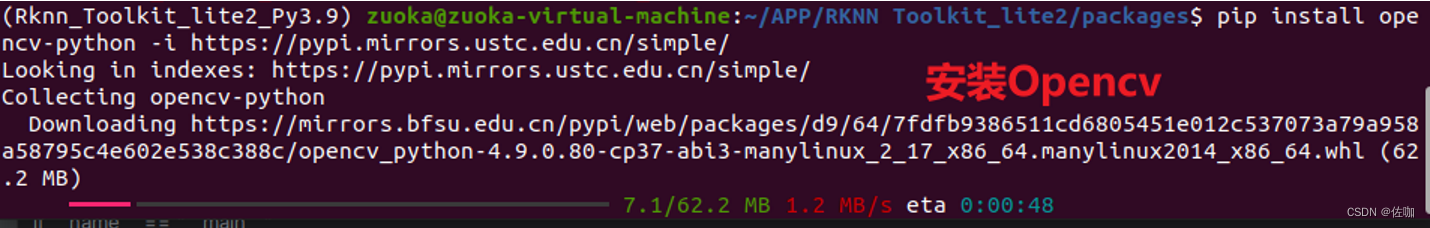

2.4 安装OpenCV包

在同样的虚拟环境下,使用下面命令安装opencv:

pip install opencv-python -i https://pypi.mirrors.ustc.edu.cn/simple/

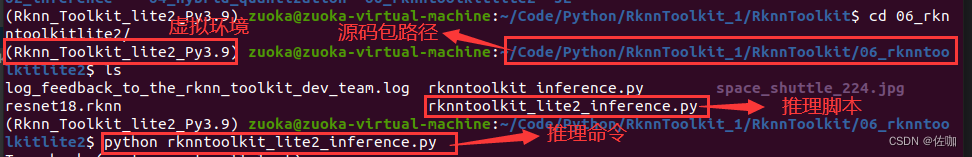

三、推理

上面环境都准备好后,在终端通过命令进入到源码包目录下,运行下面命令即可在开发板上推理RKNN模型。

python rknntoolkit_lite2_inference.py

3.1 代码

此代码对应源码包中的rknntoolkit_lite2_inference.py脚本。

from rknnlite.api import RKNNLite

import cv2

import numpy as npdef show_outputs(output):output_sorted = sorted(output,reverse = True)top5_str = '\n----------top5-----------\n'for i in range(5):value = output_sorted[i]index = np.where(output == value)for j in range(len(index)):if (i + j) >= 5:breakif value > 0:top1 = "{}:{}\n".format(index[j],value)else:top1 = "-1:0.0\n"top5_str += top1print(top5_str)def show_perfs(perfs):perfs = "perfs:{}\n".format(perfs)print(perfs)def softmax(x):return np.exp(x)/sum(np.exp(x))if __name__ == "__main__":rknn = RKNNLite()# 使用load_rknn接口直接加载RKNN模型rknn.load_rknn(path="resnet18.rknn")# 调用init_runtime接口初始化运行时环境rknn.init_runtime(core_mask = 0, # core_mask表示NPU的调度模式,设置为0时表示自由调度,设置为1,2,4时分别表示调度某个单核心,设置为3时表示同时调度0和1两个核心,设置为7时表示1,2,4三个核心同时调度# targt = "rk3588")# 使用Opencv读取图片img = cv2.imread("space_shuttle_224.jpg")img = cv2.cvtColor(img,cv2.COLOR_BGR2RGB)# 调用inference接口进行推理测试output = rknn.inference(inputs=[img],data_format=None)show_outputs(softmax(np.array(output[0][0]))) # 根据概率排名,打印出前5名的概率rknn.release()

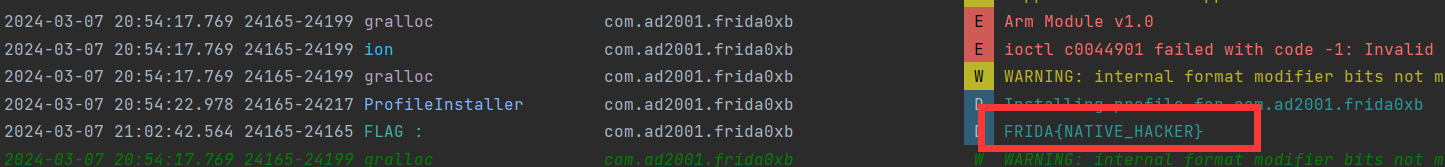

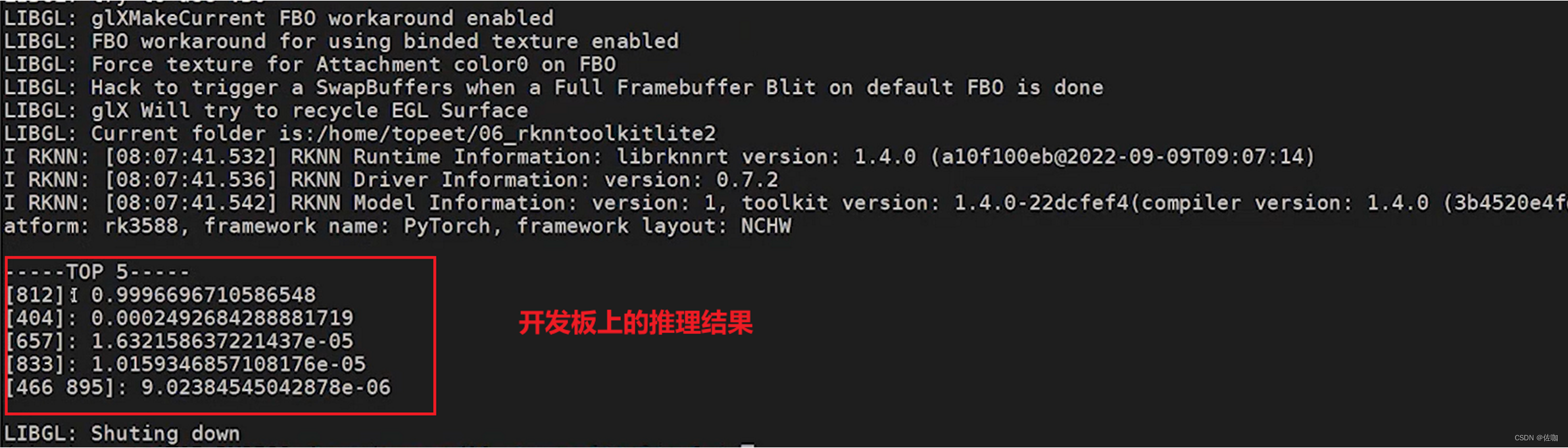

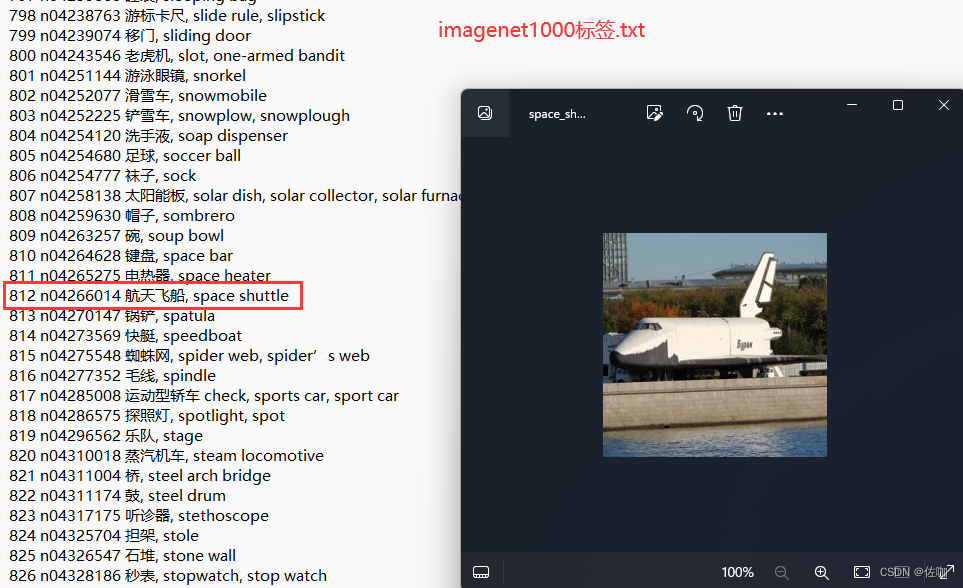

3.2 开发板推理结果

运行上面脚本,输出推理结果如下:

打开源码包中的图片和imagenet1000标签.txt文件对照查看,推理预测的结果与标签文件对应的类名一致,说明开发板推理结果正确,如下:

四、总结

以上就是rknn-toolkit-lite2部署RKNN模型到开发板上的详细过程,CAPI开发板部署见下一期博文。

总结不易,多多支持,谢谢!

感谢您阅读到最后!关注公众号「视觉研坊」,获取干货教程、实战案例、技术解答、行业资讯!