2 FAST APROXIMATE CONVOLUTIONS ON GRAPHS

在这一章节,我们为这种特殊的的图基础的神经网络模型f(X, A)提供理论上的支持。我们考虑一个多层的图卷积网络(GCN),它通过以下方式进行层间的传播:

这里,是无向图邻接矩阵加上自己本身。

是对称矩阵,

,

是层的训练权重矩阵。

表示激活函数,例如ReLu.

是

层的激活矩阵,

.在接下来中,我们将会展示,这种规则的传播方式是局部谱域滤波的一阶近似。

2.1 SPECTRAL GRAPH CONVOLUTIONS

我们考虑图上的谱域卷积 : 多维信号,用参数

定义的傅里叶过滤器

,i.e.:

这里U是归一化的图拉普拉斯矩阵的特征向量矩阵,这里,

对角矩阵是特征值,

是x的图傅里叶的转换。我们可以理解

是拉普拉斯矩阵L的特征值的函数,即

。计算公式(3)是非常繁重的计算,因为特征向量的矩阵U的乘法是

。并且,在大的图上计算L的特征值分解,其计算量之大以至于无法做到。为了规避在大图上特征值分解的问题,

近似是切比雪夫多项式

级截断

:

。

表示L的最大特征值。

是切比雪夫向量的系数。切比雪夫多项式递归地定义为

,这里面

。

回到我们信号x过滤器

这里;可以轻易验证

。这个表达式是K阶截断的拉普拉斯多项式近似,它依赖于中心节点周围做多K个节点的作用。公式 5的复杂度是

,随着边的数量线性增长。Defferrard et al 使用K阶卷积定义了图上的卷积网络。

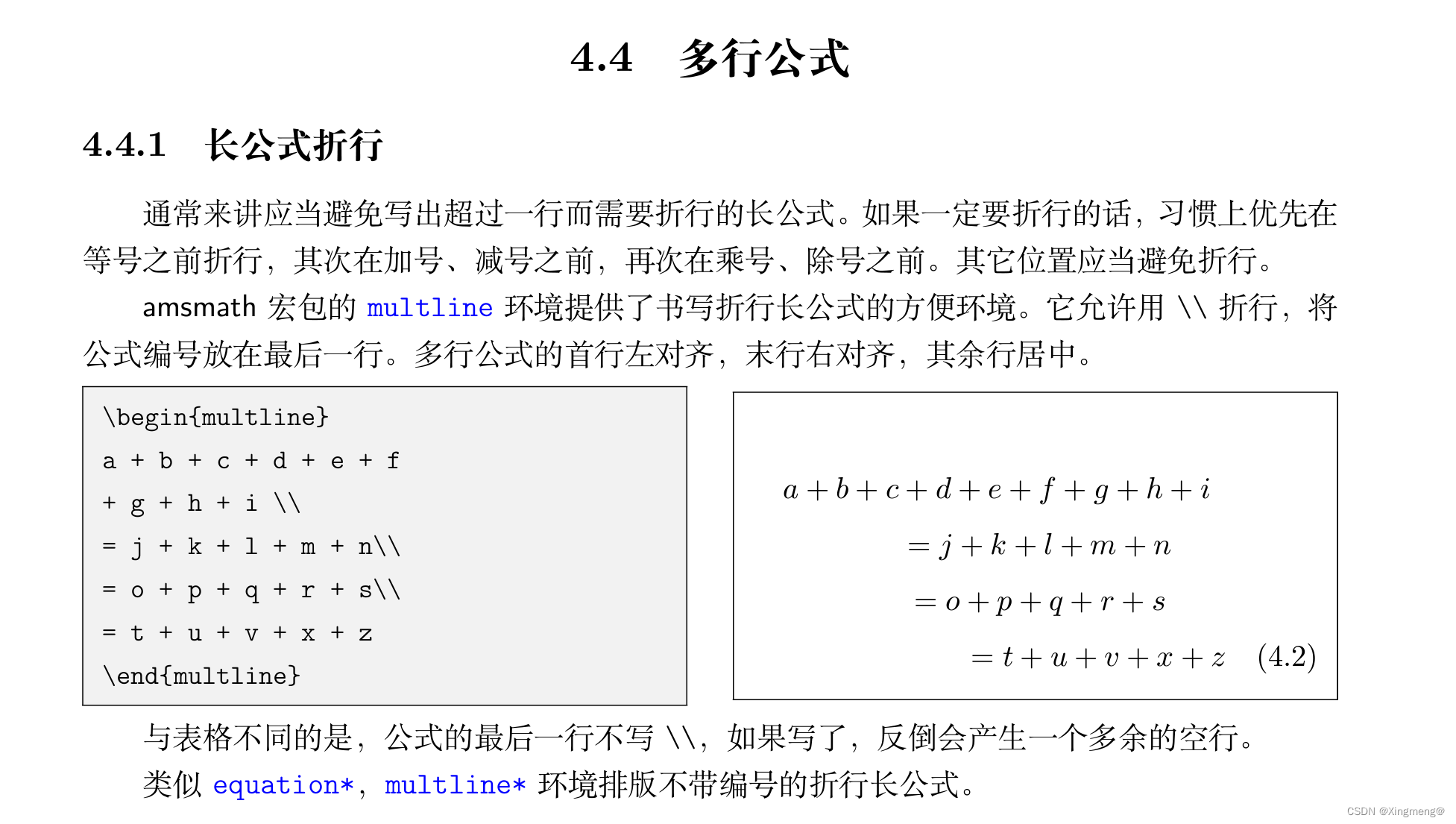

2.2 LAYER-WISE LINEAR MODEL

通过公式5,图卷积神经网络可以叠多个卷积层,每一层都是非线性的。现在,如果我们将层的卷积操作K=1,即图谱域拉普拉斯矩阵L的限行函数。

这种一阶的线性方式,我们仍然可以罗列多层的卷积层,这不局限于切比雪夫多项式。我直觉期望这样的模型能够对于点的度数很高的分布(例如,社交网络、引用网络、知识图谱和其他一些真实世界的数据库)的图结构起到减轻过拟合的作用。并且,对于一定的计算资源,这种一阶的layer-wise方式能够建立更深的网络。

这样一种GCN的方式,我们近似,训练过程中,网络的参数适应如下方式:

这里2个自由参数和

。这个过滤器的参数被整个网络共享。多层卷积过滤能够卷积到一个节点的第

层邻居,k就是图神经网络卷积层的层数。

在实际中,限制参数的数量以减少计算(例如矩阵乘法)已解决过拟合的问题,这种优化可以得到如下公式

一个参数。注意

的特征值取值范围在

。在神经网络里面叠多层这样的操作将导致数值不稳定,以及神经网络梯度的消失。为了有效缓解这个问题,我们将使用再归一化的技巧:

,

和

。

我们可以将上述的定义真正泛化到一个信号,带有C个输入通道(例如,每一个节点有C维的特征向量),F过滤和特征映射如下:

这里是过滤矩阵的参数,

是卷积信号矩阵。这个过滤操作有

的复杂度,

是稀疏矩阵和稠密矩阵的乘积。