文章目录

- 论文结构 及 读论文的方法总结

- 论文理解

- 看图

- Abstract

- Introduction

- RELATED WORK

- PROPOSED METHOD

- A Philosophy of Model Design

- B Framework of CURE-Net

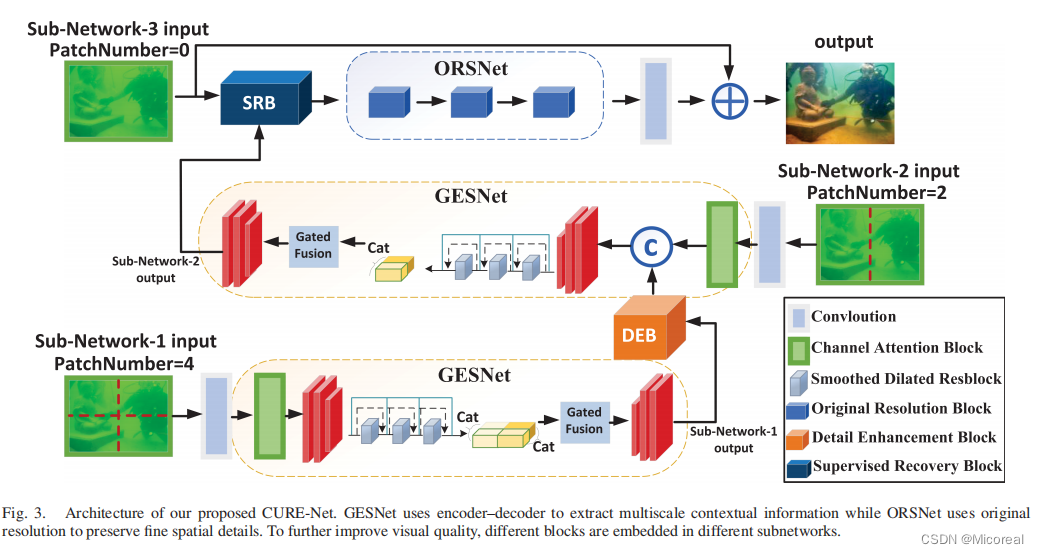

- C Proposed GESNet and ORSNet

- D Proposed DEB and SRB

- E Loss Function

- Experiment And Result

- A Implementation Details

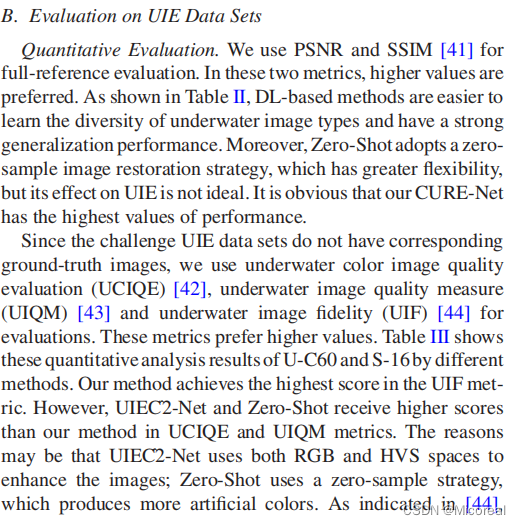

- B Evaluation on UIE Data Sets

- C Abltion Experiments

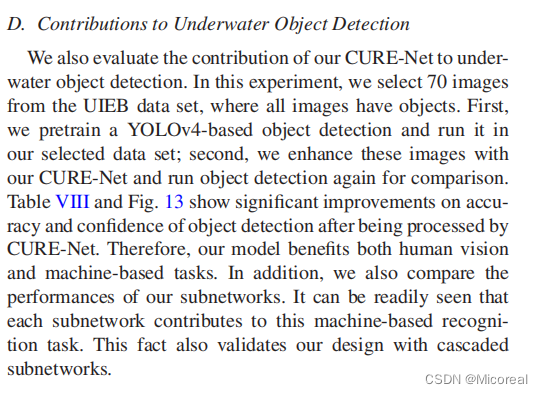

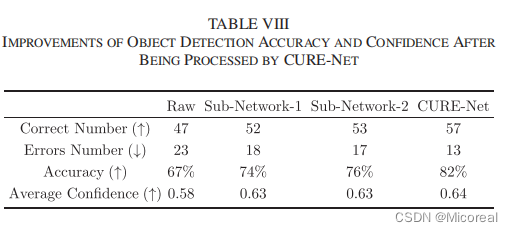

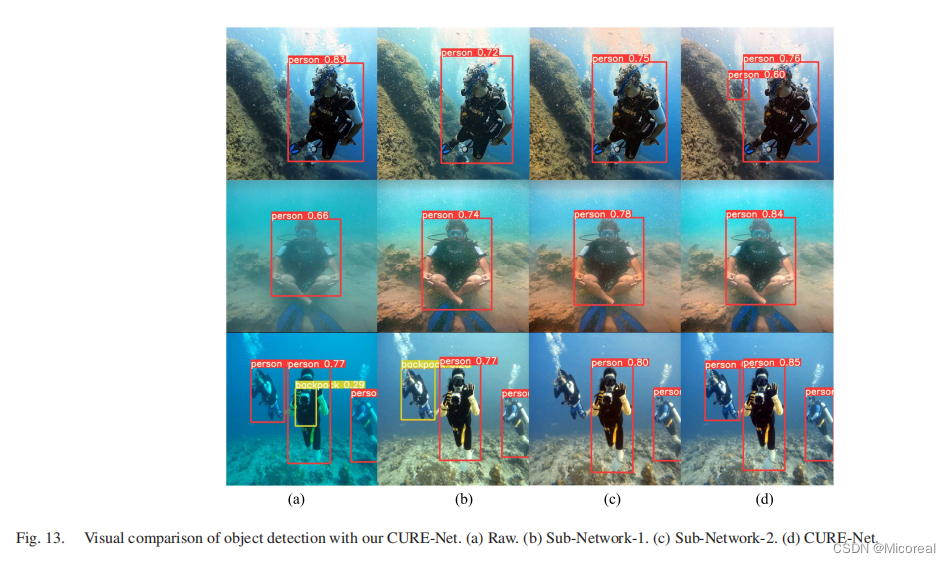

- D Contributions to Underwater Object Detection

- Conclusion

此篇文章来源于IEEE期刊。

链接: 论文下载

叠甲:本篇论文阅读仅仅是个人的想法与猜测。

刊物发布时间

IEEE JOURNAL OF OCEANIC ENGINEERING, VOL. 49, NO. 1, JANUARY 2024

作者列表:

Xiaowen Cai, Nanfeng Jiang , Weiling Chen , Member, IEEE, Jinsong Hu , Member, IEEE,and Tiesong Zhao , Senior Member, IEEE

前三位应该是共一作,这么写的话。

论文结构 及 读论文的方法总结

我稍微在word当中进行了相关的整理,关于目录其实每篇论文的结构都差不多,但由于之前没大概说过,这边就大概说一下每个部分大概讲解的是什么,之后的论文阅读就不细说了。(注意以下存是个人的super small cup理解)

首先注意的是,个人把读论文分作读三轮,所以下面也会有读论文的方法介绍。

- Abstract:这一部分主要就是对于自己论文方法概括性介绍以及对于自己研究的任务的概括性介绍【第一遍读的时候重要的】

- Introduction:对于上面的Abstract的详细介绍【可以详细看也可以不详细看】

- Relation Work:这一部分主要就是关于这个任务下,前人给予的贡献的叙述,也相当于站在巨人的肩膀上不能忘本,所以要提一嘴的【不太重要】

- Perposed Method:这一部分主要就是关于方法的具体接受【第二遍第三遍重点读的位置】

- Experiments And Results:这一部分主要是关于实验时超参数的调整的位置和最后的结果【第一遍第三遍重点读,但读的重点不一样】

- Conclusion:总结【小看一下,看完论文没想法就详细看】

读论文读三遍:

第一遍粗读:主要看的是Abstract(明白任务以及此篇论文的大概是什么个情况),然后去看Experiments And Results(这一部分是要看实验的硬件设施,以及作者 的方法相对于其他人的方法有多少提升),总结可以看一下

看完第一遍之后,需要明白的是自己能不能复现这篇论文(配置),以及这个任务对于自己的研究方向上有没有什么意义(抄袭创意点),如果都满足就可以开始考虑下面的第二遍

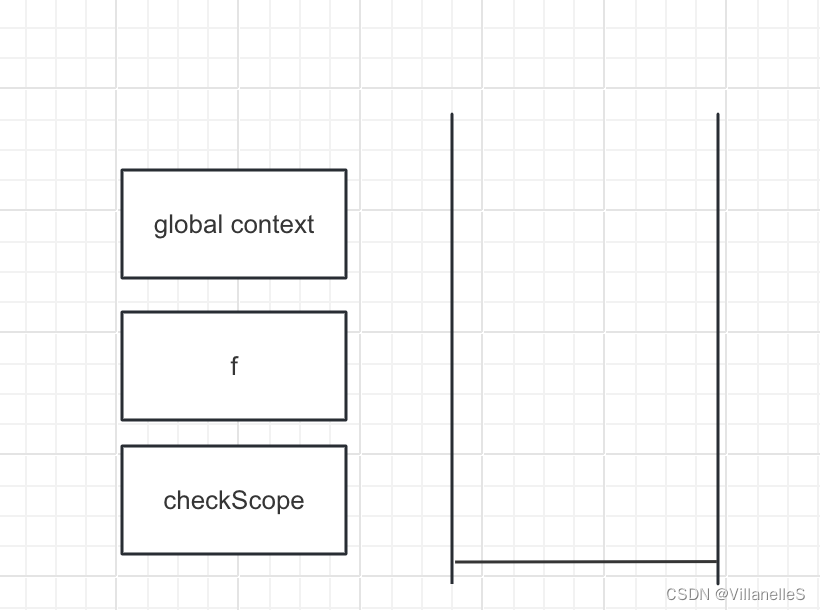

第二遍细度:第二遍主要看的位置就是Perposed Method位置,先搭配着论文给出的图片,对整体的算法有个想法,知道大概的流程是怎么样子的,也可以补充看一下Introduction的总结部分,知道每个部分的结构的作用

这一遍看完之后需要明白的是,你对于论文的前置知识是否有遗漏,需不需要去补充了解别的论文或知识点来辅助看懂这篇论文,比如读这篇论文,如果你还不知道CNN是什么,那在读原理的时候,就需要前去补充,要确保的是你读完第二遍之后对于整体的算法有个概括性的理解。并根据现在的理解,判断此篇论文对你研究的方向是否有效,是否还需要了解论文的细节上的处理,来决定是否进行第三步的阅读。

第三遍精读:第三遍主要做的事情是复现代码,一切脱离实践的阅读都是虚假的,这一步主要需要做的事情主要是搭配着code去理解算法【Perposed Method】,然后当代码大概搞懂了之后根据Experiments And Results中的超参数进行复现论文,然后看看此篇论文是否能复现【注意数据集,很多情况下数据集选择的不同,或者说不按照论文提供的数据集来训练,结果会很一般,我被坑了好多次。。。。。】。

论文理解

下面是个人存手工翻译,由于处于大三,所以并不是很系统的学习过机器学习,只能说略懂,已经尽量去把一些机器学习名词给还是弄成英文了,但有些个人可能还是不知道,会直接直译。

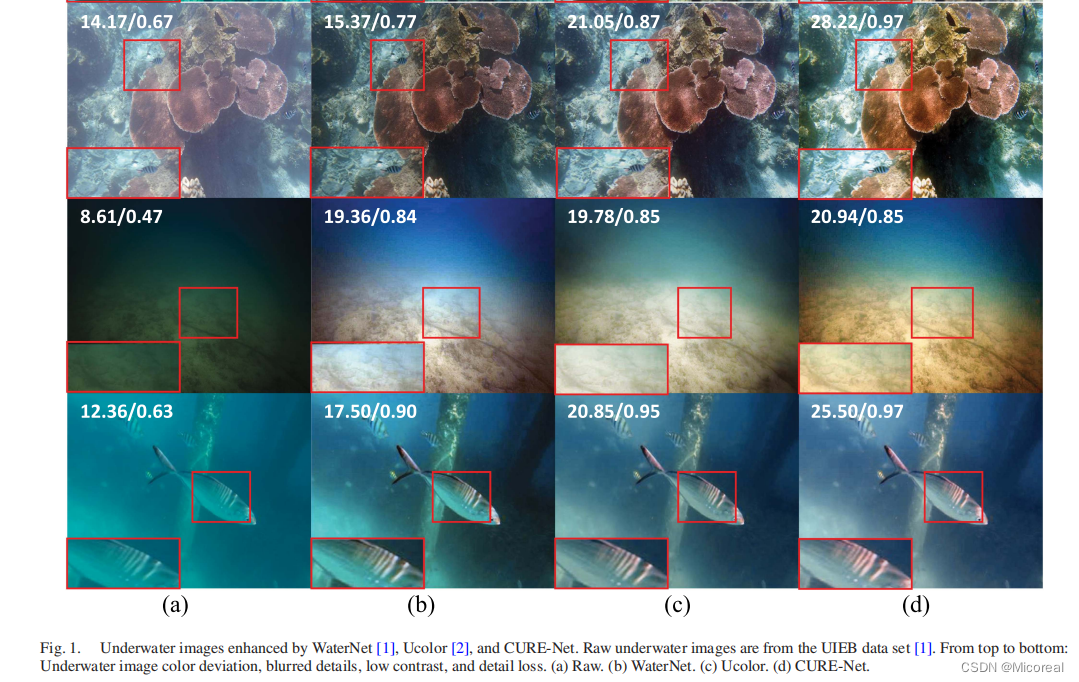

看图

这一步需要了解大概的任务,以及模型的大概思路:

比如论文中的这张图,我们可以看出,这篇论文做的事情实际上是水下的图像识别的。

然后就是抓模型大概了解,别死钻:

一看就是利用transfomer架构的CNN变种,需要知道的是图片的流向输入输出。

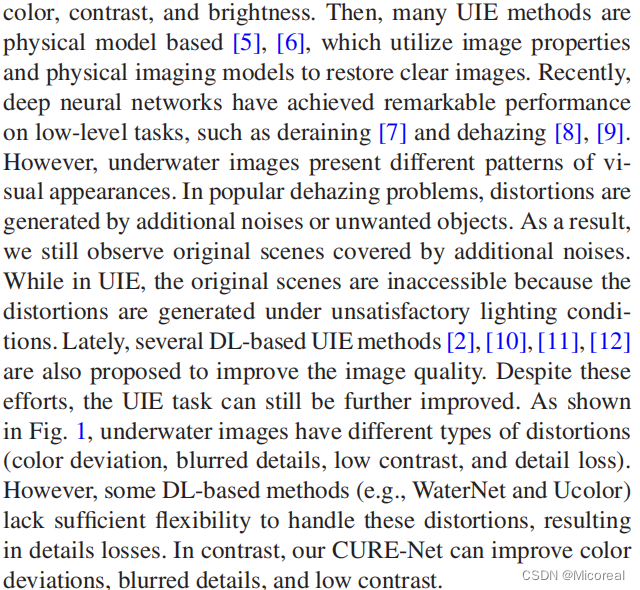

Abstract

由于光的色散和吸收,水下图像在低对比度和图像铸造上会退化。

这个因素限制了在水下和海洋环境下的图像识别的准确性。

在这篇文章中,为了解决这个问题,我们采用CURE-Net,这个网络用从粗到细的方式去改善这种水下的退化。

具体来说,CURE-Net包含三级子网。

前两级子网融合了注意力机制和门去学习多尺度的上下文信息,而第三级网络保护了网络本身的空间信息。

在子网之间插入了细节增强和有监督的恢复的block去更多的恢复图像的颜色和细节

我们让CURE-Net在流行的数据集上进行广泛的评价和得到了最好的效果。

对比于同辈的方法,我们的方法更友好,水下的目标检测在我们的方法下也更容易去识别。

总结:CURE-Net是一个级联网络,改善了水下成像的图像退化问题。

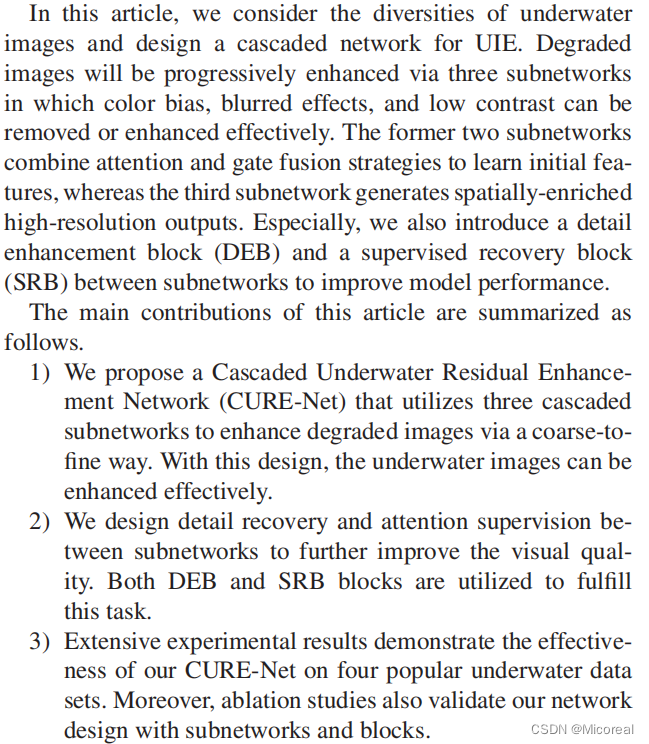

Introduction

因为光在穿过水的时候会衰退,水下图像检测经常有到噪点,颜色变形和低对比度的问题。

这些问题使得各种任务比如海洋生物识别复杂化。

因此,需要海洋图像增强(UIE)的方法已经被提出去改善水下图像的退化。

现在使用的UIE方法包括基于传统算法的和深度学习算法的。

早期的尝试([3][4])主要是通过处理图像的像素提高特定图像的特征,比如通过调整颜色,对比度,亮度。

然后,很多的UIE算法的模型是基于([5][6]),这些算法都是利用了图像本身的属性和物理的成像规律来恢复成清晰的图片的。

最近,深度神经网络在低级任务中已经取得了显著的性能提升,比如去雨去雾([7][8][9])方面。

但是,水下图像展现出不同的视觉外观的模式。

在传统的去雾问题当中,图片噪点和不想要的对象造成了图片扭曲。

因此,我们仍然可以看到包含大量噪点的原始图像。

而在UIE当中,原始场景是不可见的因为图像的变形是在令人不满意的光照条件下。

最近,各种基于深度学习的UIE算法([2][10][11][12])都是用来改善图像的。

尽管做出了这些努力,UIE任务仍然可以进一步改进。

如图1所示,水下图像存在不同类型的变形(颜色偏差、细节模糊、对比度低、细节损失)。

但是,一些深度学习方法(waternet和ucolor)缺少足够的灵活度去处理这个变形,从而导致了细节上的损失。

我们的CURE-Net对比于前面的方法能改善颜色偏差,细节模糊,低对比度的问题。

在这篇文章中,我们考虑了水下图像的多样性,设计了一个级联的UIE神经网络。

退化的图片将会被逐渐加强,通过三个级联网络,颜色偏差,模糊效应,和低对比度能被很好的移除或者有效的增强。

先前的两个子网把注意力和门机制融合来学习最初的特征,然后第三级网络生成空间丰富的高分辨率的输出

特殊的是,我们在级联网络中引入了一个细节增强模块DEB和有监督的恢复模块SRB来改善模型的表现

这篇文章主要的贡献总结如下:

- 我们提出了一个级联水下残差增强网络(CURE-Net),它利用三个级联子网通过粗到精的方式增强退化图像。通过这种设计,可以有效地增强水下图像。

- 我们设计了子网之间的细节恢复和注意监督,进一步提高了视觉质量。DEB和SRB块都被用来完成这项任务。

- 大量的实验结果证明了我们的CURE-Net在四个流行的水下数据集上的有效性。

此外,消融研究也验证了我们的网络设计与子网和块。

RELATED WORK

现在的UIE方法可以被粗略的分成两类,第一类是基于传统算法的,第二类是基于深度学习算法的。

而很少有与视频相关的UIE的方法;本文中,我们主要关注于图像方向上的UIE算法。

A Traditional Methods

早期的研究工作通过调整像素的值来提高视觉的质量。

例如,Iqbal([3])设计了一个对比度校正模型来提炼出蓝色和红色的通道

Chiang和Chen([4])提出了通过融合暗通道先验和波长补偿来改善水下图像

Ancuti([13])提出了多尺度融合的UIE解决方案

一些其他的工作也基于Retinex的理论进行展开([5],[6])。

例如,Fu([5])提出了一种Retinex框架的变种去去除水下图像的反射和照明。

Zhang([6])提出了基于扩展的多尺度的Retinex的UIE算法,这个算法是在CIELAB色系上处理水下图片的。

Peng([14])提出了一种 Generalized Dark Channel Prior,它依赖于深度的颜色变化来估计环境光。

Liu和Chau([15])观察到水下图像的暗通道趋于为零,并提出了一种基于对比度增强的系统增强方法。

Li等人([16])提出了一种颜色校正和水下图像去雾的混合方法。

最近,Akkaynak和Treibitz([17])设计了一个基于物理模型的水下的颜色校正算法

这些算法都可以很好的被执行,但是由于在复杂的水下环境的限制,不免有低对比度,细节损失,颜色偏差的问题。

B DL-Based Methods

深度神经网络广泛应用于低水平视觉问题上([18][19][20][21]).

Li([10])建立了一个基于WaterGAN的DL模型,这个模型把水下图片作为输入,输出高质量的图片输出。

相同的,他还提出了一个弱监督的水下颜色转移模型(Water Cycle-GAN) ,这个模型基于对抗神经网络。

为了得到水下图片的多样性,Li提出了UWCNN去直接重现清晰的水下图片。

Guo([23])提出了一种多尺度的Dense-GAN,这个方法通过学习真实领域下的分布来提升UIE。

Jiang([12])提出了轻量的级联网络LCNet,这个网络用Gaussian Laplacian图像金字塔来用更少的参数得到更清晰的水下图片重现。

Li([2])提出了基于多色传输的UIE神经网络。

Fu([24])提出了一个新颖的UIE算法(SCNet),这个算法是来解决多样性衰退的。

Wang([25])提出了一个UIEC2-Net,这个模型有效的把RGB色系和HSV色系整合到一个简单的CNN网络结构当中。

Kar([26])提出了一种基于Koschmieder的模型的zero-shot的方法。

Gangisetty和Rai([27])提出了FloodNet,这个网络用残差dense网络来评估恢复水下图片

Zhang([28])用最小的颜色损失和自适应对比度增强来改善水下图片的退化。

Zhang([29])通过衰退的颜色通道校正和细节保留的对比度增强器来解决这个问题

最近,从粗到细的策略已经在低级任务当中展示了其的有效性。

Cho([30])重新考差了从粗到细的策略并提出了一个多输入多输出的U-net(MIMO-UNet)来去模糊。

Li([31])通过轻量级的的LPNet网络来实施了从粗到细的低光条件下的图像增强。

受到他们的启发,我们提出的算法采用不同的级联的子网来逐步增强图片。

PROPOSED METHOD

水下图像有他们自己的特点。

第一,光的衰减在水中是不均匀的和与波长相关的。

第二,在水体中的粒子反射光源,因此水下成像具有反射的效果

第三,在深水区域,捕获的图片经常有很低的光照条件。

因为上面的因素,水下成像经常显示出他会让颜色扭曲,让细节模糊,对比度降低。

为了解决水下成像的不同种类的问题,我们设计出CURE-Net如下介绍。

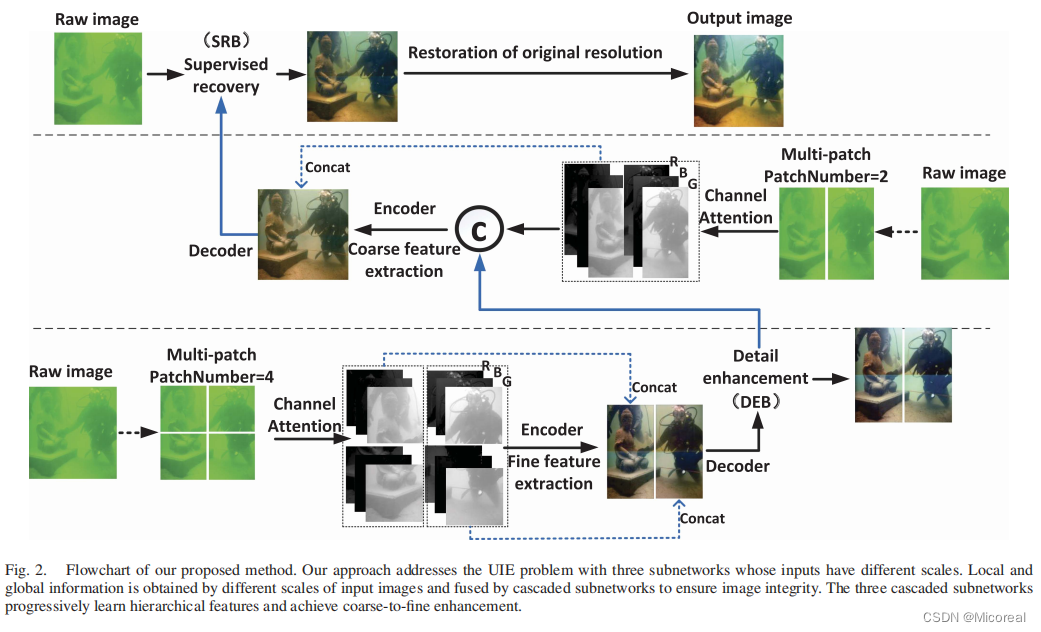

A Philosophy of Model Design

解释:

如上所述,水下图像遭受到不同程度的退化,包括局部细节的损坏(例如额外的噪点和模糊的区域)和全局的伪影(例如颜色偏差和对比度丢失)。

因此,我们能在不同的图像区域中去使用多尺度的操作来捕获局部或者全局的信息和融合他们以确保图像的完整性。

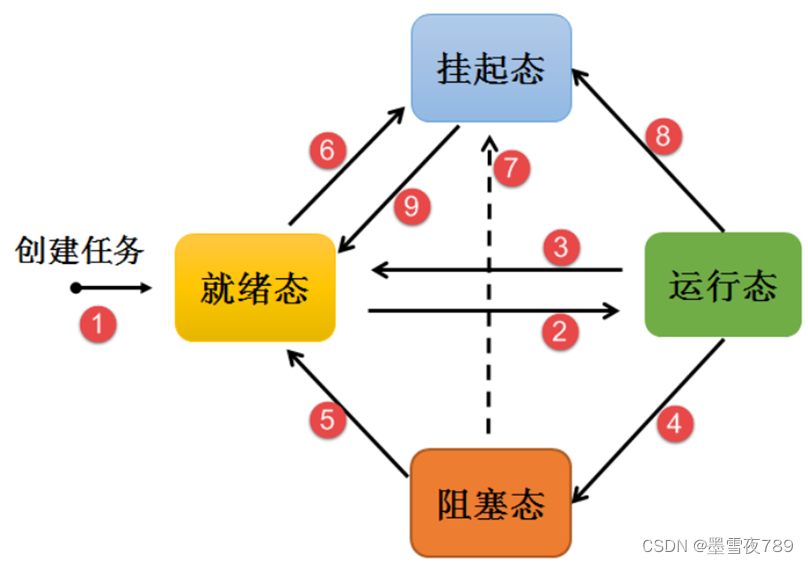

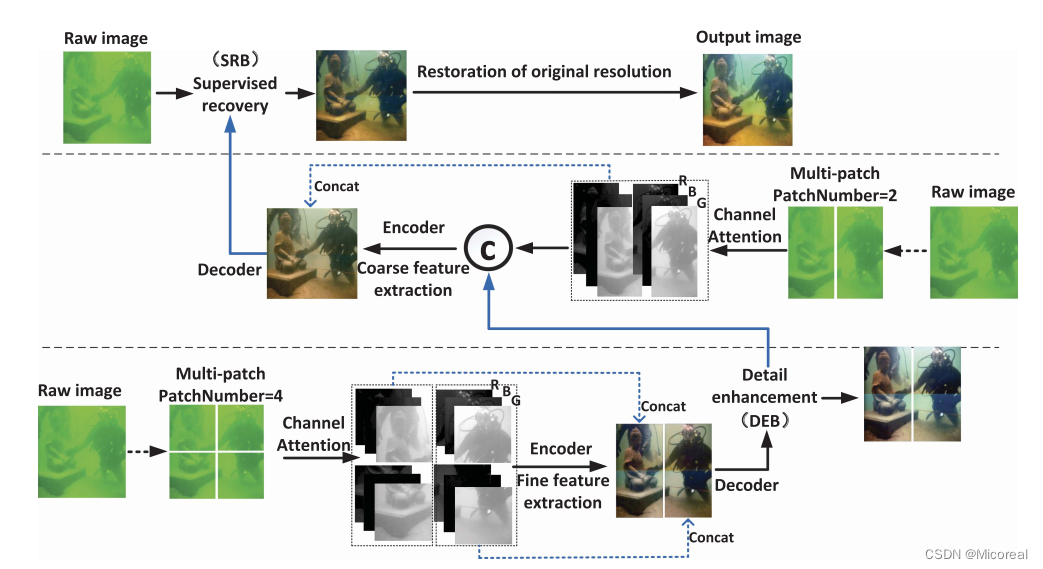

如图二所示,我们用三个不同尺度的子网来解决UIE问题。

我们提出的方法逐步学习层次特征去实现从粗到精的增强。

在前两个子网络当中,我们利用channel attention去加上一些通道权值,这有助于纠正水下图像的对比度偏差。

在第三个子网当中,我们只处理最初的图像的分辨率以免造成细节的损失。

更甚的是,在第一个和第二个子网之间,我们使用DEB去去除额外的噪点和模糊;同时在第三个和最后一个子网当中,我们使用SRB去进一步指导先前获得的层次特征的图像增强。

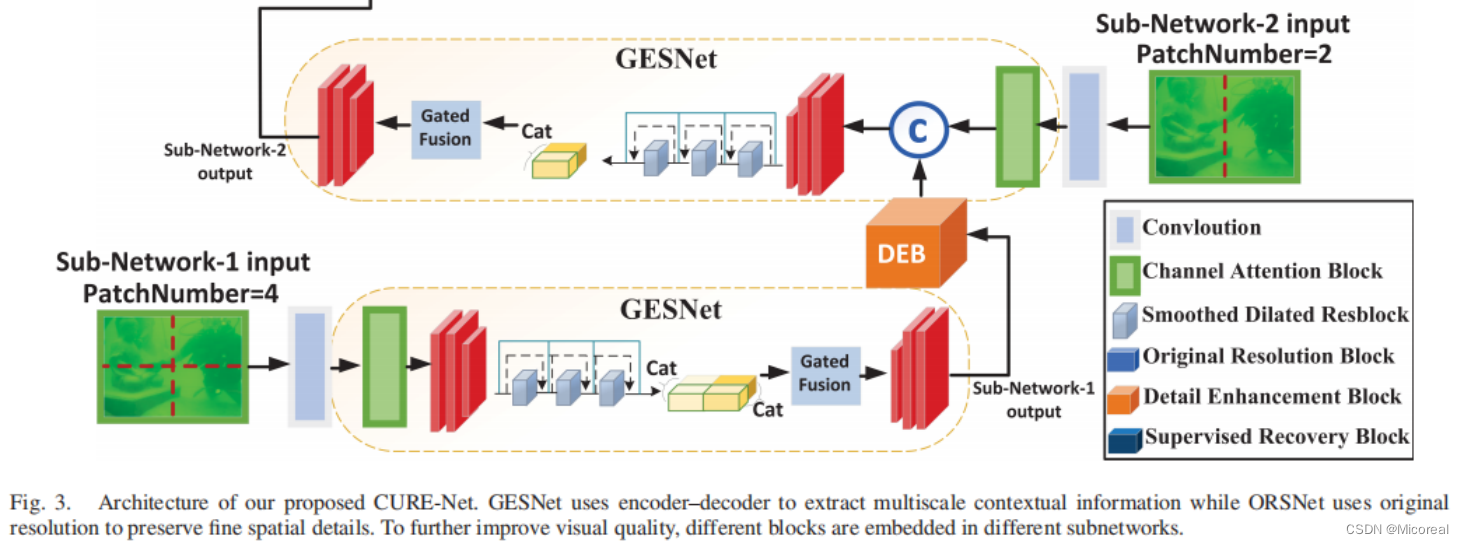

B Framework of CURE-Net

解释:

图三展示了CURE-Net的体系结构,它包含着三个子网,并用来逐步恢复图像。

前两个GESNet被用于学习上下文信息。

图像增强是一个对位置很敏感的任务,这个任务需要从输入到输出中的像素到像素的关系

因此,我们使用了ORSNet,这个网络能保留精细的纹理

特别的,一个DEB模块被添加到学习图像的多尺度特征,同时一个SRB来融合前面的信息并进行最后的图像的重建

子网的细节和块的阐述如下

C Proposed GESNet and ORSNet

解释:

为了获得更多的UIE的信息,我们在图三当中提出了GESNet

首先,得益于不同的通道信息有不同的权重,我们添加了channel attention模块(CABs)来校正水下图片的颜色偏差

第二,替代于使用转置的卷积层来提升解码器中的空间分辨率,我们嵌入扩大的卷积层来夸大接受域避免细节损失。

更甚的是,我们使用一个门融合来融合来源于不同残差块的特征

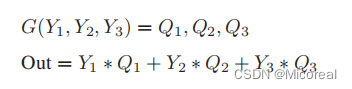

门融合主要通过一个卷积核是3*3的卷积层实现,它的输入是Y1Y2Y3的矩阵拼接,和输出的通道数是3.

我们首先从三个带有不同膨胀因子的残差块中提取出特征图(Y1Y2Y3),并将这些特征图喂给门融合模块。

门融合控制模块的输出是三种不同的的重要权重,每个权值对应一个特征的级别。

最后,这三个特征图和回归的权值呈线性组合。

具体的过程见下

其中G(`)代表的是门融合模块,Yi和Qi分别表示输出的第i个残差块和对应的输出的门融合。

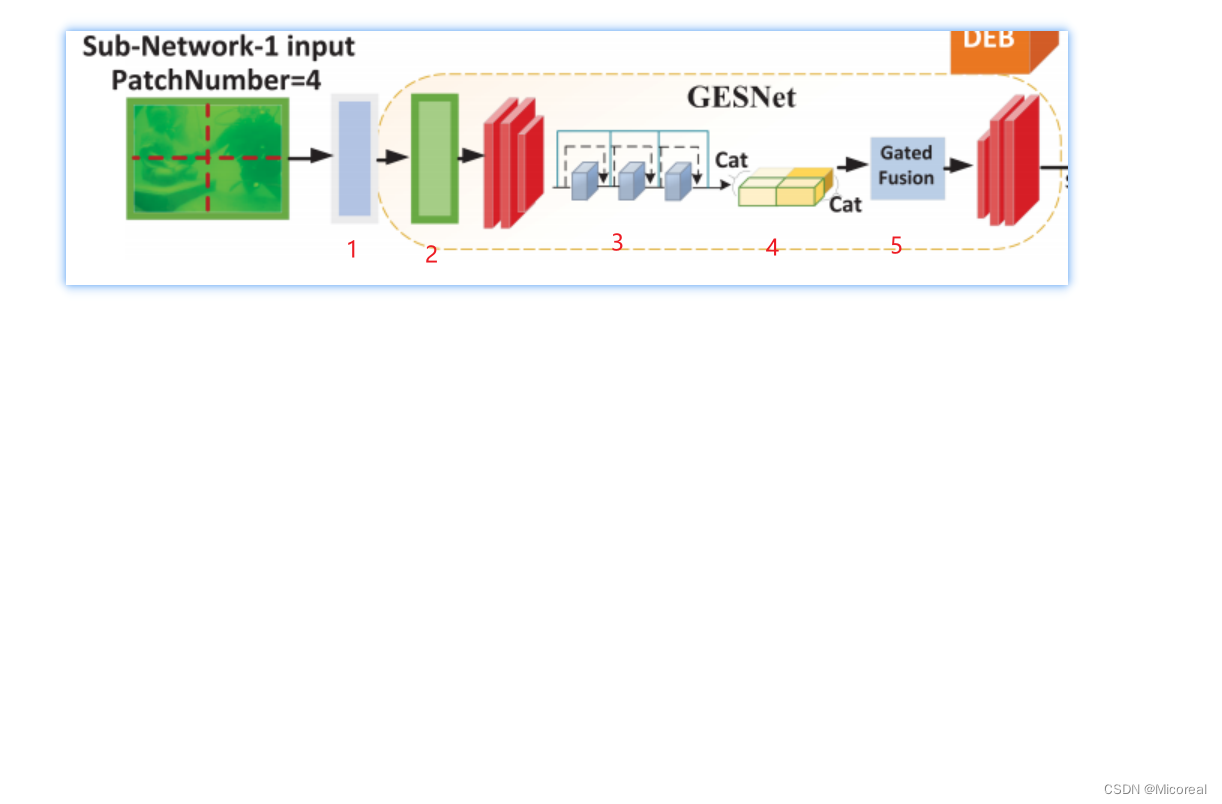

这一部分主要介绍的是GESNet,但是介绍的不是很清楚,并且也没代码予以理解,这边就仅仅给出个人的理解:

详细解释:

0:首先就是把图片分成4个patch

1:经过一层Conv(卷积层),此时需要注意的是绝大多数的Conv都会增加通道数以避免图像损失太多,而产生问题。

2:经过一层Channel-attention,对于图片加上了深度注意力的考虑,使用的算法个人并不知道,但其实可以当做1*1的卷积来进行思考。

3:然后经过三层带有残差的空洞卷积(膨胀卷积),这边实际上有一个思考,也是我之前一直不太理解的,文中原句是替代于使用转置卷积(反卷积),我们采用空洞卷积进行替代,可以更好的保护好其图片的性能,我们这时候就会产生一点疑惑,就是反卷积做的是上采样,空洞卷积做的是下采样,二者完成的工作不同,那该怎么去理解这件事情呢?

这边个人的猜测有二:

其一:论文写错了,原本想继续使用卷积。

其二:上面通过经验得知,我们经过卷积之后channel会增加,然后后面的4有需要将之拼接成一张图片,故这里需要还原成3通道,然后经过他们的经验或者是实验得到反卷积的还原成3通道和空洞卷积还原成3通道,他们觉得空洞更好。

这边存疑。

4:自然就是拼接concate

5:具体就见那个数学公式,将前面输入的三通道Y0,Y1,Y2做拼接,然后分别乘上系数。

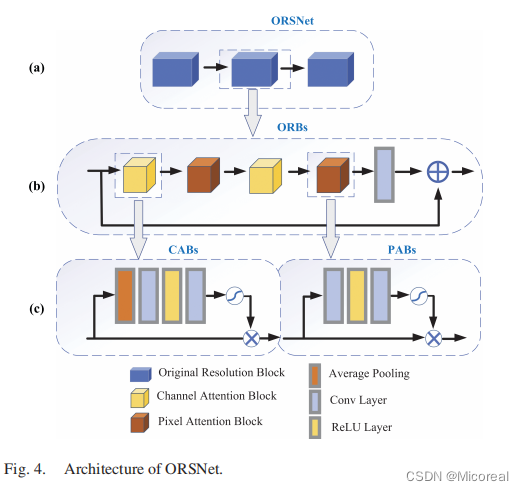

为了在保护UIE过程中的细节,我们在最后使用了ORSNet并不进行任何降采样的操作(见图4)

考虑到水下成像的颜色和水体的影响,我们采用了CABs模块和PABs模块去得到像素和通道的信息来得到更好的增强。

如图4(b)所展示的,ORSNet包含多个原始的ORBs模块,每个模块都包含更多的CABs和PABs

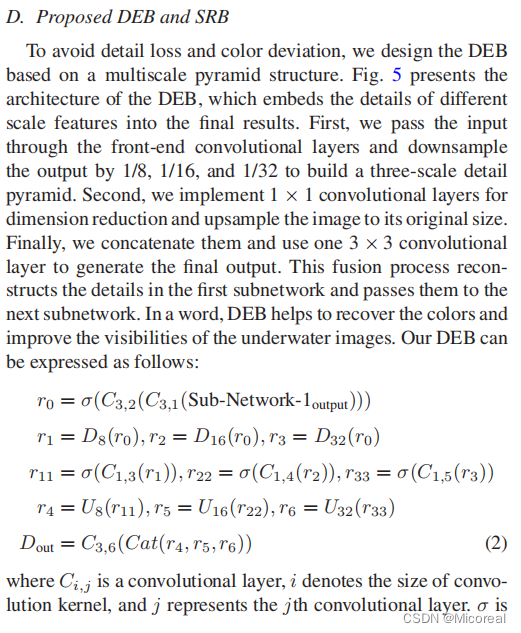

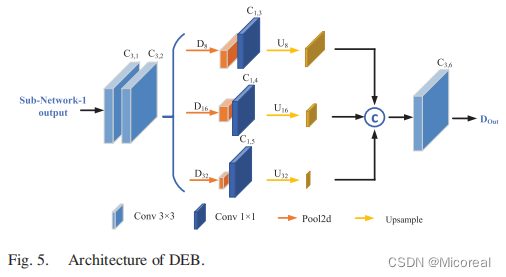

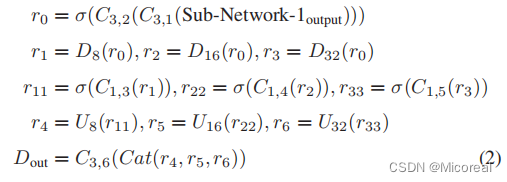

D Proposed DEB and SRB

解释:

为了避免细节损失和颜色偏差,我们设计了基于多尺度金字塔结构的DEB。

图五展示了DEB的结构,它把不同尺度的特征嵌入到最后的结果当中。

首先,我们输入通过前端的卷积层,并进行降采样1/8,1/16,1/32,以建立三尺度的细节的金字塔。

第二,我们使用11的卷积来降维并把图像还原到原本的形状

最后,我们把他们连接起来,并使用一个33的卷积核去生成最后的输出

这个融合的过程重建了第一个子网的细节和把这些细节传递给下一个子网。

总之DEB有助于恢复颜色和提高水下图像的可见性。

我们的DEB表示如下:

其中,Cij表示的是卷积层,i表示卷积核的大小,j表示第几个卷积层。

xigema 表示就是relu。

Dp和Up代表池化操作和上采样操作。

DCB总结:见公式吧,已经很完整了。

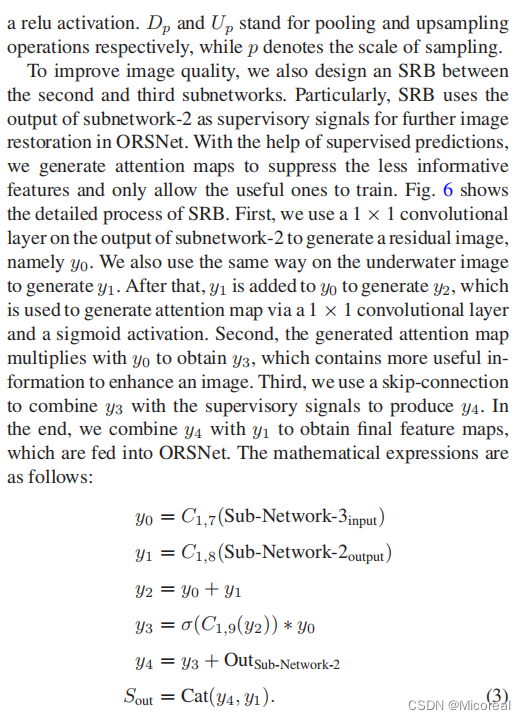

为了提升图像的质量,我们也设计了一个衔接在第二个子网和第三个子网的SRB模块。

特殊的是,SRB使用第二个子网的输出作为监督的信号,并在ORSNet当中进一步的图像恢复。

在监督预测的帮助细,我们生成注意力图去抑制少量信息的特征和只允许有用的特征去训练。

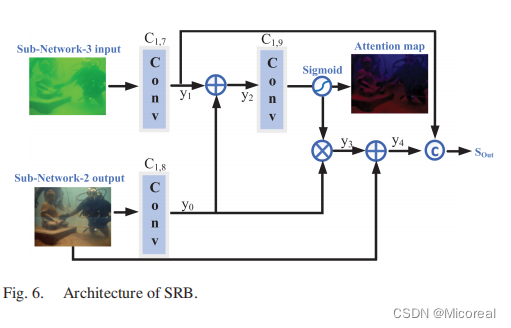

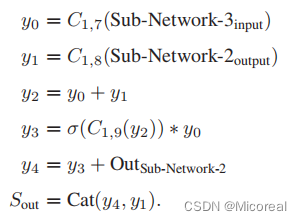

图6中展示了SRB的详细的细节

首先我们在子网2的输出上使用一个11的卷积层去生成一个残差图片,取名叫y0.

我们也使用相同的方法去处理一张水下图片叫y1.

在此之后,y1和y0一起生成y2,然后再通过一个11的卷积层和一个sigmoid的激活函数。

第二,生成的注意力图和y0做乘法得到y3,y3就包含着更多有用的信息去增强图像。

第三,我们使用skip-connection(这里使用的是残差网络),把y3和和这个监督信号结合起来生成y4.

最后,我们把y4和y1结合起来得到最终的特征图,并将之输入给ORSNet。

数学表达式见下:

SRB总结:一样数学公式总结的很好了

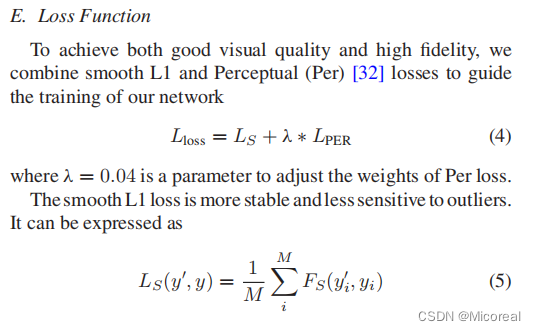

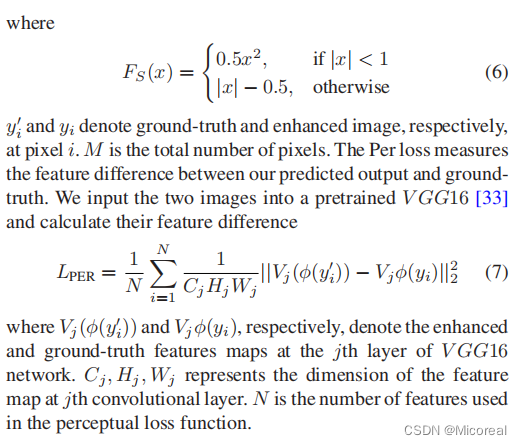

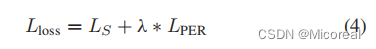

E Loss Function

解释:

为了实现好的视觉质量和高的保真度,我们融合了L1和Per([32])去指导训练我们的网络

其中,λ=0.04是一个调整每次损失权重的参数

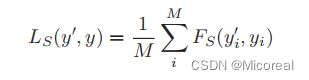

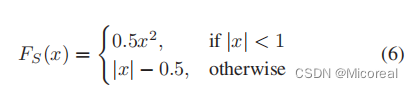

平滑的L1损失更稳定,对于异常值不太敏感,他可以表示为

y1撇和y1分别表示像素处的真实场景下的图片和图片增强的图片。

M是像素的总数。

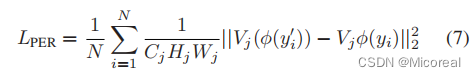

Per损失解决了在预测输出和真实场景下的特征差异。

我们输入两张图片到预训练好的VGG16网络和计算他们之间的特征差异是

其中,Vj撇和Vj分别代表图像增强和真实场景下的第j层VGG16的图

CWH就是第j层卷积层上特征映射的维数,N是在知觉损失函数中使用的特征数。

Experiment And Result

在这个部分中,我们采用了广泛的实验去评估我们提出的方法。

我们跑自己的算法在两个真实场景UIE的数据集下(UIEB和SQUID),和两个合成的数据集(EUVP和UFO-120)

对比的算法包括IBLA,RGHS,ULAP,UWCNN,WaterNet,LC-Net,Ucolor,SCNet,UIEC2-Net,Zero-Shot和MIMO-Unet。

此外,我们进行了大量的消融实验去证明我们的每个组成成分的有效性。

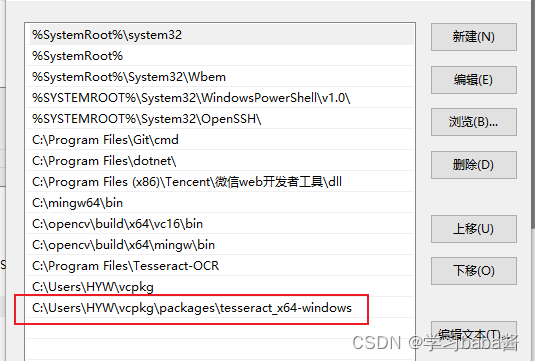

A Implementation Details

整个网络是端到端的运用putorch框架的。

所有的训练和测试都是基于三张GTX 1080GPU的

我们使用Adam优化器并将其的β1和β2设置为0.9和0.999.

此外我们把初始的学习率设置为0.001和epoch设置为200.

特别的,我们让学习率每过30个周期就下降到原本的1/2.

我们裁剪图片到256256进行训练,然后用512512进行测试。

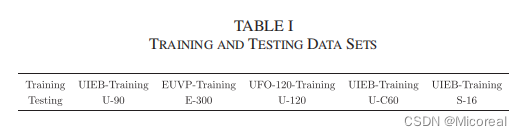

训练和测试的数据展示在表格1.

在UIEB的数据集当中我们挑选了800对图像进行训练和90对进行测试,将至记为U-90.

我们使用60张具有挑战性的水下照片进行测试,记为U-C60.

在EUVP数据集当中,我们挑选了Underwater ImageNet对子集,其中包含3700张水下合成的图片和相应的高质量图像。

我们使用其中3400对对图像进行训练,然后拿剩下的300对进行测试,记为E-300

在UFO-120数据集当中,我们挑选1500张图片作为训练集和剩下的120张图片作为测试集,记为U-120

在SQUID数据集当中,我们挑选了16个代表性的例子进行测试,记为S-16.

B Evaluation on UIE Data Sets

定量评价,我们使用PSNR和SSIM指标进行全参考的评估。

在这两个算子中,得到越高的值其效果就越好。

在表2中,基于DL的方法是更容易去学校水下图片类型的多样性和有更强的泛化能力。

此外,Zero-shot采用了零样本图片的恢复策略,这个策略更具灵活性,但是它在UIE任务上的效果是不理想的。

很显然,我们的CURE-Net得到了最好的表现。

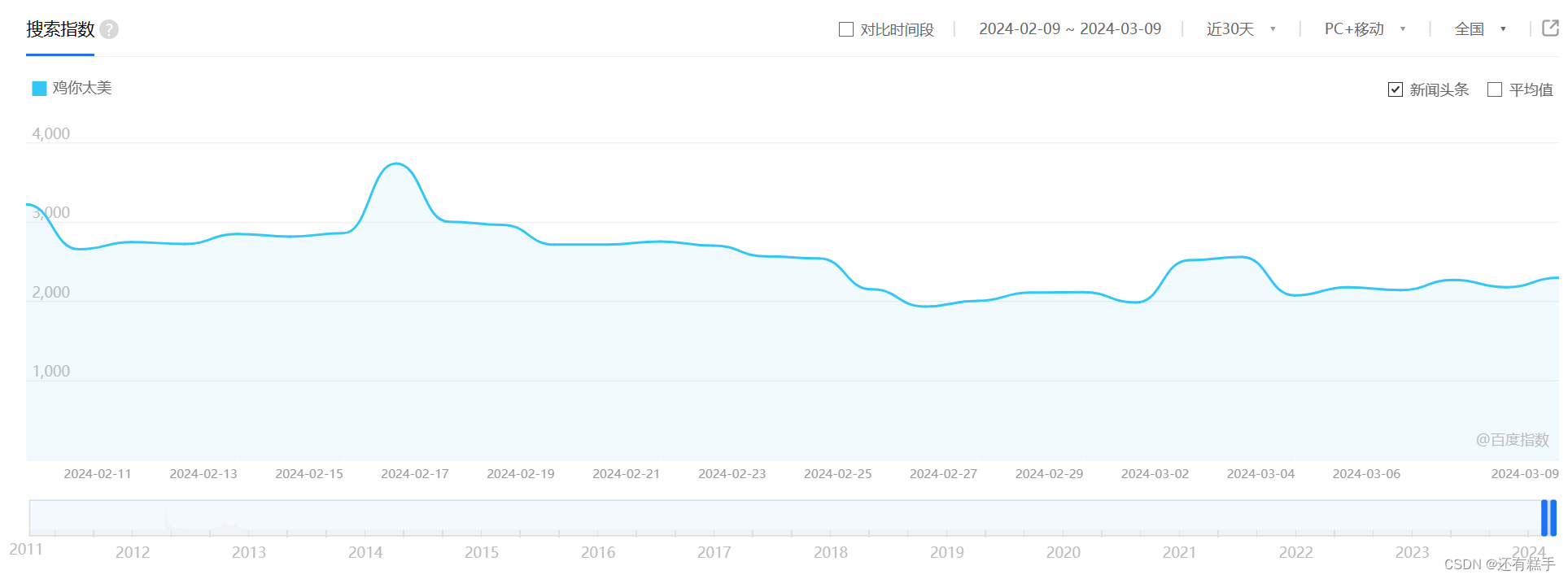

由于UIE数据集的挑战没有相对应的真实的图像,我们使用高质量的水下彩色图片评价(UCIQE),水下图像质量度量(UIQM),和水下图像保真度(UIF)来评估这些指标。

这些算子更喜欢更高的值。

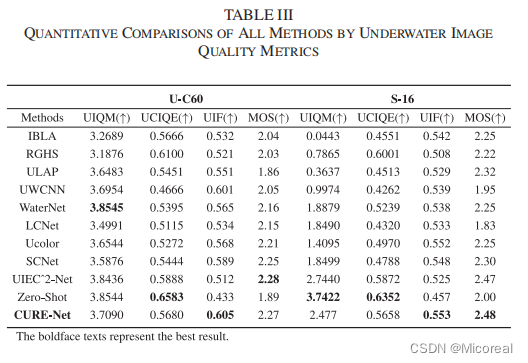

表三展示了通过不同方法的U-C60和S-16的定量分析结果。

我们的算法实现了在UIF上得到了最高的分数

但是UIEC2-Net和Zero-Shot在UCIQE和UIQM上得到了比我们更高的分数。

原因可能是UIEC2-Net同时使用了RGB和HVS色系空间来增强图片,

Zero-Shot采用了一个零样本数据,这样实际上能产生更多的人工色彩。

在([44])中表明了,这两个算子是在DL和UIE应用之前发展的,因此,在评估基于DL的UIE算法时存在缺陷。

我们主观的实验表明,我们的方法的结果是更好的。

特别的,我们邀请了16位志愿者(8位专家和8位非专家)去独立的评估这些图像增强的图像的分数(打分是1-5,最差到最好)

每张图片是根据颜色偏差的表现和伪影,对比度和全局的视觉表现。

在表三当中进行展示,我们的CURE-Net实现了在U-C60中得到了第二的好值,在S-16中得到了最好的成绩,这些成绩都证明我们的方法是有效的。

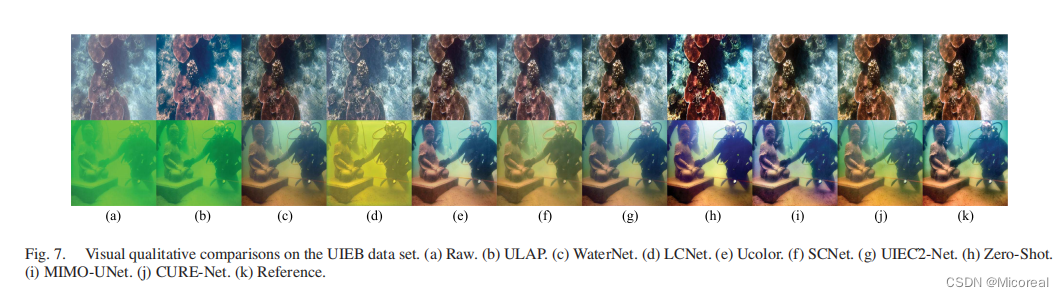

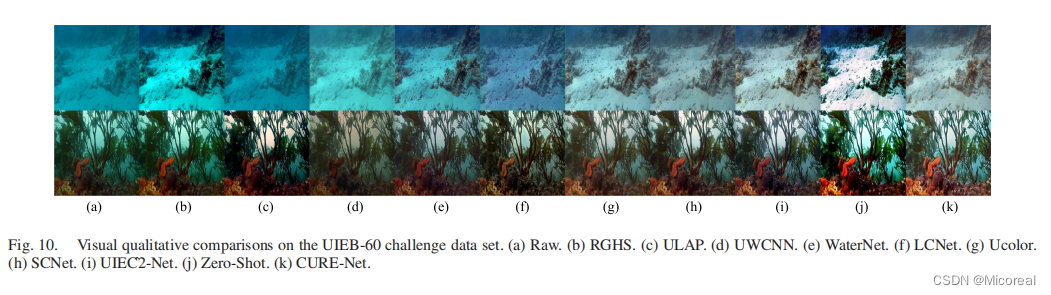

定性的评价上,我们首先展示了在UIEB数据集上对图7和图10的比较。

为了更好的反映出水下场景的多样性,我们选择了不同类型水下图片来评估。

可以看出ULAP不能增强水下的绿色的图片。

Water-Net 产生更黑的照片。

LCNet加重了色差的影响

MIMO-UNet产生了艺术颜色。

Zero-Shot导致了过度增强的过度饱和。

图标8展示了EUVP数据集的结果。

WaterNet生成的图像过暗。

UIEC2-Net导致图像失去了他原本的颜色

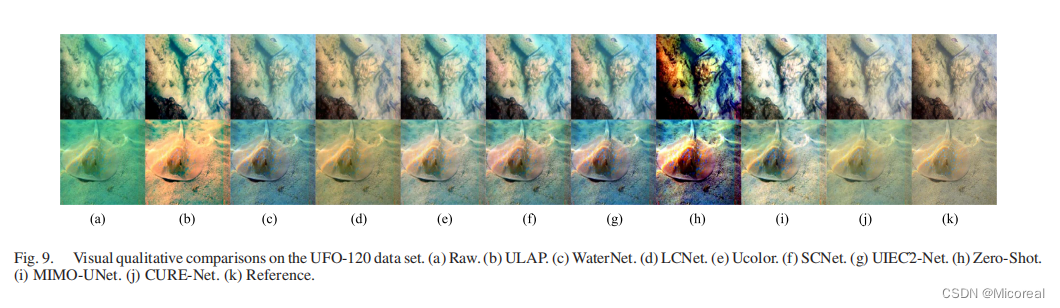

在图9中,对UFO-120的评价中,ULAP颜色变形了。

Ucolor基本上可以删除绿色,但仍然有退出问题的细节。

Zero-Shot引入了人工颜色,并不现实。

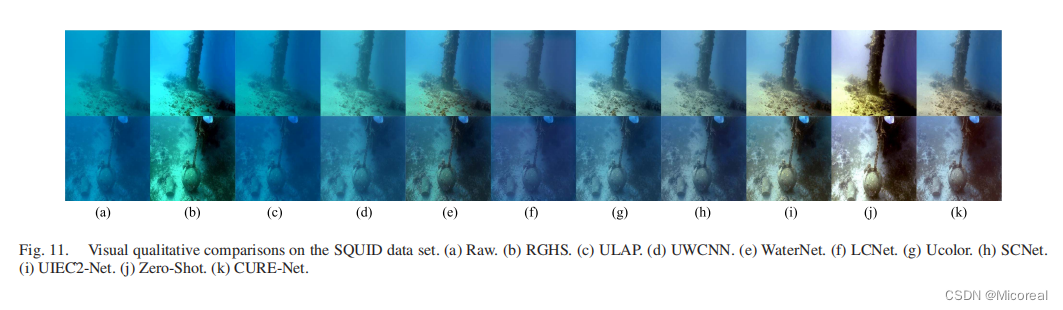

在图11中,我们还展示了从SQUID数据集采样的具有挑战性的水下图像的不同方法的结果。

ULAP、UWCNN、LCNet、Ucolor和SCNet不能很好地处理蓝色图像。

RGHS用不真实的颜色来增强图像。

相比之下,我们的方法能更好的处理水下退化图像的多样性和生成带有自然光的图片。

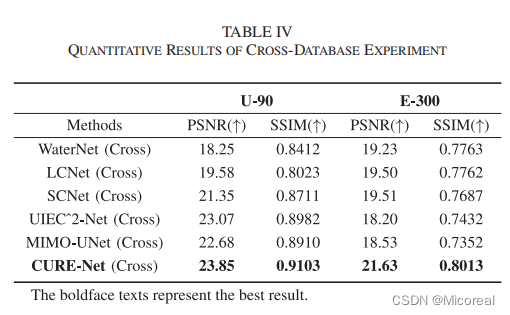

交叉数据库验证 为了进一步验证我们模型的稳健性,我们采用两个交叉数据库进行测试下面的方法:WaterNet,LCNet,SCNet,UIEC2-Net,MIMO-UNet和我们的CURE-Net。

在第一次交叉数据库测试中,我们的方法在EUVP-Training上训练然后在U-90上进行测试

第二次,在UIEB-Training上训练在E-300上进行测试。

表IV展示了这个测试的结果,也有他们的平均的性能。

可以看出,我们的CURE-Net在跨数据集的验证上优于其他的方法。

C Abltion Experiments

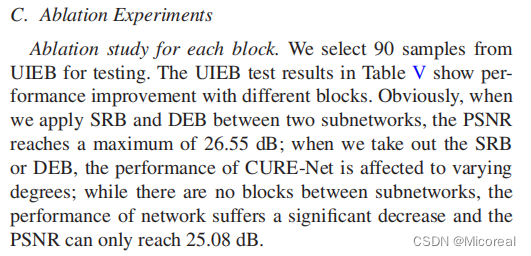

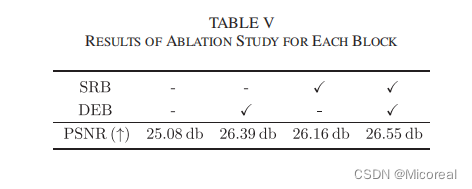

对每个区块进行消融实验,

我们从UIEB当中挑选了90个样本来测试。

表五张展示了不同区块的性能提升。

显然的,我们在两个子网之间使用SRB和DEB的时候,PSNR最大值达到26.55db;

当我们不适用SRB和DEB的时候,CURE-Net的表现就会收到不同程度的影响

在子网之间没有这些模块,整体网络的性能就会收到显著的下降,PSNR只能达到25.08db

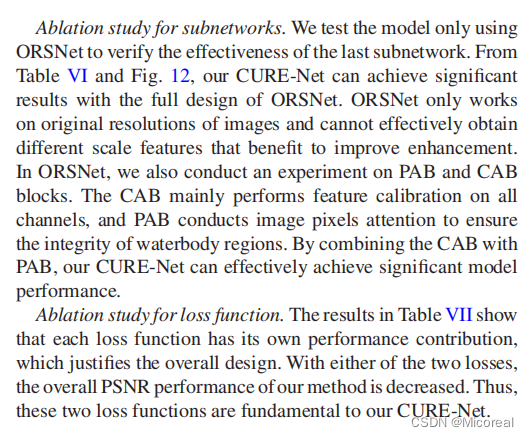

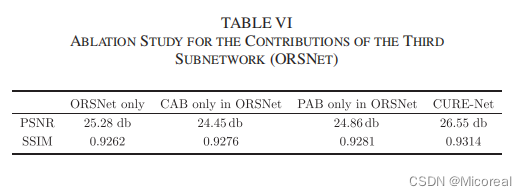

对于子网络进行消融研究。

我们只使用ORSNet去证实最后一层子网络的有效性。

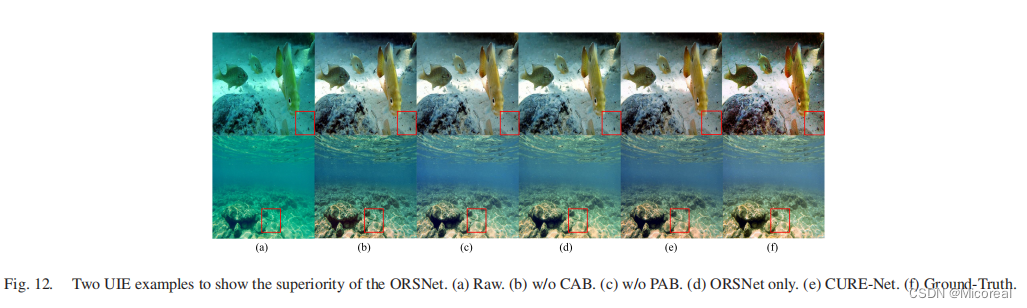

从表6和图12中可以知道,CURE-Net带有完整的ORSNet能有显著的效果。

ORSNet只工作在原始的图像的分辨率下和不能有效的得到不同尺度的有利于促进图像增强的特征。

在ORSNet当中,我们还对PAB和CAB模块进行了额实验。

CAB主要在对所有的通道进行特征的校准,PAB主要关注图片的像素,以确保水体区域的完整性。

通过把CAB和PAB进行融合,我们的CURE-Net能有效的实现模型的性能

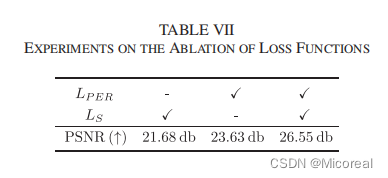

关于损失函数的消融研究

结果在表七当中展示,结果展示了每种损失函数都有他特殊的贡献,这证明了我们全面的设计

没有这两种损失函数的任何一种,PSNR的表现就会全面下降。

因此,这两个损失函数是我们CURE-Net的基础

D Contributions to Underwater Object Detection

解释:

我们还评估了CURE-Net对于水下目标检测的贡献

在这个实验中,我们从UIEB当中挑选了70个图片,所有的图片都有对应的对象

首先我们预训练了基于YOLOv4的对象检测,并在我们挑选的数据集上去运行它

其次,我们使用我们CURE-Net增强后的图像,并再次运行对象检测进行比较。

表8和图13展示了经过CURE-Net处理后,目标检测的准确性和置信度都有显著的提高。

因此,我们的模型有利于人类视觉和机器学习任务。

此外,我们对比我们子网的性能,每一个子网都能很好做贡献于这个任务

这个事实也是验证了我们的级联网络的设计

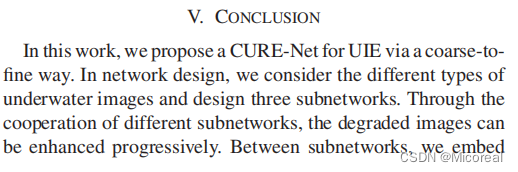

Conclusion

解释:

在这个工作中,我们提出了从粗到细的神经网络CURE-Net。

在这个网络的设计中,我们考虑了不同类型的水下图片和设计了三种子网。

通过这次不同子网的合作,退化的图像可以被有效的增强。

在这个子网当中,我们嵌入了DEB和SRB模块,这些模块能通过多尺度和有监督的信号来提高图像的质量

定性和定量的实验结果展示了这个方法的有效性

此外,通过我们的CURE-Net能提高目标检测的性能。