1.目前使用LLM的方式

目前,我们主要在零样本模式下使用大型语言模型(LLM),通过提供提示(prompt),模型逐词(token)地构建最终的输出内容,其间并未实施任何操作。这一过程可以类比为要求一个人不间断地从文章开头连续键入至结尾,且不许回撤修改,却期待得到高水准的成品。即便面临这样的挑战,LLM 在完成此类任务时仍展现出了卓越的能力!

2.智能体迭代工作流——新的使用LLM的方式

然而,我们具备实现迭代优化的能力。借助智能体工作流,我们可以引导LLM对文档进行多次递进式的创作与完善。比如,它可以遵循以下系列行动:

- 制定初步的文章结构和大纲;

- 智能判断是否有必要进行网络检索以获取更多相关素材;

- 编写文章的初版内容;

- 对初稿进行全面审阅,识别并剔除不合逻辑的观点或无关细节;

- 基于审阅结果修订和完善稿件;

- 以及更多的后续步骤……

这个反复修正的过程对于人类作者创作高质量文本是不可或缺的,而对于人工智能而言,采用这样循环的工作流程通常能够显著提升单一一次性生成文本的质量。

对于人工智能来说,这种迭代工作流会比单次编写产生更好的结果。

3.性能比较

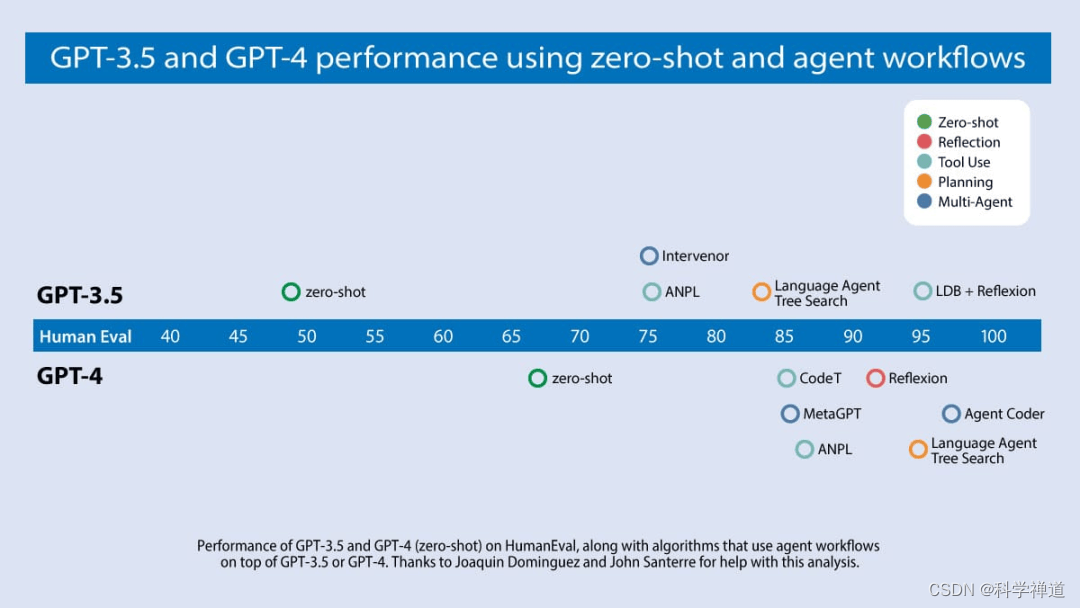

最近, Cognition AI 团队所研发并推出的首个人工智能软件工程师 Devin,在社交媒体平台上引发了热烈反响。吴恩达的团队持续追踪 AI 编程技术的进步动态,并对多个研究组的成果进行了深入剖析,其中特别重视算法在业界广泛采用的 HumanEval 编码基准测试中的性能展现。

吴恩达的研究团队发现:在零样本模式下,GPT-3.5模型的准确率为48.1%;而其后继者GPT-4则表现更好,达到了67.0%的正确率。尽管如此,相较于通过迭代智能体工作流程的应用,单纯从模型本身的性能升级来看,从GPT-3.5过渡到GPT-4带来的提升相对有限。值得注意的是,在应用了智能体迭代工作流时,GPT-3.5或GPT-4展现出了显著的优势,其正确率跃升至高达95.1%的程度。结果对比如下图所示。

4. 构建智能体工作流的设计模式

开源智能体工具和有关智能体的研究论文正在激增,这是一个令人兴奋的时刻。为了更好地帮助大家理解和评价相关工作,吴恩达提出了一个关于智能体构建策略的分类体系。

简明概括起来,此体系涵盖了以下几个核心组成部分:

- 自我审查与反馈:智能体运用自身的大型语言模型能力对已完成的任务进行评估,并据此制定改进策略。

- 工具使用能力:智能体能够利用诸如网络搜索、代码执行等手段辅助自身获取信息、执行动作和处理数据资源。

- 规划与执行:智能体会设计并实施一套包含多个步骤的行动计划,以便达成既定目标,如先构思论文提纲,接着进行线上调研,最后形成文稿草案等环节。

- 多智能体协同作业:不同AI智能体间相互协作,分工合作,通过讨论、交流甚至竞争性思维碰撞来共同寻求优于单个智能体所能产生的解决方案。

吴恩达透露,AI Fund已在多种应用场景中成功应用了这些设计模式,并将在后续讨论中进一步详解这些模式的具体实践与成效。

参考链接:

https://twitter.com/AndrewYNg/status/1770897666702233815

https://www.deeplearning.ai/the-batch/issue-241/