深入探讨基于实例的学习及K-最近邻算法

在机器学习的众多策略中,基于实例的学习方法因其简单性和高效性而备受关注。这种方法的核心理念在于利用已知的数据实例来预测新数据的标签或属性。本文将深入探讨其中的两个重要概念:最近邻算法和K-最近邻算法(KNN),并解析它们在现实世界应用中的重要性和挑战。

1. 基于实例的学习简介

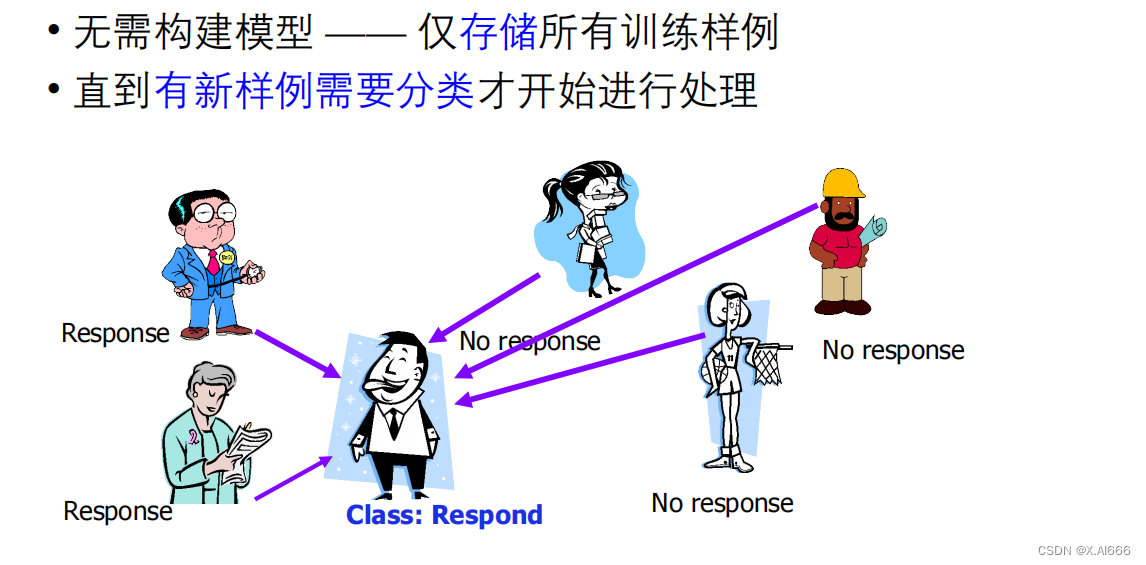

基于实例的学习,或称案例推理,属于机器学习中的一种懒惰学习方法。不同于在训练阶段构建显式模型的积极学习,懒惰学习算法直到接收到预测请求才开始分类过程,通过在训练数据中查找与新实例最相似的案例来进行预测或分类。

特征与优势:

- 灵活性:由于不需要预先建模,它能够灵活适应数据的变化。

- 解释性:基于实例的决策过程通常更易于解释,因为预测是直接基于已知的实例。

- 简易性:算法实现简单,易于理解。

然而,这种方法也存在一定的缺点,如计算成本高、需要大量内存存储实例,以及对噪声和异常值敏感。

2. 最近邻算法

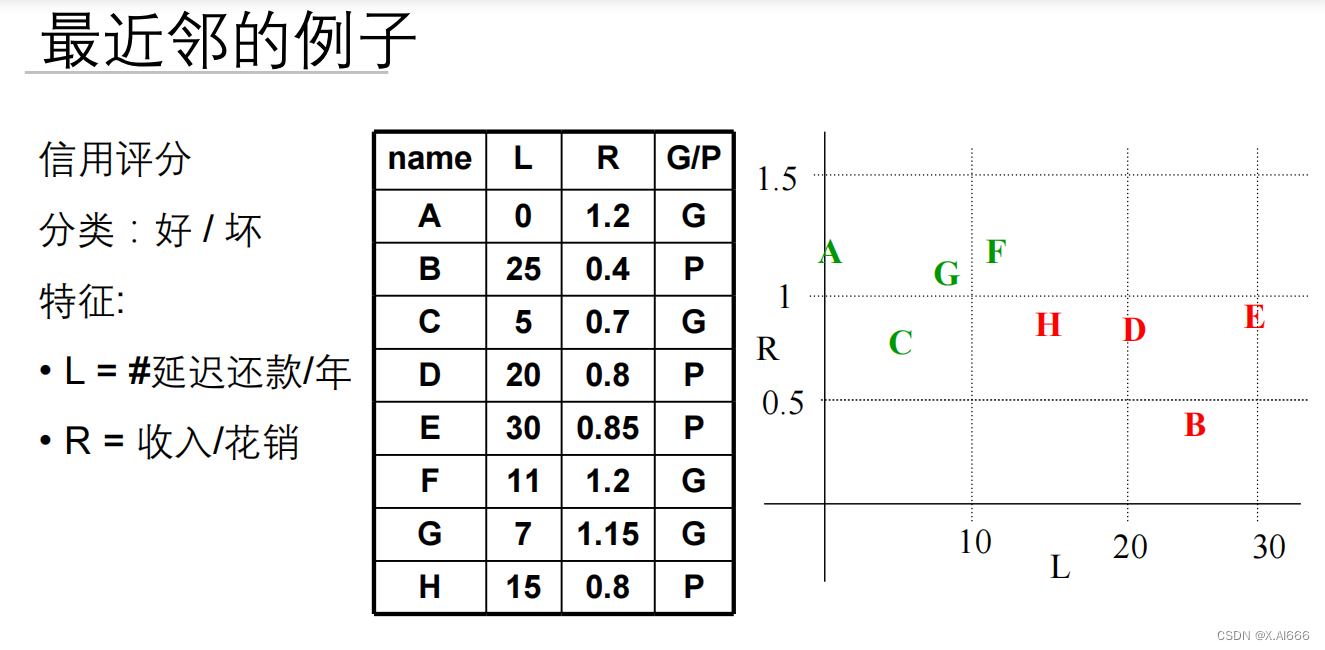

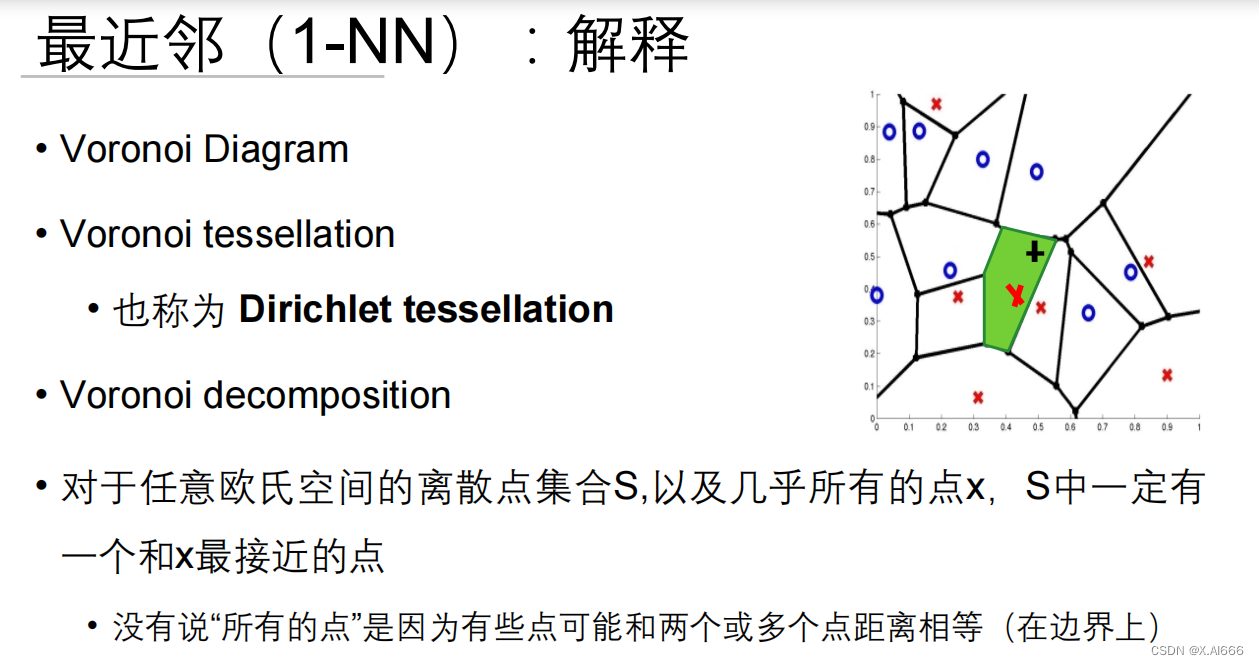

最近邻算法是最简单的基于实例学习方法之一,它的原理是在数据集中找到与新实例距离最近的单个实例,然后直接采用这个最近实例的标签作为预测结果。

工作原理:

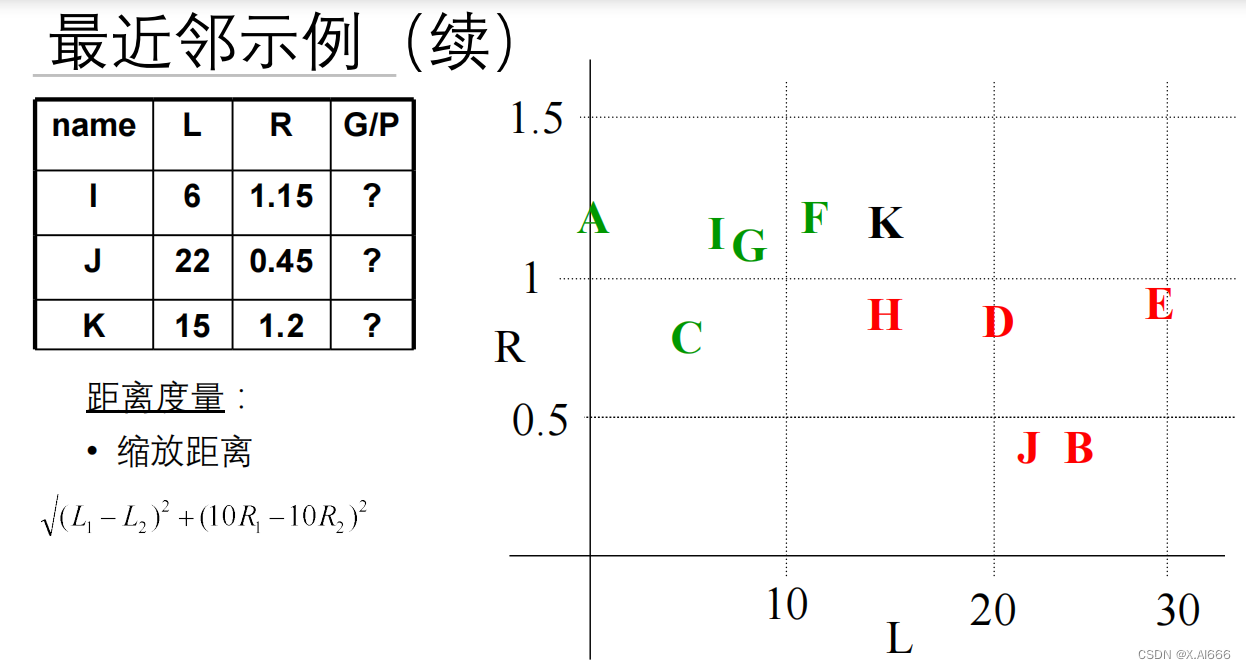

- 选择距离度量:常用的距离度量方法包括欧氏距离、曼哈顿距离和余弦相似度。

- 计算距离:对于每个训练实例,计算其与新实例之间的距离。

- 寻找最近邻:从训练集中选择一个距离最近的实例。

- 分类或回归:采用这个最近邻的输出值作为新实例的预测结果。

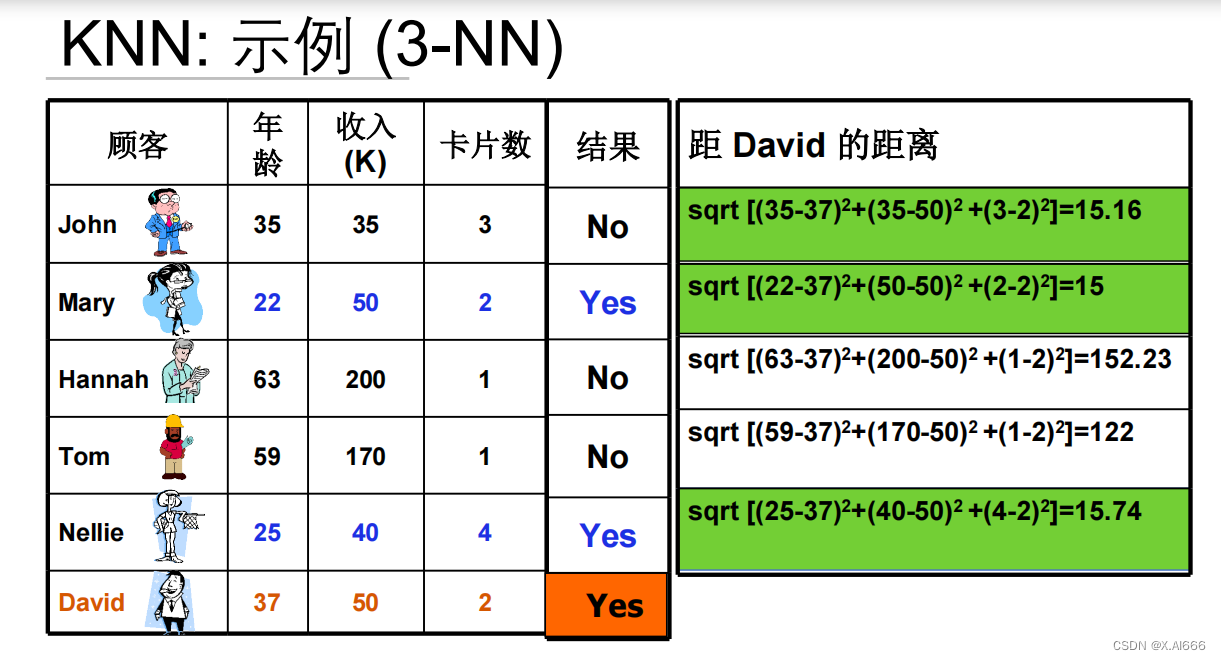

3. K-最近邻算法(KNN)

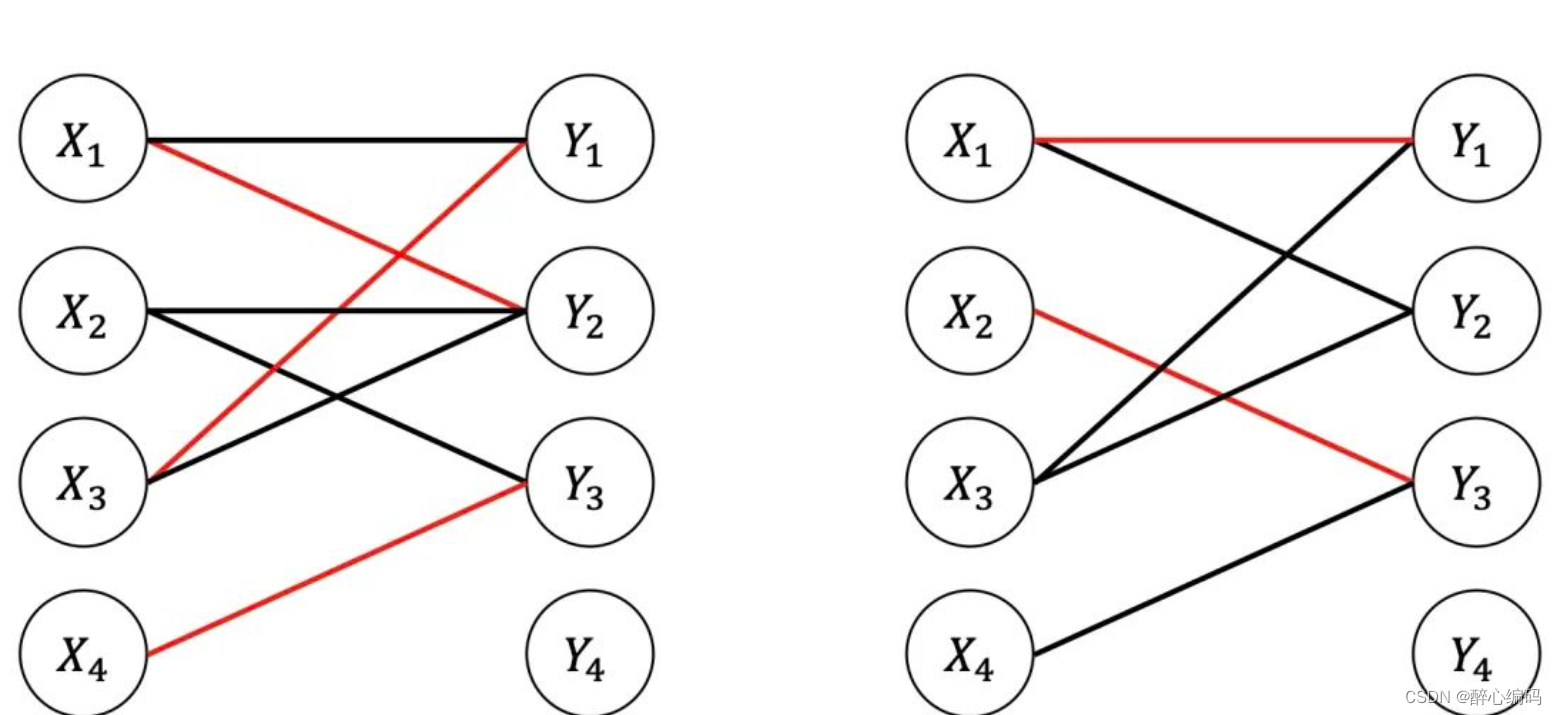

K-最近邻算法是最近邻算法的扩展,它考虑了K个最近的邻居而不仅仅是一个。通过综合多个最近邻的信息,KNN旨在提高预测的准确性和鲁棒性。

核心步骤:

- 确定K值:选择一个正整数K,它表示将参与投票或平均的最近邻的数量。

- 距离度量:计算测试实例与训练集中每个实例之间的距离。

- 选择K个最近邻:基于距离,选出K个最近的训练实例。

- 多数投票或平均:对于分类任务,根据K个最近邻的标签进行多数投票;对于回归任务,计算K个最近邻的输出值的平均。

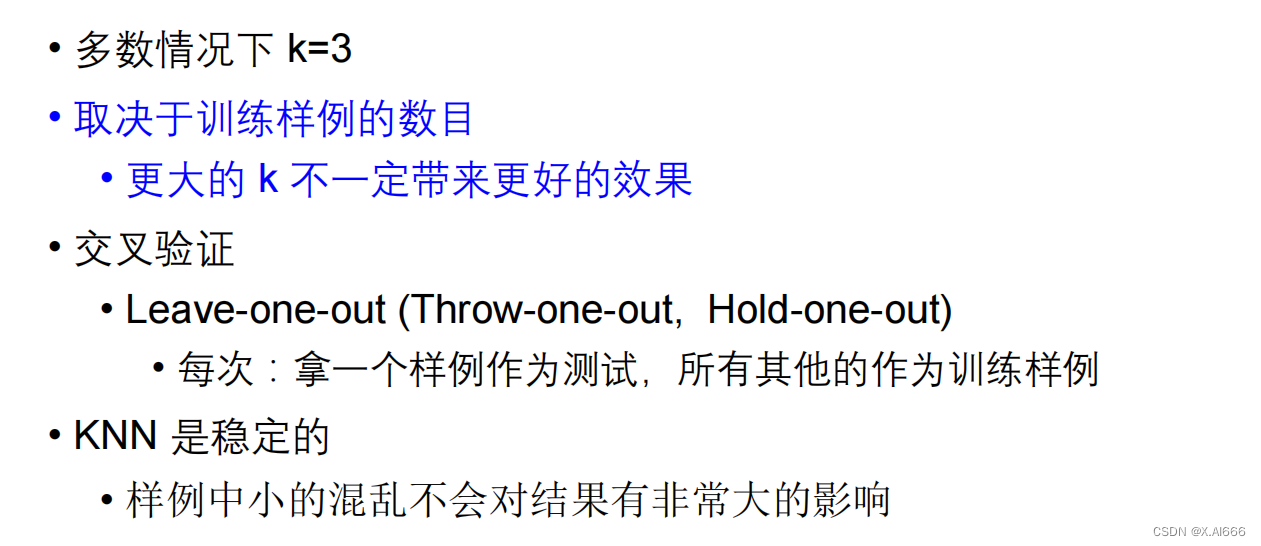

K值的选择:

K值的选择对算法的性能有着重要影响。一个较小的K值意味着模型对训练数据的小波动更敏感,可能会导致过拟合;而一个较大的K值能够减少噪声的影响,但可能会导致模型无法捕捉到数据的细节特征,从而欠拟合。

4. 应用与挑战

KNN算法因其简单和有效性在许多领域中被广泛应用,如推荐系统、图像识别和医疗诊断等。然而,随着数据量的增加,计算距离的成本也随之上升,特别是在高维数据中,距离的计算会变得异常复杂和耗时,这就是所谓的“维度诅咒”。

解决策略:

- 降维技术:通过主成分分析(PCA)等方法减少数据的维度。

- 优化数据结构:使用如KD树或球树等数据结构可以有效地减少需要计算距离的实例数。

- 选择合适的K值:通过交叉验证等方法选择最优的K值。

5. 结语

基于实例的学习及其代表算法KNN在机器学习领域中占据了重要位置。它们以简单直观的方式提供了解决分类和回归问题的有效手段。尽管面临维度诅咒等挑战,通过合理的策略和优化,KNN算法仍然是一个强大且灵活的工具,能够应对各种复杂的数据分析任务。

![[Flutter]环境判断](https://img-blog.csdnimg.cn/direct/b9443b429608478e8fc7829dc0094626.png)