文章立意方向

在开始这篇文章之前,首先介绍下笔者的站位和看问题的角度:笔者是一个有过大厂从业经历的一线人工智能算法工程师,从2011年至今,亲身参与、亲眼看到人工智能的蓬勃发展的历程。手中的工具从基于概率论、导数的机器学习再到今天的带有深度记忆、推理能力的大模型。

所以,基于笔者的从业经历(2011年~至今),那些史前的、创世性的论文(如辛顿-Hiton教授苦苦求索的CNN卷积神经网络),并不在笔者的介绍范围内。

本文笔者仅介绍那些 【应用度高】、【引用量高】、【被互联网大厂直接上线使用】的 极具现实意义和落地价值的paper。主要涵盖的领域是视觉算法(CV)和自然语言处理(NLP)。

牛X论文一览

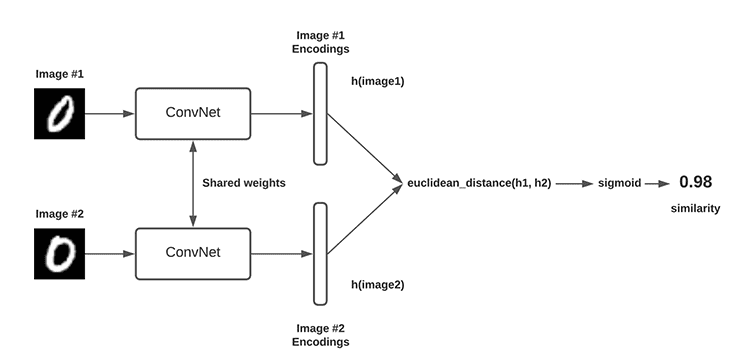

1、《A Convolutional Neural Network for Modelling Sentences》 (2014)

官方描述:这篇论文提出了一个用于句子建模的卷积神经网络(CNN)架构,该模型使用一维卷积来学习句子嵌入的层次特征

老杨描述:为文本分类开启了新篇章(之前我们都是用RNN循环神经网络来做文本分类),这篇文章的出现,让本应该做图片分析的CNN,干起了NLP的活,不仅准确率略有提升,关键的问题是-->CNN做文本分类可以在CPU机器上来训练(当然RNN也可以跑在CPU机器上,只不过完成一轮模型训练,非常耗时!),对于当时部门极度缺少GPU的我们来讲,是一个福音-->既能完成业绩,而且干活效率高(不用深夜定闹钟来看训练进度了)。

直到目前为止,据老杨所知,百度搜索体系、信息流体系,仍然采用这篇论文的技术来快速筛选涉黄/暴/恐/恶心/政治等相关的文章、语句、评论等。

论文意义:传统的认知是,CNN就是做图片分析的,现在可以跨界做NLP的活,为以后新的特征提取器transformer(本来这个特征提取器的定位和RNN一样,是为了做NLP)在Sora上的应用开辟了新篇章!

2、《Attention is All You Need》 (2017) ---谷歌公司

官方描述:这篇论文提出了Transformer模型,它在处理序列数据时不依赖于循环网络结构,而是使用注意力机制,对NLP领域产生了革命性影响。

老杨描述:没错,这就是transformer,是谷歌公司2017年提出的,本意是替代RNN这个特征提取器,当然也确实在NLP任务上表现出来了一定的成绩。当时没有人认为这篇文章能够怎么样,也就慢慢的尘封了---->直到OpenAI的ChatGPT的出现(据说谷歌高层,为此事耿耿于怀)

论文意义:里程碑式的论文,一种全新的特征提取器,一开始只是取代了两架马车中的RNN,但是现在正在慢慢的也要取代CNN。不仅在ChatGPT上应用,而且在Sora上应用。包括国内目前所有的主流语言大模型---文心一言、清华智谱。不过清华智谱死不承认自己是用的transformer,非得叫自己glm,其实就是换汤不换药。

该文章,已经一统NLP领域的江山,马上也要一统CV了。

3、《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》 (2018)---谷歌公司

图片加载中

官方描述:BERT模型通过双向Transformer预训练,显著提高了多种语言理解任务的性能。

老杨描述:在2018年,该论文已经发布,在NLP业界(各大互联网公司),引起了很大的震动,因为用过transformer特征提取器 + bert的神经网络结构,联合训练出来的语言模型。在全部,注意是全部NLP任务上,全部遥-遥-领-先!刷爆了之前所有NLP技术的最好效果--->准确率/召回率

具体任务包含:

- 文本分类(小黄文分类、财经体育娱乐等文章分类,都用)

- 机器翻译

- 序列标注、命名实体、分词等

- 情感分析(恶意、辱骂、开心、沮丧等)

- 意图识别(搜索引擎的核心技术,当你输入搜索内容,第一步要做的就是识别用户的意图)

- 文本摘要(司法、医院经常用到,比如判决书摘要、病例摘要等)

- 。。。。

论文意义:当所有的算法工程师都对中文NLP感到绝望的时候,这篇论文给全国的顶级NLP工程师带来了希望,并且一步步的工程化应用,至今都在百度、腾讯、美团、字节跳动公司的平台发光发热。

4、《Deep Residual Learning for Image Recognition》2015---华人之光(也可称为广州之光)何恺明,该论文获得顶会CVPR Best

图片加载中

官方描述:何恺明的残差网络(ResNet)是人工智能视觉算法领域的一个重大突破。ResNet通过引入残差学习框架来解决深度神经网络训练中的退化问题,使得训练深层网络成为可能。ResNet的影响力非常广泛,它不仅在图像分类任务中取得了显著的性能提升,也推动了其他计算机视觉任务的发展,如目标检测和人脸识别等。

老杨描述:如果说辛顿(Hiton)教授定义了神经网络,那么何恺明就定义了深度学习。在没有何恺明的Resnet之前,如何让神经网络层数变得更多、更深,是解决不了的问题。而浅层神经网络在记忆能力、推理能力的表现实在太差。强行提升网络层数,一直因为梯度消失、梯度爆炸的技术难题,无法变成现实。Resnet的出现,一举改变了现状。

**论文Title**:人类文明以来,人工智能方向被引用次数最多的文章,没有之一!

论文意义:有了Resnet,才有了深度学习。没有Resnet,就什么都没有。没有人脸识别、没有目标检测、没有ChatGPT、没有Sora。

5、《Generative Pre-trained Transformer 3 (GPT-3)》2020---OpenAI

官方描述:这是一个强大的语言生成模型,能够执行各种语言任务。

老杨描述:这就是ChatGPT(gpt3.5)的前身,这个是3.0

老杨恶意的揣测(有内行人交流),讯飞星火、360大模型、紫东太初、出门问问,都是基于这个基础模型来做的自己的大模型(或者是Facebook开源Llama开源大模型)。为啥呢?因为3.0是代码、模型全开源的。因为这些提到的公司,公布成本损耗,电费没有明显增长啊!

论文意义:让所有的行业内的技术从业人员,开始将目光投向生成式人工智能技术。但是大部分都是静静的看着,没有动作,普遍心态是--->你这个gpt3,也就是比bert强一丢丢,先看着再说。没想到,3.5的问世,翻天覆地。

6、《You Only Look Once: Unified, Real-Time Object Detection (YOLO)》2015

图片加载中

官方描述:它能够实时进行目标检测,对实时应用产生了重要影响

老杨描述:目标检测的最终胜利者,从2015年问世,直至今天,都是目标检测领域99%的工程师首选。这个技术有啥优点呢?--->识别的不仅精准,而且耗时更短。题外话:该文章的作者,由于不接受该技术被美国军方用于导弹精确视觉制导,黯然消失在大众视野。

论文意义:没有该技术,也就没有所谓的人体检测、人脸检测、旗帜检测等所有目标识别类的国内蓬勃应用。也就不会有所谓的商汤、旷视、依图等公司,海康威视要砍掉一半市值。

笔者的总结

有些论文已经完成了它的历史使命,有些论文仍在发光发热,有些论文将在未来的某天,决定着真正的类人智能体。

笔者以上列举的文章,不是权威的业界排名,只是一个从业10余年的资深用户的深刻体验。有的是极具落地价值的,比如1、3、5、6. 有的是人工智能领域里程碑意义的(堪比人类登月),比如2、4.

下一篇文章预告

《RNN/CNN/Transformer三个特征提取器的爱恨情仇》

声明:本文所有配图,均来自于GPT4作图。

Edit by Biuke Yang