梗直哥、梗直哥丶的个人空间-梗直哥丶个人主页-哔哩哔哩视频

过去十年,卷积神经网络(CNN)如同科技领域的明星,以其卓越的表现撑起了人工智能的半边天。这种创新的网络模型,不仅在计算机视觉、语音识别等传统领域大放异彩,更为人工智能的快速发展和广泛应用奠定了坚实的基础。

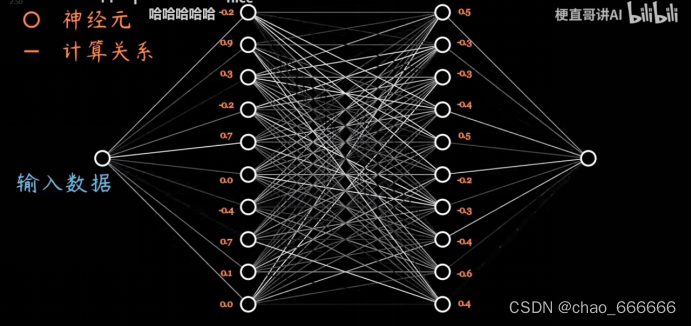

我们先来看看CNN的内部构造。从表面上看,神经网络就像一个黑盒子,我们无法完全看清其内在的运作机制。但不同的神经网络架构,实际上反映了内部构造的不同,就像不同的机器引擎一样,决定了它们的性能表现。

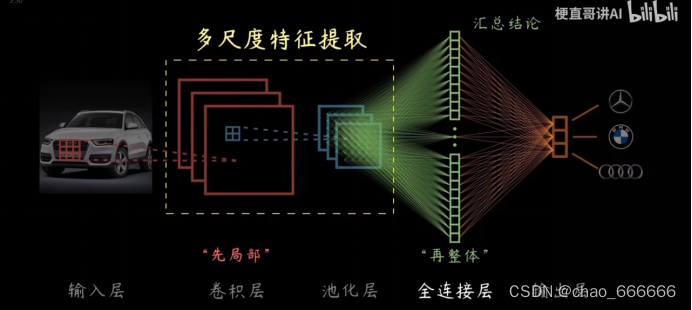

一个典型的CNN由输入层、隐藏层(包括卷积层、池化层)和输出层组成。输入层接收原始数据,如图像像素矩阵;输出层给出最终的预测或分类结果;而隐藏层则负责对输入数据进行特征提取和转换,是CNN的核心所在

1.为什么用卷积层

这个设计灵感来自计算机科学家对数学和生理学的研究。他们发现,生物神经元在接受感知信息时,会对局部区域的刺激产生响应,这种局部感知特性恰好与卷积操作相吻合。

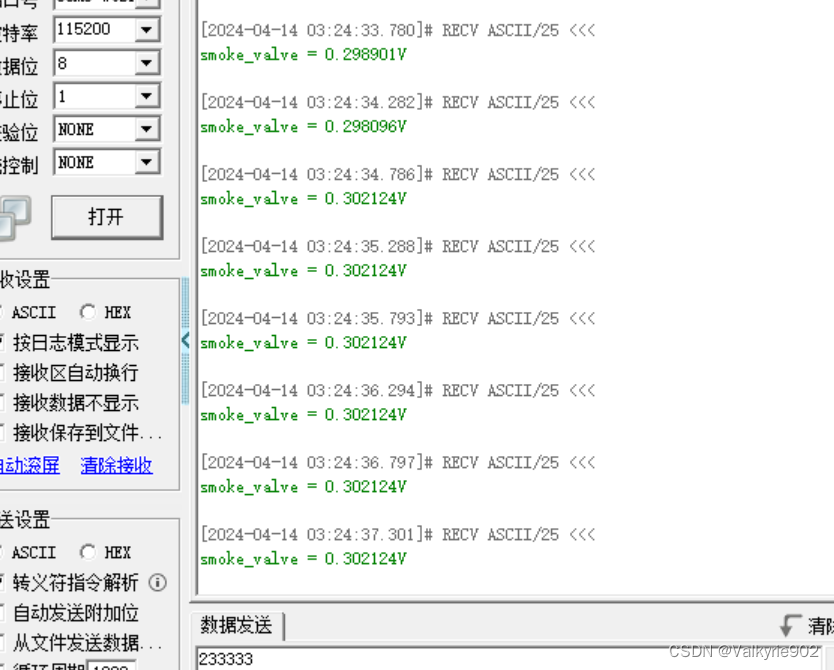

随着算力的发展成熟,卷积操作终于可以在大规模数据上展现其优势。CNN的训练过程,实际上就是不断喂入数据样本,根据损失函数调整神经网络中每个节点的权重,使得模型可以更准确地拟合训练数据。

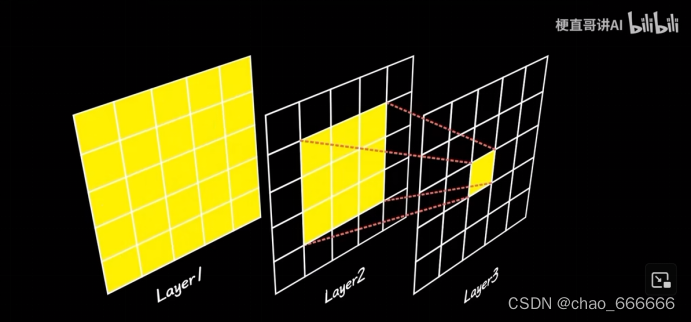

早期的全连接神经网络就像一个"大胖子",每层节点都与上一层所有节点相连,造成了巨大的计算冗余和参数过多的问题,难以高效训练。而卷积层的本质,就是给神经网络"减肥"——它只与输入数据的局部区域相连,极大降低了参数量,简洁高效。

同时,随着网络层数的增加,每个神经元的感受野(即感知范围)也在逐层扩大,使得CNN可以逐步捕捉到输入数据中的更高层次特征。

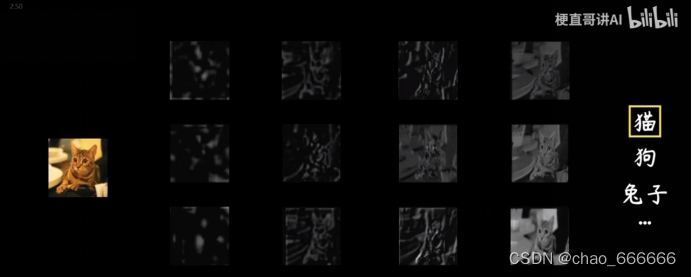

以图像识别为例,浅层可能只能识别边缘和纹理等低级特征,而深层就能识别物体的轮廓、局部和整体形状等高级语义信息。

在卷积神经网络中,卷积层并不是简单地对输入数据进行卷积操作,还需要引入非线性激活函数,以增加网络的表达能力。

激活函数的作用是对卷积的线性输出结果进行非线性变换,使神经网络能够学习到更加复杂的映射关系。常见的激活函数包括Sigmoid函数、Tanh函数等,它们可以将输入压缩到一个较小的范围内。

然而,这些传统激活函数在深层网络中容易出现梯度消失的问题,导致收敛缓慢。为了解决这个问题,线性整流单元(ReLU)应运而生。

ReLU激活函数的计算公式非常简单:f(x)=max(0,x),也就是说,大于0的输入保持不变,小于0的输入则被直接置为0。

2.池化层干什么的

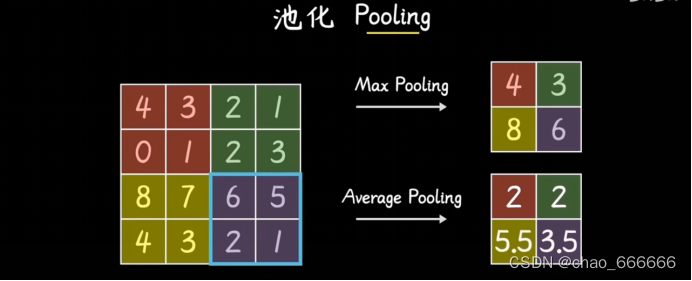

池化层相当于对特征图进行"汇聚"操作,抓住局部区域的主要特征,忽略次要的细节差异。

具体来说,池化层会在特征图上滑动一个小窗口,对窗口内的多个神经元输出进行统计,组合成单个下层神经元的输入。常见的池化方式包括最大池化(Max Pooling)和平均池化(Average Pooling)。

以最大池化为例,它会在滑动窗口内找到最大的神经元激活值作为输出。这种操作可以保留局部区域内最显著的特征响应,达到"抓主要矛盾"的目的。通过这样的汇聚和压缩,池化层可以进一步放大特征的响应强度,增强特征的鲁棒性,使得神经网络对几个像素的细微差异不那么敏感。

除了提取主要特征外,池化层还可以降低特征图的维度,减少网络的参数量和计算复杂度。这不仅能够大幅提高训练和预测的效率,更重要的是,池化层通过降低维度,增加了网络的泛化能力,一定程度上缓解了过拟合问题。

3.全连接层的妙用

在卷积神经网络的结构中,全连接层扮演着整合和决策的关键角色。它会将来自前面所有卷积层和池化层的特征信息进行融合,把这些分布式的特征表示集中到一个全连接的网络层中。

具体来说,全连接层会将相邻的两层全部节点之间进行交叉连接,每个节点与上一层的所有节点相连。通过这种密集的连接方式,全连接层可以将之前层提取的所有局部特征整合起来,建立更加全面的特征表示。

在分类或回归任务中,全连接层的输出就是神经网络的最终结论。之所以称为"全连接",就是要确保模型能够充分利用来自各层的所有特征信息,从而产生更加准确和鲁棒的预测结果。因此,全连接层被视为卷积神经网络的"大脑",起着整合和决策的关键作用。

与之相对,卷积层和池化层则主要负责多尺度特征的提取。卷积层通过滑动卷积核在输入数据上进行局部扫描,能够有效捕捉数据的局部模式和结构信息,例如图像的边缘、纹理、形状等低级特征。而池化层则通过下采样操作,对卷积层提取的局部特征进行归纳和压缩,保留主要特征信息的同时降低了特征维度。这种操作不仅提高了特征的鲁棒性,还增强了网络的泛化能力。

通过多层次的卷积和池化操作,神经网络逐层从低级到高级,从小尺度到大尺度地提取特征。从边缘->纹理->局部形状->整体轮廓,这种层层递进的特征提取过程,使得神经网络最终能够获得对输入数据的多尺度、多层次的表示。

4.总结

卷积神经网络是一种精心设计的神经网络架构,内部结构精妙高效,赋予了它强大的特征提取和表达能力。作为推动人工智能飞速发展的重要力量,CNN无疑是深度学习领域最杰出、最广泛应用的模型之一。

通过对输入数据进行多层次的卷积和池化操作,CNN可以从低级到高级、从小尺度到大尺度地逐步提取特征。卷积层发挥了特征提取的核心作用,池化层起到降维和压缩特征的效果,而全连接层则负责将这些分布式特征整合,得出最终结论,完成分类、预测等任务。

只有深入理解CNN的内在机理和精巧设计,我们才能更好地利用这一强大工具,在图像识别、语音处理等领域施展拳脚,并将CNN的创新思路推而广之,开拓人工智能的新视野,探索更多前沿应用。