教师指点弟子 - 深度神经网络知识蒸馏技术详解

注1:本文系“概念解析”系列之一,致力于简洁清晰地解释、辨析复杂而专业的概念。本次辨析的概念是:知识蒸馏(Knowledge Distillation)。

Knowledge Distillation(知识蒸馏)Review–20篇paper回顾- 知乎

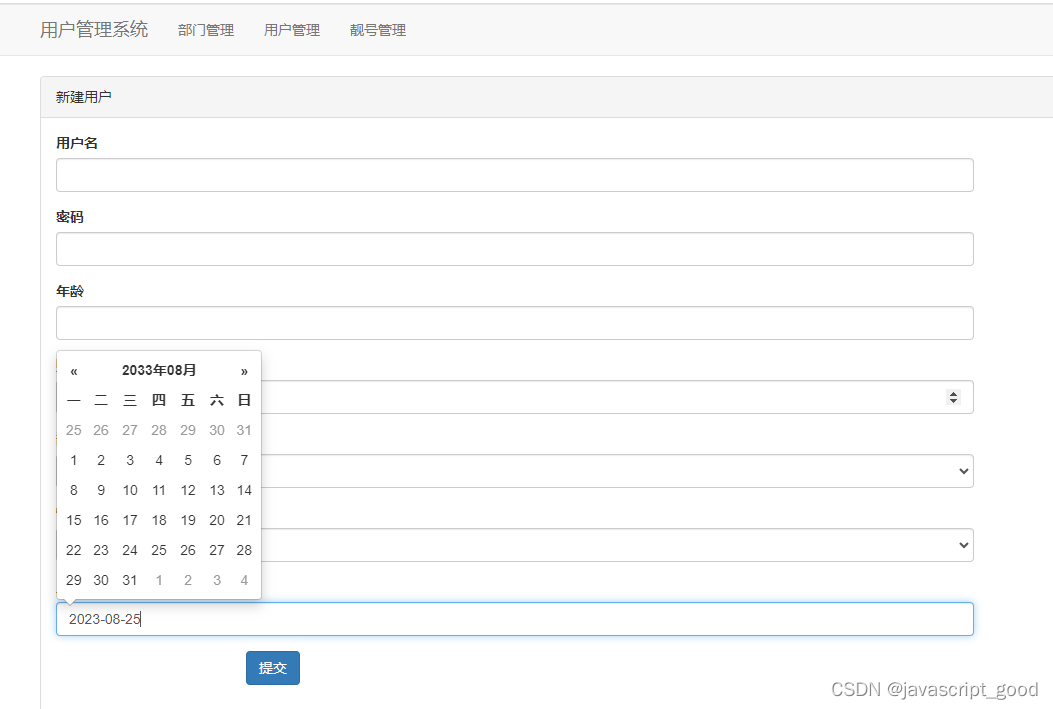

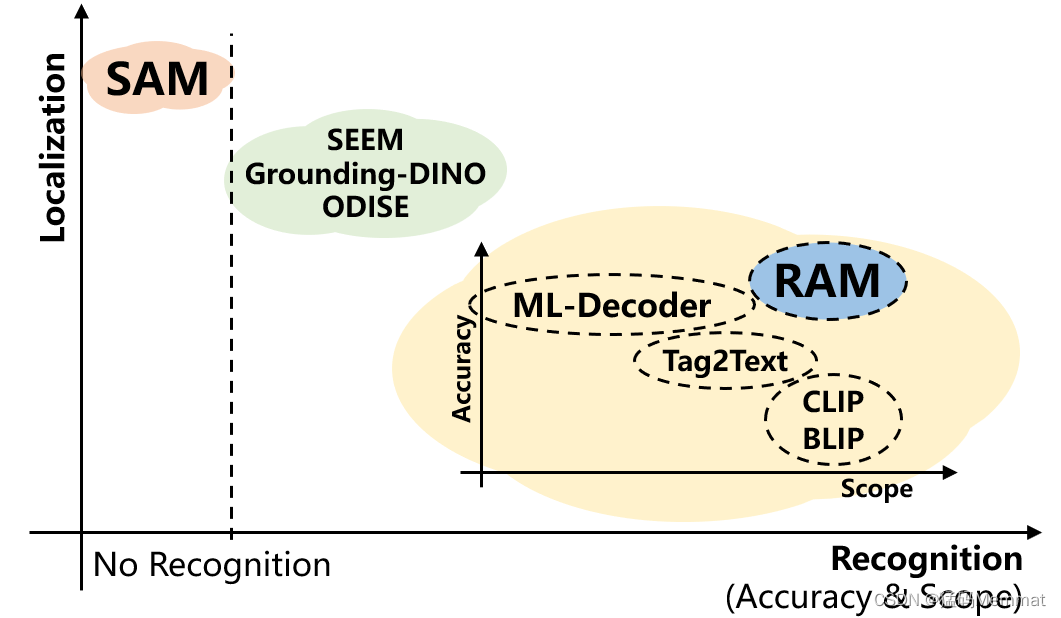

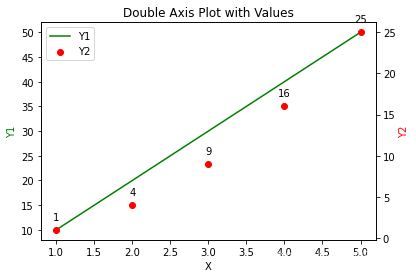

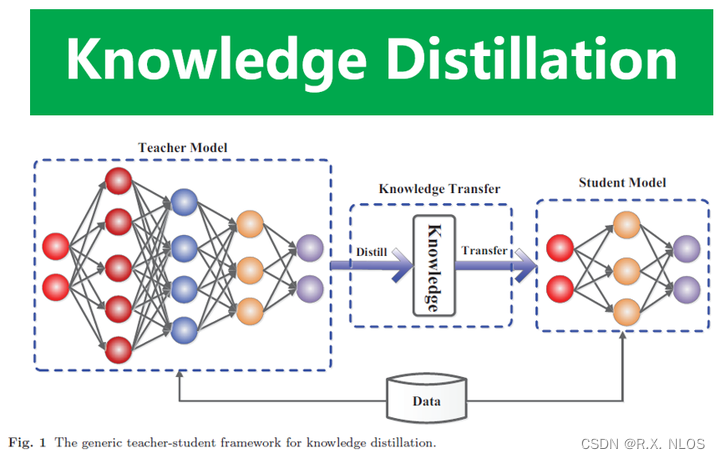

知识蒸馏(Knowledge Distillation, KD)是深度学习中的一项重要技术,它模仿人类教学的过程,通过让一个已经训练好的大师模型(teacher model)来指导一个通常更小更快的学生模型(student model)的训练,使学生模型学会大师模型的知识表示,从而获得比单独训练更好的性能。知识蒸馏技术被广泛应用于模型压缩与加速等任务中。

背景介绍

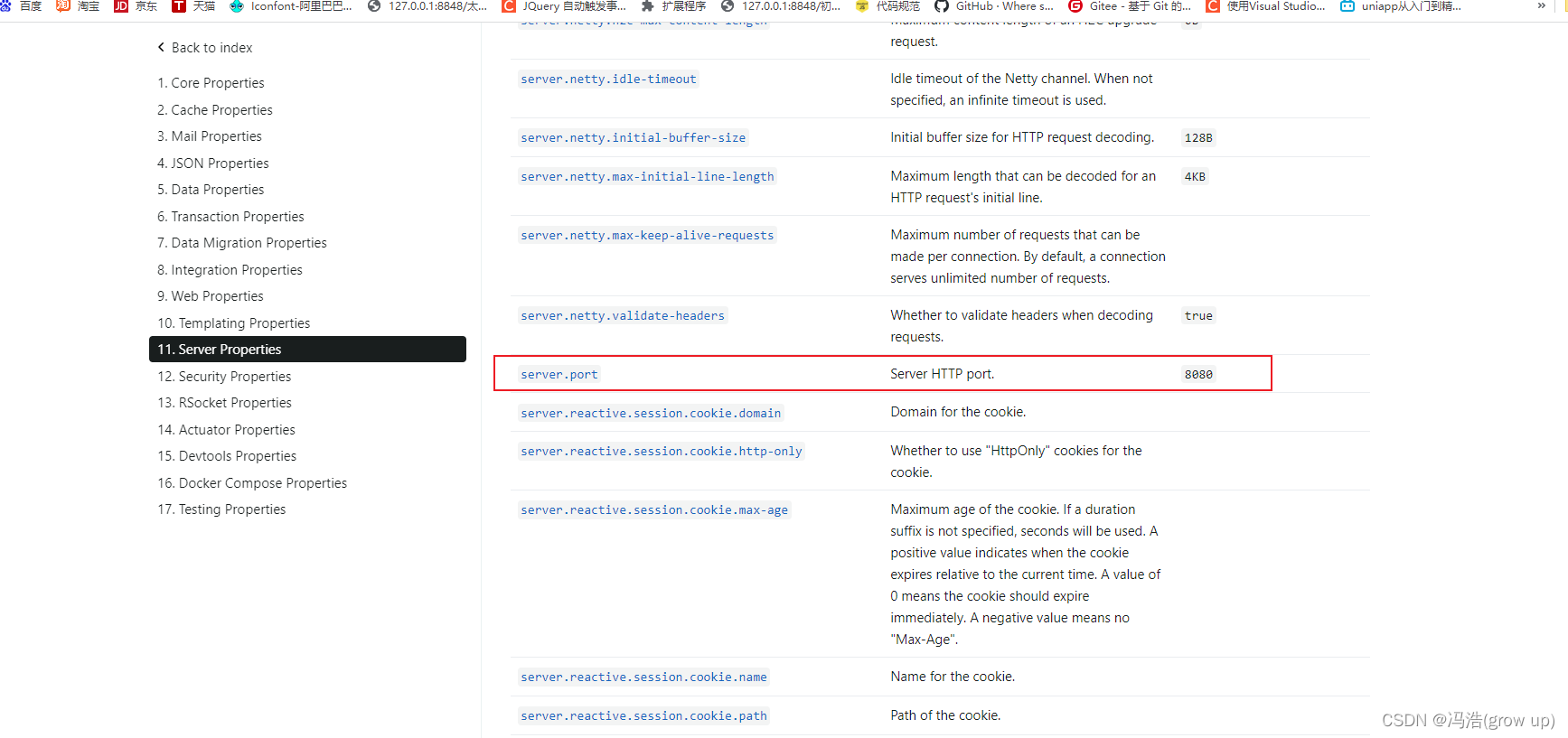

深度神经网络在计算机视觉、自然语言处理等领域取得了巨大成功,但大型的神经网络模型通常需要大量计算资源,不便于在资源受限的环境如移动端部署。知识蒸馏技术应运而生,其目标是训练一个小型的学生模型,使其从一个精确但复杂的教