1、认识Service

程序在容器中、容器在Pod中,可以通过pod的ip来访问应用程序,但是podIP会随着创建销毁而改变。由此,Service出现:

Service会对提供同一个服务的多个pod进行聚合,并且提供一个统一的入口地址。通过访问Service的入口地址就能访问到后面的pod服务。

在整个Service的生命周期中,ServiceIP是不会变化的。

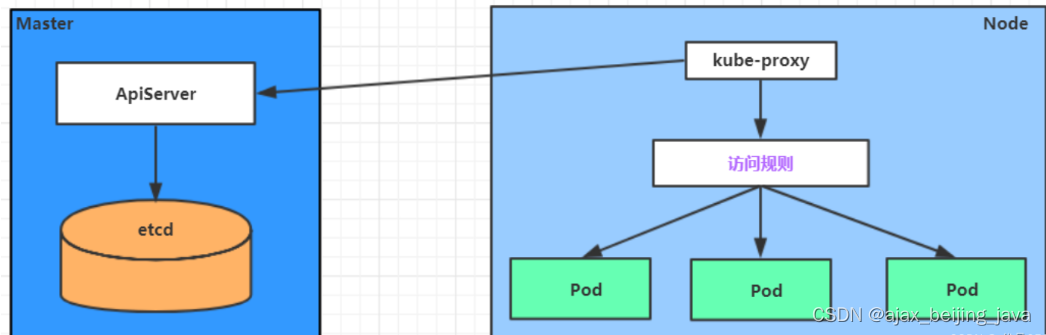

Service是一个概念,真正起作用的是kube-proxy服务进程:

每个Node节点上都运行着一个kube-proxy服务进程。当创建Service的时候会通过api-server向etcd写入创建的service的信息,而kube-proxy会基于监听的机制发现这种Service的变动,然后它会将最新的Service信息转换成对应的访问规则。

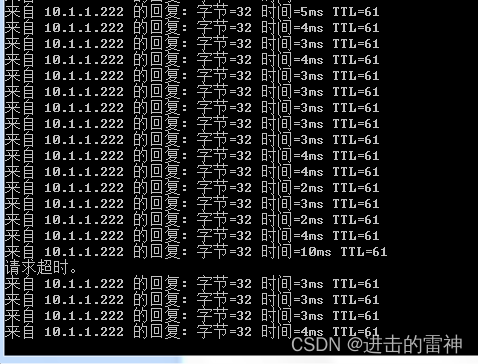

[root@node1 ~] ipvsadm -Ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.97.97.97:80 rr

-> 10.244.1.39:80 Masq 1 0 0

-> 10.244.1.40:80 Masq 1 0 0

-> 10.244.2.33:80 Masq 1 0 0

- 10.97.97.97:80 是service提供的访问入口

- 当访问这个入口的时候,可以发现后面有三个pod的服务在等待调用

- kube-proxy会基于rr(轮询)的策略,将请求分发到其中一个pod上去

- 这个规则信息会同时在集群内的所有节点上都生成,所以在任何一个节点上,都可以访问

2、kube-proxy的三种工作模式

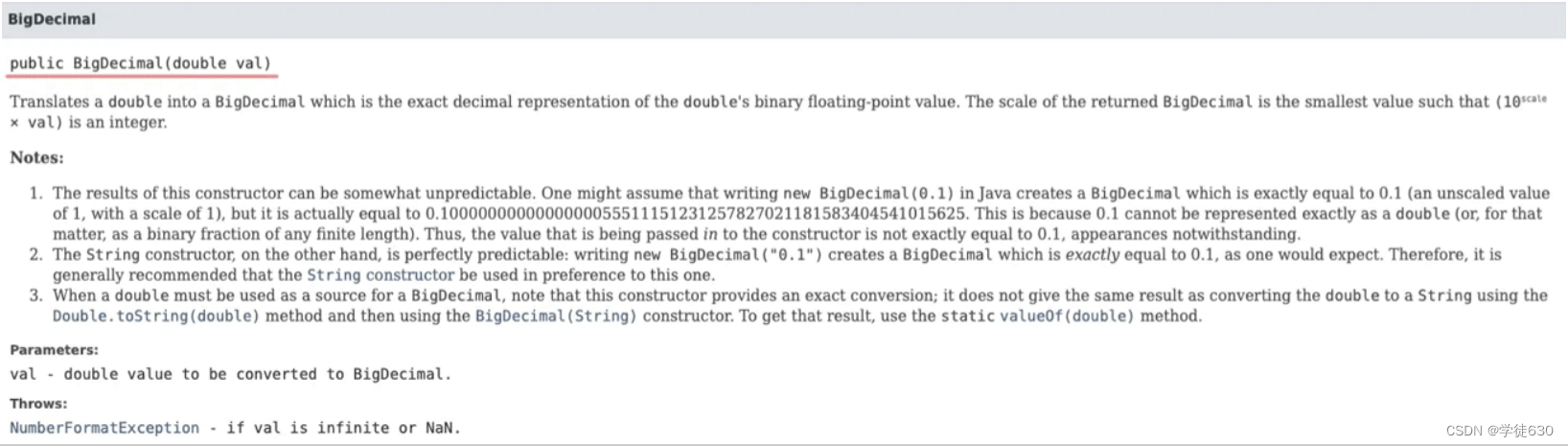

userspace 模式

userspace模式下,kube-proxy会为每一个Service创建一个监听端口,发向Cluster IP的请求被Iptables规则重定向到kube-proxy监听的端口上,kube-proxy根据LB算法选择一个提供服务的Pod并和其建立链接,以将请求转发到Pod上。 该模式下,kube-proxy充当了一个四层负责均衡器的角色。由于kube-proxy运行在userspace中,在进行转发处理时会增加内核和用户空间之间的数据拷贝,虽然比较稳定,但是效率比较低。

iptables 模式

iptables模式下,kube-proxy为service后端的每个Pod创建对应的iptables规则,直接将发向Cluster IP的请求重定向到一个Pod IP。 该模式下kube-proxy不承担四层负责均衡器的角色,只负责创建iptables规则。该模式的优点是较userspace模式效率更高,但不能提供灵活的LB策略,当后端Pod不可用时也无法进行重试(转发到了podA,podA不可用也不会去试其他pod)

ipvs 模式

ipvs模式和iptables类似,kube-proxy监控Pod的变化并创建相应的ipvs规则。ipvs相对iptables转发效率更高。除此以外,ipvs支持更多的LB算法。

此模式必须安装ipvs内核模块,否则会降级为iptables

# 开启ipvs

[root@k8s-master01 ~] kubectl edit cm kube-proxy -n kube-system

# 修改mode: "ipvs"

按标签删除kube-proxy的pod:

# 按标签删除kube-proxy的pod,使刚改的配置生效

[root@k8s-master01 ~] kubectl delete pod -l k8s-app=kube-proxy -n kube-system

[root@node1 ~] ipvsadm -Ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.97.97.97:80 rr

-> 10.244.1.39:80 Masq 1 0 0

-> 10.244.1.40:80 Masq 1 0 0

-> 10.244.2.33:80 Masq 1 0 0

3、Service的类型

Service的资源清单文件:

kind: Service # 资源类型

apiVersion: v1 # 资源版本

metadata: # 元数据

name: service # 资源名称

namespace: dev # 命名空间

spec: # 描述

selector: # 标签选择器,用于确定当前service代理哪些pod

app: nginx

type: # Service类型,指定service的访问方式

clusterIP: # 虚拟服务的ip地址

sessionAffinity: # session亲和性,即将客户端的同一个IP的访问转发到同一个podshang .支持ClientIP、None两个选项

ports: # 端口信息

- protocol: TCP

port: 3017 # service端口

targetPort: 5003 # pod端口

nodePort: 31122 # 主机端口

关于type字段,service有四种类型:

ClusterIP:默认值,它是Kubernetes系统自动分配的虚拟IP,只能在集群内部访问(除了集群里的主从节点机器,其他机器即使网络和集群机器相通也不能访问)

NodePort:将Service通过集群某节点Node上指定的端口暴露给外部,如此,集群外部的机器就可以访问服务

LoadBalancer:使用外接负载均衡器完成到服务的负载分发,注意此模式需要外部云环境支持

ExternalName: 把集群外部的服务引入集群内部,直接使用

二、Service的使用

1、实验数据准备

准备实验数据,结构如下,通过改变Service的类型查看效果:

利用Deployment创建出3个pod,pod设置app=nginx-pod的标签:

# deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: pc-deployment

namespace: dev

spec:

replicas: 3

selector:

matchLabels:

app: nginx-pod

template:

metadata:

labels:

app: nginx-pod

spec:

containers:

- name: nginx

image: nginx:1.17.1

ports:

- containerPort: 80

[root@k8s-master01 ~] kubectl create -f deployment.yaml

deployment.apps/pc-deployment created

查看pod详情,加 -o wide和 --show-labels

[root@k8s-master01 ~] kubectl get pods -n dev -o wide --show-labels

NAME READY STATUS IP NODE LABELS

pc-deployment-66cb59b984-8p84h 1/1 Running 10.244.1.39 node1 app=nginx-pod

pc-deployment-66cb59b984-vx8vx 1/1 Running 10.244.2.33 node2 app=nginx-pod

pc-deployment-66cb59b984-wnncx 1/1 Running 10.244.1.40 node1 app=nginx-pod

此时,通过podIP和容器暴露的端口就可以访问:

curl 10.244.1.39: 80

# 但现在都返回nginx的主页

为了方便直观看到请求被转发到哪个pod,修改三个pod的nginx的index.html页面:

[root@k8s-master01 ~] kubectl exec -it pc-deployment-66cb59b984-8p84h -n dev /bin/sh

: echo "10.244.1.39" > /usr/share/nginx/html/index.html

#修改完毕之后,访问测试

[root@k8s-master01 ~] curl 10.244.1.39:80

10.244.1.39

[root@k8s-master01 ~] curl 10.244.2.33:80

10.244.2.33

[root@k8s-master01 ~] curl 10.244.1.40:80

10.244.1.40

2、Service类型为ClusterIP

创建service-clusterip.yaml文件:

apiVersion: v1

kind: Service

metadata:

name: service-clusterip

namespace: dev

spec:

selector:

app: nginx-pod

clusterIP: 10.97.97.97 # service的ip地址,如果不写,默认会生成一个

type: ClusterIP

ports:

- port: 80 # Service端口,自己指定

targetPort: 80 # pod端口,注意和上面要选择的pod保持一致

创建和查看service:

# 创建service

[root@k8s-master01 ~] kubectl create -f service-clusterip.yaml

service/service-clusterip created

# 查看service

[root@k8s-master01 ~] kubectl get svc -n dev -o wide

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR

service-clusterip ClusterIP 10.97.97.97 <none> 80/TCP 13s app=nginx-po

查看service的详细信息,在这里有一个Endpoints列表,里面就是当前service可以负载到的服务入口:

[root@k8s-master01 ~] kubectl describe svc service-clusterip -n dev

Name: service-clusterip

Namespace: dev

Labels: <none>

Annotations: <none>

Selector: app=nginx-pod

Type: ClusterIP

IP: 10.97.97.97

Port: <unset> 80/TCP

TargetPort: 80/TCP

Endpoints: 10.244.1.39:80,10.244.1.40:80,10.244.2.33:80

Session Affinity: None

Events: <none>

# 查看ipvs的映射规则

[root@k8s-master01 ~] ipvsadm -Ln

TCP 10.97.97.97:80 rr

-> 10.244.1.39:80 Masq 1 0 0

-> 10.244.1.40:80 Masq 1 0 0

-> 10.244.2.33:80 Masq 1 0 0

# 访问10.97.97.97:80观察效果

[root@k8s-master01 ~] curl 10.97.97.97:80

10.244.2.33

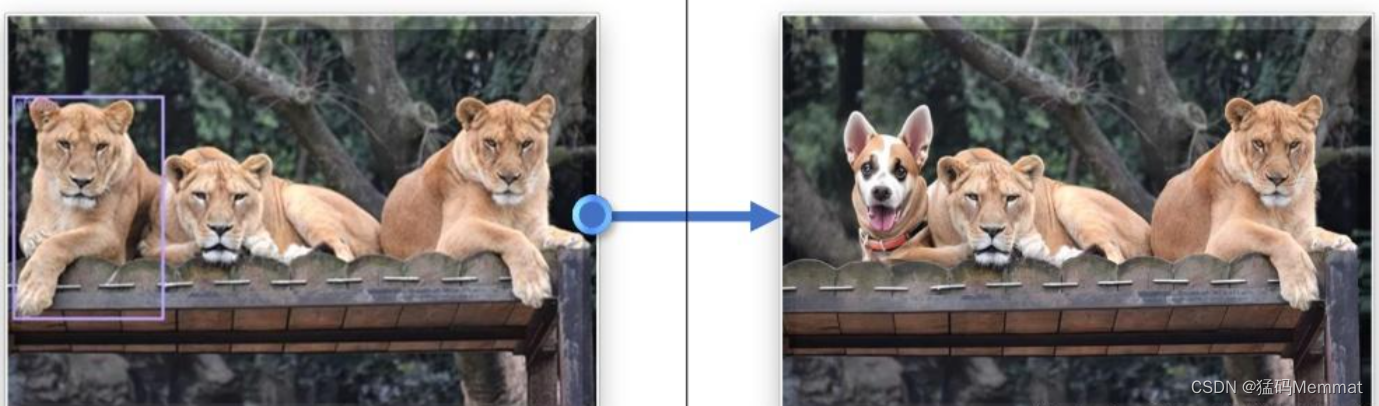

下面是一个创建LoadBalancer类型的Service。创建完成后,可以通过ELB的IP:Port访问到后台Pod。

apiVersion: v1 kind: Service metadata: annotations: kubernetes.io/elb.id: 3c7caa5a-a641-4bff-801a-feace27424b6labels: app: nginx name: nginx spec: loadBalancerIP: 10.78.42.242 # ELB实例的IP地址ports: - name: service0 port: 80protocol: TCP targetPort: 80nodePort: 30120selector: app: nginx type: LoadBalancer # 类型为LoadBalancer

上面metadata.annotations里的参数配置是CCE的LoadBalancer类型Service需要配置的参数,表示这个Service绑定哪个ELB实例。CCE还支持创建LoadBalancer类型Service时新建ELB实例,详细的内容请参见负载均衡(LoadBalancer)。