在现代信息时代,数据是企业决策和发展的关键。然而,许多有用的数据分散在网络上,且以各种格式和结构存在,因此,利用爬虫技术来采集数据成为了一项重要任务。本文将介绍如何使用 Python 编写一个简单的网络爬虫,来解决数据采集难题。

首先,我们需要安装 Python 的爬虫框架 BeautifulSoup 和 requests。你可以通过以下命令来安装:

pip install beautifulsoup4

pip install requests

接下来,我们将以一个简单的示例来说明如何使用爬虫技术采集网页上的数据。假设我们想要从一个网站上获取新闻标题和链接,我们可以编写如下的 Python 程序:

import requests

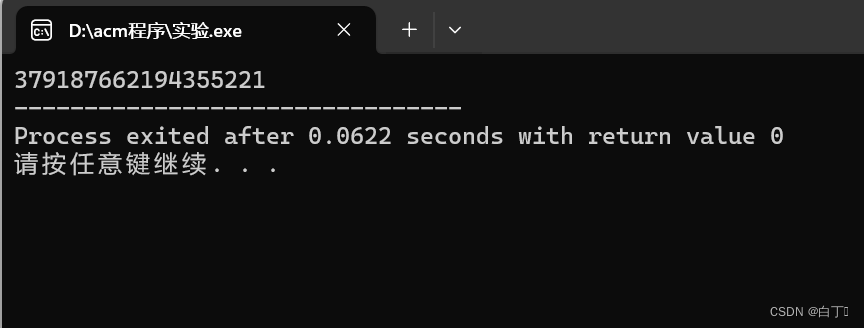

from bs4 import BeautifulSoupdef scrape_news(url):# 发送 HTTP 请求response = requests.get(url)# 解析 HTML 内容soup = BeautifulSoup(response.text, 'html.parser')# 查找新闻标题和链接news_list = soup.find_all('a', class_='news-title')for news in news_list:title = news.textlink = news['href']print("标题:", title)print("链接:", link)print("-------------------------")# 要爬取的网页链接

url = "https://example.com/news"# 调用函数进行数据采集

scrape_news(url)

在这个示例中,我们首先使用 requests 库发送了一个 HTTP 请求,然后使用 BeautifulSoup 对返回的 HTML 内容进行解析。接着,我们通过查找特定的 HTML 元素来获取新闻标题和链接,并将其打印出来。

当然,实际的网页结构可能会更加复杂,你可能需要进一步处理数据以适应你的需求。此外,需要注意的是,爬取网站数据时需要遵守网站的使用条款和条件,以及遵守相关法律法规,避免造成不必要的麻烦。

通过以上示例,我们可以看到,利用 Python 编写简单的网络爬虫程序并不难,但在实际应用中,需要根据具体情况进行更加灵活和复杂的处理。