集群设置免密登录

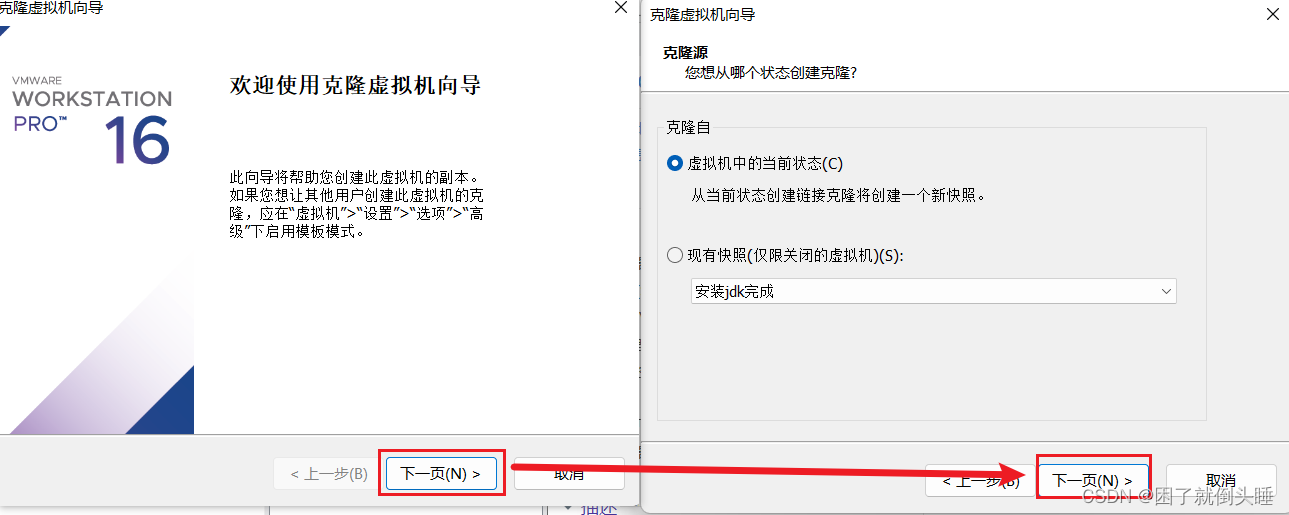

克隆node1虚拟机的前置条件:node1虚拟机存在且处于关闭状态

1.克隆出node2虚拟机

1.node1虚拟机: 右键 -> "管理" -> "克隆"

2.图形化弹窗中: "下一页"->"下一页"->选择"创建完整克隆"再"下一页"->填写"node3和对应位置"再点击"完成"

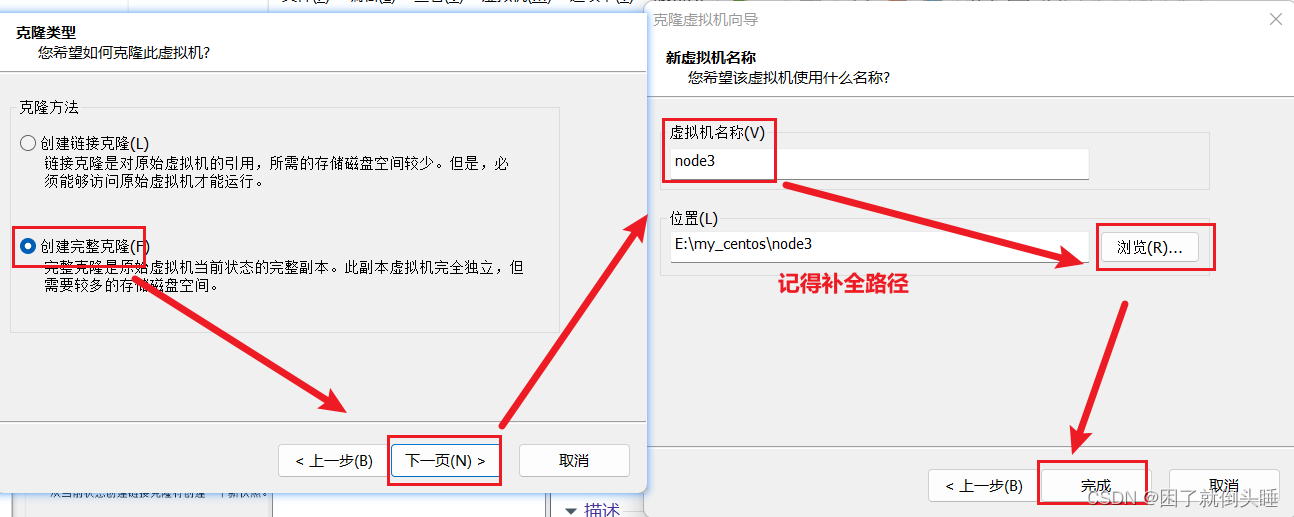

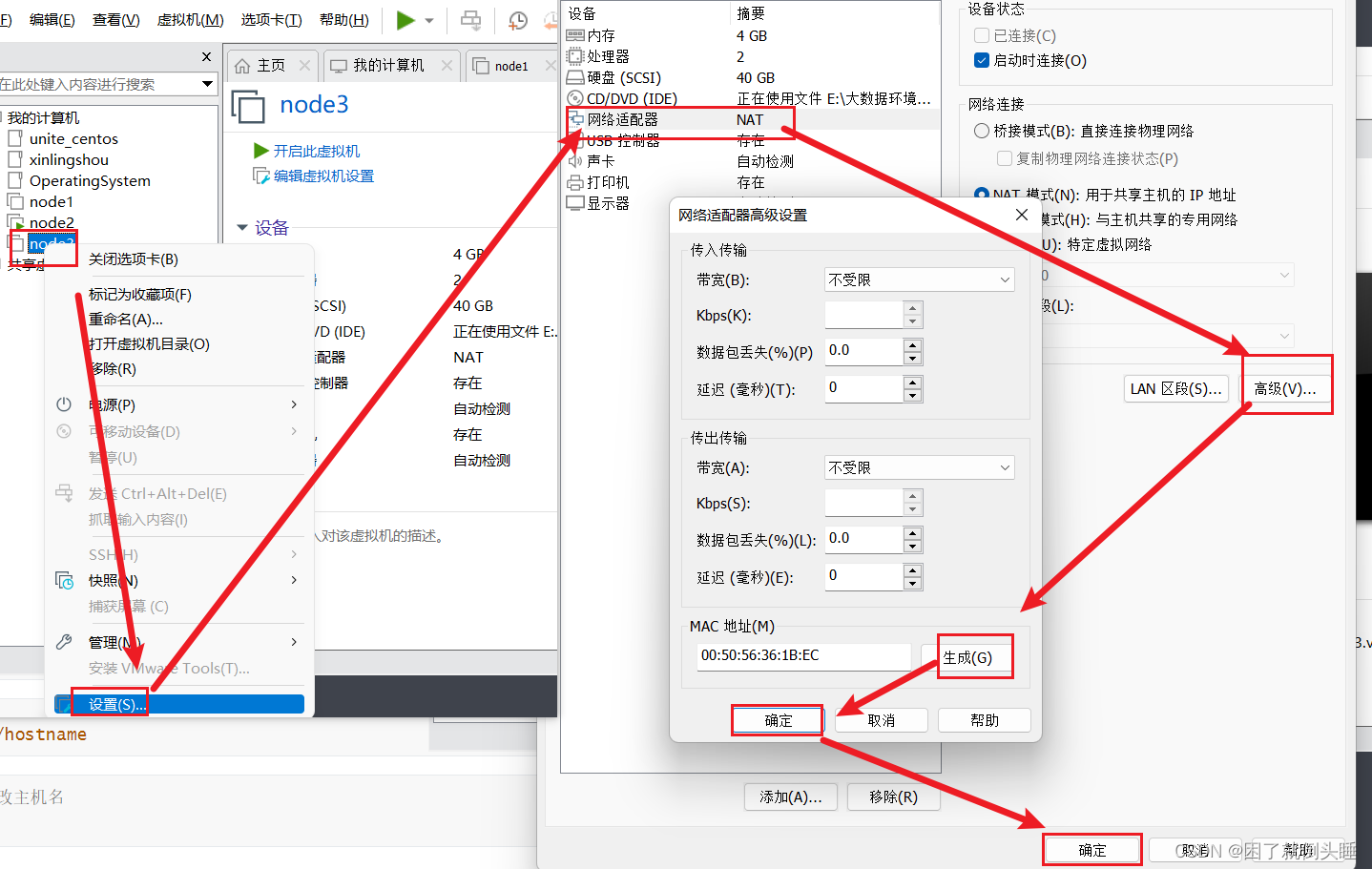

3.node3虚拟机: 右键 -> "设置" -> "NAT模式" -> "高级" -> "生成"Mac地址再'确定' -> 最后点击"确定"

node3基础配置

-

修改ip地址

[root@node1 /]# vim /etc/sysconfig/network-scripts/ifcfg-ens33

# 注意此操作是在node3中修改ip地址 IPADDR="192.168.88.103"

-

修改主机名

[root@node1 ~]# vim /etc/hostname

# 注意此操作是在node3中修改主机名 node3

-

重启虚拟机

[root@node1 ~]# reboot

-

查看配置是否生效

[root@node3 ~]# ifconfig

3.CRT操作所有会话

SecureCRT软件: "查看 "- > 选择"交互窗口" -> 右键选择"发送交互到所有会话"

4.设置免密登录

-

三台虚拟机都生成公钥和私钥

输入命令(注意需要三次回车操作): ssh-keygen

三台虚拟机都执行完命令后,在 /root/.ssh 中会自动生成两个文件: id_rsa 和 id_rsa.pub

-

分别拷贝公钥给其他虚拟机

输入命令(注意需要输入yes和密码): ssh-copy-id node1 输入命令(注意需要输入yes和密码): ssh-copy-id node2 输入命令(注意需要输入yes和密码): ssh-copy-id node3

-

测试免密登录

输入命令(注意此时会直接登录成功): ssh node1 输入命令(注意此时会直接登录成功): ssh node2 输入命令(注意此时会直接登录成功): ssh node3

安装hadoop软件

1.上传软件

使用CRT等客户端远程上传 hadoop-3.3.0-Centos7-64-with-snappy.tar.gz文件到/export/software目录下

2.解压软件

[root@node1 ~]# cd /export/software/ [root@node1 software]# tar -zxvf hadoop-3.3.0-Centos7-64-with-snappy.tar.gz -C /export/server/

3.添加环境变量

[root@node1 software]# vim /etc/profile

# 把如下内容复制到profile文件的最后,注意:记得保存并退出wq # 小技巧 : 按G + o快速到文件末尾 export HADOOP_HOME=/export/server/hadoop-3.3.0 export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

-

修改完后重启生效

[root@node1 server]# source /etc/profile

4.1修改配置文件[自动方式]

上传文件

使用CRT等客户端远程上传 配置好的文件压缩包

hadoop-config.tar文件到/export/software目录下

解压文件

[root@node1 ~]# cd /export/software/ [root@node1 software]# tar -xvf hadoop-config.tar -C /export/server/

覆盖原有文件

[root@node1 software]# mv -f /export/server/hadoop-config/* /export/server/hadoop-3.3.0/etc/hadoop/ [root@node1 software]# rm -rf /export/server/hadoop-config*

4.2配置文件详解[手动方式]

需要进入/export/server/hadoop-3.3.0/etc/hadoop目录下修改如下配置文件

-

hadoop-env.sh : 文件中设置的是Hadoop运行时需要的环境变量

-

core-site.xml : hadoop的核心配置文件,如果在core-site.xml里没有配置的属性,自动会获取core-default.xml 里的相同属性的值

-

hdfs-site.xml : HDFS的核心配置文件,如果在hdfs-site.xml里没有配置的属性,会自动会获取hdfs-default.xml里的相同属性的值

-

mapred-site.xml : MapReduce的核心配置文件,如果在mapred-site.xml里没有配置的属性,会自动会获取mapred-default.xml里的相同属性的值

-

yarn-site.xml : YARN的核心配置文件,如果在yarn-site.xml里没有配置的属性,会自动会获取yarn-default.xml里的相同属性的值

-

workers : 文件中记录集群的主机名。主要配合一键启动脚本如start-dfs.sh、stop-yarn.sh用来进行集群启动

①hadoop-env.sh文件

[root@node1 hadoop]# vim hadoop-env.sh

# 在55行添加JAVA_HOME,因为Hadoop把当前的执行环境当成远程服务器,所以需要重新配置下 export JAVA_HOME=/export/server/jdk1.8.0_65 # 在440行文件末尾添加以下内容 export HDFS_NAMENODE_USER=root export HDFS_DATANODE_USER=root export HDFS_SECONDARYNAMENODE_USER=root export YARN_RESOURCEMANAGER_USER=root export YARN_NODEMANAGER_USER=root

② core-site.xml文件

[root@node1 hadoop]# vim core-site.xml

<!-- 在文件的<configuration></configuration>的标签中添加以下内容: --> <!-- 设置默认使用的文件系统 Hadoop支持file、HDFS、GFS、ali|Amazon云等文件系统 --> <property><name>fs.defaultFS</name><value>hdfs://node1:8020</value> </property> <!-- 设置Hadoop本地保存数据路径 --> <property><name>hadoop.tmp.dir</name><value>/export/data/hadoop-3.3.0</value> </property> <!-- 设置HDFS web UI用户身份 --> <property><name>hadoop.http.staticuser.user</name><value>root</value> </property> <!-- 整合hive 用户代理设置 --> <property><name>hadoop.proxyuser.root.hosts</name><value>*</value> </property> <property><name>hadoop.proxyuser.root.groups</name><value>*</value> </property> <!-- 开启垃圾桶机制[可选操作] 1440 表示1440分钟也就是24小时一天的时间--> <property><name>fs.trash.interval</name><value>1440</value> </property>

③ hdfs-site.xml文件

[root@node1 hadoop]# vim hdfs-site.xml

<!-- 在文件的<configuration></configuration>的标签中添加以下内容: --> <!-- 指定secondarynamenode运行位置 --><property><name>dfs.namenode.secondary.http-address</name><value>node2:9868</value></property>

④ mapred-site.xml文件

[root@node1 hadoop]# vim mapred-site.xml

<!-- 在文件的<configuration></configuration>的标签中添加以下内容: --> <!-- 设置MR程序默认运行模式: yarn集群模式 local本地模式 -->

<property><name>mapreduce.framework.name</name><value>yarn</value>

</property>

<!-- MR程序历史服务器端地址 -->

<property><name>mapreduce.jobhistory.address</name><value>node1:10020</value>

</property>

<!-- 历史服务器web端地址 -->

<property><name>mapreduce.jobhistory.webapp.address</name><value>node1:19888</value>

</property>

<property><name>yarn.app.mapreduce.am.env</name><value>HADOOP_MAPRED_HOME=${HADOOP_HOME}</value>

</property>

<property><name>mapreduce.map.env</name><value>HADOOP_MAPRED_HOME=${HADOOP_HOME}</value>

</property>

<property><name>mapreduce.reduce.env</name><value>HADOOP_MAPRED_HOME=${HADOOP_HOME}</value>

</property>

⑤ yarn-site.xml文件

[root@node1 hadoop]# vim yarn-site.xml

<!-- 在文件的<configuration></configuration>的标签中添加以下内容: --> <!-- 设置YARN集群主角色运行机器位置 --> <property><name>yarn.resourcemanager.hostname</name><value>node1</value> </property> <property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value> </property> <!-- 是否将对容器实施物理内存限制 --> <property><name>yarn.nodemanager.pmem-check-enabled</name><value>false</value> </property> <!-- 是否将对容器实施虚拟内存限制。 --> <property><name>yarn.nodemanager.vmem-check-enabled</name><value>false</value> </property> <!-- 开启日志聚集 --> <property><name>yarn.log-aggregation-enable</name><value>true</value> </property> <!-- 设置yarn历史服务器地址 --> <property><name>yarn.log.server.url</name><value>http://node1:19888/jobhistory/logs</value> </property> <!-- 保存的时间7天 --> <property><name>yarn.log-aggregation.retain-seconds</name><value>604800</value> </property>

⑥ workers文件

[root@node1 hadoop]# vim workers

# 用以下内容把之前内容覆盖 node1 node2 node3

5.拷贝软件到其他机器

-

nod1主机上拷贝到node2和node3中各一份

[root@node1 server]# scp -r /export/server/hadoop-3.3.0 root@node2:/export/server/ [root@node1 server]# scp -r /export/server/hadoop-3.3.0 root@node3:/export/server/

-

node2主机配置环境变量

[root@node2 server]# echo 'export HADOOP_HOME=/export/server/hadoop-3.3.0' >> /etc/profile [root@node2 server]# echo 'export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin' >> /etc/profile [root@node2 server]# source /etc/profile

-

node3主机配置环境变量

[root@node3 server]# echo 'export HADOOP_HOME=/export/server/hadoop-3.3.0' >> /etc/profile [root@node3 server]# echo 'export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin' >> /etc/profile [root@node3 server]# source /etc/profile