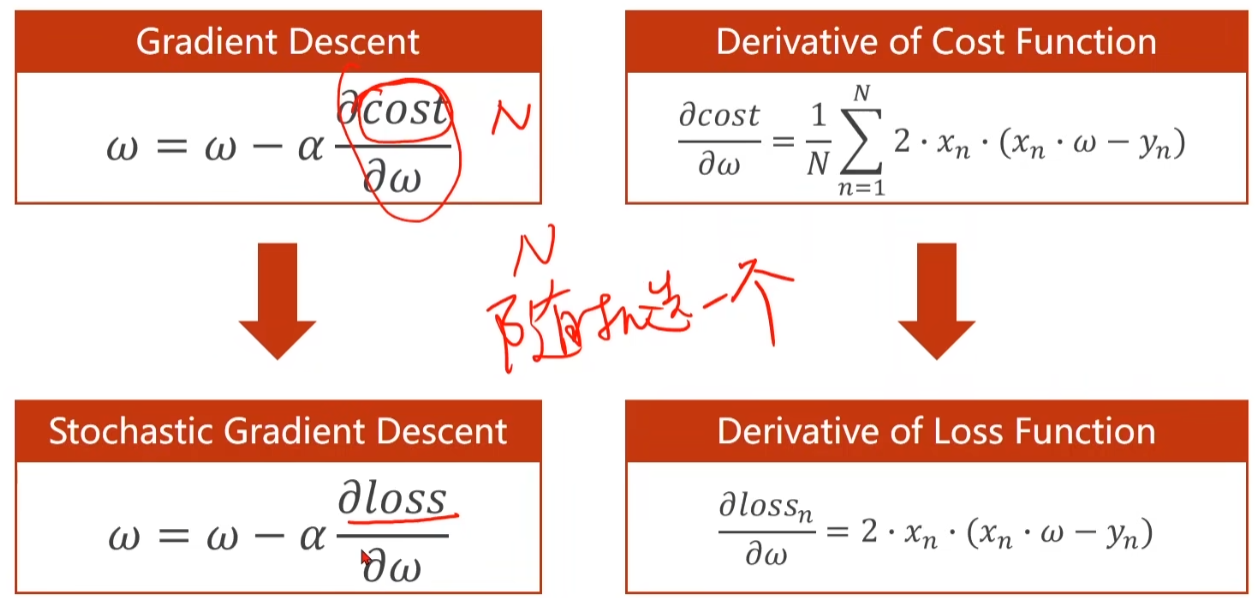

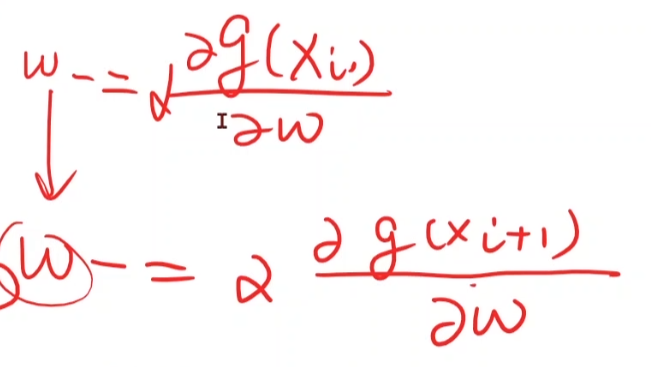

随机梯度下降可以跨越鞍点

对每一个样本的梯度进行更新

点击查看代码

import numpy as np

import matplotlib.pyplot as pltx_data = [1.0, 2.0, 3.0]

y_data = [2.0, 4.0, 6.0]w = 1.0def forward(x):return x * wdef loss(x,y):y_pred = forward(x)return (y_pred - y) ** 2def gradient(x, y):return 2 * x * (w*x - y)for epoch in range(100):for x, y in zip(x_data, y_data):grad = gradient(x, y)w = w - 0.01*gradl = loss(x, y)print('epoch:', epoch, 'loss:', l, 'grad:', grad)注意随机梯度下降w的更新是不可以并行的,所以运算性能不是很高

为了平衡随机梯度下降和梯度下降算法各自的缺点,我们可以使用批量梯度下降算法