https://blog.csdn.net/qq_43799400/article/details/131202148

写代码遇到问题

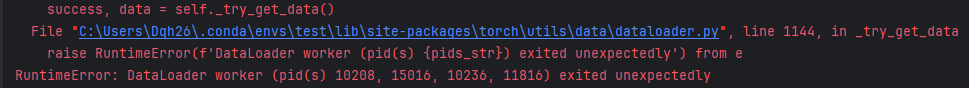

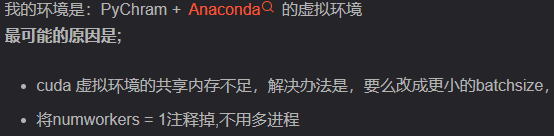

1、使用data.DataLoader时如果使用多进程num_workers,会报错

其原因可能是

https://blog.csdn.net/KaelCui/article/details/106184158

2、loss的backward

注意backward只能对标量,而不是对张量。

我们定义损失函数时,如果没有进行reduction=sum/mean,那么损失函数返回的是张量

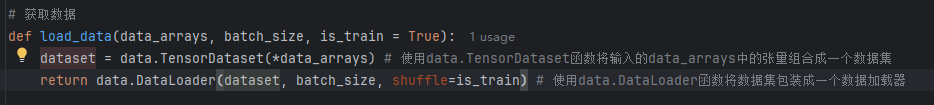

3、DataLoader的第一个参数必须是dataset数据集

在线性回归中,我们先将数据转为dataset再放入DataLoader

这是因为我们要先将多个张量合并到pytorch的一个统一的数据集中才可以

import torch

from torch.utils import data# 准备数据

true_w = torch.tensor([2, -3.4])

true_b = 4.2def synthetic_data(w, b, num_examples):x = torch.normal(0, 1, size=(num_examples, 2))y = torch.matmul(x, w) + by += torch.normal(0, 1, size = y.shape)return x, y.reshape((-1, 1))features, labels = synthetic_data(true_w, true_b, 1000)# 获取数据

def load_data(data_arrays, batch_size, is_train = True):dataset = data.TensorDataset(*data_arrays) # 使用data.TensorDataset函数将输入的data_arrays中的张量组合成一个数据集return data.DataLoader(dataset, batch_size, shuffle=is_train) # 使用data.DataLoader函数将数据集包装成一个数据加载器data_iter = load_data((features, labels), 10)# 构造模型

net = torch.nn.Sequential(torch.nn.Linear(2, 1)) # 输入特征形状 输出特征形状

net[0].weight.data.normal_(0, 0.01)

net[0].bias.data.fill_(0)# 定义损失函数和优化器

loss = torch.nn.MSELoss()

optimizer = torch.optim.SGD(net.parameters(), lr=0.01)# 训练

epochs = 10

for epoch in range(epochs):for X, Y in data_iter:l = loss(net(X), Y)optimizer.zero_grad()l.backward()optimizer.step()l = loss(net(features), labels)print('epoch:{}, loss:{}'.format(epoch+1, l.item()))

![[poc] hw情报-泛微 e-cology v10 远程代码执行漏洞](https://img2024.cnblogs.com/blog/977686/202408/977686-20240823153739999-306314569.png)