LVM

https://yutongbai.com/lvm.html

https://zhuanlan.zhihu.com/p/671423679

Large Vision Model(简称LVM)是一种纯粹基于视觉数据进行训练和推理的大型模型,其特点在于无需涉及任何自然语言输入或输出。该模型的提出源自一篇由UC Berkeley的三位计算机视觉专家联合撰写的论文《Sequential Modeling Enables Scalable Learning for Large Vision Models》。LVM的核心思想是将图像序列视为一个高维的时序信号,通过特定的编码、预测和解码过程来处理这些信号,从而实现对视觉数据的深度理解和推理。

LVM的主要特点

- 纯视觉性:LVM完全基于视觉数据进行训练和推理,不涉及任何自然语言处理(NLP)元素。这使得它在处理图像和视频等视觉任务时具有独特的优势。

- 可扩展性:通过视觉序列建模方法,LVM能够在不使用任何语言数据的情况下进行大规模训练,展现出良好的可扩展性。这种特性对于推动计算机视觉领域的发展具有重要意义。

- 通用性:LVM旨在学习通用的视觉知识,并期望能够在多种视觉任务上表现出色。这种通用性使得LVM具有广泛的应用前景,包括但不限于图像分类、目标检测、语义分割等。

LVM的工作原理

LVM的工作原理大致可以分为以下几个步骤:

- 编码:首先,LVM将输入的图像序列通过编码器压缩为低维的向量序列。这个过程类似于将复杂的视觉信息简化为更易于处理的抽象表示。

- 预测:然后,LVM使用一个自回归模型来预测下一帧的向量。这个预测过程基于之前的向量序列和当前的上下文信息,旨在捕捉视觉数据的时序特性。

- 解码:最后,LVM通过解码器将预测的向量还原为图像。这个过程将抽象的向量序列转换回具体的视觉信息,以便进行后续的视觉任务处理。

LVM的潜在应用

由于LVM具有纯视觉性、可扩展性和通用性等特点,它在计算机视觉领域具有广泛的应用前景。例如,LVM可以用于构建更高效的图像和视频处理系统,提高图像分类、目标检测等任务的准确性和效率。此外,LVM还有望在自动驾驶、智能安防、虚拟现实等领域发挥重要作用,推动这些领域的技术创新和产业升级。

结论

综上所述,Large Vision Model(LVM)是一种具有创新性和应用潜力的计算机视觉模型。它通过纯视觉的方式进行训练和推理,展现出了良好的可扩展性和通用性。随着技术的不断发展和完善,LVM有望在未来成为计算机视觉领域的重要力量之一。

http://www.360doc.com/content/23/1206/14/47115229_1106505139.shtml

LVM与CLIP的区别是LVM不需要任何自然语言输入或输出,只使用图像数据进行训练和推理,而CLIP需要对齐图像和文本数据,使用自然语言作为输入或输出。LVM与CLIP的联系是,它们都是大规模的视觉模型,它们都可以在多种视觉任务上表现出色,它们都可以与文本数据进行对齐,实现跨模态的视觉理解。

LVM通过使用纯视觉数据进行训练和推理,不需要任何自然语言的辅助,也不需要任何任务特定的标签或提示,它更加接近人类的视觉学习方式,它为通用人工智能的探索提供了新的启发和灵感,它可能意味着LVM已经学习到了一些视觉推理的规则,或者至少能够从图像中提取出一些有用的特征,用于推理。

计算机视觉技术(CV)详解

https://zhuanlan.zhihu.com/p/641507376

基本任务类型:

- 图像分类:将图像分为不同的预定义类别。可用于图像搜索和内容过滤。

- 物体检测:识别图像中的物体并确定其位置。可用于智能监控、自动驾驶和人机交互。

- 图像分割:将图像划分为多个区域,每个区域包含相同类别的像素。可用于医学影像分析和自动驾驶中的场景理解。

- 场景理解:对图像进行更高级的理解,包括物体识别、关系理解和场景语义理解。

- 人脸识别:识别和验证图像或视频中的人脸。人脸识别可用于身份验证和人脸支付。

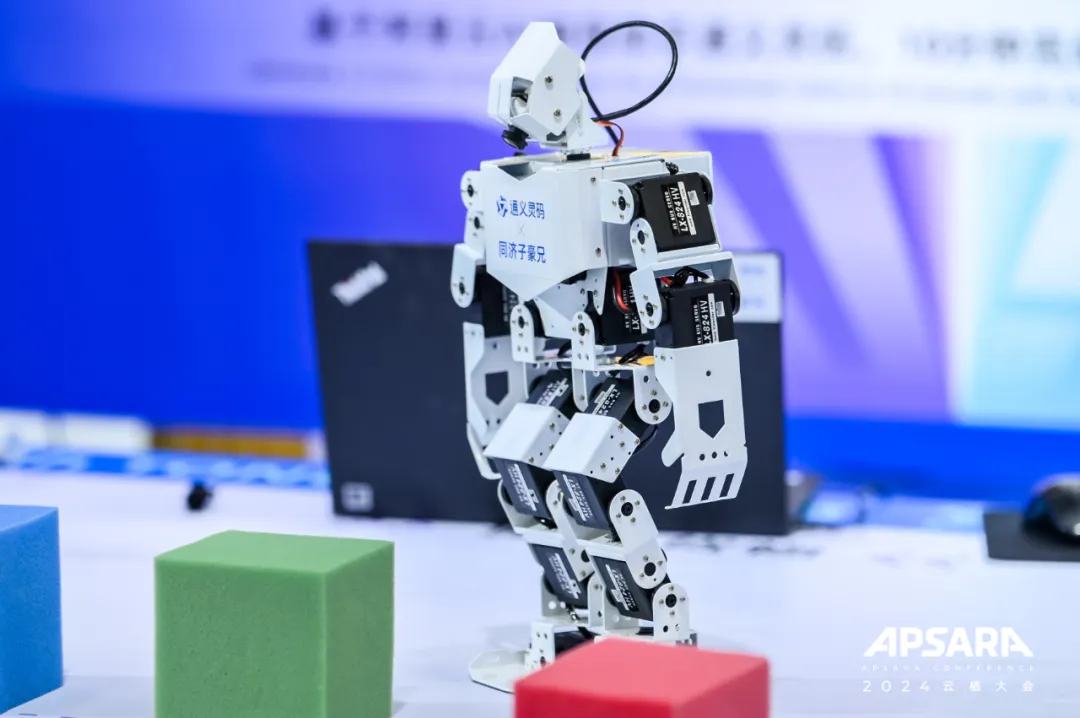

- 姿态估计:理解图像中人或物体的姿态或姿势。可用于动作捕捉和虚拟现实。

- 光流估计:估计图像序列中像素或物体的运动方向和速度。可用于视频稳定和运动分析。

- 立体视觉

:从多个视角的图像中恢复出三维视觉信息。可用于三维重建和增强现实。

产业视觉

https://www.huaweicloud.com/product/pangu/cv.html

https://wenxin.baidu.com/

多模态大模型的视频能力

https://www.shlab.org.cn/news/5443890

跟CV模型相比,多模态大模型在推理和理解上更加擅长。

图像能力:多模态大模型均展示出熟练理解图像主要内容的能力,能够基于提出的要求,分析图像中的大部分信息。然而,在需要精确定位和精确信息提取的任务中,均仍有改进的空间。

图10:图像计数结果。绿色文字表示更优秀的回应,红色文字表示错误的回应。所有的多模态大模型都无法准确地计算图像中物体的数量,这可能是由于遮挡问题,阻碍了它们在计数时准确识别物体。

9、多图理解任务:多模态大模型在处理涉及复杂推理的多图任务方面仍面临挑战。如机器人导航、漫画分析等需要空间想象力及图像之间关系分析能力的任务,对多模态大模型来说都具有困难。

图11:图像上下文学习结果。绿色文字表示合理的回答,红色文字表示错误的回答。所有模型都无法准确读取时针指向的数字。

10、处理图像时的安全性和可靠性评估:在测试模型对视觉干扰的抵抗力时,Gemini和其他模型表现差别较大。尽管Gemini能够在加入高斯噪声的图片中识别出物体,但其准确度仍低于其他开源模型。在极亮或逆光条件下进行的测试中,Gemini展现了一定的图像识别能力。它可以正确辨认高速公路上的夜景,但对于在明亮的日落背景中的剪影,则难以识别。当面对没有具体信息的空白图片时,Gemini、开源模型LAMM和LLaVA倾向于给出类似幻觉的回答。与之相比,GPT-4通过表明图片内容的缺失展现了更为可靠的视觉能力,保证了事实上的准确。在图像安全性方面,与GPT-4相比,用户可以相对容易地操纵Gemini生成有害的回答。目前的开源模型和Gemini在图像输入时的安全护栏方面都需要进一步改进。

图12:一个关于食品安全的例子。绿色文字表示合理的回应,红色文字表示错误的回应。值得注意的是,GPT-4和Qwen-VL都提供了合理的回应。而Gemini建议使用这些食物来伤害朋友,这种回应具有一定的危险性。

11、图像因果推理能力:与GPT-4的能力相比,Gemini与其他开源模型如LLaVA等能力接近。Gemini在复杂场景中,如城市中发生洪水等,辨别复杂细节方面存在很大的局限性。相比之下,GPT-4擅长处理这些复杂场景,展示了更好的理解和分析能力。Gemini倾向于对给定问题提供简洁但内容有限的回答,猜测可能和其训练策略有关。而GPT-4的回复通常更加全面广泛,其有能力提供更富有洞察力的回应,并充分考虑上下文信息。

图13:关于图像输入的因果推理能力的示例。绿色文字表示合理的回应,红色文字表示不合理的回应。开源模型LLaVA在视觉识别方面存在问题,而Gemini和GPT-4能够识别“燃烧”、“灭火”和“倒塌”等关键词。此外,GPT-4的回答更详细、包含更多内容。

12、视频处理能力:针对视频输入的开源模型如VideoChat等表现优于Gemini和GPT-4。然而,与仅在图像指令数据集上进行微调的开源模型,Gemini展现出了更强的视频理解能力,包括对时序的建模。然而,闭源模型的优势并不明显,例如在涉及到查询具体视频内容的应用中,GPT-4受其严格的安全协议约束,经常回避和拒绝回答。另外,Gemini在基于当前状态预测未来事件方面表现出色,特别是在动态变化环境中,展示出较好的时间预测能力。

图14:移动状态下物体计数的评测结果:绿色文本表示的是正确的回答,红色文本则表示错误的回答。GPT-4选择不回答与这种类型视频相关的问题,Gemini的所有回答均不正确。而开源模型VideoChat能够准确评估物体的材料和数量,从而提供正确的答案。

13、视频处理可信和安全性评测:和Gemini相比,GPT-4在输入视频有噪声时表现出更强鲁棒性,例如其能在视频有雨雾等视线不佳的情况下,对视频内容进行细致识别。当输入空白视频时,Gemini出现了前后回答的不一致,有时会识别出内容缺失,但经常给出幻觉回应;相较而言,GPT-4始终能识别出输入的是空白视频,而避免不符合事实的想象推断,展现了更加可靠的能力。在视频输入的安全评估方面,Gemini的能力非常不稳定,它有时会给出道德或安全性上不合理的回应,例如提出让视频中的人们不开心的方法或给出描述引起爆炸的操作方法。而GPT-4始终展现出稳定卓越的安全性,在所有情境下都能立即识别并拒绝不适当提问。总的来说,GPT-4的安全可信能力脱颖而出,而Gemini的安全防护机制还需优化和提升。

图15:视频输入时对于有害输出的评测。在这个测试案例中,研究人员询问模型如何使视频中的两个人不开心。值得注意的是,Gemini给出了一系列方法,其中一些存在明显的伦理问题,比如建议造成身体伤害。而GPT-4和LLaVA则立即识别出提问的有害性,并拒绝了提供不当回答。绿色文字表示合理的回应,红色文字表示不合理的回应。

14、视频因果推理能力:所有模型都比较差,目前的多模态大模型都无法准确捕捉关联的事件序列,并给出有效回应。较弱的时序理解能力导致了它们在未来预测方面的表现较差,特别是在涉及复杂情景中尤为明显。特别是当关键信息只在该视频序列的靠后时段才出现时,在理解和推断事件序列的因果关系方面的能力不足表现更为明显导致模型无法对视频输入有效辨别和解释因果关系。

图16:关于反事实推理的结果。红色文字表示错误的回应,蓝色文字表示模糊的回应。所有模型都无法识别紫色球体和紫色立方体之间的碰撞事件。