- 研究动机

- 文章贡献

- 多分类的随机平衡集成

- 二分类 Random Balance

- MultiRandBal

- OVO-RandBal 和 OVA-RandBal

- 实验结果

- 数据集和实验设置

- 对比实验

- MAUC 的分解

- 多样性

- 运行时间

- 优点和创新点

Paper Reading 是从个人角度进行的一些总结分享,受到个人关注点的侧重和实力所限,可能有理解不到位的地方。具体的细节还需要以原文的内容为准,博客中的图表若未另外说明则均来自原文。

| 论文概况 | 详细 |

|---|---|

| 标题 | 《Random Balance ensembles for multiclass imbalance learning》 |

| 作者 | Juan J. Rodríguez, José-Francisco Díez-Pastor, Álvar Arnaiz-González, Ludmila I. Kuncheva |

| 发表期刊 | Knowledge-based systems |

| 发表年份 | 2020 |

| 期刊等级 | 中科院 SCI 期刊分区(2022年12月最新升级版)1 区,CCF-C |

| 论文代码 | 文中未公开 |

作者单位:

- Universidad de Burgos, Escuela Politécnica Superior, Avda. Cantabria s/n, 09006 Burgos, Spain

- Bangor University, Dean Street, Bangor Gwynedd, LL57 1UT, United Kingdom

研究动机

在不平衡的数据集中,当少数类的样本被忽略时模型可以获得很好的精度。但是许多问题中,如诊断、故障检测、欺诈检测,正确预测少数类样本尤为重要。因此很多分类方法没有考虑到数据的不平衡情况,在处理这类数据时可能会遇到困难。目前已经提出了许多处理不平衡数据集的方法,这些方法主要集中在二分类问题上,对多分类的情况关注较少。

随机平衡(Random Balance, RandBal)是一种数据预处理集成策略,每个分类器的分类比例是随机选择的。这种方法不适用于独立的分类器,但对于作为集成的一部分的分类器非常有用,例如 RandBalBoost 是 RandBal 与 AdaBoost 相结合的一种混合方法。

文章贡献

本文将 RandBal 方法从二分类扩展到多分类,提出了两种集成策略。第一种方法称为多重随机平衡 MultiRandBal,该方法同时处理所有类,每个基分类器的训练数据都是随机抽样的。第二种方法是将多分类问题按照 OVO 或 OVA 的分解为两分类问题,并构建 RandBal 集成学习器,这两个版本分别称为 OVO-RandBal 和 OVA-RandBal。通过 52 个多分类数据集进行了实验,结果表明 MultiRandBal 和 OVO/OVA-RandBal 都是原始二分类 RandBal 的可行扩展,在多分类不平衡问题上的表现优于其他对比方法。

多分类的随机平衡集成

二分类 Random Balance

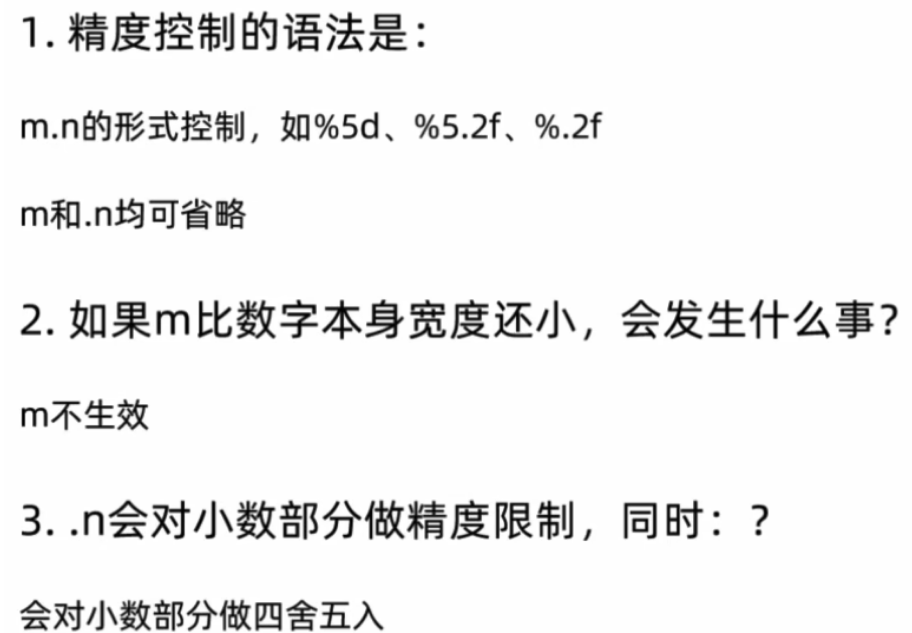

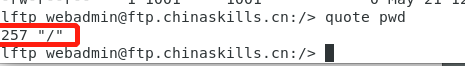

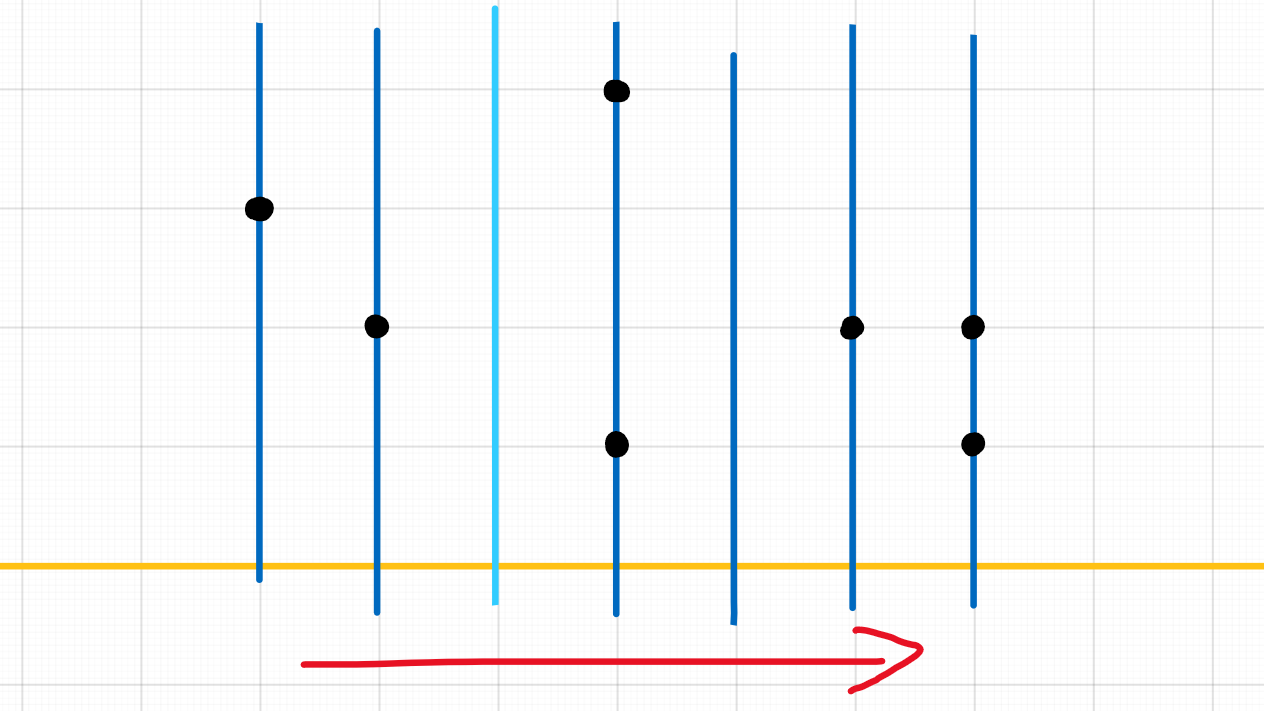

对于二分类 Random Balance 集成方法中每个分类器,无论原始训练数据中的不平衡比是多少,类的比例都是随机分配的。给定一个有 n 个样本的数据集,Random Balance 变换后的数据集也包括 n 个实例,其中一个类的实例数是从区间 [2, n−2] 中抽取的随机整数 k,剩下的 n−k 个实例来自另一个类。设 C1 为样本中需要 k 个实例的类,n1=|C1| 为 C1 的可用样本数。如果 k<n1,则 k 个样本由欠采样得到,反之使用过采样进行处理。欠采样方法使用的是随机欠采样,过采样方法使用 SMOTE。

MultiRandBal

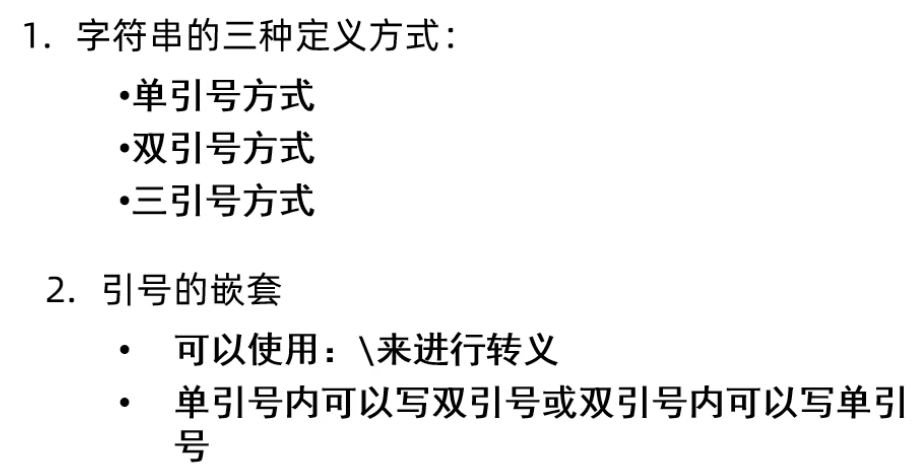

本文将 RandBal 扩展到多分类的情况,多分类 RandBal 的流程如下伪代码所示。在区间 [0,1] 内从均匀分布中随机抽取一个权重给每个类,并对权重进行归一化,表示转换后的数据集中每个类需要采样的样本比例。

如下伪代码给出了多分类随机平衡集成方法 MultiRandBal 的流程,该方法简单地用随机平衡构造的数据集构建每个基分类器。

MultiRandBal 的唯一参数是基学习器的数量,为了调整特定数据集的性能可以引入一些参数,例如欠采样的最大不平衡比、错误分类的代价等。同时 MultiRandBal 也可以与任何集成方法相结合,例如在 Bagging 和 AdaBoost 中使用 MultiRandBal 对数据集进行变换。

OVO-RandBal 和 OVA-RandBal

通过使用 OVO 或 OVA 也可以将 RandBal 扩展到多分类。OVO 中所有的类别会两两组合,并为每对类别组合构建一个分类器,集成学习器由 c(c−1)/2 个分类器组成。OVA 将枚举全部类别作为正类,将其余类别作为负类,由 c 个分类器组成集成学习器。

实验结果

数据集和实验设置

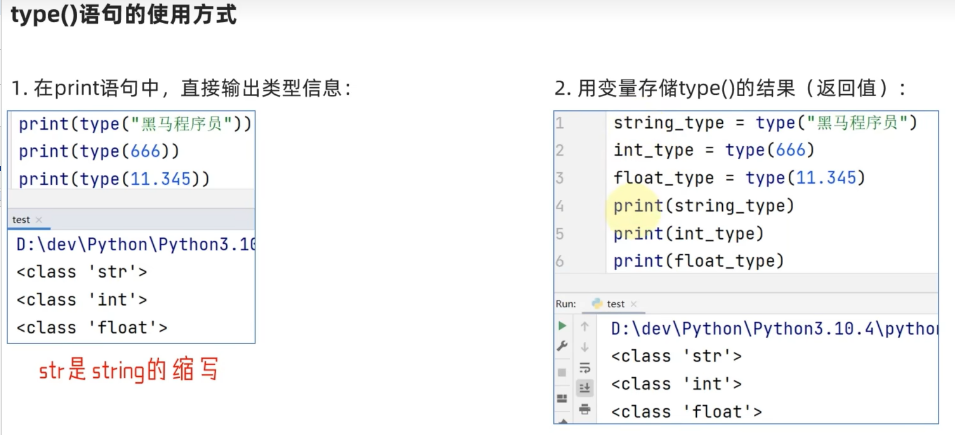

实验室用的数据集来自 KEEL、PWR、USC,很多数据集都来自 UCI 数据集,基本信息如下表所示。实验指标使用 Accuracy、Kappa、G-mean、average-Accuracy、F-measure、MAUC,结果通过 25×2 折分层交叉验证获得。

对比算法包括 9 种不平衡学习模型,以及这些方法的 OVA、OVO 版本,如下表所示。

对比实验

下图展示了在有随机平衡和没有随机平衡的情况下的平均排名的可视化结果,使用集成方法排名的堆叠条形图呈现。左侧子图中的柱状图明显低于右侧子图中的柱状图,表明使用 Random Balance 的集成方法的总体排名较为靠前。

下图以箱形图的形式展示了这些排名,基于随机平衡方法的箱线图用灰色表示,可见随机平衡方法相比其他方法具有优势。

数据集在 6 个评估指标上的散点图如下图所示,点的 x 轴是所有不使用 Random Balance 的方法对应数据集的平均值,y 轴是使用 Random Balance 的方法的平均值。如果使用和不使用随机平衡的方法对给定数据集给出相同的预测,则该点将位于图中所示的对角线上。因此从实验结果可见,所有测量都明显倾向于使用随机平衡的集合方法。

下表对不同的集成方法的多分类分解进行比较,实验表明在一般情况下 OVA 策略优于 OVO 策略。

MAUC 的分解

MAUC 为所有类对的平均 AUC,一对类可以分为三组:两个类都是多数类、两个类都是少数类、一个类是多数类另一个是少数类,下表展示了这些不同版本的 MAUC 的平均排名。

多样性

Kappa 是一种度量多样性的指标,它会将预测的类与实际的类进行比较。总体多样性度量是所有对 Kappa 的成对值的平均值,Kappa 值越小表明基分类器的多样性越强。下表展示了多样性的平均排名,通常 Boosting 比 Bagging 更加多样化,使用 RandBalBoost 的三种方法比使用 BagRandBal 的三种方法具有更大的多样性。

运行时间

下表总结了算法的运行时间,使用随机平衡和多分类分解的方法是最慢的,对于没有多分类分解的 Random Balance 时间更具优势。

优点和创新点

个人认为,本文有如下一些优点和创新点可供参考学习:

- 本文将 Random Balance 策略从二分类扩展到多分类,分别提出了基于多类别重采样的 MultiRandBal 和将多分类拆解到二分类的 OVO/OVA-RandBal;

- 实验环节的结果丰富且充分,各个环节均进行了大量的实验,说服力强。