在人工智能快速发展的今天,语音交互技术正经历一场革命性的变革。从语音识别到语音合成,再到端到端的语音对话系统,这一领域的创新正以前所未有的速度推进。这些进步不仅提升了技术指标,更为实时翻译、虚拟数字人、智能客服等实时互动场景带来了新的可能。

本届 RTE2024 大会上,来自学界和业界的多位专家深入探讨了语音 AI 的最新进展。阿里巴巴通义实验室语音算法专家吕翔、声网音频算法工程师李嵩、香港中文大学(深圳)教授武执政、标贝科技联合创始人兼 CTO 李秀林、SpeechGPT 的作者张栋等行业专家分享了他们的研究成果和洞见。

声网音频技术负责人陈若非和海外独角兽的 AI Research Lead 钟凯祺分别主持了主题分享和圆桌讨论环节。

吕翔:CosyVoice 语音生成大模型的突破与挑战

阿里巴巴通义实验室的语音算法专家吕翔介绍了 CosyVoice 的三大核心模块:自回归 Transformer、Flow Matching 和声码器。「自回归 Transformer 主要用于预测 Next Token,Flow Matching 则负责从噪声分布到目标分布的转换,」他说:「而声码器也做了一些改进,比如结合了 Filter 和 Vocal 技术。」

CosyVoice 的应用场景令人印象深刻。吕翔举例说:「零样本语音克隆是大家特别感兴趣的功能,最短只需 3 秒的音频就能模仿说话人的音色与风格。」CosyVoice 甚至能让一个不会说英语和日语的人「说出」流利的外语。CosyVoice 的开源也为更多开发者提供了机会。「代码库结构非常简单,一个指令就可以自行训练。」

李嵩:低延迟流式语音识别系统的突破与应用

「在人与人的交流过程中,我在说话的时候你们已经听到我在说什么了,但现在的系统都是我说以后你们才开始理解我说的是什么,然后再进行反馈,」声网音频算法工程师李嵩如此描述当前技术的局限性。

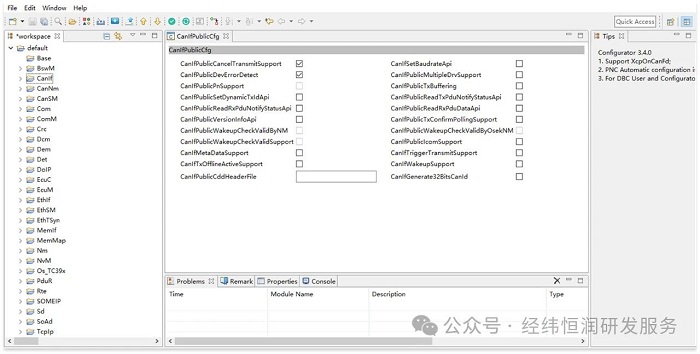

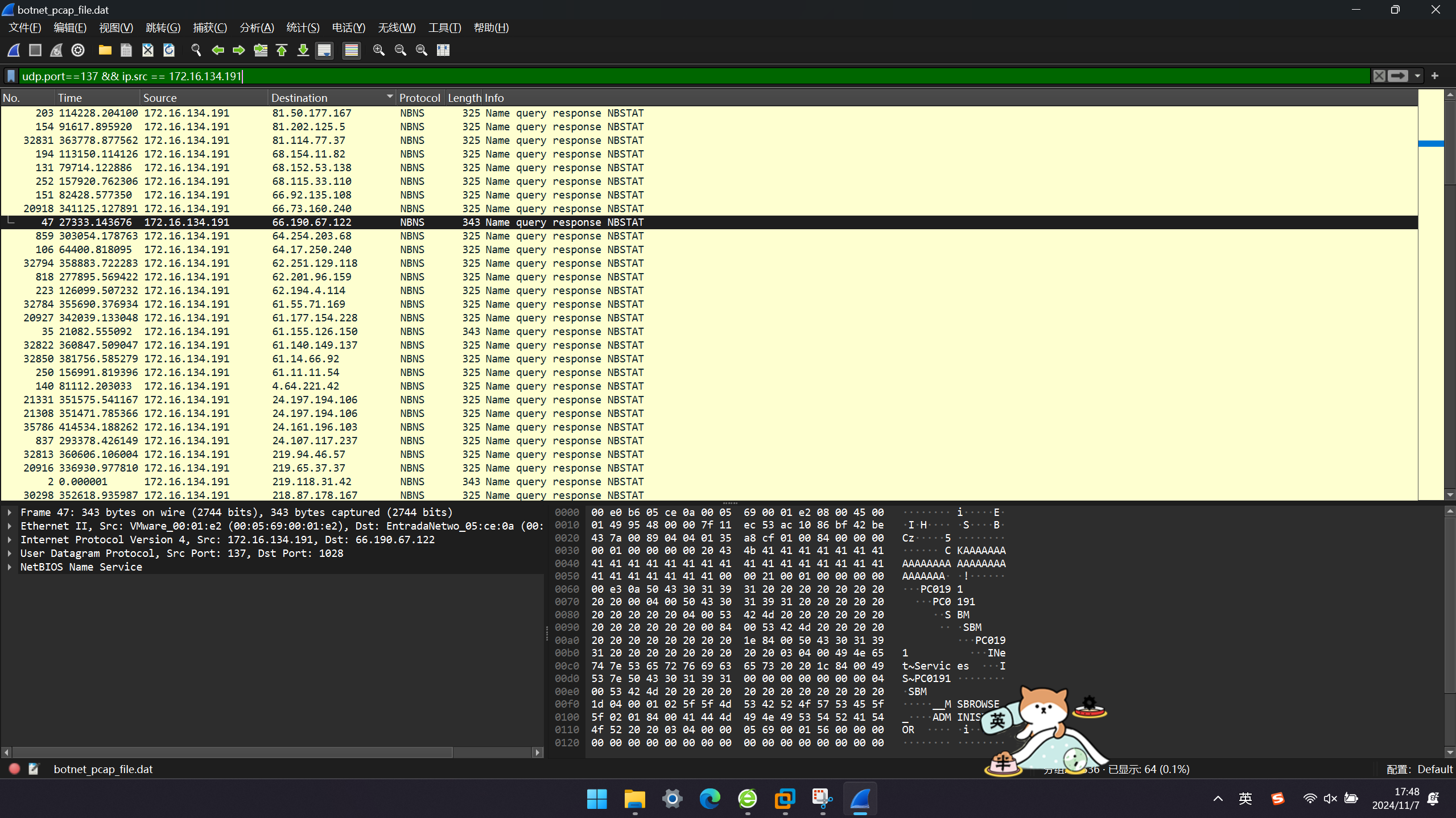

为了应对这一挑战,李嵩和他的团队开发了一套低延迟流式语音识别系统。这个系统能够支持各种实时性要求高的任务。李嵩举例说明:「实时字幕、实时翻译、实时人机交互,这些场景对 ASR 实时性的要求都非常高。」在技术层面,李嵩介绍了他们的创新方案,包括前处理、ASR 和后处理三个关键环节。其中,前处理阶段使用了凤鸣 AI 引擎,包括 AINS(噪声抑制)、AIAEC(回声消除)和 AIVAD(低延迟人声检测)等技术,显著提升了识别性能。

「适配线上真实音频环境,数据永远是最重要的,尤其是开源框架或者模型效果都差不多时。我们在做训练数据增加了 RTE 环境适配,包括噪声+混响环境,配置不同等级的 3A 处理,让 ASR 识别引擎了解 RTE 真实环境,让适配率更好。」李嵩声网音频算法工程师

武执政:语音生成大模型研究进展与未来趋势

以电影《Her》为引子,香港中文大学(深圳)的武执政教授指出当前语音交互技术与理想状态仍有差距,特别是在理解和表达复杂情感方面。

武教授强调,真正的语音交互不仅涉及语义内容,还包括情感、语气、口音等多维度信息。他举例说明同样的文字在不同情境下可能表达截然不同的含义,这对 AI 系统是巨大挑战。

李秀林:语音合成大模型与高质量数据的融合之路

标贝科技联合创始人兼 CTO 李秀林强调:「Transformer 之后,大家可能会在这种框架下做更精致、更巧妙的设计,数据的需求量也是非常大的,数据占比或者对整个效果的影响非常大。」

为了满足大模型对数据的需求,标贝科技开发了一整套数据处理 Pipeline 工具链,包括数据获取、降噪、片段切分、质量筛选、ASR 转写等步骤。李秀林指出,高质量数据的定义会因应不同任务和环节而有所不同,可能是大规模但质量一般的数据,也可能是中等规模但音质和风格把控更好的数据。

标贝科技在过去八年积累了大量合成方向的数据库,涵盖各种年龄、性别、风格和情绪的语音数据。最近,他们还制作了数千小时的对话数据库,以满足自然聊天风格的需求。

张栋:通向端到端拟人化语音对话的智能体探索

SpeechGPT 作者、复旦大学的张栋分享了团队在端到端语音对话方面的最新研究成果,重点介绍了 SpeechGPT 系列的发展历程。张栋描绘了一个理想的语音对话 chatbot 应具备的特点:Human-like、Conversational Toolbox 和Real-time。

在 SpeechGPT 的开发过程中,团队发现了一些局限性。「SpeechGPT 不能支持和副语言学习相关的任务,包括情绪、环境、年龄、口音,这些任务基本上都不能产生。」为了解决这个问题,他们开发了自己的 Speech Tokenizer 和 SpeechGPT2。

张栋还介绍了 SpeechGPT2 的训练数据特点:「我们采用 10 万小时的语音文本配置数据集,但区别就是会给所有语音加上 Caption 或者 Description,就是用一段文字描述语音特性,副语言也用文本形式描述起来。」

圆桌讨论:VoiceAI ,下一代人机交互界面?

在主题是「Voice AI,下一代人机交互界面?」的圆桌讨论中,来自「海外独角兽」的钟凯祺担任主持人,参与讨论的嘉宾包括张栋、李秀林、武执政和王芷,他们分别来自学界和业界的不同领域。

-

语音 AI 领域中被低估的方向

讨论伊始,张栋就指出了语音 AI 领域中被低估的两个重要方向:合成数据和强化学习。他强调了预训练数据的重要性,指出即使有 1000 万小时的预训练数据,与文本大模型相比仍有数百倍的差距。张栋还提到了双通道对话数据的稀缺性,以及如何利用人类反馈来提升语音大模型的质量。

李秀林则从数据建设的角度补充道,中英混合的数据或者中粤混合的数据在真实数据中的占比是非常低的,但这种数据在一些场合下又需要,包括方言和口音等等。他呼吁业界合作,共同建设超大规模、低成本的数据资源。在语音 AI 模型评估的问题上,武执政指出了现有评估方法的局限性。他说:「我们内部做产品的时候希望定义一个比较客观的指标,但这个客观指标很难定下来。」他举例说明,即使在准确率达到 100%的情况下,情感和语气等细微差别仍难以评估。

-

语音能否成为下一代人机交互界面?

王芷则分享了微软在 Voice AI 方面的洞察,她认为教育和泛娱乐是 Voice AI 的下一个爆发点。「不管是重交互场景还是重内容场景,都是现在我们可以看到各行各业快速迭代的场景。」

张栋认为最大的难点在于模型能力。他解释道:「语音到语音的模型几乎完美,但不需要任何调整地适配到所有的 Agent 框架或者是文本技术相结合是比较难的。」

李秀林则指出了语音交互效率的局限性:「我们看到一页纸可以一目十行地看过去,要是听和说的话,码率信息含量密度是不够的。」

王芷还表达了对声音复刻技术的期待:「我很期待声音特征能够让数字分身更加智能化,也会维系家庭关系,就是把气都撒在老公的智能分身上面,可以很好地维系自己的夫妻关系。」

加入 RTE 开发者社区,一同探索人和 AI 的实时互动新范式

在语音 AI 技术的快速发展下,一个更加智能、自然的人机交互时代正在加速到来。我们期待与各领域的研究者和开发者一起,携手迎接这个更具表现力的语音 AI 新纪元,为更多实时互动应场景开启无限可能。

RTE 开发者社区持续关注 Voice AI 和语音驱动的下一代人机交互界面。如果你对此也有浓厚兴趣,也期待和更多开发者交流(每个月都有线上/线下 meetup),欢迎加入我们的社区(加微信 bob_fu),一同探索人和 AI 的实时互动新范式。

「重塑语音交互:音频技术和 Voice AI」技术专场由 RTE 开发者社区和海外独角兽联合出品。

RTE 开发者社区是聚焦实时互动领域的开发者社区。希望通过社区链接领域内的开发者和生态力量,萌芽更多新技术、新场景,探索实时互动领域的更多可能。这里你将遇见一群致力于改变人和人、人和世界,以及人和 AI 连接方式的开发者。

「海外独角兽」是拾象旗下的开源研究平台,专注于研究全球范围最优秀的创新公司,致力于用开源精神重塑投资信息分发网络。创立以来拾象团队积极输出高质量的行业与公司认知,已经输出了近 300 篇针对全球头部科技公司和前沿科技趋势的文章。在全球 AI 社区中积累了行业影响力,全网拥有 20万+订阅,覆盖头部互联网企业界、硅谷 AI 科学家、以及全球科技公司一线从业者等。