今天,我将介绍一种简单的方法,帮助大家从各种网站上收集数据,搭建一个能够像人在浏览器中操作的网页爬虫。这种爬虫甚至可以在 Upwork 等平台上独立完成一些网页抓取的自由职业任务。

自2024年以来,随着 AI 的发展,网页抓取发生了巨大的变化。以前,大公司如亚马逊或沃尔玛为了保持价格竞争力,必须花费大量时间和金钱抓取其他网站的数据。这些公司通过模拟浏览器的操作来实现:向网站发送请求获取 HTML 代码,再使用特定代码找到并提取需要的信息。然而,这一过程复杂且耗时,特别是当网站设计变动时,爬虫需要不断修复和更新。

想象一下,如果亚马逊想监控沃尔玛的商品价格,就需要专门为沃尔玛的网站开发一个爬虫;但若沃尔玛更改网站设计,亚马逊就得更新爬虫,这不仅费时还费钱。不仅大公司有爬虫需求,很多小公司和创业公司也需要爬虫。

例如,在 Upwork 等自由职业网站上,小企业会寻找开发爬虫的自由职业者,用于获取联系方式、跟踪价格、市场调研或职位列表。举个例子,一家初创公司可能需要监控不同电商网站上的商品价格来制定自家商品的定价。在 AI 出现之前,小公司获取这些解决方案既困难又昂贵。现在,有了大型语言模型(LLMs)和新工具,创建网页爬虫变得简单又实惠。过去需要一周完成的工作,现在几小时就能搞定。LLMs 能聪明地理解不同网站结构,避免频繁重写爬虫。

如何有效抓取数据并处理各类网站

我将内容分为三类:

-

简单的公共网站

-

有复杂交互的网页

-

需要智能代理的高级应用

-

抓取简单的公共网站

简单的公共网站,如 Wikipedia 或公司官网,不需要登录或付费访问。以前,为了从 Wikipedia 收集信息,需要查看每个页面的 HTML 代码,并编写自定义代码获取数据。现在,有了 LLMs,只需将原始 HTML 提供给 AI,它就能提取数据,比如“获取植物的名称、描述和养护要点”,AI 会返回一个组织良好的结果,节省了大量时间和精力。

- 抓取有复杂交互的网站

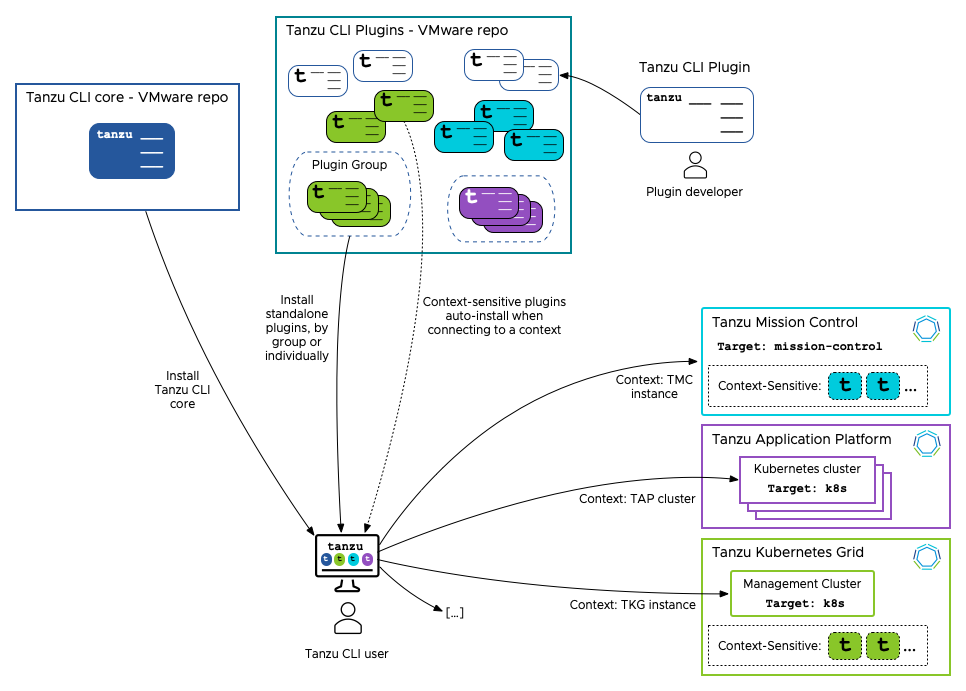

有些网站需要复杂交互,如登录、验证码、关闭弹窗等。例如,新闻网站可能要求登录查看文章,这时像 Selenium、Puppeteer、Playwright 等工具派上用场。假设你想从《纽约时报》抓取文章,可以用 Playwright 或 Selenium 让爬虫登录、关闭弹窗,然后访问文章内容。AgentQL 可帮助爬虫找到网页上的关键元素,比如按钮和表单,让爬虫完成这些交互。

- 需要智能思考的高级应用

最后一类是需要模糊任务的高级应用,比如找到最便宜的航班或按预算购买演唱会门票。这些任务需具备规划和判断,目前已有一些工具在开发中,如 Multion,它能制作出独立完成复杂任务的代理,比如找到七月从纽约到墨尔本的最便宜航班并预订。

实用的网页抓取工具

以下是一些结合 LLMs 和代理的网页抓取工具:

• Fireship、Gina 和 SpiderCloud:将网页内容转化为 AI 更易理解的格式。

• AgentQL:帮助爬虫与网站交互,适合填写多表单的招聘网站。

• Airtable/Google Sheets 集成:爬虫收集的数据可存入 Airtable 或 Google Sheets,便于分析。

• Octoparse 和 ScrapeHero:擅长处理 JavaScript 密集的网站。

• ScraperAPI 和 Zyte:提供旋转代理以避免爬虫被封。

• Mozenda 和 Web Robots:可自动化复杂网页表单操作,还支持定时任务。

小技巧:如果不想自己动手搞爬虫,仅需要数据支持,还可以考虑与专业提供商或个人合作,直接购买实时数据。对于很多企业而言,这往往比自行组建团队更具性价比。

总结

在2024和2025年,AI 正在改变网页抓取方式。有了大型语言模型、AgentQL、Playwright 等工具,复杂网站的抓取可以更少人工操作。无论是收集商业数据、寻找职位,还是预订航班,这些系统足够灵活,能处理多种任务。网页抓取自动化的机会比以往更大也更容易实现了。无论你是小企业主、自由职业者,还是好奇学习的个人,这些 AI 工具都让网页抓取变成一种强大又简单的解决方案。

一定要试试!