Topology-Driven Multi-View Clustering via Tensorial Refined Sigmoid Rank Minimization翻译

通过张量化改进的Sigmoid秩最小化实现的拓扑驱动多视图聚类

Zhibin Gu KDD 2024 北京交通大学 冯松鹤 通信作者

PANDA模型从欧几里得图中提取拓扑结构,以有效捕捉数据点的相似性。此外,开发了一种精细的Sigmoid函数,作为张量秩最小化的一个明显更紧密的近似。这允许在张量数据的不同奇异值中探索重要信息。

2问题定义

2 符号和预备知识

在本节中,我们概述了整篇论文中使用的数学符号和初步定义。具体来说,标量、向量、矩阵和张量分别用小写字母、粗体小写字母、粗体大写字母和粗体花体字母表示(即 a,\(\mathbf{a}\),\(\mathbf{A}\),\(\mathcal{A}\))。对于矩阵 A,其Frobenius范数和核范数分别表示为\(\|A\|_{F}=\sqrt{\sum_{ij}|A(i, j)|^{2}}\)和\(\|A\|_{*}=\sum_{v}\delta_{v}(A)\),其中\(A(i, j)\)和\(\delta_{v}(A)\)分别代表 A 的第\(i,j\)个元素和第\(v\)个最大的奇异值。对于张量\(\mathcal{A}\in \mathbb{R}^{n_{1}\times n_{2}\times n_{3}}\),其t-SVD定义为\(\mathcal{A}=O \ast \mathcal{P} \ast Q^{T}\),其中\(O\in \mathbb{R}^{n_{1}\times n_{1}\times n_{3}}\)和\(Q\in \mathbb{R}^{n_{2}\times n_{2}\times n_{3}}\)是正交张量,而\(\mathcal{P}\in \mathbb{R}^{n_{1}\times n_{2}\times n_{3}}\)是由对角矩阵作为前切片组成的f-对角张量。

定义1(张量核范数TNN:Tensor Nuclear Norm):对于张量\(\mathcal{A}\in \mathbb{R}^{n_{1}\times n_{2}\times n_{3}}\),其张量核范数可以定义如下:

其中\(\mathcal{P}\in \mathbb{R}^{n_{1}\times n_{1}\times n_{3}}\)是从t-SVD(即\(\mathcal{A}=O \ast \mathcal{P} \ast Q^{T}\))在傅里叶域中派生的。

TNN在张量分析中用于度量度张量“大小”的一种方法。张量核范数是张量奇异值的和,类似于矩阵的核范数是其奇异值的和,它是张量低秩性质的重要指标,低秩性(Low-Rankness)意味着张量可以被近似表示为较低维度的张量的乘积,低秩性在数据压缩、降维和特征提取等领域有广泛应用。。

- \(\mathcal{A}\) 是一个三维张量,其维度为 \(n_1 \times n_2 \times n_3\)。

- \(n_3\)是张量的第三维的维度。

- \(\mathcal{P}_f^{\kappa}\) 是从张量 \(\mathcal{A}\) 通过张量奇异值分解(t-SVD)得到的,它是在傅里叶域中的表示。

- \(k\) 表示张量 \(\mathcal{A}\) 的第 \(k\) 个前切片(frontal slice)。

- \(i\) 是索引,用于遍历前切片中的元素。

- \(\mathcal{P}_f^{\kappa}(i,i)\) 是第 \(k\) 个前切片的第 \(i\) 个对角线元素,即奇异值。

张量核范数的计算过程如下:

- 对张量 \(\mathcal{A}\) 进行张量奇异值分解(t-SVD),得到 \(\mathcal{A} = O * \mathcal{P} * Q^T\),其中 \(O\) 和 \(Q\) 是正交张量,而 \(\mathcal{P}\) 是由对角矩阵组成的f-对角张量。

- 对于每个前切片 \(\mathcal{P}_f^k\),计算其对角线上的元素,即奇异值。

- 将所有前切片的奇异值求和,然后除以\(n_3\) 得到张量核范数。

张量核范数在多视图聚类(MVC)中可以用来正则化张量的“大小”,有助于在聚类过程中减少噪声的影响,从而提高聚类性能。在PANDA模型中,张量核范数被用来作为正则化项,以促进不同视图之间的一致性和互补性。

3 提出的方法

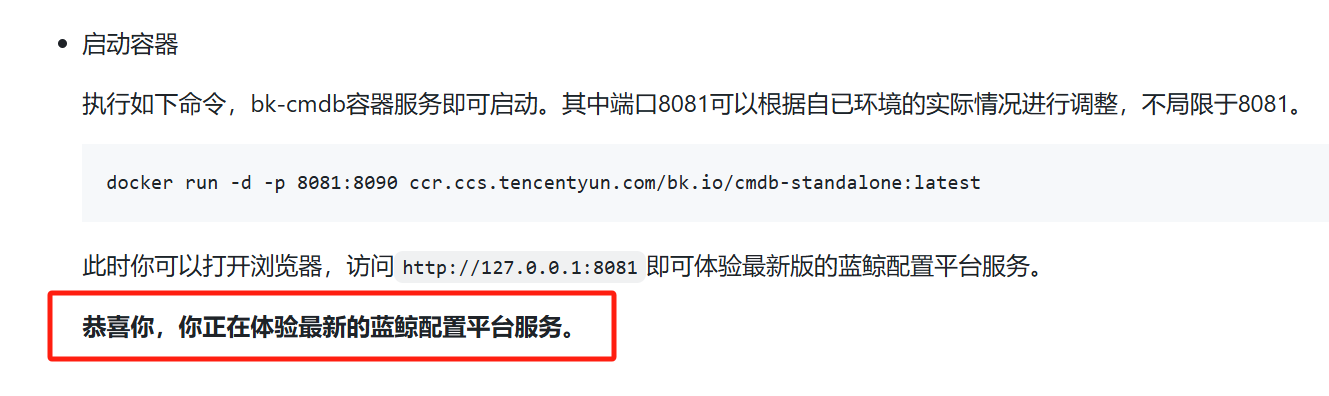

图1:PANDA模型的示意图。PANDA首先基于数据点之间的欧几里得距离构建多个视图特定的空间相似性图。随后,从欧几里得结构中提取多个拓扑流形,并将其重新组织成一个低秩3-D张量。此外,我们采用精细的张量Sigmoid函数作为张量秩最小化的更紧密的近似,从而便于探索张量数据中不同奇异值的显著信息。同时,多个拓扑结构以不同的权重合并成一个共识结构,使得视图之间的显著差异性和目标图的显式聚类结构得到有效利用。

3.1PANDA模型

给定一个多视图数据集\(\{X^{(v)}\}_{v=1}^{m}\),其中包含\(m\)个视图和\(n\)个个体,\(X^{(v)}\in \mathbb{R}^{n\times d_{v}}\)表示第\(v\)个视图的特征矩阵,\(d_{v}\)是相应的特征维度。亲和性导向的多视图聚类(AMVC)旨在利用多个特征中包含的丰富信息来学习一个有信息量的共识亲和矩阵,从而促进将数据点划分为不同的子簇。AMVC过程的广义数学表示如下:

公式(2):

- 目标函数包括两个主要部分:计算视图特定的亲和矩阵 \(\mathcal{L}(X^{(v)}, Z^{(v)})\) 和将多个视图的亲和矩阵 \(\{Z^{(v)}\}_{v=1}^{m}\) 合并到统一结构 \(U\) 中的项 \(\xi^{(v)}\|Z^{(v)}-U\|_{F}^{2}\)。

- 正则化项 \(\beta\|U\|_{\Theta}\) 用于对共识亲和矩阵 \(U\) 施加结构化惩罚,其中 \(\Theta\) 可以是 \(\ell_{0}\), \(\ell_{1}\), \(\ell_{2}\) 或核范数,以实现亲和矩阵的不同属性,如稀疏性和连通性,用于控制模型的复杂度。

- 权重 \(\xi^{(v)}\) 用于在合并过程中为不同的视图分配权重。

其中,\(\mathcal{L}(X^{(v)}, Z^{(v)})\) 表示第 v 个视图的损失函数,衡量第v个视图中数据点与亲和矩阵之间的一致性或相似性,\(\xi^{(v)}\) 是正则化参数,\(\|Z^{(v)}-U\|_{F}^{2}\) 是第 v 个视图的特征矩阵与共识亲和矩阵之间的Frobenius范数差的平方,\(\beta\) 是正则化参数,\(\|U\|_{\Theta}\) 是共识亲和矩阵的核范数,用于控制模型的复杂度。约束条件确保了每个数据点的亲和度之和为1,且亲和度非负。

在多视图聚类(AMVC)的背景下,\(Z^{(v)} \in \mathbb{R}^{n \times n}\)和\(U \in \mathbb{R}^{n \times n}\)分别表示第 v 个视图特定的亲和矩阵和所有视图的共识亲和矩阵,共识亲和矩阵的目的是整合所有视图的信息。\(\beta\)是一个权衡参数。\(\mathcal{L}(X^{(v)}, Z^{(v)})\)负责计算视图特定的亲和矩阵。第二项将来自多个视图的亲和矩阵\((Z^{(v)})_{v=1}^{m}\)融合成一个统一的结构\(U\),有效地利用了多视图数据中固有的丰富信息。在这种情况下,\(\xi^{(v)}\)表示在融合过程中赋予第 v 个视图的权重,用于在共识亲和矩阵 U的构建过程中调整该视图的影响力。最终的正则化项包括对共识亲和矩阵施加的结构化惩罚,不同的\(\Theta\)选择(包括\(l_0\)、\(l_1\)、\(l_2\)或核范数)导致亲和矩阵具有不同的属性,如稀疏性和连通性。

为了减轻权重分配过程中参数调整的负担,我们采用逆矩阵策略来动态地为不同视图分配权重,这可以数学表达如下:

公式 (3) 的核心思想是,如果第 v个视图的亲和矩阵与当前的共识亲和矩阵 U之间的差异较大,那么应该给予这个视图更大的权重,以便在构建共识亲和矩阵时更加重视这个视图的信息。相反,如果差异较小,那么这个视图的权重会较小,意味着在构建共识亲和矩阵时对这个视图的依赖性降低。

通过使用方程 (3) 中概述的权重分配方案优化方程 (2),可以获得一个有效整合了来自多个视图的有价值信息的共识亲和矩阵\(U\)。尽管如此,模型 (2) 只考虑了成对样本相关性和成对视图相关性,忽略了多个视图之间的高阶相关性,从而限制了对多视图中嵌入的丰富信息的探索。鉴于此,出现了一种有效的策略:将多个视图特定的亲和矩阵聚合并重构为一个具有低秩结构的三维张量。这种战略性的融合提供了一种深入挖掘多特征中固有的高阶相关性的方法,从而有助于提高聚类性能。因此,改进的基于张量的亲和性导向的多视图聚类模型采取以下形式:

其中\(\mathcal I \in \mathbb{R}^{n \times m \times n}\)表示通过堆叠多个视图特定的亲和矩阵形成的三维张量,\(\psi()\)是张量化操作符,\(\|\cdot\|_{\Theta}\)表示张量核范数(TNN),用于保持张量数据中固有的低秩属性。

公式(4):

-

公式(4)与公式(2)类似,但增加了一个张量核范数(TNN)项 \(\beta\|\mathcal I\|_{\circledast}\),用于保持张量数据的低秩属性。

-

引入了一个三维张量 \(Z \in \mathbb{R}^{n \times m \times n}\),通过堆叠多个视图特定的亲和矩阵形成,并通过张量化算子 \(\psi(\cdot)\) 进行处理。

-

约束条件中增加了 \(\xi^{(v)} \geq 0\) 和 \(\mathcal{I}= \psi(Z^{(1)}, Z^{(2)}, \ldots, Z^{(m)})\),确保权重非负且张量由视图特定的亲和矩阵构成。

-

在公式(2)中,正则化项 \(\beta\|U\|_{\Theta}\) 用于对共识亲和矩阵 \(U\) 施加结构化惩罚,其中 \(\Theta\) 可以是 \(\ell_{0}\), \(\ell_{1}\), \(\ell_{2}\) 或核范数,以实现亲和矩阵的不同属性,如稀疏性和连通性。公式(2)侧重于通过权重分配来整合不同视图的信息。

-

公式(4)中,正则化项变为 \(\beta\|\mathcal{I}\|_{\circledast}\),这里使用的是张量核范数(TNN),即通过张量化算子 \(\psi(\cdot)\) 将多个视图特定的亲和矩阵堆叠成一个三维张量 \(\mathcal{I}\),用于保持张量数据的低秩属性,这有助于捕捉多视图数据中的高阶相关性。

总的来说,公式(4)在合并多个视图的亲和矩阵时,采用了更为复杂的张量结构和正则化策略,以更好地捕捉和利用多视图数据中的高阶相关性。而公式(2)则侧重于通过权重分配来整合不同视图的信息。

尽管模型 (4) 在捕捉多个视图下的高阶相关性方面表现出了有效性,但它在考虑数据点之间固有的拓扑连通性方面存在不足,这是高效聚类任务的一个关键方面。更具体地说,由于现实世界中数据集的固有特性,它们通常在高维空间中表现出嵌入的非线性低维流形结构,存在一个引人注目的假设,即个体之间的拓扑连接可以从邻近实体传播到远距离实体。换句话说,如果给定的数据点对显示出显著的欧几里得距离,同时保持共享邻居连接,它们应该仍然表现出强烈的相关性,并且很可能属于同一个簇。如图2所示,尽管节点1和5表现出显著的空间分离,但它们与节点3共享邻接性,从而产生了显著的拓扑相关性。这种共享邻居在节点1和5之间产生了相当大的拓扑相互依赖性,增强了连通性。相反,节点5和6表现出相反的情况,它们在空间位置上的接近性与由于缺乏共享邻近连接而产生的低拓扑亲和力形成对比。然而,这种关键的拓扑连通性关系在欧几里得空间结构中被忽视了,导致构建的三维张量的表示能力下降。因此,这种限制显著影响了聚类性能,产生了次优的结果。

为了解决上述数据点之间拓扑连通性探索不足的问题,我们放弃了传统欧几里得框架中用于捕捉数据点间相似性的度量方法。相反,我们利用从欧几里得空间结构中提取的拓扑流形来近似数据点之间的固有相似性。随后,将提取的多个拓扑流形组合并组织成一个3-D低秩张量,允许同时利用数据点之间的拓扑连通性和多个特征之间的高阶相关性。因此,可以构建一个增强的基于张量的拓扑驱动的多视图聚类(AMVC)数学模型,如下所示:

- 在公式(4)中,亲和矩阵 \(Z^{(v)}\) 是直接从数据中学习得到的,而没有明确提到拓扑流形的概念。

- 公式(5)引入了拓扑流形 \(A^{(v)}\) 的概念,其中 \(a_{ij}^{(v)}\) 编码了数据点之间的拓扑相关性。亲和矩阵 \(Z^{(v)}\) 与拓扑流形 \(A^{(v)}\) 之间的关系被明确地建模在目标函数中。

其中\(Z^{(v)} \in \mathbb{R}^{n \times n}\)表示第 v 个视图特定的亲和矩阵,它是由现成的局部结构化图学习范式生成的。\(A^{(v)} \in \mathbb{R}^{n \times n}\)表示第 v 个视图的拓扑相关性流形,其元素\(a_{ij}^{(v)}\)编码了第 i 个和第 j 个数据点之间的拓扑相关性。\(\mathcal{A} \in \mathbb{R}^{n \times m \times n}\)由多个提取的拓扑流形构成的三维张量。\(\alpha\)和\(\beta\)是两个权衡参数。方程 (5) 中的第一项作为一个平滑约束,与拓扑连通性相一致,确保当第 j 个和第 k 个数据点与第 i 个数据点表现出相似性时,它们与第\(i\)个数据点共享可比较的拓扑关系。第二项的加入是为了避免在流形\(A^{(v)}\)中获得平凡的解。

亲和矩阵和拓扑流形都可以用来描述数据点之间的关系,并且都可以用于聚类和降维任务中,以保持数据的内在结构:

- 亲和矩阵更侧重于描述数据点之间的相似性,而拓扑流形则侧重于描述数据点之间的拓扑关系。

- 亲和矩阵是通过学习过程得到的,可能包含更多的信息,如距离、角度等;拓扑流形则更抽象,主要关注数据点之间的连通性和邻接性。

- 在优化问题中,亲和矩阵 Z可能直接参与到目标函数中,而拓扑流形 A可能作为约束条件或先验知识来指导学习过程。

- 在实际应用中,亲和矩阵和拓扑流形可以相互补充,共同帮助模型更好地理解和处理数据的复杂结构。例如,在多视图聚类中,亲和矩阵可以捕捉视图特定的相似性,而拓扑流形可以提供跨视图的拓扑一致性

此外,为了减轻数据点与许多相似邻居之间的连接对目标值的潜在影响,使用了方程 (5) 的归一化版本,其被动公式如下:

其中\(D^{(v)}\)是\(Z^{(v)}\)的度矩阵。

到目前为止,我们已经构建了一个包含拓扑流形学习方案和张量低秩正则化机制的目标函数,这确保了数据点之间的拓扑连通性和多个视图下的高阶相关性可以同时有效探索。然而,当前模型仍然受到其依赖于等量缩小所有奇异值以恢复低秩张量的约束,这阻碍了有效发现异构奇异值之间的显著差异。主要原因在于张量数据中奇异值的固有特性,其中较大的和较小的奇异值通常分别携带主导的有价值信息和稀疏噪声信息。因此,对所有奇异值应用等量缩小策略会导致对较大值的过度惩罚和对较小值的惩罚不足,从而产生次优的张量表示。

鉴于此,本文开发了一种张量化精细Sigmoid秩(TRS)作为张量秩最小化的更紧密的近似(即, \(f(x) = \frac{x}{x + \exp(\frac{-x}{\delta})}\))。与传统张量核范数(TNN)方法中对不同奇异值采用的线性惩罚(即\(f(x) = x\))不同,TRS允许对大奇异值和小奇异值自适应地施加不同程度的惩罚,其定义如下:

定义2:对于给定的张量\(\mathcal{A} \in \mathbb{R}^{n_1 \times n_2 \times n_3}\),其张量细化Sigmoid秩(TRS)定义如下:

其中\(0 < \delta \leq 1, h = \min(n_1, n_2)\)。\(\mathcal{A}_f^k\)表示\(\mathcal{A}\)的第 k 个前切片,而 \(\mathcal{P}_f\)是通过张量-SVD分解(即,\(\mathcal{A} = O_f \mathcal{P}_f Q_f^{\top}\))得到的傅里叶域的表示。

通过将模型(6)中的张量核范数(TNN)替换为定义在方程(7)中的张量细化Sigmoid秩(TRS),我们可以有效地考虑张量数据中不同奇异值的重要性。这种方法有助于通过将模型(6)中的张量核范数(TNN)替换为在方程(7)中定义的张量细化Sigmoid秩(TRS),可以有效地考虑张量数据中不同奇异值的重要性。这种方法有助于促进创建一个有价值的共识亲和矩阵 \(U\)。结果,这个共识亲和矩阵作为后续聚类任务的基础。

在一个理想的情况下,如果亲和矩阵 \(U\) 中的连通分量等于真实的簇数量,可以直接从图矩阵的结构中获得聚类标签,从而避免了额外的图切割过程。巧合的是,通过在共识图的拉普拉斯矩阵上施加秩约束(即,\(\operatorname{rank}(L_{U})=n-c\))[38],可以实现这样的理想结构,其中 \(L_{U}\) 和 \(c\) 分别是拉普拉斯矩阵和簇的数量。此外,由于 \(L_{U}\) 的正半定性,秩约束问题可以重新表述为奇异值优化问题(即,\(\sum_{i=1}^{c}\omega_{i}(L_{U})=0\)),其中 \(\omega_{i}(U)\) 表示 \(L_{U}\) 的第 \(i\) 个最小的奇异值。根据Ky Fan定理[8],非凸奇异值优化问题可以进一步放松为以下凸问题:

公式(8)是一个优化问题,它的目标是最小化矩阵 \(P\) 的迹(即矩阵对角线元素之和),其中 \(P\) 是一个嵌入矩阵,\(L_U\) 是共识图的拉普拉斯矩阵。这个问题是从原始的奇异值优化问题中通过Ky Fan定理转换而来的,目的是在保持矩阵 \(P\) 的正交性(即 \(P^\top P = I\),其中 \(I\) 是单位矩阵)的约束下,找到一个最优的 \(P\)。

元素含义如下:

- \(\omega_{i}(L_{U})\) 表示拉普拉斯矩阵 \(L_{U}\) 的第 \(i\) 个最小的奇异值。

- \(c\) 是聚类的数量,也就是我们期望的连通分量的数量。

- \(P\) 是一个 \(n \times c\) 的嵌入矩阵,其中 \(n\) 是数据点的数量,\(c\) 是聚类的数量。这个矩阵的列向量代表了数据点在低维空间中的嵌入表示。

- \(P^\top P = I\) 是一个正交性约束,确保了嵌入向量之间是正交的,这有助于保持数据点之间的相对距离。

- \(\operatorname{Tr}(P^\top L_{U} P)\) 是矩阵 \(P^\top L_{U} P\) 的迹,即其对角线元素之和。

这个优化问题的目的是找到一个嵌入矩阵 \(P\),使得 \(L_{U}\) 的前 \(c\) 个最小的奇异值之和最小化。这等价于找到一个嵌入,使得数据点在低维空间中的表示能够尽可能地保持原始数据的聚类结构。通过最小化这个迹,实际上是在寻找一个嵌入,它能够捕捉到数据的聚类结构,同时减少不同聚类之间的干扰。

这种方法的一个关键优势是,它将原始的奇异值优化问题转化为一个凸优化问题,这使得问题更容易解决,并且解决方案更稳定。通过这种方式,可以在不需要进行额外图切割操作的情况下,直接从图矩阵的结构中获得聚类标签。

通过在一致性框架内整合方程(6)-(8),我们得到了PANDA模型的全面表述,如下所示:

其中\(\lambda\) 是一个自调整参数,其值决定了目标亲和矩阵 \(U\) 是否表现出 \(c\) 个连通分量[35]。技术上,如果连通分量的数量小于所需的数量 \(c\),我们增加 \(\lambda\),反之亦然。聚类的数量是已知的?

备注1:[张量细化Sigmoid秩(TRS)的好处] 本文开发了一个细化的Sigmoid函数作为张量秩函数的非凸替代。本质上,开发的TRS满足\(f_{TRS}(x)=0\),与真实的秩函数一致。为了清晰起见,图3展示了张量真实秩、两种常用的秩近似方法(即,TNN和LTSpN)以及我们的TRS之间的视觉比较。从图3可以看出,我们提出的TRS在近似张量秩方面优于TNN和LTSpN,特别是在接近零和大奇异值时。具体来说,当 x 接近零时,\(f_{TRS}(x) \gg x\)和 \(f_{TRS}(x) \gg f_{LTSpN}(x)\),表明对小奇异值有强烈的惩罚。这一观察突出了对噪声的鲁棒性,因为小奇异值通常来自噪声和异常值。相反,当 x 趋向于较大值时,\(f_{TRS}(x) \ll x\)和\(f_{TRS}(x) < f_{LTSpN}(x)\),表明保留了重要的大奇异值并最小化了对有价值信息的惩罚。

备注2:[拓扑流形的优势] 受基于传播的流形学习启发,PANDA模型采用了从欧几里得相似性图中提取的拓扑流形,而不是传统的欧几里得相似性图(即\(\{Z^{(v)}\}_{v=1}^{m}\))来近似数据点相似性。随后,这些提取的拓扑流形表示被聚合形成一个三维张量。如图2所示,利用拓扑流形打破了依赖于成对欧几里得距离的传统欧几里得结构的限制,巧妙地利用了数据点之间的固有拓扑相关性。这种亲和学习策略有效地捕捉了它们潜在的亲和关系,提高了精度,最终导致聚类性能的提高。