随着多种商业、开源的 LLM(大型语言模型)流行,越来越多的企业将人工智能整合到工作流中去,而这也对大模型的调用提出了新的要求。无论是在产品设计、后端开发还是数据分析方面的需求,LLM 和 GenAI (生成式人工智能)的应用都已成为企业保持竞争力的关键。

AI 技术的快速发展也带来了在同一项目中使用多个 LLM 的需求,企业会对不同 AI 的能力、性能、调用成本等等都会经过比较,以便在开发和生产阶段能够更加灵活切换不同的模型。因此,像 OpenAI、Anthropic、Google、Meta 和 Mistral 这些大模型会为用户和开发者提供了适用于各种应用场景的 API。

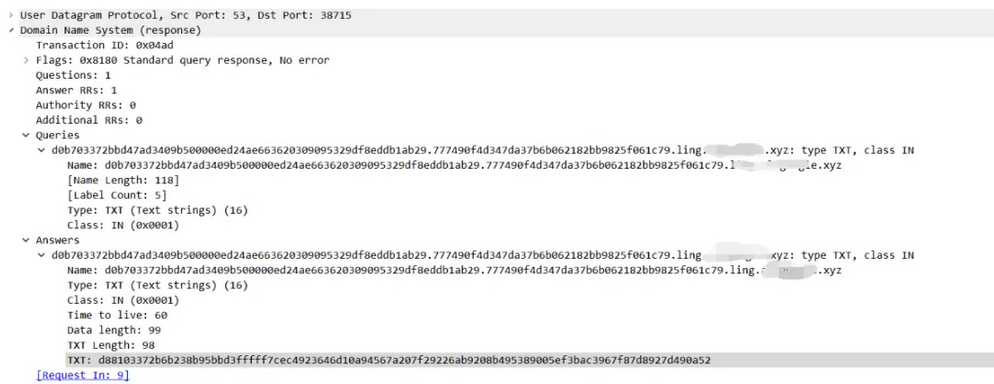

但是要集成和管理来自不同供应商的多种 LLM 并不是一件简单的事情,因为它们的 API 接口不是一样的:

当你需要在不同模型之间切换时,往往需要部署新版本的代码。也就是说你要需要了解每个 AI 供应商的 API,并具备一定的专业知识。那么随着市面上各种能力 LLM 越来越多,还有各种 AI Agent 也是层出不穷,显然这种接入方式不仅麻烦而且低效。这时候,为了给 AI 大模型的调用提供一个统一且简化的解决方案,LLM 网关或者说 AI 网关的概念就应运而生。

LLM 网关的诞生与发展与 LLM 的管理需求相伴相生

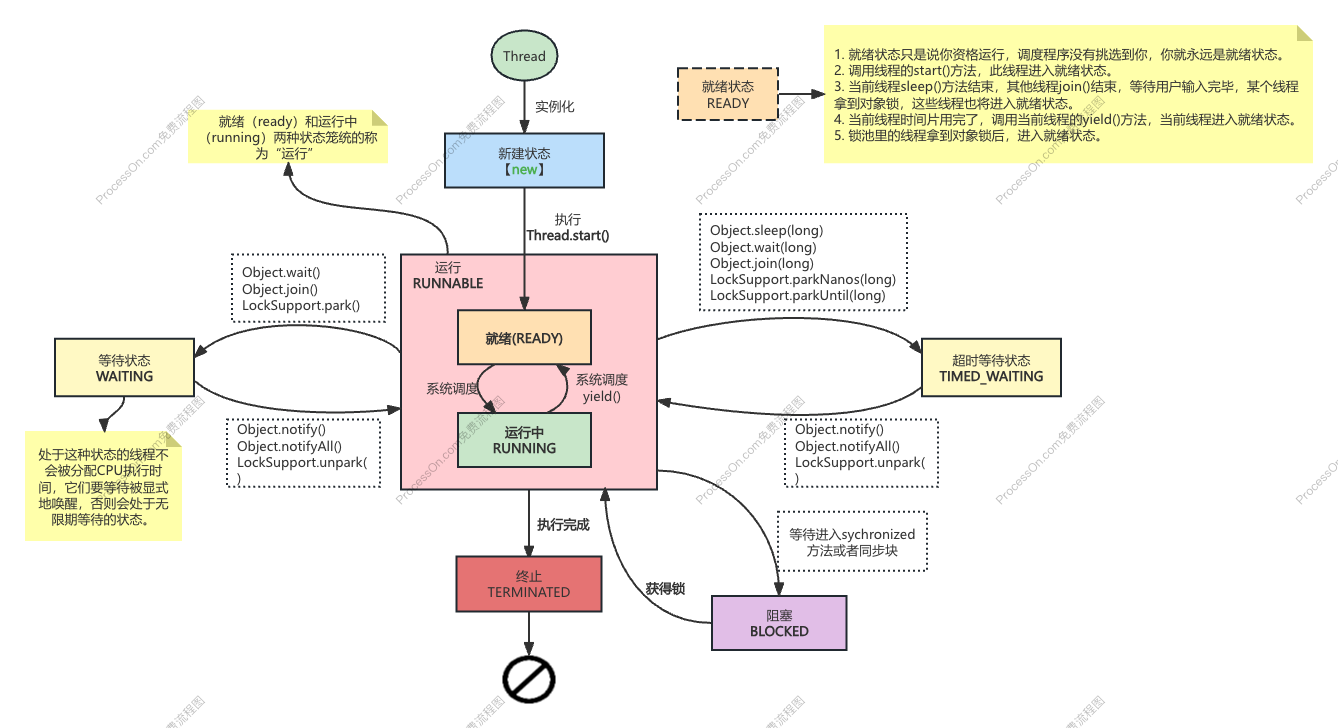

LLM 网关是一种中间件,主要负责将用户应用程序与各种 LLM 服务提供商相连接。简单来说 LLM 网关就像一个“服务中介”,接收应用程序的请求,并且对这些请求进行处理或批量操作,然后将它们发送到用户选择的 AI 大模型服务提供商。当大模型处理完毕后,网关会收集响应,并根据需要进行处理,最后将结果返回给用户。这套系统不仅简化了应用程序与多个大模型之间的通信,还集成了管理请求、优化性能和保障安全等多项任务,所有工作都能在一个平台上完成。

举个例子:如果你管理一个客服部门,想要同时运用 A、B和 C 三个大模型来回答客户的问题。如果没有 LLM 网关,你就需要单独接入每个大模型的 API,配置各自的请求方式、权限认证、成本监控等。开发人员不仅要学习不同大模型的使用方法,还要维护这些连接,这不仅耗时且容易出错。

有了 LLM 网关,开发人员只需要通过统一的接口发送请求。所有的请求和响应都会通过网关处理,团队只需关注一个系统,使用统一的认证信息,极大降低了管理成本。

此外,LLM 网关支持同时管理外部大模型 API(如 OpenAI、Google、AWS Bedrock)和内部大模型(如 Llama、Falcon,或公司自定义微调的模型)。不论是外部 API 还是自建模型,都可以通过网关进行统一管理和调用。未来如果需要新增其他大模型或业务功能,网关的架构让这些调整变得简单且高效。

LLM 网关的能力价值

LLM 网关的核心功能是确保应用程序和大模型之间的顺畅对接。无论是通过用户界面,还是软件开发工具包(SDK),LLM 网关都提供了安全、成本控制和性能优化等一站式服务,以"让开发者专注于业务逻辑的实现,无需过多担心底层的技术细节"。

对于 APIPark 的能力而言,我们的目标远不止于此

〇 连接 200+ LLM & Agent

APIPark 支持多款主流 AI 大模型,包括 OpenAI、Anthropic、AWS Bedrock、Google Gemini ... 无论内部调教的大模型还是外部大模型的 API,都可以轻松接入 APIPark 管理。

此外,APIPark 还支持将 API 服务无缝集成到各种 AI Agent 平台中。一键复制分享 API 服务的对外可读取文档详细信息的 URL,开发者则可轻松地将这些 API 服务导入到他们选择的 AI Agent 平台, 极大的扩展 Agent 的 API 资源。

〇 负载均衡

随着企业 AI 应用场景的不断扩大,如何高效管理和优化多实例部署的 AI 容量逐渐成为重点问题。

以 Azure OpenAI 为例,其通过吞吐量单元(PTU)分配容量,每个部署都有固定配额。当容量耗尽或性能下降时,如何快速调整而不影响服务,成为企业面临的难点。

通常情况下,管理员可以通过创建多个端点,分别管理不同区域或业务单元的容量。但要实现端点间的动态流量分配,必须依赖复杂的负载均衡机制。

APIPark 提供一个更灵活、自动化的系统来实现容量管理、区域流量调度及临时后端支持,确保 AI 系统的高可用性、低延迟与扩展能力,应对扩展的不确定性,还能确保流量灵活调度,降低业务连续性的风险。

多维度的 LLM 流量监控:

APIPark 提供实时可视化仪表盘,你可看到每个大模型的使用情况、哪个部门哪个API调用者的具体流量情况,让 LLM 的成本可视化。

Token 配额及模型调用优先级:

在 APIPark 上,你还可以为每个租户配置大模型流量配额,并优先分配特定大模型,确保资源分配更加高效合理。

应用场景:

1)按业务需求选择最适合的大模型

通过 LLM 网关,你可以根据不同业务需求,将请求灵活分配给最适合的大语言模型。

例如:撰写论文时选择 通义千问,研究类请求交由 秘塔搜索 处理,代码生成任务分配给 豆包大模型,而需要复杂推理时则使用 OpenAI 的 O1。

这种按需匹配的方式,可以充分发挥各大模型的特长,帮助团队更高效地完成任务。无论是文字处理、数据分析还是代码生成,都能实现精准对接,事半功倍。

2)按成本优先选择最划算的大模型

通过 LLM 网关,你还可以根据成本优化调用策略。

例如:当 A 模型 比 B 模型 调用成本高出 30%,但 A 模型 在前 6 个月享有免费优惠时,你可以设置优先调用 A 模型。优惠期结束后,网关会自动切换到 B 模型,以控制成本开支。

这种智能化的成本管理方式,不仅帮你节省预算,还免去了频繁手动调整的麻烦,让资源利用更加高效。

3)配置备用大模型确保业务不中断

在关键业务场景中,LLM 网关支持配置主模型和备用模型。

例如:比如你搭建了一个 SEO AI 写作场景,你需要每天保证 AI 写文不能中断,你可以优先使用 OpenAI 作为主力模型,同时设置 文心一言 或 通义千问 为备用。当 OpenAI 出现波动或故障时,网关会自动切换到备用模型,保证业务持续运行。

这种多模型备份机制,让你的系统具备更高的稳定性和容错能力,再多的不可控的故障事件都可以从用应对。

〇 语义缓存

语义缓存是 APIPark LLM 网关的重要功能之一。通过缓存语义相似的请求和对应的大模型响应,能够避免重复向大模型发送相似请求,为企业节省开销并提升用户体验。

借助 APIPark 提供智能语义缓存策略,企业不仅能够减少上游大模型调用的延迟,提升智能客服等服务的响应速度,并有效降低大模型资源的使用成本。

应用案例:

AI 客服如何借助语义缓存降低成本

某公司开发一款提升客户体验的 AI 客服机器人。在日常服务中,很多用户的沟通往往从一些简单的问候开始,例如:“你好、在吗、有人吗”。针对这些请求,系统通常会给出固定的回复,比如:“你好!有什么可以帮您的吗?”

尽管这类交互看似简单,但对于需要处理海量用户请求的企业来说,其成本会迅速累积。

以 ChatGPT 为例,每次“你好”请求消耗 1 个token,而 AI 模型的默认回复需要 9 个tokens,总的合计每次互动就要 10 个tokens。但如果一个企业组织每年处理 10 亿次这样的请求,成本就会达到近 10 万刀之多。

由于大部分用户发送的初始内容和收到的回复基本一致,企业完全可以将这些常见对话缓存下来,无需每次重新调用模型生成。假设缓存命中率达到 100%,而且存档没有过期,无疑每年节省的成本都是巨大的。

〇 Prompt 管理与数据防护

APIPark 实现了大模型 API 与 Prompt 的有机融合,以往企业调用 AI 过程中,涉及到 Prompt 提示词都是采用硬编码的形式写在系统中。

在 APIPart 上你可以对每个 LLM API 的 Prompt 独立管理,你可以将 Prompt 提示词和 AI 模型组合成自定义的 AI API ,APIark 还支持一键发布到 API 门户上供大家订阅。

目前 APIPark 借助正则表达式和字符匹配已经为企业用户实现了基本的数据脱敏,后面,APIPark 将持续探索基于微调的小型语言模型用于检测、清理清除敏感数据。借助 AI 模型动态分析输入,识别出微妙或模糊化的个人身份信息。实现数据的分层处理,这样不仅保护了用户数据,还确保 AI 系统在合规和安全标准内运行,为企业避免了不必要的风险和成本。

此外,APIPark 还会进一步健全基于 Prompt 提供敏感信息防护保护功能。将在网关层实现支持对 Prompt 的增强管控,无需修改底层代码,安全部门和研发团队即可通过预设或附加方式灵活配置业务 Prompt。

这样不仅保护了用户数据,还确保 AI 系统在合规和安全标准内运行,为企业避免了不必要的风险和成本。例如,安全团队可以简单灵活地设置系统级规则:“如涉及企业财务、个人信息,请回复:抱歉,我无法提供相关数据。”

以上,是 APIPark LLM 网关能力全面的基本构想,APIPark 开源项目还在火热迭代中!

如果您也对 APIPark 未来的功能感兴趣,并有意向参与我们项目的开源共建,请登录 APIPark Github 仓 给我们开源团队提出您宝贵的建议!