AWQ:激活-软件权重量化

大型语言模型(LLM)已经改变了许多人工智能应用程序。设备上的LLM变得越来越重要:在边缘设备上本地运行LLM,可以降低云计算成本并保护用户隐私。然而,天文模型的大小和有限的硬件资源带来了巨大的部署挑战。提出了激活感知权重量化(AWQ),这是一种硬件友好的LLM低比特权重量化方法。AWQ认为,并非LLM中的所有权重都同等重要。仅保护1%的显著权重可以大大减少量化误差。为了识别显著的权重通道,应该参考激活分布,而不是权重。为了避免硬件低效的混合精度量化,从数学上推导出,扩大显著通道可以减少量化误差。AWQ采用等效变换来缩放显著权重通道以保护它们。规模是通过收集罚款的激活统计数据来确定的。AWQ不依赖于任何反向传播或重建,因此它可以推广到不同的领域和模态,而不会对校准集进行过度偏移。AWQ在各种语言建模和领域特定基准(编码和数学)方面的表现优于现有工作。幸亏了更好的泛化能力,它为指令调谐的LM和首次多模态LM,实现了出色的量化性能。除了AWQ,还实现了TinyChat,这是一个为4位设备上LLM/VLM量身定制的高效灵活的推理框架。通过内核融合和平台感知的权重打包,TinyChat在台式机和移动GPU上的速度比Huggingface FP16实现快3倍以上。同时完成了70B Llama-2模型在移动GPU上的部署。

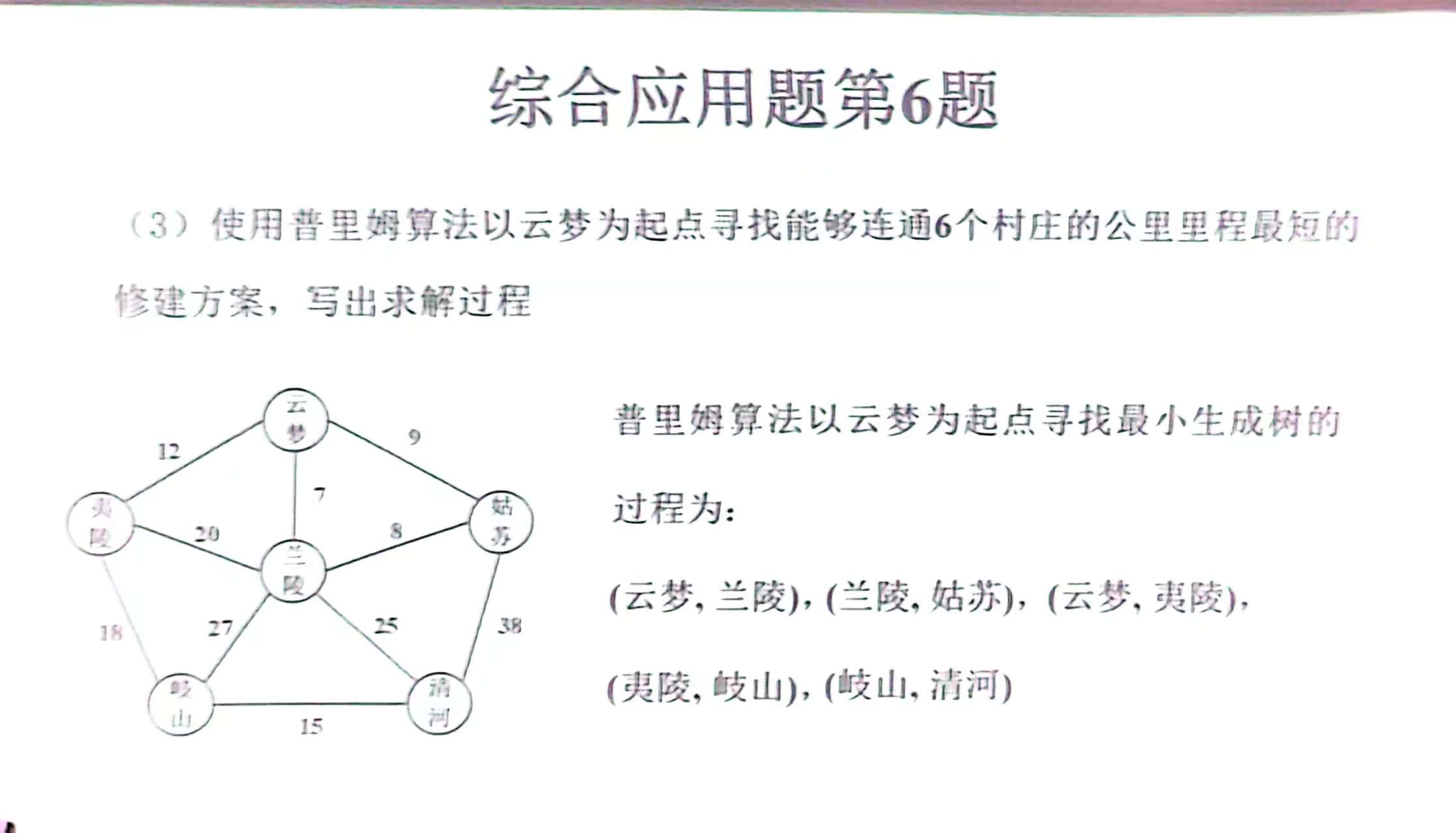

基于激活分布(中间),可以在LM中找出1%的显著权重,如图5-1所示。

图5-1 基于激活分布(中间),可以在LM中找出1%的显著权重

在图5-1中,保留FP16中的显著权重可以显著提高量化性能(PPL从43.2(左)提高到13.0(中)),但混合精度格式不利于硬件。遵循激活意识原则,提出了AWQ(右)。AWQ执行信道缩放,以保护显著权重并减少量化误差。测量了OPT-6.7B在INT3-g128量化下的困惑度。

与RTN和GPTQ相比,AWQ持续提高了量化性能,显示出对指令调优模型的泛化能力。与GPTQ相比,校准集小10倍。右:方法对校准集分布更稳健。总体而言,使用相同的校准和评估分布效果最好。但当使用不同的校准分布时,AWQ仅将困惑度增加了0.5-0.6,而GPTQ的困惑度则降低了2.3-4.9。所有实验均在INT3-g128量化下,用OPT-6.7B模型完成。还支持各种通用和编码特定的LLM,其速度至少是AutoGPTQ的2.6倍,AutoGTQ也支持所有这些工作负载。此外,TinyChat在Raspberry Pi上无缝运行,最多可部署7个LLM在资源极其有限的物联网设备上,有10亿个参数。

在这项工作中,提出了激活感知权重量化(AWQ),这是一种简单而有效的低比特权重LLM压缩方法。基于权重在LLM中并不同等重要的观察,AWQ执行信道缩放以减少显著权重的量化损失。AWQ不会对校准集进行过fft运算,并保留了LLM在各种领域和模态中的泛化能力。它的表现优于现有的工作语言建模,适用于指令调优的LM和多模态LM。TinyChat系统将AWQ实现的理论内存节省,转化为比桌面和移动GPU上Huggingface的FP16实现高3.2-3.3倍的测量加速,完成边缘的LLM部署。

AWQ方法概述,模型用S槽模型近似输入点云X,如图5-2所示。

图5-2 AWQ方法概述,模型用S槽模型近似输入点云X

在图5-2中,每个槽将X映射到仿射3D变形

、槽激活概率αs和被激活槽的联合概率

,并选择K个可学习的原型点云

中的一个。通过将变换

应用于其最可能的原型,获得激活槽s的输出

。未激活的插槽对输出没有贡献。引入了一种新的无监督方法,使用一小部分学习到的原型形状,将复杂的现实世界航空扫描解析为简单的部分。在一个新的航空激光雷达扫描数据集上,展示了结果的质量和可解释性。第一个证明在如此具有挑战性的现实世界数据集上,进行深度无监督3D形状分析。研究结果为计算机辅助环境监测和经济情报开辟了新的前景。

![VbaCompiler 1.6.4 注册分析[1]](https://img2023.cnblogs.com/blog/1145982/202412/1145982-20241219003311636-507062330.png)