图片由Gabriel Sollmann提供,来源于Unsplash

前言:在人工智能快速发展的时代,AI正在从协助工具向独立内容生产者转变,甚至进入科学研究领域。然而,AI在科学写作中的能力是否足以胜任?作者通过一系列案例,揭示了AI生成内容在科学期刊中的泛滥,以及由此引发的编辑困境和学术信任危机。与此同时,他反思了AI在阅读和分析科学文本中的失败尝试,尤其是欧盟“Horizon Europe”计划的惨痛教训。文章不仅指出AI在科学写作和评估创新性上的局限性,也强调了科学创新与机器学习本质上的矛盾:AI的能力建立在已有数据的模仿与整合之上,而创新却需要超越现有框架的突破。通过这些反思,作者让我们看清一个现实——AI或许能模仿人类的思维,但距离理解科学创新的深度和复杂性,仍有一段难以逾越的鸿沟。

你刚在某篇期刊文章中读到的科学结论是否完全是无稽之谈?本周《科学》杂志的一篇新闻报道揭示了,在一些医学期刊中出现的大量文章,答案是明确的“是”。由Retraction Watch的Frederik Joelving撰写的这篇报道(Retraction Watch是一个追踪和报告科学出版物中的不端行为,包括数据操控的项目)描述了许多被刊登在合法医学期刊中的评论文章并非由研究人员撰写,而是由AI生成的。报道中的作者通过一封匿名邮件获悉,在某一单一医学期刊中,三名作者在八周内发表了69篇评论,这些评论似乎是由AI生成的不真实内容。Retraction Watch发现,在某一特定期刊的投稿中,评论文章已经占了一半,而非实证研究或综述论文;而在另一个期刊中,这些文章占比达到70%。这些投稿变得如此泛滥,以至于某个期刊《神经外科评论》(Neurosurgical Review)向研究界宣布,全面暂停接受编辑信和评论文章的投稿。

现在看来,AI目前尚无法撰写真正的科学论文。但,也许它至少可以阅读这些论文?这样一来,或许可以帮助全球的编辑们识别出真实、原创的写作和思考?

当然,第一个需要提出的问题是:谁在阅读和审核这些文章?AI生成的稿件怎么可能通过编辑的审核?答案并不是AI已经强大到能够欺骗经验丰富的科学家。根据举报邮件的内容,这些人工文本可以被识别出来。作为一名科学写作者,我可以补充道,经验丰富的科学文章读者能够迅速察觉到AI生成的部分。然而,由于评论文章不需要经过同行评审,新的报道揭示了一种现实:某些编辑显然并未完整阅读他们发表的某些文章(而且几乎没有科学家——如果有的话——会费心去阅读评论文章)。在指责编辑之前,我们应该考虑这些编辑收到的大量评论文章。一些编辑可能会选择阅读直到找到一篇有趣的文章,而忽略其余的——这是一种可以接受的方法;而另一些人可能觉得有义务至少浏览所有的投稿,以示对作者及其努力的尊重,而这可能使他们更容易陷入AI的陷阱。

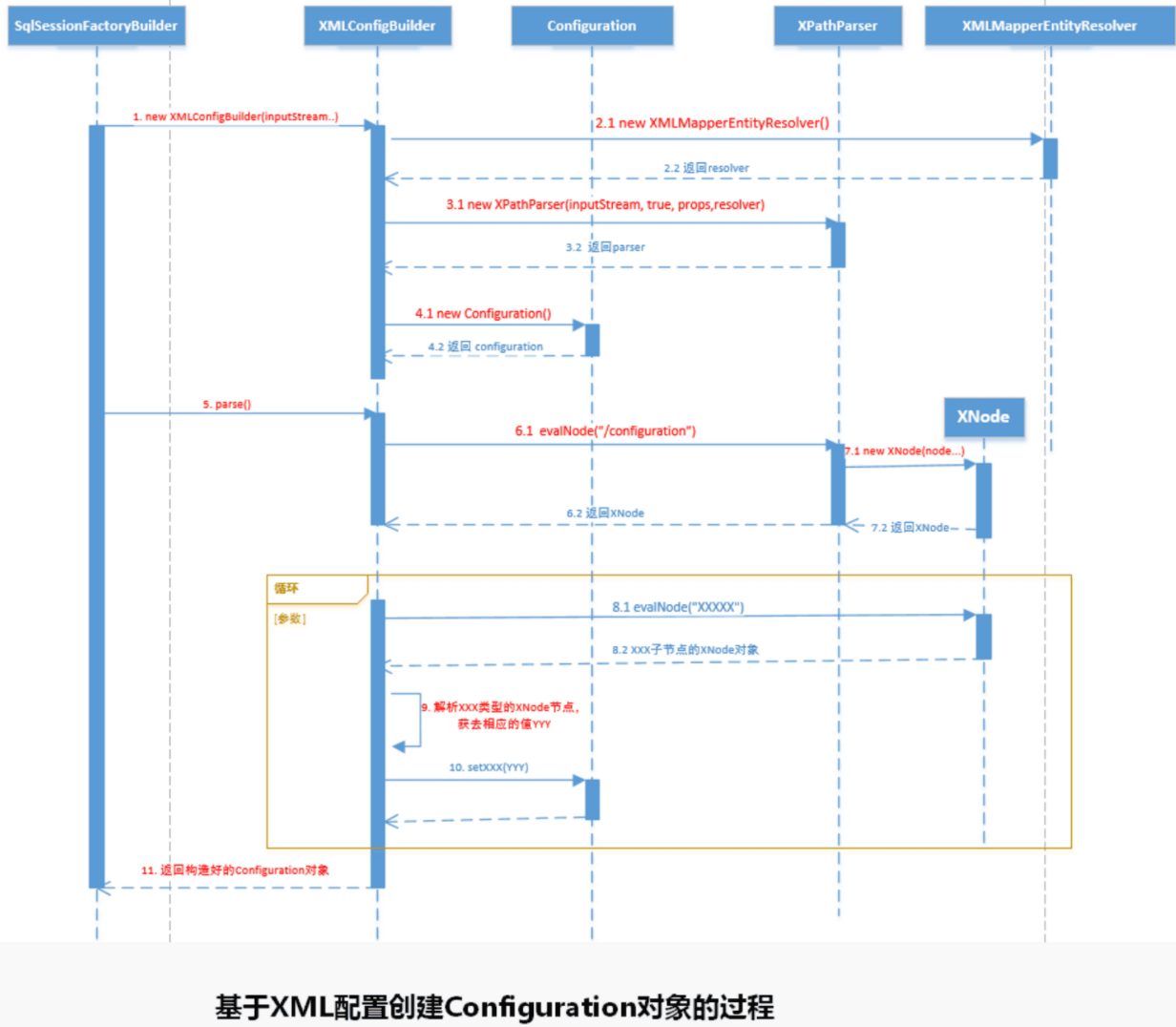

不过,现在很清楚的是,AI目前尚无法撰写科学论文。但,也许它至少可以阅读这些论文?这样一来,它或许能够帮助编辑们识别出真正的原创性写作和思考?在《科学》和Retraction Watch的报道发布的同一周,《自然》披露了一些有望实现这一目标的尝试。《自然》报道称,一家名为DeSci Labs的瑞士公司(其名字融合了“去中心化”和“科学”这两个词)开发了一种系统,用于为提交期刊的稿件分配新颖性评分,并将其提供给出版商。根据《自然》援引开发者的说法,“这种评分可以帮助期刊编辑决定哪些研究值得发表”,其算法通过比较科学稿件中的关键词和引用的期刊组合来实现。《自然》披露称,该算法首次出现在2023年9月arXiv平台上的一篇论文中,自那以来已对5000万篇稿件进行了评分。然而,编辑们是否真的能够利用这一新方法来识别新颖性和原创性、从而排除AI撰写的文本,这一点完全不确定;而且,这个问题是否能通过技术解决方案来解决,也并不明显。

对于科学来说,这个问题可能比技术障碍更深层次,也许不是通过足够的计算能力最终能够解决的。

2023年记录的一次重大失败展示了AI和算法在解读科学文本方面的局限性,这让欧洲大吃一惊。当时,欧洲最大的研发资助机构——EU的“Horizon Europe”计划,试图完全依赖AI来审查其新技术资助项目“加速器”(Accelerator)的提案。这一尝试开始于2021年4月,欧盟的声明宣称,AI的“天文级能力”可以让系统将任何研究想法与庞大的知识库进行比较,以量化创新性。据称,该系统可将拟议研究与“1.8亿篇科学出版物”和“1.2亿项专利文件”进行比对。然而,事情并不顺利。仅仅两年后,在2023年6月2日,AI系统被紧急下线,欧盟通知申请人,整个评审流程将回归人类同行审阅。

这一失败并不令人意外。许多开发者和科学家认为,强迫申请者将创新性的科学技术想法拆分为百余个小段并提交给AI系统,本身就反映了AI在解读自然科学语言方面的不足。这种处理模式明显体现了AI在理解科学创新上存在的根本障碍。

或许,正是AI对自然科学语言的无力解读,能够拯救编辑和读者?然而,问题是,即使像《自然》提到的勇敢尝试,正如欧盟失败的案例所示,AI在阅读真实科学文本方面非常糟糕,而要用算法量化人类创新概念的尝试,则可能是对机器和人类意识界限的戏剧性展现。

未来科学的方向,可能不是让机器去解读,而是让人类通过理解“荒谬”来发现真相。