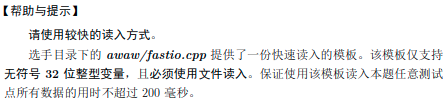

以下是一篇以纯HTML形式创建的文章,名为“用简单例子理解前沿科技:流数据处理”。为了增强可读性和排版,我们将适当插入了一些CSS类。

用简单例子理解前沿科技:流数据处理

在当今信息时代,海量的原始数据持续以超高速度生成。这些数据不仅来源于日常应用如社交媒体、传感器网络,更来自工业制造和医疗保健等领域的实时活动。要从这股“信息洪流”中提炼有价值的信息,并用于决策和改进,我们需要高效的处理机制,其中关键的是流数据处理

概念:何为流数据?

在计算机科学领域,“流数据”通常指的是那些以持续且不可预知的速度产生和到达的数据集。例如,在社交媒体平台上,每分钟有无数的新帖子被发布;或者,一个工业制造车间的机器设备可能每秒收集数千次传感器数据。与静止数据集相比,这类数据集具有三个核心特点:流式、高速率、实时性。

关键特性:理解挑战和机遇

- 数据连续性和高流量:在实际应用中,流式数据的处理要求能够连续、无停顿地接收信息。

- 实时决策需求:这类数据用于支持即时决策的情况越来越多。比如,预测模型需要实时更新来提供当前或未来趋势的信息。

- 适应性挑战:处理流式数据的技术必须能够适应不同规模的数据流量变化,并对新出现的模式做出响应。

解决方案:流处理工具与算法

为了有效管理和分析流式数据,科技界发展出了一系列工具和框架,其中较为著名的是Apache Kafka, Apache Storm或Apache Flink。这些系统采用分布式、并行处理方法来减少延迟和提升处理能力。

- Apache Kafka: 主要用于高吞吐量的实时数据流的处理,并以高容错性著称。

- Airflow and Spark Streaming: 常见于构建基于事件驱动的应用或在数据管道中集成各种服务和工具。

实践应用案例

一个实际的例子是金融行业,尤其是交易市场。在股市波动的环境中,流式数据处理帮助即时分析大量买卖信息,并提供实时策略反馈或决策支持。另一个例子是在社交网络上进行的情感分析,在快速响应用户行为、调整产品定位或者检测潜在的公关危机方面起着关键作用。

此代码提供了一种创建长篇文档的方法,虽然其包含的基本是文章元素而非完全完整的可操作内容(如数据库或实时数据分析工具的应用实例),但它遵循HTML5语法规则并使用了基本的CSS进行格式化。请注意,在实际网站中部署这类结构时,您通常需要更多客户端脚本代码来使功能完全运行,以及可能还需要服务端处理和数据API来提供文章中所涉及的具体技术实现和应用详情。 本栏目所用的所有开源软件及开源项目均来源于国内最大的公益性开源软件平台,大家有空可以去尝试一些,没有广告、免费,体验感很棒。

![[cause]: TypeError: e_.createContext is not a function (Next.js 15)](http://i.creativecommons.org/l/by-nc/2.5/cn/88x31.png)