在 Python 爬虫开发过程中,"补环境"通常指的是确保你的爬虫具备所有必要的配置和依赖,以便能够成功地访问和解析目标网站。以下是一些常见的情况,以及如何补全环境的方法:

### 1. 网站需要特定的 User-Agent

如果网站根据 User-Agent 来限制爬虫访问,你需要设置一个常见的浏览器 User-Agent。

```python

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

```

### 2. 网站内容通过 JavaScript 动态加载

如果网站内容是通过 JavaScript 动态生成的,你可能需要使用 Selenium 或 Playwright 来模拟浏览器环境。

```python

from selenium import webdriver

driver = webdriver.Chrome()

driver.get('https://example.com')

```

### 3. 网站有反爬虫机制,如验证码

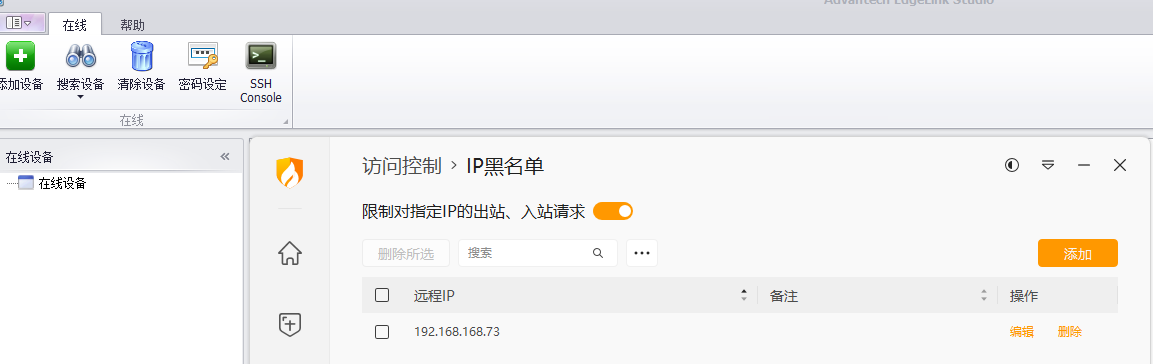

如果网站有验证码或其他反爬虫机制,你可能需要使用第三方服务来解决验证码,或者使用代理和旋转 IP 来避免被封。

```python

proxies = {

'http': 'http://proxy_ip:port',

'https': 'https://proxy_ip:port'

}

```

### 4. 网站需要登录

如果网站内容需要登录后才能访问,你需要先登录获取 cookies,然后在请求中携带这些 cookies。

```python

session = requests.Session()

login_url = 'https://example.com/login'

data = {'username': 'your_username', 'password': 'your_password'}

session.post(login_url, data=data)

# 后续请求携带 cookies

response = session.get('https://example.com/protected_page')

```

### 5. 网站有请求频率限制

如果网站对请求频率有限制,你需要在请求之间添加延迟。

```python

import time

time.sleep(1) # 等待1秒

```

### 6. 网站使用 HTTPS 且证书有问题

如果网站使用 HTTPS 但证书有问题,你可能需要在请求时忽略 SSL 证书验证(不推荐,因为这会降低安全性)。

```python

response = requests.get('https://example.com', verify=False)

```

### 7. 网站需要特定的请求头

如果网站需要特定的请求头(如 Referer、Origin 等),你需要在请求中添加这些头信息。

```python

headers = {

'Referer': 'https://example.com',

'Origin': 'https://example.com'

}

response = requests.get('https://example.com', headers=headers)

```

### 8. 网站内容依赖于浏览器的 JavaScript 特性

如果网站内容依赖于浏览器的 JavaScript 特性,如 WebAssembly 或特定的 API,你可能需要使用 Selenium 或 Playwright 来模拟这些特性。

### 9. 网站对爬虫有特定的要求

如果网站在 `robots.txt` 文件中对爬虫有特定的要求,或者有其他的使用条款,你需要遵守这些要求。

### 10. 使用代理服务器

如果由于地理位置限制或需要隐藏你的真实 IP,你可能需要使用代理服务器。

```python

proxies = {

'http': 'http://your_proxy:port',

'https': 'https://your_proxy:port'

}

response = requests.get('https://example.com', proxies=proxies)

```

补环境的目的是为了确保你的爬虫能够模拟真实用户的浏览器行为,避免被目标网站识别和封锁,同时也要遵守目标网站的使用条款和法律法规。