为什么人工智能会导致更大的社会不平等……至少在开始时如此

一次巨大变革的不对称性

来源:作者使用GPT-4o撰写

虽然每一次技术革命都创造了比毁掉的工作岗位更多的就业机会,人工智能也不会例外。然而,我们正迎来向那个世界转变的一个极其复杂的阶段。

简单来说,未来几年人工智能的发展,很可能变成一个“付费即胜利”的游戏,那些能接触到最先进工具的人,将对无法获得这些工具的人占据压倒性的优势。

这一点现在可能很难理解,所以让我来讲清楚过去几周一直让我忧心忡忡的恐惧。

智力的代价

虽然人工智能多年来一直在稳步进步,但 ChatGPT 的出现却让我们全体突然进入了一个新的世界,而这个世界才刚刚开始成形。

LRM:关键的三字母缩写

当 ChatGPT 发布时,它让大多数社会群体接触到了一个尽管已经存在但几乎无人知晓的术语:LLM,即大型语言模型。这是一种人工智能模型,可以接收一串文字作为输入并生成该输入的延续。

使用LLM确实在一定程度上给用户带来了一些优势,例如大学生用它来改进作业。但很快,是否能利用这些工具更多取决于你是否快速接受这些技术,因为它们对普通预算来说一直相当易得。

此外,其有用性往往被夸大了。它们确实可以加快一些任务的完成,但并不是能让使用者对非AI用户占据压倒性优势的工具。

再者,其成本已下降了几个数量级,以至于技术较为精通的人甚至可以在自己的电脑上免费运行强大的模型。

换句话说,LLM更多是一个“好奇即胜利”的游戏,而不是富人的专属。但我担心,2025年将标志着一个转折点,仅有好奇心已不足以从这些工具中受益。取而代之的是,你将需要钱——很多钱。

其背后的原因在于LLM的下一次演变:LRM。这个鲜为人知的缩写,彻底改变了游戏——和规则。

当智能成为奢侈品

我特意聚焦于文本模型,因为目前大多数LRM(如果不是全部的话)并不具有多模态能力(处理并特别是生成文本以外的内容)。这些模型对社会的影响也是最大的,所以以下论点仍然成立。

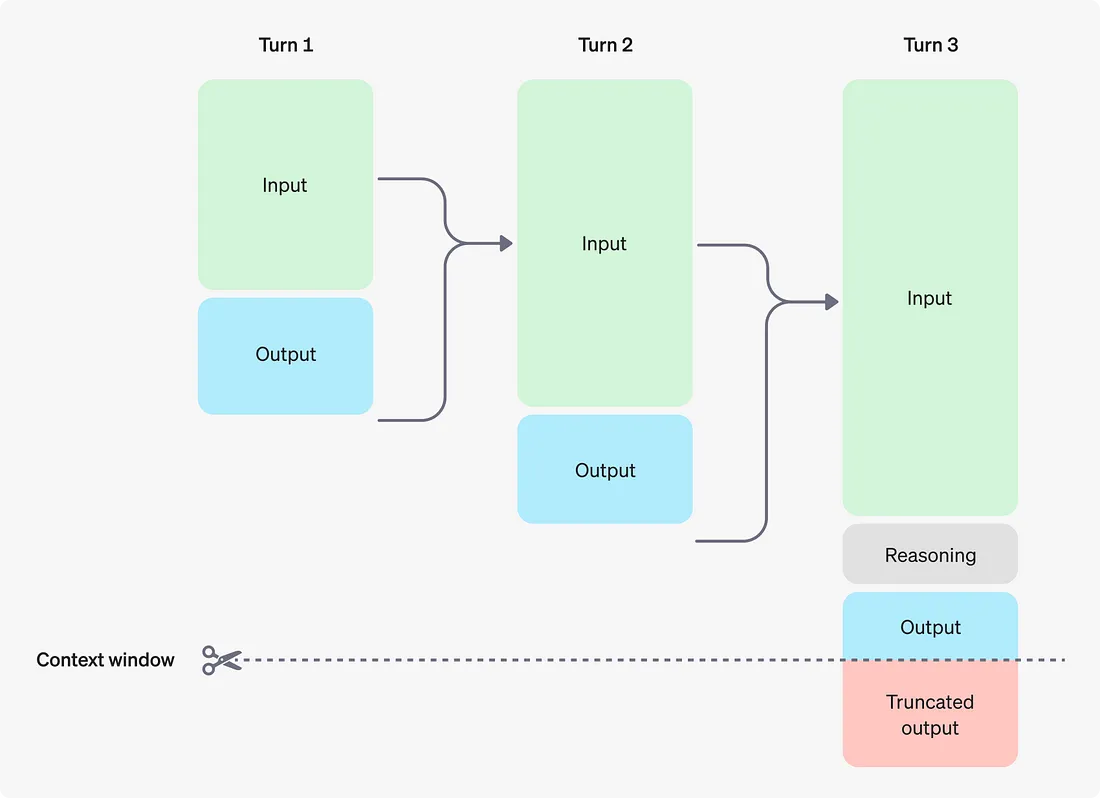

大型推理模型(LRM)表面上与LLM的作用非常相似:它们接收一串文本输入,并返回一个响应。但关键的区别在于其处理方式。

LLM生成答案的过程可以类比于人类的直觉:快速、自动、几乎是“本能的”,非常适合处理那些人类无需思考或推理就能完成的任务,比如喊出你最好的朋友的名字、唱你最喜欢的歌,或者简单地行走;这些任务无需调用人类的意识。

这也解释了为什么LLM在需要推理的任务(例如数学)上通常表现糟糕。因为此类任务通常需要两个关键方面:

-

探索:人类在面对困难任务时,会探索解决问题的多种方法。

-

时间:思考时间越长,获得正确答案的概率越大。

这两个新因素带来了一个简单易懂的结果:LLM需要“更长时间地‘思考’”。

不管你是否认为人工智能真的“思考”或只是“模拟思考”,这个问题尚未有定论,其真相取决于观察者的主观看法。但为了讨论本文的内容,输出无论如何都是一种思考响应。

因此,LRM就是将这种思考能力嵌入LLM的愿景的实现。虽然探索功能在很大程度上仍在研发中,并且主要存在于研究领域,但LRM的主要特征在于它们“思考得更久”。

这种对任务“更久的思考”通常以思维链的形式表现出来,即LLM生成一系列相连的思维链条,类似于人类通过多步骤方法解决复杂问题的过程。

虽然这自然提高了人工智能模型的“智能”水平,但支撑本文核心观点的暴力现实是,这一变化更重要的是改变了对智能的获取方式——使其成为一种奢侈品。

问题出在规则,而不是参与者

在“AI经济学”中,人工智能的单元经济学归结为一个问题:每个token的成本是多少?

AI经济学101

人工智能无法直接处理语言,只能处理数字。因此,每个AI模型都必须执行两个操作:

-

编码:将单词(或任何其他数据类型)转换为一个捕捉该单词属性的数字向量。

-

解码:在这些编码(称为嵌入,embeddings)被AI模型处理后,将它们解码回语言。

尽管像Meta公司通过Byte-level Transformer等努力在优化这一过程,但目前大多数AI模型将语言分解为token(单词或子单词),这些token是根据它们在某种语言中的常见性划分的。

处理嵌入并生成新嵌入以形成响应需要大量计算,这些计算由被称为GPU的硬件(以及类似LPUs、TPUs或RDUs的设备)执行,而这些硬件具有以下特点:

-

极其昂贵:受到极端供需不对称的推动。

-

不稳定:寿命远非理想,并且由于多种因素,它们故障率很高。

由于计算量非常大,你需要大量此类硬件,这会显著增加你的总体拥有成本(TCO)。

更糟糕的是,它们需要巨量的能量消耗(对于LLM,其能耗大约是一次Google搜索的10倍)以及大面积集中的土地资源(硬件必须彼此紧密放置),导致资本支出(CAPEX)达到惊人的规模。如果这一趋势持续下去,仅微软、Meta、Google和Amazon这四家公司在2025年的资本支出就可能超过3200亿美元(还有许多其他公司未统计在内)。

一个粗略的估算方法是将NVIDIA、AMD、Broadcom和华为等AI业务的收入翻倍,因为GPU通常只占投资总成本的50%。

我的观点是,将LLM推向市场已经非常昂贵,对这些公司的财务构成了巨大的负担:

• OpenAI据报道在2024年亏损了50亿美元。

• 超大规模公司(上述四家公司)的资本支出与收入差距在12到30倍之间,并且还在扩大。

然而,在消费者眼中,这一切都被抽象为一个简单的指标:每个token的成本。这些公司通过以下方式向你收费:

-

每个输入token的固定价格。

-

每个输出token的固定价格,通常是输入token价格的2到3倍。

因此,作为消费者,你的整体成本由你发送给模型的token数量以及模型返回给你的token数量决定。好消息是,这种价格几乎每个月都在下降!

问题解决了吗?很遗憾,没有。原因是,LRM再次改变了一切。

LRM的经济学

LRM引入了三大成本负担:

- 数据成本

在LLM中,大多数数据是免费的,模型提供商甚至涉嫌通过侵犯版权等手段获取数据。如果需要,也不惜花费时间。

- token数量

由于LRM的“更长时间思考”特性,它在响应中会生成数倍于LLM的token,尤其是推理token。由于token具有单位成本,这导致了生成成本的爆炸性增长。

- 验证者的成本

LRM会使用自身或替代模型来“判断”其思考质量,从而增加了元token的生成成本。

数据问题

LRM需要推理数据进行学习,这种数据不仅包含输入和输出(像大多数普通数据那样),还包含从输入到输出的推理过程。然而,互联网上的大部分数据直接给出答案,写作者很少展示其思维链条。这使得现有数据对LRM而言几乎没有价值。

这意味着AI实验室必须自行筛选数据,雇佣博士和各领域的专家来生成这些用于训练的数据。这需要昂贵的专家时间,显著增加了全球培训成本。

token级别的成本

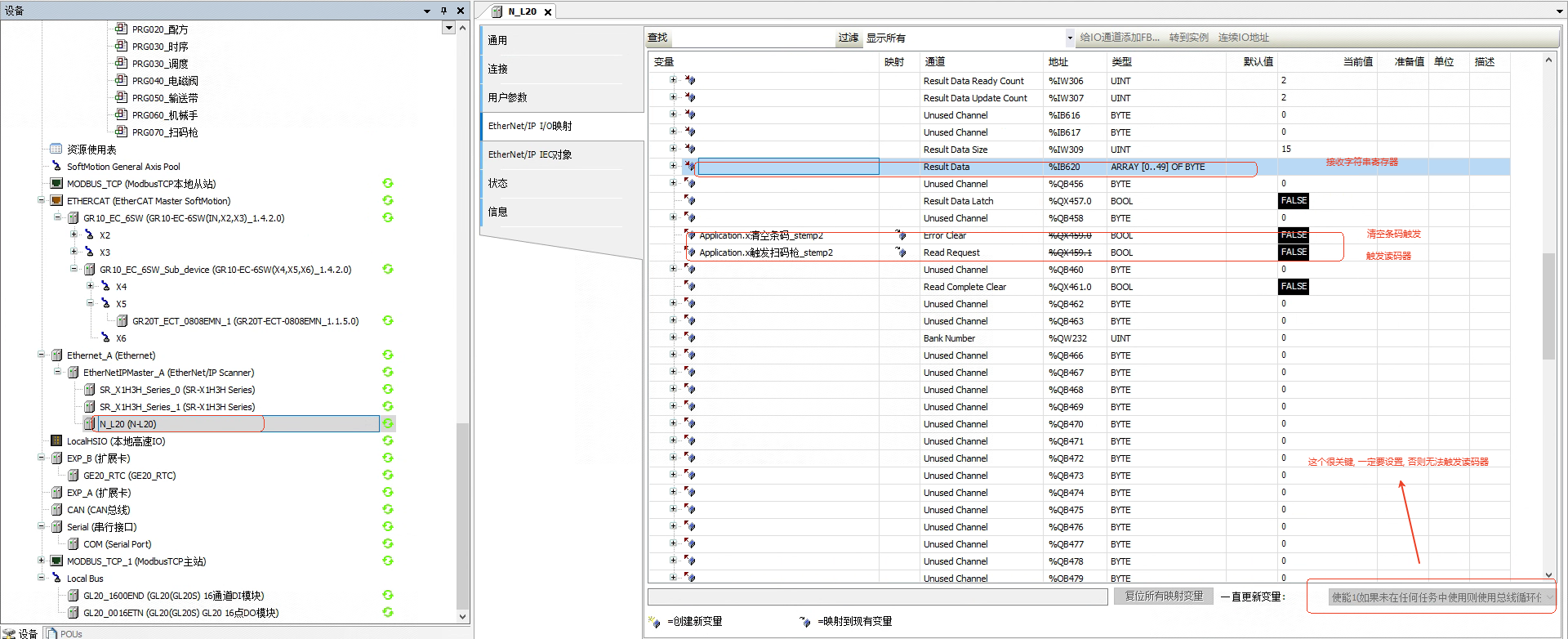

如OpenAI自己的图表所示,LRM引入了两种新的token类型,显著增加了token数量:元token和推理token。

• 元token:模型反思其自身思考的token(在上图中被包含在“推理token”内)。由于模型(或替代模型)需要生成新token来进行批判,这些token增加了成本。

• 推理token:模型用于推理任务和其响应的token,以提高结果正确率。

由于之前提到的“探索”因素,这些模型会“尝试”多种解决路径,生成额外的token来探索、回溯和扩展新的解决路径。

结果是显而易见的:LRM生成的token数量大幅增加。这也意味着用于LLM的AI经济学模型不再适用,而为了让LRM盈利,消费者可能要与每月20美元的订阅费说再见。

o3:巨大的不平等化器

让我引入OpenAI的新模型o3,它是一个真正的LRM。

与LLM相比,它的能力在探索、迭代和回溯中全面超越,就像人类解决问题时那样。但其成本和经济效益完全崩溃。

据可靠消息,OpenAI仅在一个基准测试(ARC-AGI)上就花费了数百万美元来获得结果。

一旦推出,o3的订阅费用预计将达到2000美元/月,即24000美元/年。

这将是社会中的转折点,AI不再只是一种工具,而成为一种富人垄断的优势,社会的不平等将由此加剧。

结论

AI虽然在未来可能会普惠社会,但在短期内,其高昂的成本将使绝大多数人无法使用最先进的工具。要应对这一挑战,政府需要从教育、能源和竞争等多方面进行调整,以减少不平等的影响。

![MySQL从库延迟 [Note] Multi-threaded slave statistics : seconds elapsed = 120; events assigned【转】](https://oscimg.oschina.net/oscnet/up-a36bfc614716e0d27a310b95cf9df2657b9.png)