引子

这两天国货之光DeepSeek-R1火爆出圈,凑个热闹。过来看看 aha moment(顿悟时刻)的神奇,OK,我们开始吧。

一、模型介绍

1月20日,中国AI公司深度求索(DeepSeek)发布的DeepSeek-R1模型,凭借其独特的强化学习(RL)训练方法,首次让AI展现出类人的“顿悟时刻”——在解决复杂问题时,模型会突然停下思考,自主修正推理路径,甚至用自然语言标注“等等,这一步可能有误”。(AI在思考的过程中突然停下:“等等,等等。这是一个顿悟时刻。让我们一步一步地重新评估一下,以确定正确的总和...”)知名AI评测员Matthew Berman表示,R1拥有他所见过的最像人类的内心独白。

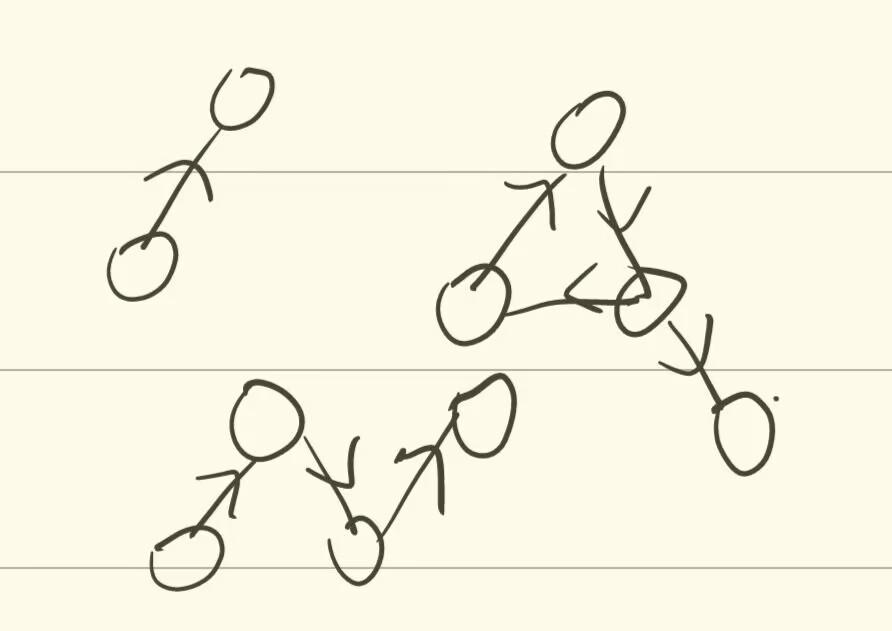

DeepSeek-R1的这种特点,和它独特的训练方式有关。传统的AI训练有三个阶段:预训练、SFT(监督微调)、RL(强化学习)。打个比方,传统AI需经历三阶段学习:先在预训练阶段里“背书自学”基础知识,再在SFT阶段里“抄写教案”模仿人类示范,最后在RL阶段里“模拟考试”优化表现。而R1 Zero跳过了SFT阶段,直接进入了RL阶段。也就是说,DeepSeek-R1直接砍掉用人工标准数据训练的“模仿”环节,而是仅凭基础语言能力和数学规则,在持续解题试错中自悟知识体系。

SFT的使用是当年ChatGPT成功的关键,而R1 Zero完全用强化学习替代了SFT。DeepSeek-R1成功的秘诀在于构建了一个智能训练场,这一系统由三个技术组件构成:动态题目生成系统、过程验证体系和协同工作机制。用一个比喻来说,每解完一题,系统自动生成更难的变体题,并实时验证解题过程逻辑是否自洽。它迫使AI像数学家般提炼方法论,甚至能将几何证明中的反证法迁移到代码检测中。这个训练过程展示了强化学习的潜力。未来的AI发展,依然充满无限可能。

强大,便宜,还开源。据介绍,DeepSeek-R1的功能比肩OpenAI o1。根据DeepSeek官方公布的数据,DeepSeek-R1在AIME2024上获得了79.8%的成绩,略高于OpenAI-o1-1217的79.2%。在MATH-500上,它获得了97.3%的惊人成绩,表现略高于OpenAI-o1-1217的96.4%,并明显优于其他模型。在编码相关的任务中,DeepSeek-R1在Codeforces上获得了2029 Elo评级,在竞赛中表现优于96.3%的人类参与者。对于工程相关的任务,DeepSeek-R1的表现略优于OpenAI-o1-1217

二、环境搭建

模型下载,硬件受限,下载1.5B模型

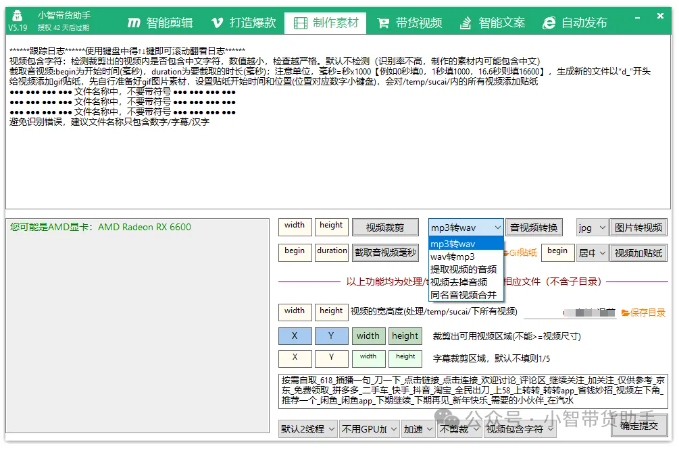

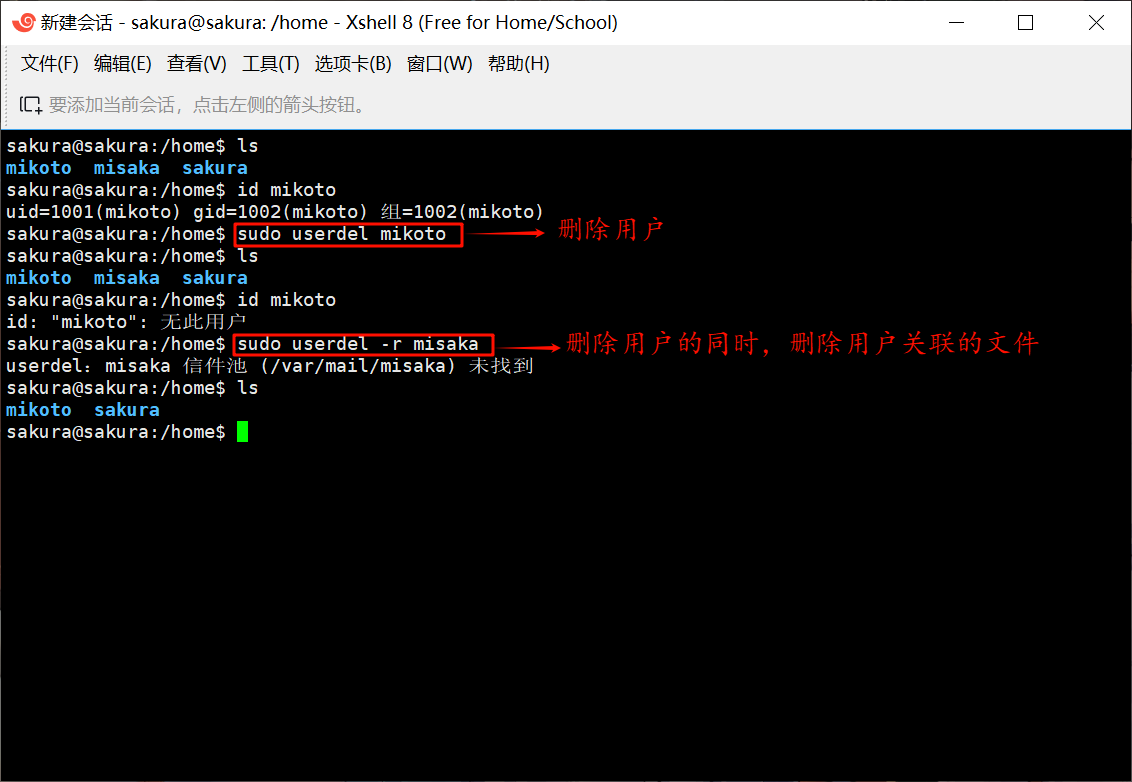

docker run -it -v /datas/work/zzq/:/workspace --gpus=all --net=host deepseek_r1:v1.0 bash

pip install vllm==v0.6.2 -i

三、测试推理

vllm serve DeepSeek-R1-Distill-Qwen-1.5B --tensor-parallel-size 1 --max-model-len 32768 --enforce-eager --dtype=half

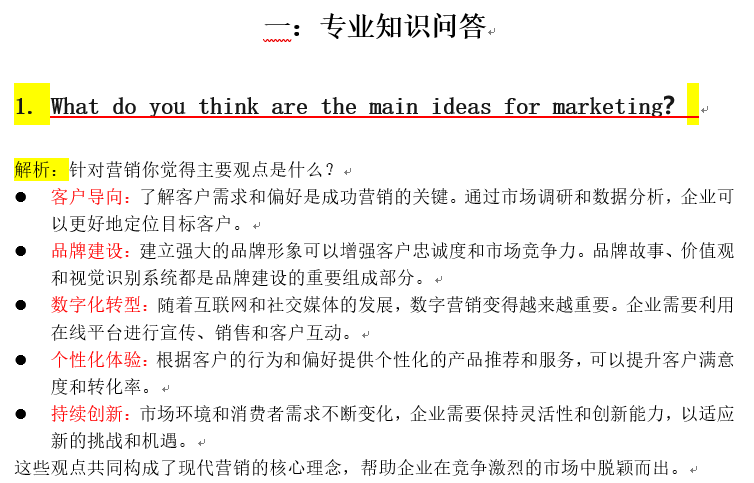

仔细阅读DeepSeek-R1的思考过程,就能发现它思考时的语言风格十分自然,还会随口蹦出一些“让我仔细想一想”这样的活泼表述。