引言:从"结对编程"到API范式迁移

在GitHub Copilot等工具普及的今天,开发者们正在经历编程范式的第三次跃迁。我们曾从面向文件系统转向网络接口,从直接操作数据库到响应式前端框架,而当下,大语言模型(LLM)正在演变为一种新型编程接口。这种接口的特殊之处在于:它不直接操作存储系统或网络协议,而是通过自然语言处理人类意图,成为代码创作维度的"脑补引擎"。

代码索引:LLM的上下文构建艺术

传统方案 vs LLM范式

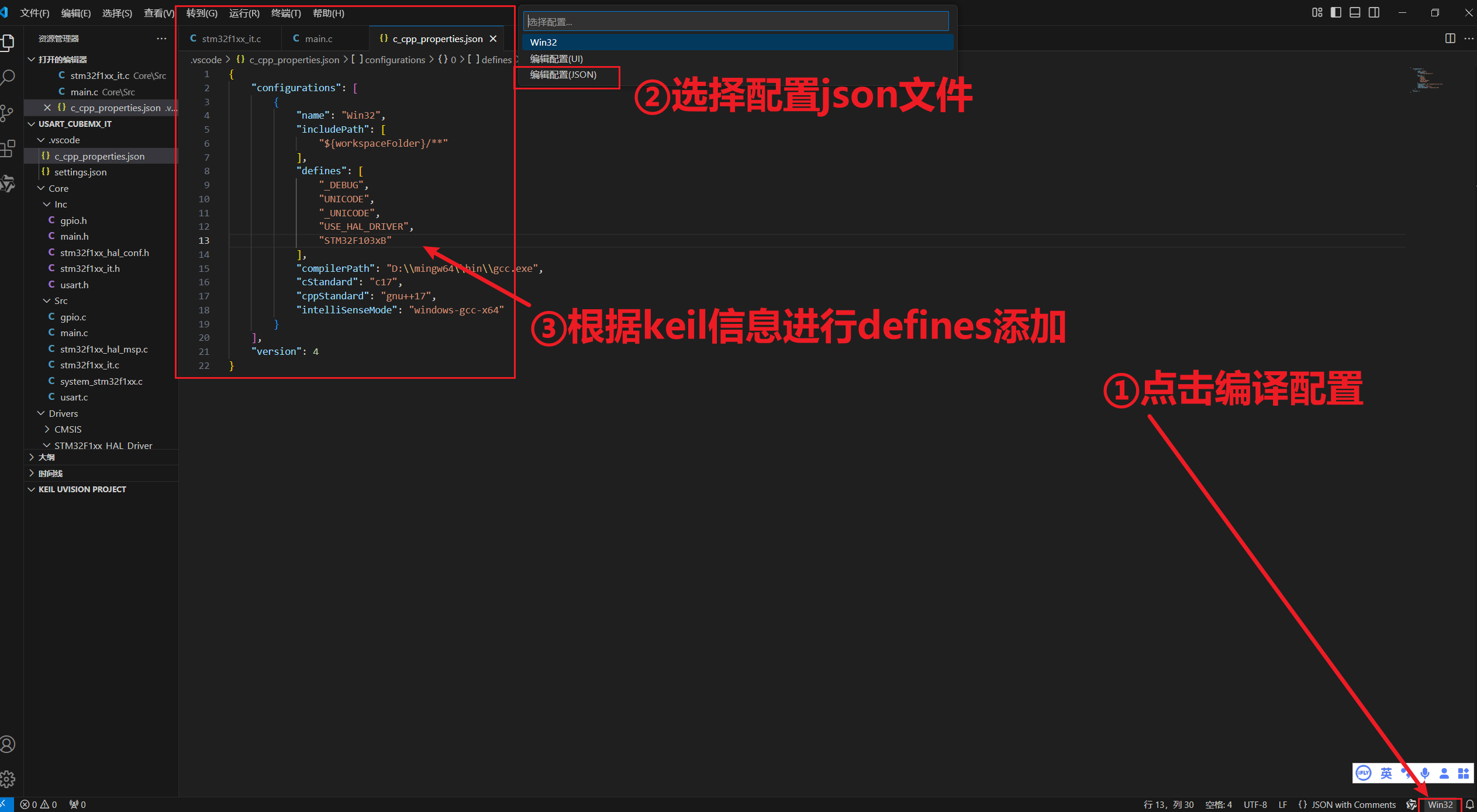

传统IDE通过静态分析构建符号表(Symbol Table),而LLM的代码理解基于动态上下文构建:

-

分块嵌入(Chunk Embedding)

- 代码文件切分为语义块(类/函数级)

- 使用text-embedding-ada-002等模型生成向量

- 余弦相似度匹配用户query与代码块

-

AST增强索引

# 示例:Python AST解析 import astclass CodeIndexer(ast.NodeVisitor):def visit_ClassDef(self, node):print(f"Class: {node.name} @ {node.lineno}")self.generic_visit(node)def visit_FunctionDef(self, node):print(f"Function: {node.name} @ {node.lineno}")- 提取类/方法签名构建轻量级索引

- 保留继承关系等语义信息

-

**混合索引策略

索引类型 构建成本 查询精度 适用场景 全文检索 低 中 快速代码片段定位 向量索引 中 高 语义相似度匹配 AST索引 高 极高 代码逻辑推理

LLM编程的"SQL化"特征

查询引擎的本质差异

-- 传统SQL查询

SELECT * FROM users

WHERE age > 25

INDEXED BY age_idx-- LLM"脑补查询"

{"context": ["UserService.java", "AuthFilter.kt"],"prompt": "实现JWT过期自动续期","schema": "OpenAPI-3.0"

}

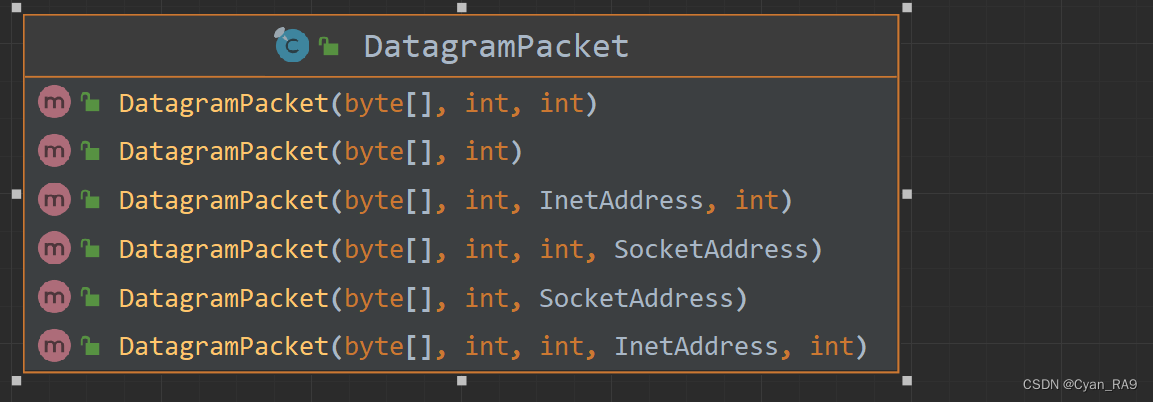

- 查询目标:数据库 vs 开发者心智模型

- 索引位置:DBMS内部 vs 本地代码库

- 返回形式:结果集 vs 代码块/JSON

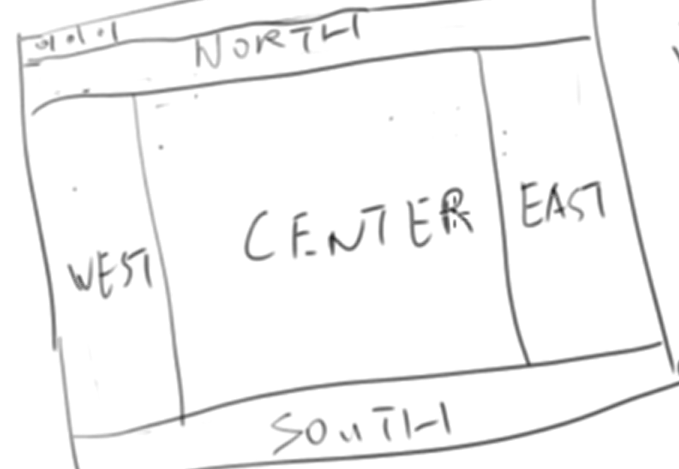

脑补引擎的三层抽象

- 自然语言层:用户意图的模糊表达

- 上下文工程层:RAG(检索增强生成)机制

- 结构化输出层:JSON Schema约束生成

本地化索引的工程实践

轻量级实现方案

# 基于ripgrep的代码索引

rg --type py 'class [A-Z]' -n > class_index.txt

rg --type py 'def [a-z_]+' -n > func_index.txt

重量级AST方案

// 基于TS compiler API的索引构建

ts.forEachChild(sourceFile, node => {if (ts.isClassDeclaration(node)) {storeSymbol(node.name.text, ts.SyntaxKind[node.kind], node.getStart());}

});

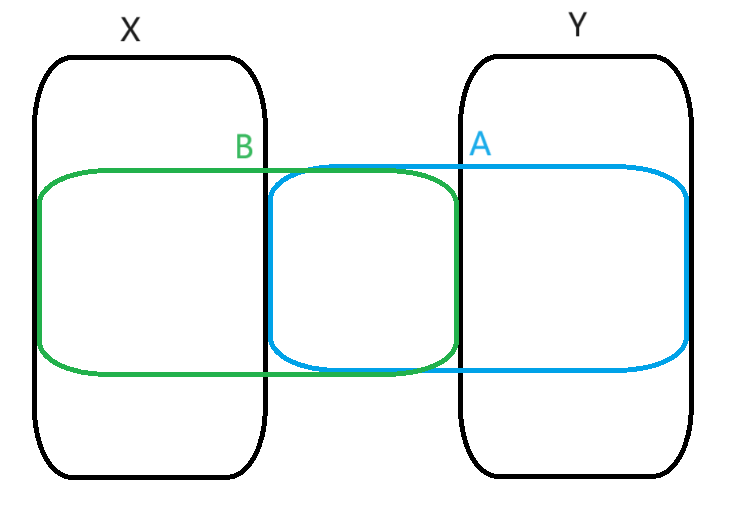

混合索引架构

[Codebase]│├── [VectorDB] <-> (语义检索)│ ├── chunk_embeddings│ └── doc_strings│└── [AST Indexer] <-> (结构检索)├── class_hierarchy└── method_signatures

范式革命的启示

当LLM成为一种新型编程接口,开发者需要掌握三种核心能力:

- 上下文剪裁术:在有限的token窗口内构建有效上下文

- 索引架构思维:在轻量文本索引与重量AST分析间权衡

- 概率编程直觉:理解temperature等参数对"脑补"结果的影响

这种转变正如当年SQL抽象了底层存储细节,LLM正在抽象代码创作过程的认知负荷。未来的编程,可能演变为"意图描述-上下文构建-结果校准"的新型工作流,而本地化索引的质量,将成为决定LLM编程效率的新战场。