1 啥是 DeepSeek-R1?

如你曾为一道棘手数学题绞尽脑汁,就明白多花时间仔细思考多重要。OpenAI o1 模型证明,当 LLM 在推理时,通过增加计算量进行类似训练后,它们在数学、编程和逻辑等推理任务上的表现显著提升。

然而,OpenAI 推理模型的训练方法一直是秘密。直到DeepSeek发布DeepSeek-R1模型,瞬间引爆互联网(甚至影响股市!)。

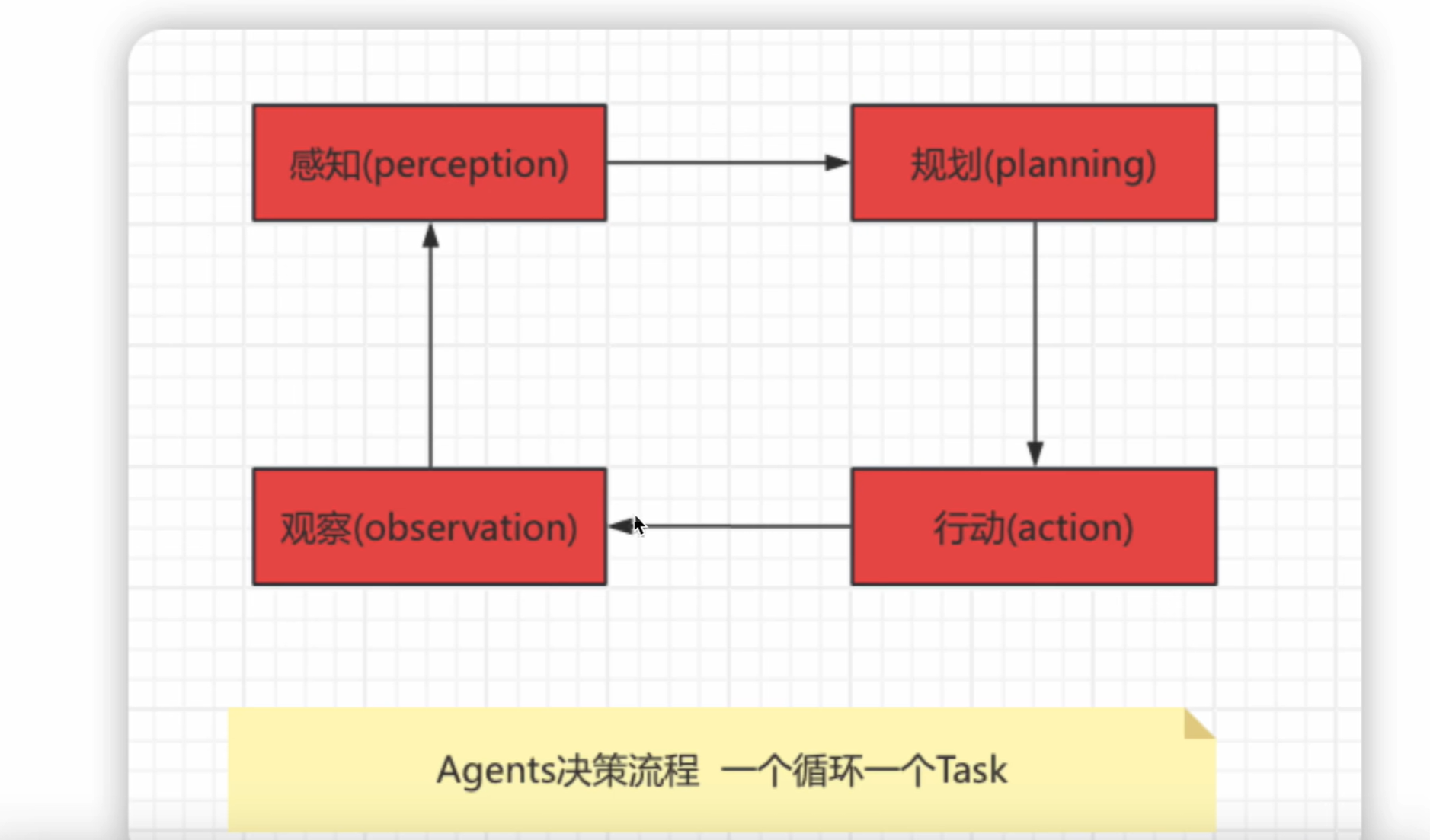

除了性能达到或超越 o1,DeepSeek-R1发布还附带详细技术报告,揭示其训练方法的关键步骤。该方法包含多项创新,最引人注目的是使用纯强化学习让基础语言模型学会推理而无需任何人工监督。如下图所示,只要拥有强大的基础模型和高质量的数据混合,构建强大的推理模型就变得非常简单:

不过,DeepSeek-R1 发布仍留下几个

1.1 未解之谜

- 数据收集:推理专用数据集咋构建的?

- 模型训练:DeepSeek 未公开训练代码,因此最佳超参数设置及其在不同模型系列和规模间的差异尚不明确

- 扩展规律:训练推理模型时计算资源和数据量之间咋权衡?

这些问题促使业界启动Open-R1 项目,旨在系统复现 DeepSeek-R1 的数据和训练流程,验证其声明,并推动开源推理模型的边界。通过构建 Open-R1

1.2 愿景

- 揭示强化学习如何增强推理能力

- 与开源社区分享可复现经验

- 并为未来模型应用这些技术奠定基础

本文深入探讨 DeepSeek-R1 的核心要素、计划复现的部分。

2 他们咋做到的?

DeepSeek-R1 是基于 [DeepSeek-V3] 打造的推理模型。与所有优秀推理模型一样,它始于一个强大的基础模型——DeepSeek-V3 正是如此。这个 671B 的混合专家模型(MoE)性能媲美 Sonnet 3.5 和 GPT-4o 等重量级选手。其训练成本仅 550 万美元,这得益于多令牌预测(MTP)、多头潜在注意力(MLA)等架构改进和大量的硬件优化。

DeepSeek 推出两个模型,分别采用不同的训练方法

2.1 DeepSeek-R1-Zero

完全跳过监督微调,仅通过强化学习(RL)和组相对策略优化(GRPO)实现高效训练。简单的奖励机制根据答案的准确性和结构提供反馈,帮助模型发展出分步推理和自我验证等能力,但其回答常缺乏清晰度。

2.2 DeepSeek-R1

DeepSeek-R1 的改进之处。它通过"冷启动"阶段在小规模精编数据上进行微调,提升回答的清晰度和可读性。随后通过更多 RL 和精炼步骤(包括基于人类偏好和可验证奖励的低质量输出过滤),最终形成既擅长推理又能生成优雅答案的模型。

这一切听起来很完美,但还缺少啥?来看看拼图的缺失部分。

3 Open-R1:填补空白

DeepSeek-R1 的发布对社区是重大利好,但并非完整开源——虽然模型权重开放,但训练数据集和代码仍未公开😢!

Open-R1 的目标就是填补这些空白,让整个研究和产业界都能使用相同配方和数据集构建类似或更优的模型。通过开源协作,每个人都可参与贡献!

3.1 攻关计划

如下图分三步:

- 第一步:通过从 DeepSeek-R1 蒸馏高质量推理数据集,复现 R1-Distill 模型

- 第二步:复现 DeepSeek 创建 R1-Zero 的纯 RL 流程,需要构建数学、推理和代码的大规模新数据集

- 第三步:展示从基础模型→监督微调→多阶段 RL 训练的全流程

合成数据集将允许任何人通过简单微调,将现有或新 LLM 转化为推理模型。包含 RL 的训练方法将成为从零构建类似模型的起点,研究人员可在此基础上开发更先进的方法。

社区不会止步于数学数据集。代码等传统领域及医学等科学领域都有巨大潜力,推理模型可能产生重大影响。

该倡议不只复现结果,更是与社区共享洞见。通过记录有效/无效的方法及其原因,社区希望帮助他人避免在无效路径上浪费时间和算力。

本文已收录在Github,关注我,紧跟本系列专栏文章,咱们下篇再续!

- 🚀 魔都架构师 | 全网30W+技术追随者

- 🔧 大厂分布式系统/数据中台实战专家

- 🏆 主导交易系统亿级流量调优 & 车联网平台架构

- 🧠 AIGC应用开发先行者 | 区块链落地实践者

- 🌍 以技术驱动创新,我们的征途是改变世界!

- 👉 实战干货:编程严选网

本文由博客一文多发平台 OpenWrite 发布!

![[CSharpTips]C# 获取当前方法名](https://img2024.cnblogs.com/blog/2103480/202502/2103480-20250206090427159-1244229785.png)