0 为啥本地部署?

在本地运行 AI 模型具有以下优势:

- 隐私:你的数据保留在你的机器上 — — 不存在共享敏感信息的风险

- 成本: DeepSeek R1 可免费使用,无需订阅费或使用费

- 控制:无需外部依赖即可进行微调和实验

1 使用Ollama

1.1 下载并运行应用程序

直达官网:

1.2 选择你的平台

MacOS、windows

直接下载,找到对应操作系统的软件到本地:

点击安装即可:

1.3 命令行下载指定模型

如:

ollama pull deepseek-r1:8b

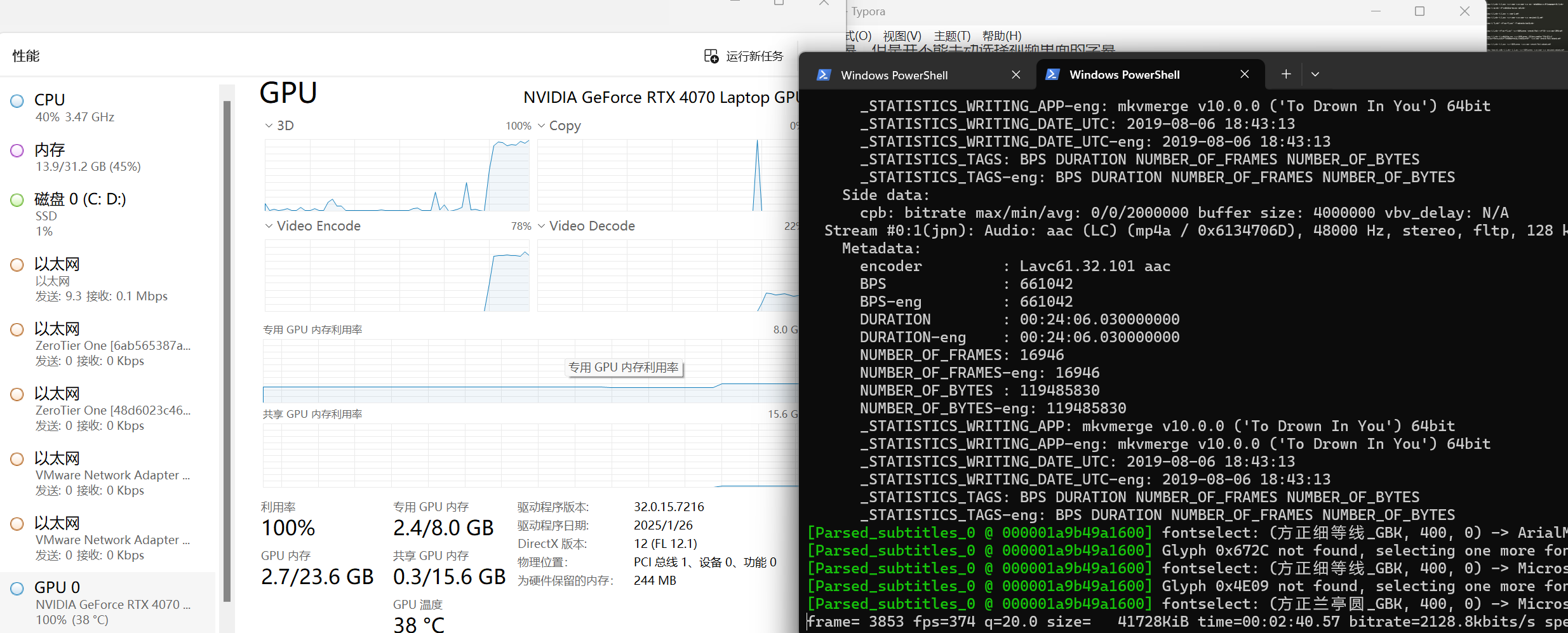

系统会自动下载。 下载速度,看网速,我的网速不好,等了20分钟左右。 完成下载后,模型即可运行。

官网支持的模型:

按LiveCodeBench评分,DeepSeek V3得分42.2,蒸馏模型Qwen 14B得分53.1,具有相当的性能,而且尺寸相对来说属于桌面级能跑,推荐用14B:

1.4 运行

浏览器:

2 可视化软件

如Chatbox/cherry studio等工具,设置简单,内置功能丰富,与本地模型集成,免费畅享各种大模型且注重数据安全。

2.1 下载 Chatbox

官网:

安装完成后,打开左下角设置:

- 将 API 主机设置为:http://127.0.0.1:11434

- 选择 DeepSeek R1 作为活动模型

- 保存

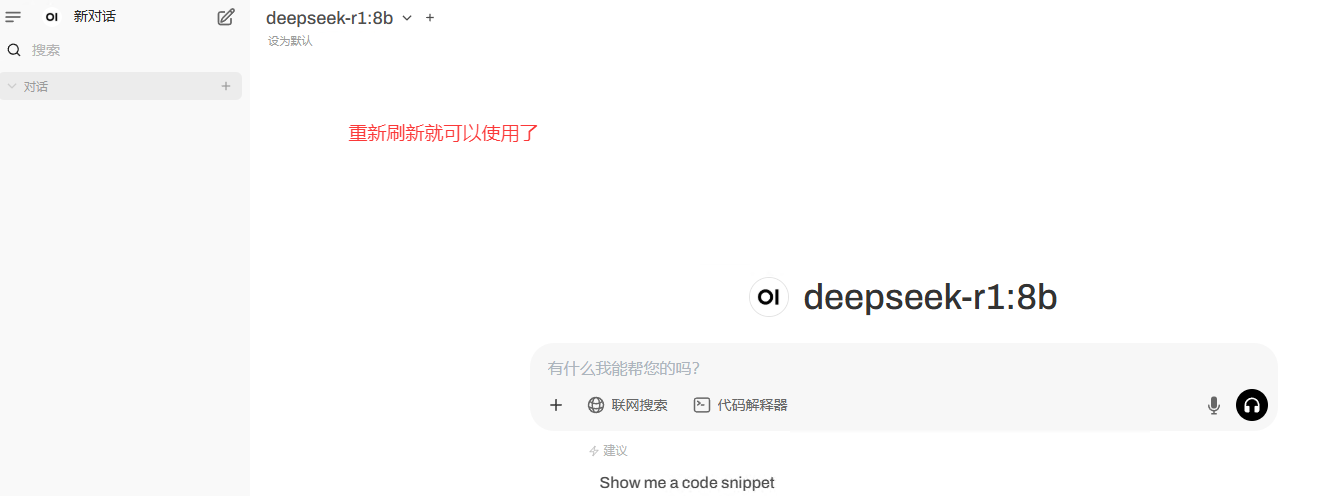

开始激聊:

PC软件连接本地大模型成功,后续即可根据自己需求训练DeepSeek,将DeepSeek训练成自己的私有专家。

2.2 遗留问题

现成 GUI 软件虽好,也不是菩萨,只是给你最基本聊天功能,想使用更高级的多模态功能,依旧需要付费,因此最终大招还是自己开发。

图片识别受限:

联网搜索受限:

3 本地大模型调用

本地部署完了,来看咋调用?

from langchain_community.llms import Ollamallm = Ollama(model="qwen2:0.5b")

llm.invoke(input="你是谁?")

使用流式

#使用流式

from langchain.callbacks.manager import CallbackManager

from langchain.callbacks.streaming_stdout import StreamingStdOutCallbackHandlerllm = Ollama(model="qwen2:0.5b", callback_manager=CallbackManager([StreamingStdOutCallbackHandler()])

)

llm.invoke(input="第一个登上月球的人是谁?")

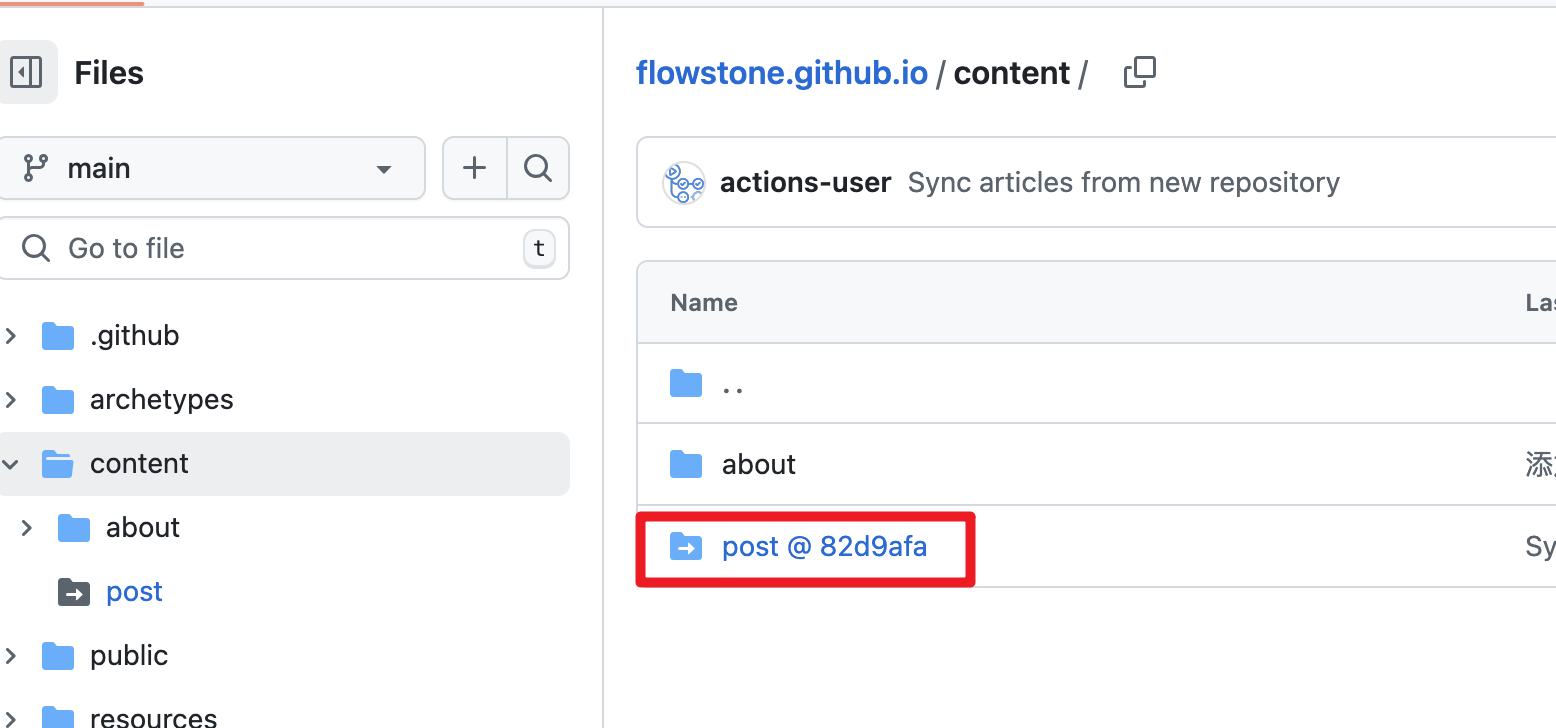

本文已收录在Github,关注我,紧跟本系列专栏文章,咱们下篇再续!

- 🚀 魔都架构师 | 全网30W+技术追随者

- 🔧 大厂分布式系统/数据中台实战专家

- 🏆 主导交易系统亿级流量调优 & 车联网平台架构

- 🧠 AIGC应用开发先行者 | 区块链落地实践者

- 🌍 以技术驱动创新,我们的征途是改变世界!

- 👉 实战干货:编程严选网

本文由博客一文多发平台 OpenWrite 发布!

![洛谷题单指南-线段树的进阶用法-P5445 [APIO2019] 路灯](https://img2024.cnblogs.com/blog/3330618/202502/3330618-20250206161041496-777296653.png)

![[LLM] ZeRO-DP技术简析](https://img2024.cnblogs.com/blog/1077980/202502/1077980-20250207124128680-1240450708.png)