一、Ollama下载指引

官网地址:https://ollama.com/download

选择Windows版本直接下载(推荐64位系统),安装包745MB左右,支持Win10/11系统。点击"Download for Windows"按钮即可开始下载。

二、安装过程详解

-

双击下载的

OllamaSetup.exe -

点击install之后,一路下一步就可以完成安装

-

静默安装约10秒后,右下角会出现小羊驼图标

-

验证安装:打开PowerShell输入:

ollama --version

出现类似ollama version is 0.5.7即表示安装成功。

ollama是默认安装到C盘的,如果不想安装到C盘,可以这样操作:

1.先进入ollamaSetup.exe安装包所在的文件。

2.在空白处右键,选择“在终端打开”,打开cmd窗口。

3.输入命令(此命令是设置安装路径):

OllamaSetup.exe /DIR=D:\"Program Files"\ollama

4.回车后,会打开ollama的安装程序,直接install即可。

三、DeepSeek R1模型全家桶

Ollama是一个运行开源大模型的平台,它提供了仓库存放非常多的开源模型,比如阿里通义千问, Meta llama等等。我们这次要探索的DeepSeek R1模型。

直接在浏览器中打开:https://ollama.com/library/deepseek-r1。从下图中可以看到,有1.5b, 7b, 8b,14b, 32b, 70b,671b等不同参数的模型。图中671b是DeepSeek R1模型,671b代表6710亿参数。所有版本均支持中英文双语,1.5b版实测可在8GB内存设备运行。

-

deepseek-r1:1.5b:最小参数版(1.1GB),适合低配设备 -

deepseek-r1:7b:平衡版(4.7GB),推荐主流配置使用 -

deepseek-r1:14b:增强版(9.0GB),需要16G+内存

四、本地运行1.5b模型实战

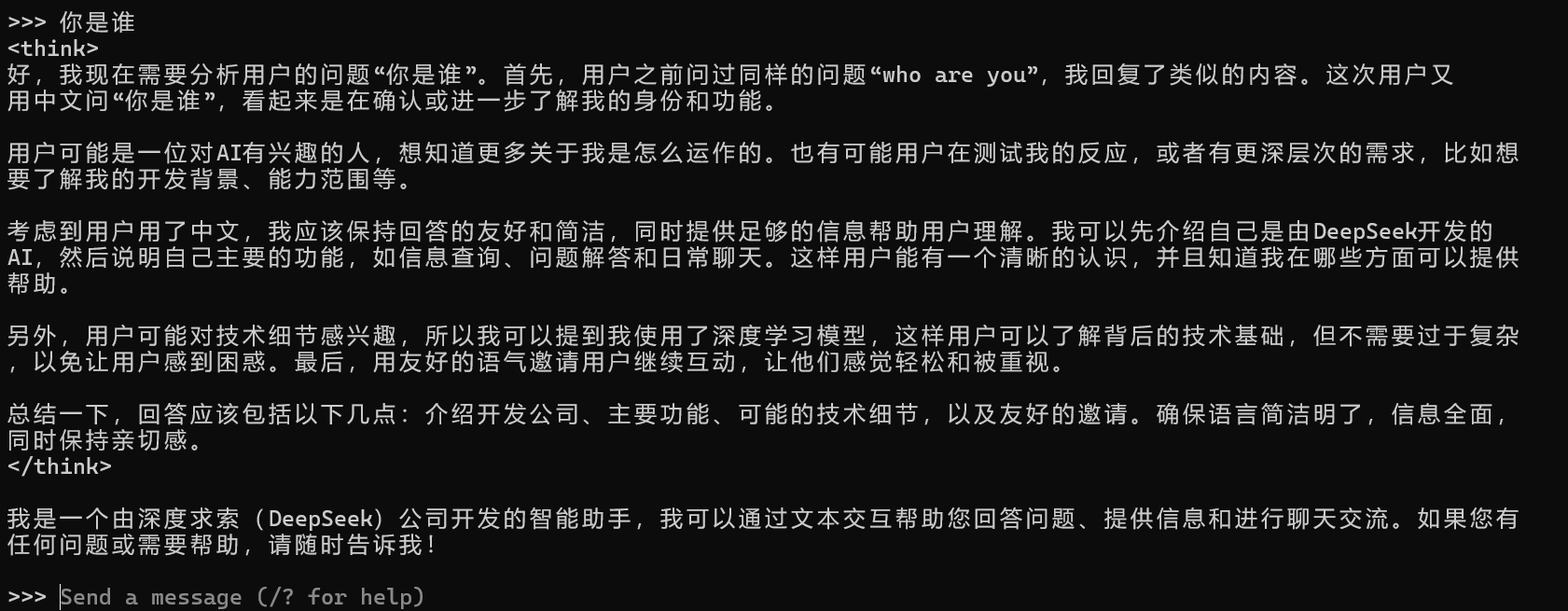

- 启动交互界面,在上图中的界面选择1.5b,复制右边的命令:ollama run deepseek-r1:1.5b,在命令窗口中执行该命令:

ollama run deepseek-r1:1.5b

如果是第一次运行,ollma会自动尝试从他们的仓库下载deepseek模型文件。如果已经下载过,则出现如下提示:

2. 输入测试指令:

>>> 用Python写个斐波那契数列生成函数

ollamap则使用deepseek r1开始输出回答,模型将返回完整代码及注释,首次响应约需3-5秒

五、告别黑窗口,安装聊天界面!

安装 ollama之后,可以在命令行里面直接和DeepSeek聊天。但显然命令行并不友好,虽然控制台可用,但每次都要输入命令确实麻烦。

我们可以安装另外一个开源软件OpenWebUI,其界面和ChatGPT和DeepSeek类似。

Open WebUI是一个可扩展、功能丰富、用户友好的自托管AI平台,旨在完全离线运行。它支持各种LLM运行程序,如Ollama和OpenAI兼容的API,内置RAG推理引擎,使其成为一个强大的AI部署解决方案。

![[书]清华大学DeepSeek:从入门到精通](https://img2024.cnblogs.com/blog/732505/202502/732505-20250211111904631-1749898225.png)