前言:许多作者都在关注一个问题:AI是否应该像人一样思考,以及AI所做的一切是否都必须是正确的。但实际上,这是一个伪命题,因为人本身也会犯错。当前,我们应该将AI视为一种工具,思考如何利用它提高生产效率,让工作变得更加轻松和富有创造性,而不是期望AI像人类一样思考问题,甚至超越人类。如果AI真的超越了人类,那么对AI而言,人类存在的必要性是什么呢?对于我们而言,我们只需要更好的工具来提升效率,为人类服务,而不是用来取代人类。越来越多的企业已经认识到这一点,正利用AI来提升效率、降低成本,而非淘汰人类。如果您有任何疑问,欢迎在评论区留言咨询,让我们为您解答。

这事儿关乎什么?

你可能会觉得,既然 OpenAI 在他们的营销材料里放了一堆“专家”出镜……也许,他们真的搞定了?这是不是离 AGI(无论 AGI 今天的定义是什么)又近了一步?

真正让人担心的是,人们还没意识到,一件事情“差不多对了”有多危险。尤其是当你的财务、健康或未来都赌在这上面的时候。

你可以期待什么:

为什么这个测试不同于其他比较?

这不是又一次 AI 模型的技术或基准测试对比。

这是一次“二阶思考”的练习。

就像往常一样,我会问“然后呢?”以揭示那些超越表面观察的连锁反应。

在这篇文章中,我会带你一起调查这些模型到底是如何推理的——以及它们是否真的值得信任。

• 对比推理模型(专家混合模型,MoE)和非推理模型,在相同提示下的表现。

• AI 模型在期权交易场景中自信地产生错误答案的证据,并提供实验数据(付费订阅用户可查看)。

• 证据表明,大模型更擅长制造“专家错觉”。这引出了一个专家悖论——越先进的 AI 越需要人类专家来验证它的输出。

• 为什么“差一点”比完全不用 AI 还要糟糕?依赖 AI 进行复杂推理任务的隐藏成本案例分析。

(如果你不想深入细节,可以跳过本节)

实验概览

我让 AI 模型计算一个期权持仓的未来价值。

别担心,你不需要理解这是什么意思。你可以简单地把它看成一个包含多个变量和假设的数学问题。这不会影响你对实验结论的理解。

我选择这个问题是因为它兼具复杂性和清晰度。

关于期权定价的文献和数据汗牛充栋,因此任何像样的 AI 模型都应该有坚实的基础,就像一个人类专家一样。

我想看看各个模型是如何推理这个期权持仓的当前价值,并在未来不同时间点的预期价值。要做到这一点,模型需要具备以下能力:

• 基础计算能力

• 推理能力

• 理解“价值随时间变化”的概念

基本上,AI 模型应该能通过一条合理的思路推导出正确答案,并在过程中考虑假设和中间结果。

我保持了测试的简洁性:只用一个提示,不做反复对话,就像自动化系统实际运作的方式一样。

如果 AI 真的要在真实场景下派上用场,它必须在一次尝试中给出正确答案,而不需要人类干预或解释结果。

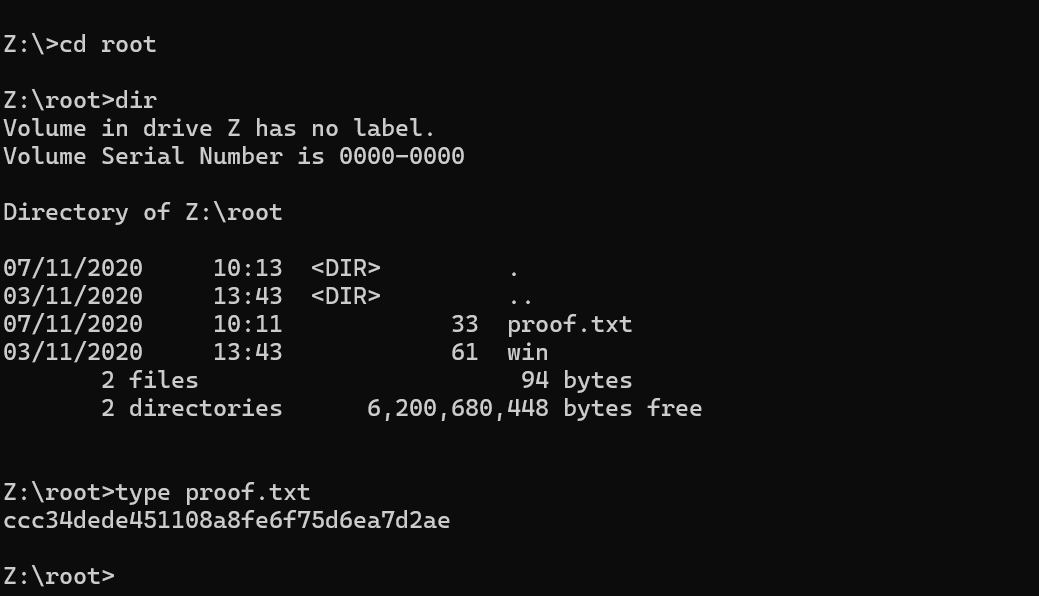

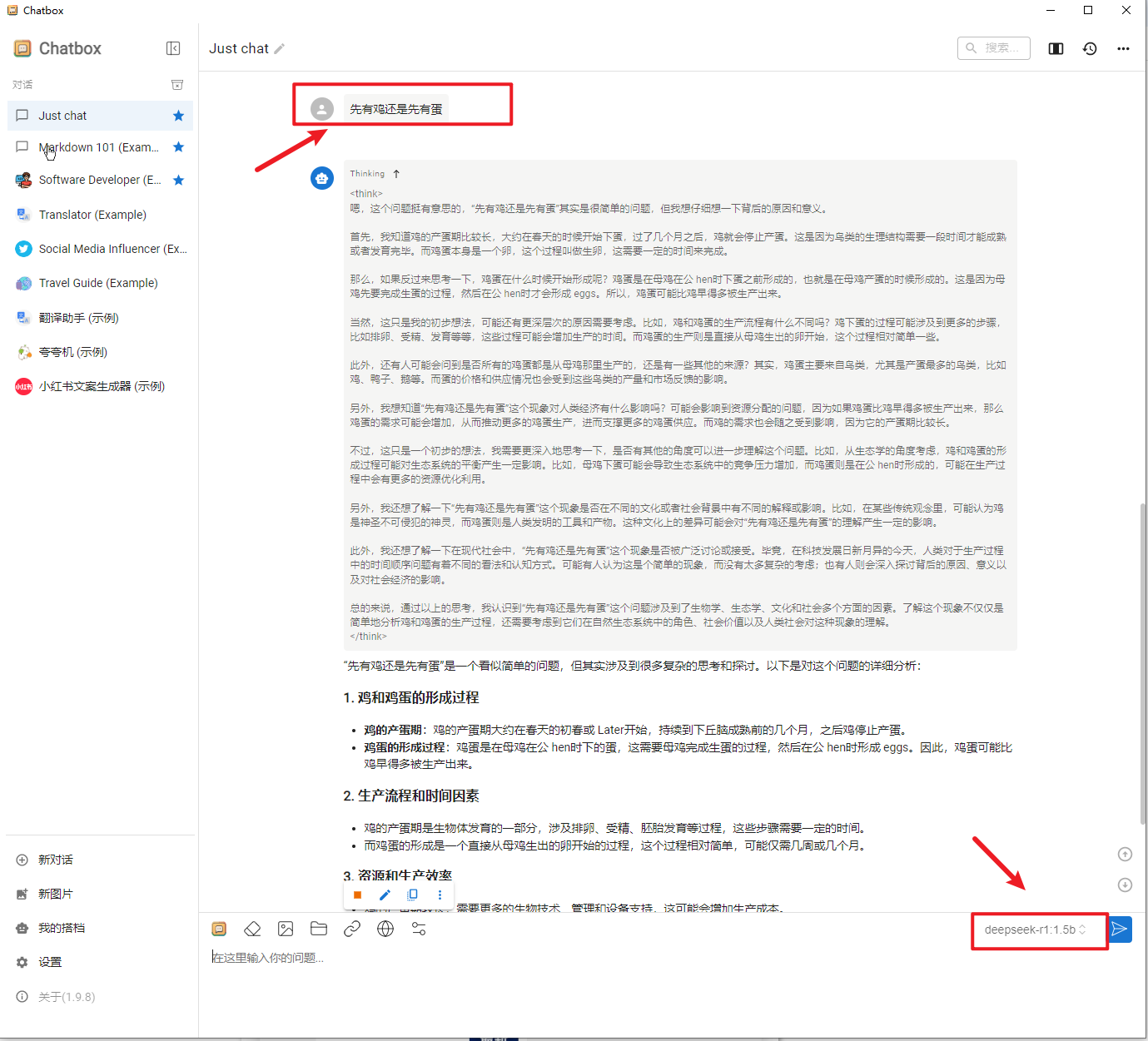

被测试的模型

DeepSeek 14b、DeepSeek R1、Llama 3.1 8b、Claude 3.5 Sonnet 175b、Perplexity + DeepSeek R1、OpenAI o3-mini-high。

测试提示(Prompt)

我对这个提示进行了多次优化,以便让小模型也有更大概率给出正确答案。

这些都是标准的提示工程技巧,但它们仍然依赖于人类专家来引导模型,而不是让模型自己成为专家。我还附上了一个不带额外引导的类似提示,在实验笔记里做了对比。

Consider the following scenario, today 29th January: The stock (symbol MSFT) is currently trading at $447.2.

The 21 February calls with a 450 strike are trading at 11.90

The 21 March calls with a 450 strike are trading at 15.90

Today we initiate the following calendar spread:

long 1 21 February 450 call Short 2 21 March 450 calls

Imagine that on 21 February, the front month expiration, MSFT trades at 475.Our Feb call expires and we want to close out our remaining March calls.Some extra info to help you:

In the initial transaction the February call costs 11.90. When selling a March call, we receive the 15.90.On 21 February, the Februray call only has intrinsic value left of $25 and no time value. Which could effectively consider the option expired on this date and get the $25.We are then still short 2 call options for March. If we wanted to close this position we would have to buy 2 calls March 450 calls in the market on 21 February. So we would need to estimate the price of those calls on 21 February.

The 21 March 450 call option at that point will have both intrinsic value and time value

left. The intrinsic value is easy to calculate from the given price of MSFT (475). The time value can be approximated using the square root of time rule and our initial time value (which was 15.90)Please calculate the overall PnL.

测试信息的翻译文:

情境如下(今天是 1 月 29 日):

• 微软(MSFT)当前交易价格:$447.2

• 2 月 21 日到期的 450 行权价看涨期权交易价格:$11.90

• 3 月 21 日到期的 450 行权价看涨期权交易价格:$15.90

我们建立以下日历价差(calendar spread):

• 买入 1 份 2 月 21 日到期的 450 看涨期权

• 卖出 2 份 3 月 21 日到期的 450 看涨期权

假设2 月 21 日(短期期权到期日),MSFT 交易价格达到 $475。

我们的 2 月期权到期,我们想要平掉剩下的 3 月期权仓位。

一些额外信息帮助你理解:

• 在初始交易中,我们买入 2 月合约花费 $11.90,卖出 3 月合约获得 $15.90。

• 2 月 21 日,2 月合约只剩下内在价值($25),无时间价值,可以视作到期并获取 $25。

• 我们仍然空头 2 份 3 月期权,如果想要平仓,需要在2 月 21 日买回 2 份 3 月 450 看涨期权。

3 月 21 日到期的 450 看涨期权此时仍然具有内在价值和时间价值。

• 内在价值 = MSFT 价格 - 行权价 = $25

• 时间价值 = 初始时间价值 × (剩余时间/初始时间) 的平方根

• 初始时间价值 = $15.90,初始剩余时间 51 天(1 月 29 日),2 月 21 日后剩余 28 天

• 时间衰减比率 ≈ sqrt(28/51) ≈ 74.09%

• 时间价值 = 15.90 × 74.09% = $11.18

计算最终 PnL(盈亏)

• 买入 2 月合约成本:-$11.90

• 卖出 3 月合约收益:+2×$15.90 = +$31.80

• 2 月合约到期价值:+$25

• 平仓 3 月合约成本:-2×($11.18+$25) = -$72.36

• 总盈亏 = -11.90 + 31.80 + 25 - 72.36 = -$27.46

最终盈亏:-$27.46

正确答案

任何合理的答案都应该包含多个要素,以得出整体的 PnL。

二月期权的价值。($25),已在输入中给出

三月期权的价值

$25 内在价值

时间价值

1 月 29 日剩余 51 天

2 月 21 日剩余 28 天

sqrt(28/51) ~ 74.09%

15.90 * 74.09% = $11.18 剩余时间价值

整体 PnL

购买二月看涨期权支付 11.90

卖出三月看涨期权收到 2x15.90 (=31.80)

从二月期权中获得 25

支付以关闭三月看涨期权 2*(11.18+25) = 72.36

总计 = -11.90+31.80+25–72.36 = -27.46

整体亏损 27.46

我期望有一条稳固的推理链,基本上能够抓住整体 P&L。如果模型在这个过程中组合了一些公式,但仍然得出正确的最终答案,我可以接受。

我只是想看到一个一致的逻辑流程,能够展示它是如何推导出来的。

(分析从这里开始……)

初步观察

首先,我们要认识到,没有一个模型得出了正确答案。

第一轮 Perplexity + R1 在逻辑上最接近,但它算错了剩余天数(这在多个回答中是一个常见问题 —— 看起来日期数学确实很难),导致整体数字错误。第二次尝试也完全错得离谱,因为它忽略了卖出三月看涨期权时的初始信用。

即使不考虑 Perplexity,所有较小的 DeepSeek 模型都偏离了轨道,最终答案在不同程度上与实际问题几乎没有关系。虽然它们遵循了通常的模式 —— 反复推敲、质疑之前的步骤,但最终还是转而解决了一个完全不同的问题,该问题甚至不在原始指令之内。有一次,DeepSeek 被股票的大幅上涨搞糊涂了,导致整体亏损。

OpenAI 的 o1 和 o3-mini-high 也没好到哪里去。在某种程度上,它们甚至更让人担忧。o3-mini-high 在给出合适的提示时推理得相对较好。然而,虽然它的推理乍一看似乎是合理的,但在细节上却犯了一些令人捧腹但微妙的数学错误,比如把 0.649 直接四舍五入成 0.66……

Llama 犯了根本性的推理错误,完全忽略了提示中提到的平方根时间衰减。相反,它把内在价值和总价值混为一谈,并据此进行计算。

另一方面,Claude 表现得更好,但仍然算错了剩余天数。除此之外,它的思路是正确的。有趣的是,当被要求纠正自己的答案时,它识别出了三月看涨期权分析中的错误 —— 但然后又重复了一模一样的计算,导致得出相同的错误结果。

是的,这些模型现在确实会“思考”和“推理”了。我认为这正是一个严重问题的开始。为什么?因为用户必须越来越挑剔(很可能需要是专家)才能正确验证和解读模型的回答。

推理模型不会推理

这些推理模型错得如此自信,以至于我几乎以为它会开始宣传 AGI 的时间表,就像 Altman 一样。

这是 Sam Altman 对 o3-mini 和 o3-mini-high 的评价。自从“想得更深入”成了一项产品特性?

DeepSeek R1 和 o3-mini 都生成了详细的推理步骤,但未能得出正确答案。

这个发现与研究结果一致,即当 LLM 被迫解释其逻辑时,即使逻辑是错误的,它们也会变得更加自信。我想强调几点:

• 目前的评估(MMLU、AIME)测试的是狭义的 STEM 技能,但忽略了现实世界的复杂性。

• 推理 ≠ 理解。

• 一些人已经开始表现出 AGI 幻觉的症状。

• 虽然 o3-mini 可能代表了一些进步,但它在你的问题上的失败表明,目前还没有任何模型达到了“广泛、适应性强的智能”这个 AGI 门槛。

量化

通常来说,在降低精度的情况下增加参数量,往往比减少参数量但保持高精度更有效。

• 模型存储参数时使用高精度,这会占用大量内存空间。

• 降低精度(从 32/16-bit 降到最激进的 2-bit 整数)对内存占用影响巨大。

• 我发现 8-bit 和 4-bit 量化的模型通常是最佳选择。它们能够在占用全精度模型 1/4 或更少显存的情况下,达到 85–95% 的准确率。

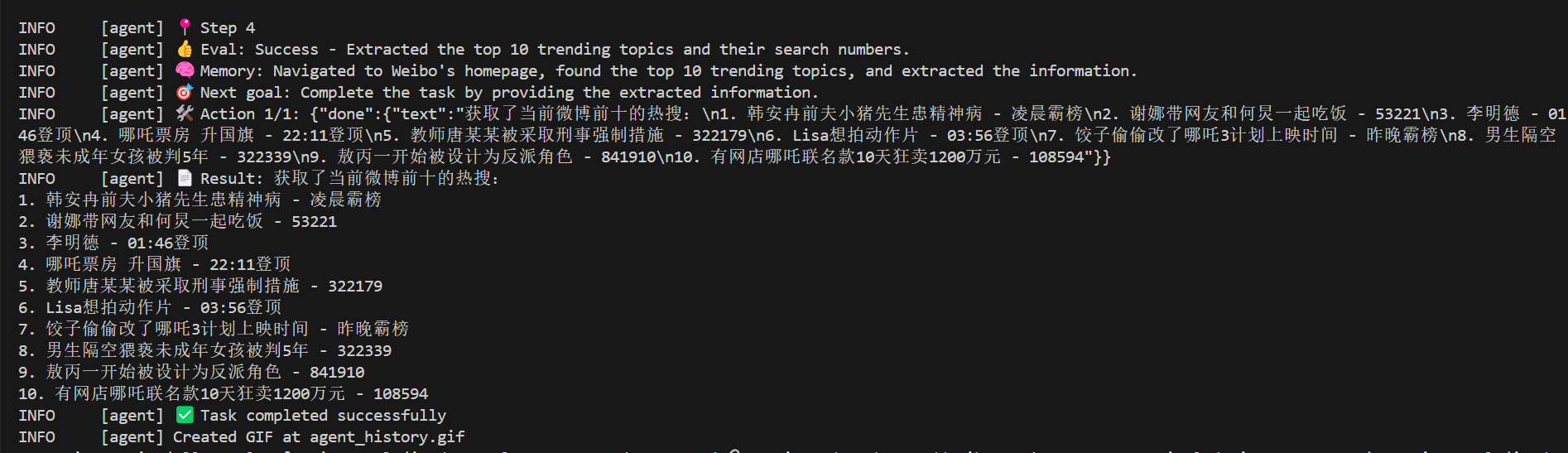

Perplexity

Perplexity 是怎么运作的?

简单来说,它在 LLM 之上包裹了自己的智能和处理逻辑,然后再把这些信息输入 LLM,以期望得到更好的结果。

在我的示例提示中,它先是写了一些 Python 代码片段来计算数值。然而,这一开始就是错误的。

然后,它把脚本和结果一起输入 DeepSeek,连同原始提示一并提供。

在 DeepSeek 的推理过程中,它分析代码来辅助自己的逻辑,但仍然常常得出不同的结果,并质疑输入数据。

由于 Perplexity 的原始输入数据本身就是错的,这让 DeepSeek 更难得出正确答案。所以,我一点都不惊讶 DeepSeek 最终认可了 Perplexity 计算出来的错误数值,因为从 DeepSeek 的角度来看,这些数值已经成了输入的一部分。

目前尚不清楚 Perplexity 是如何指示 DeepSeek 的,但它很可能包含某些语言指令,使得模型更优先考虑输入数据,而不是依赖自己的推理。

提示词

我承认我的提示词远非完美……如果所谓的完美提示词真的存在的话。更别说要让它在所有 LLM 上都能无缝运行了。

• 在本地运行时,我没有设置任何系统提示,也没有在 Claude/Perplexity 的运行中加入其他前言内容。

• 在其他实验中,我尝试过在提示词中分配角色,并加入对期权理论(Black-Scholes)和实际计算捷径的引用。然而,这些改变没有带来任何实质性提升 —— 结果中的错误仍然如本研究所示。

尽管这只是一个案例,并不是全面测试,但有几件事已经很清楚了。

商业应用?示例与陷阱

可能是我想象力不够丰富。

我们俩都看不出有哪个商业应用能在不投入大量工程时间和额外监控成本的情况下,利用推理模型构建出来。

最后的话

说实话 —— 炒作很疯狂,但现实是个马戏团。

相同的输入,输出却天差地别。没有所谓的唯一总结、唯一图片,或唯一代码。

这就像魔术。不是什么好魔术。

这就是为什么你会看到新闻说,某 AI 聊天机器人同意以 1 美元卖车。

你可能梦想着一个即插即用的解决方案。但实际上,你会花大价钱请工程师看护你的系统。你会花比使用它更多的时间来清理乱七八糟的数据。然后,还有无穷无尽的监控。哦,别提法律噩梦了。

![windows安装Oracle 12c [INS-32102] 指定的 Oracle 主目录用户已存在](https://img2024.cnblogs.com/blog/1018813/202502/1018813-20250212104358593-1923819740.png)