工具说明

- Telegraf:

- Telegraf 是一个用于收集、处理、聚合和写入指标、日志和其他任意数据的代理。

- 提供超过 300 个插件的综合套件,涵盖系统监控、云服务和消息传递等广泛功能

- 支持集成用户定义的代码,以高效地收集、转换和传输数据

- 编译为独立的静态二进制文件,无需任何外部依赖,确保简化部署流程。支持多种操作系统,Linux、Window皆可以使用

- 属于influxdata的开源项目https://github.com/influxdata/telegraf/tree/master

- Promtail:

- Promtail是一个代理,负责将本地日志内容发送到私有Grafana Loki实例或Grafana Cloud。它通常部署到运行需要监控的应用的每一台机器上。

- 提供发现目标、为日志流附加标签,并将数据推送到将它们推送到Loki实例。

- Promtail可以从两个来源跟踪日志:本地日志文件和systemd日志(在ARM和AMD64机器上)

- 天然的与Prometheus结合。也就是它主要就是Grafana家族用来做日志解析和推送的

为什么把这两个拿来比较,看起来Telegraf功能上是更强大一些,Promtail只是一个日志收集推送代理呢。但从日志解析功能上来说两个差不多,都是用表达式,支持正则来解析数据。

但是指标收集聚合功能上Telegraf就很强大,比如我们在不同的机器上有多个服务组件,如Redis、NGINX、Apache等,只需要在一个机器上运行Telegraf,并配置这些组件的地址等信息,就可以抓取并暴露指标,等待外部服务获取指标数据即可。而如果使用Grafana家族的,那就要在每个机器上安装不同的组件运行不同的exporter。

Telegraf配置

可以创建一个目录,然后在目录下按照不同的组件,创建不同的.conf文件,运行时指定配置文件目录即可。注意只是测试时,后面可配置为 --test、--debug

.\telegraf.exe --config-directory D:\NDev\telegraf-1.33.0_windows_amd64\telegraf-1.33.0\conf

这里用两个配置文件来举例:

-

一个收集Tomcat的Access日志的

[[inputs.tail]]name_override = "tomcat_log"files = ["D:/telegraf-1.33.0_windows_amd64/telegraf-1.33.0/sample/access.log"]from_beginning = truepipe = falsedata_format = "grok"grok_patterns = ["%{COMMON_LOG_FORMAT}(?: (?:%{NUMBER:cost_time:int}|-))?"]# 处理多行合并的情况,避免被一行行解析。对于解析业务日志很有用# [inputs.tail.multiline]# pattern = "^\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d{2}\.\d{3}"# preserve_newline = true# timeout = "3s" [inputs.tail.tags]_router_key = "tomcat_access"[[outputs.file]]## Files to write to, "stdout" is a specially handled file.files = ["stdout"][[outputs.prometheus_client]]listen = ":19360"collectors_exclude = ["gocollector"]关于Telegraf的具体各项插件和配置,上面连接的每个目录下都有详细说明。这里说一下上面的patterns的配置,因为用的是grok来解析的这里的COMMON_LOG_FORMAT是标准日志格式,相似的还有一个叫COMBIED_LOG_FORMAT(如果配置Nginx的access日志解析,直接使用这个即可)。

https://en.wikipedia.org/wiki/Combined_Log_Format

https://en.wikipedia.org/wiki/Common_Log_Formatgrok语法说明https://www.elastic.co/guide/en/logstash/current/plugins-filters-grok.html#_grok_basics,里面有很多预制的SYNTAX。基本语法%{SYNTAX:SEMANTIC} 或者 %{SYNTAX:SEMANTIC:TYPE}https://github.com/logstash-plugins/logstash-patterns-core/blob/main/patterns/legacy/grok-patterns

-

再给出一个简单的Redis的指标收集配置

# Read metrics from one or many redis servers [[inputs.redis]]servers = ["tcp://:mypass@192.168.3.35:6379"] [inputs.redis.tags]_router_key = "redis" [[outputs.prometheus_client]]listen = ":19450"collectors_exclude = ["gocollector", "process"] [outputs.prometheus_client.tagpass]_router_key = ["redis"]

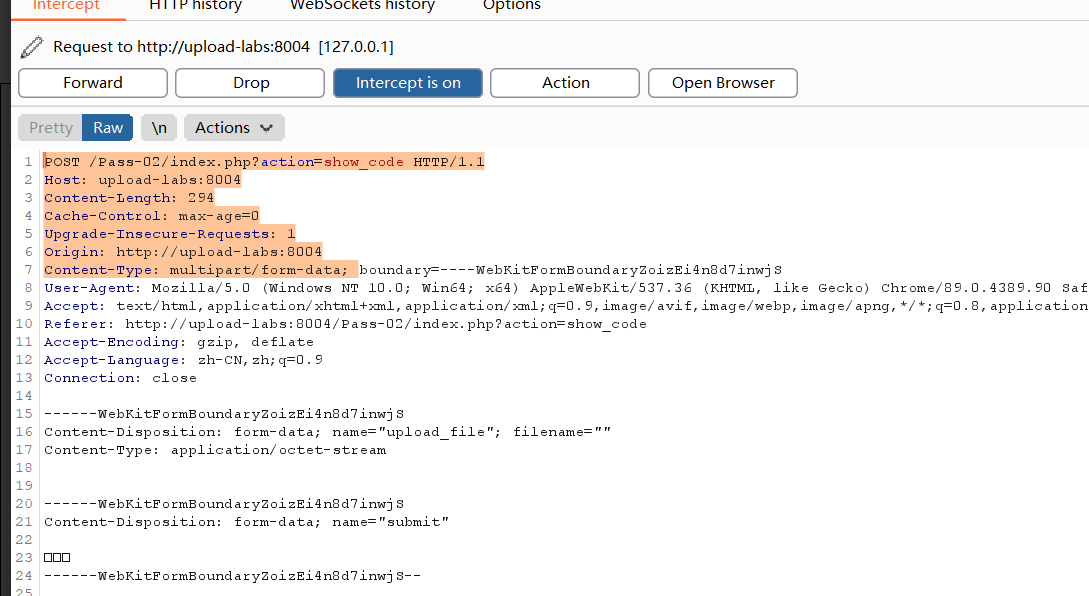

Promtail配置

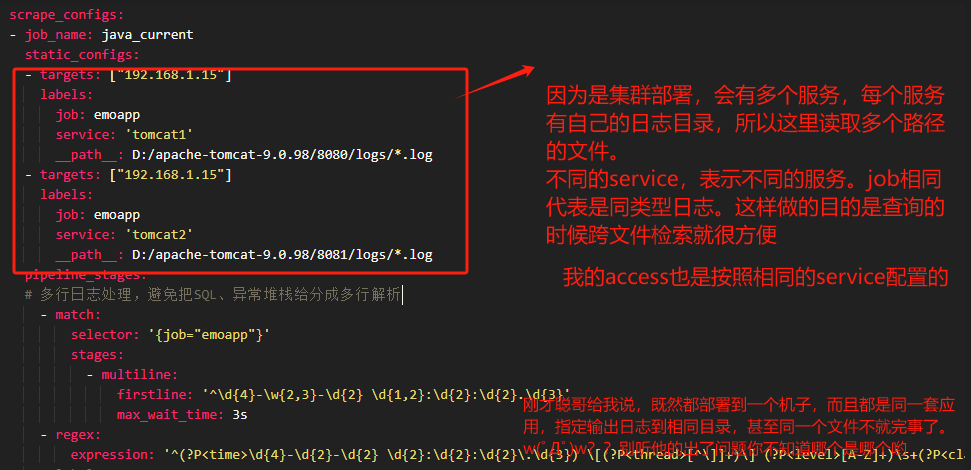

Promtail的配置是yaml格式的,这里举个配置的例子:里面读取了多个日志文件,并按照一定格式解析,最终推送到loki中

server:http_listen_port: 9080grpc_listen_port: 0# 是否启用运行时重新加载,重新加载,指标都将被重置。enable_runtime_reload: false

# positions 块配置 Promtail 将在何处保存一个文件,该文件指示它已读取文件多远。它是在 Promtail 重新启动时需要的,以允许它从停止的地方继续

positions:filename: D:\Loki-promtail\positions.yamlsync_period: 10sclients:- url: http://192.168.1.88:3100/loki/api/v1/pushscrape_configs:

- job_name: java_currentstatic_configs:- targets: ["192.168.1.15"]labels:job: emoappservice: 'tomcat1'__path__: D:/apache-tomcat-9.0.98/8080/logs/*.log - targets: ["192.168.1.15"]labels:job: emoappservice: 'tomcat2'__path__: D:/apache-tomcat-9.0.98/8081/logs/*.log pipeline_stages:# 多行日志处理,避免把SQL、异常堆栈给分成多行解析- match:selector: '{job="emoapp"}'stages:- multiline:firstline: '^\d{4}-\w{2,3}-\d{2} \d{1,2}:\d{2}:\d{2}.\d{3}'max_wait_time: 3s- regex:expression: '^(?P<time>\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d{2}\.\d{3}) \[(?P<thread>[^\]]+)\] (?P<level>[A-Z]+)\s+(?P<class>[^\s]+) (?P<line>\d+) - (?P<message>.*)$'- labels:level:thread:- timestamp:source: timeformat: '2006-01-02 15:04:05.000'location: "Local"- job_name: java_archivedstatic_configs:- targets: ["192.168.1.15"]labels:job: emoapp__path__: d:/logs/[0-9][0-9][0-9][0-9]-[0-9][0-9]-[0-9][0-9]/*.log- job_name: tomcatASstatic_configs:- targets: ["192.168.1.15"]labels:job: access__path__: D:\Tomcat 9.0\logs\localhost_access_log*.txtpipeline_stages:- regex:# tomcat的日志配置为pattern="%h %l %u %t "%r" %s %b %T"expression: '^(?P<remote_addr>\S+) - (?P<remote_user>\S+) \[(?P<time>[^\]]+)\] "(?P<request_method>\S+) (?P<request_url>\S+) (?P<http_version>\S+)" (?P<status_code>\d{3}) (?P<response_size>\d+|-)( (?P<request_time>\S+))?\r?$' - template:source: parsedJsontemplate: '{"remote_addr":"{{.remote_addr}}","time":"{{.time}}","request_method":"{{.request_method}}","request_url":"{{.request_url}}","status_code":"{{.status_code}}","body_size":"{{.response_size}}","request_time":"{{.request_time}}"}'# - labels:# request_url:# status_code:- timestamp:source: time# 格式化为与日志中的时间戳匹配format: '02/Jan/2006:15:04:05 -0700'- output:source: parsedJson多行日志处理

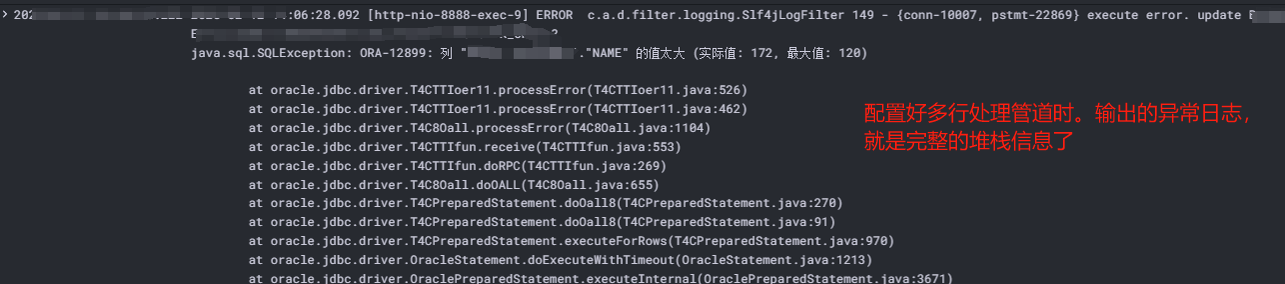

无论是Telegraf还是上面的Promtail中都加入了关于多行日志的处理,尤其是针对异常堆栈的展示,SQL的展示等等。

Promtail中multiline的配置,包括timestamp的配置都很重要,否则会解析不正常。

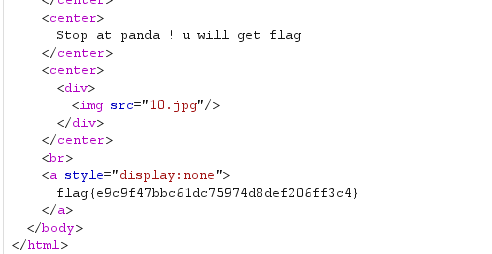

在Grafana中,通过loki输出信息图示(后面再抽空详细说明配置和实际使用):