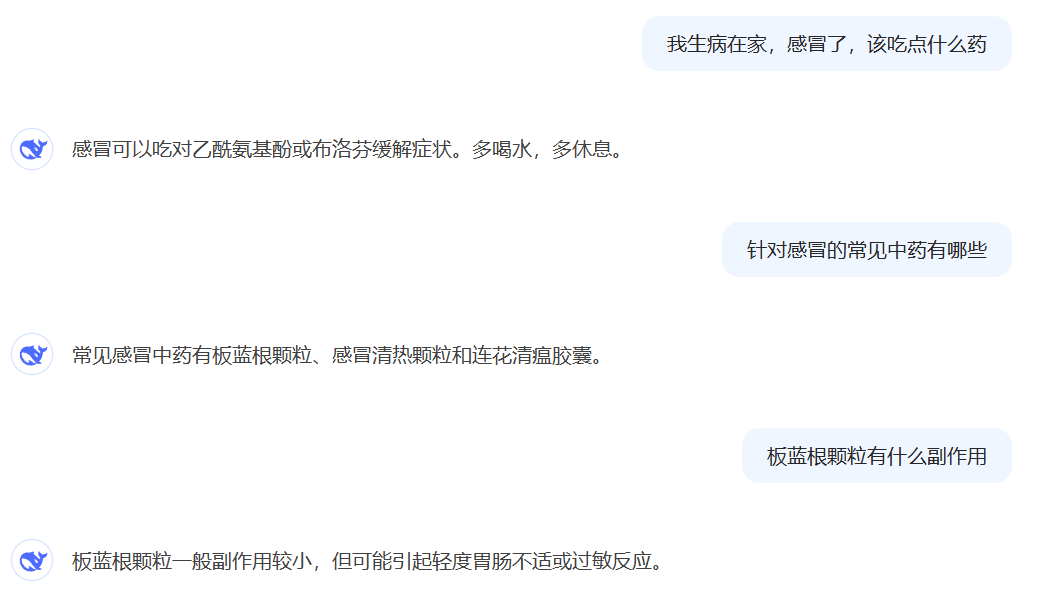

4.1 对话与问答

4.1.1 问答系统

问答系统(Question Answering System,QA System)是人工智能与自然语言处理领域的重要研究方向,旨在通过计算机技术实现对人类自然语言提问的精准理解与高效响应。与传统的搜索引擎不同,问答系统不仅需要检索相关信息,还需对问题进行语义解析、知识推理并生成简洁准确的答案,从而直接满足用户的信息需求。

系统组成与工作原理

一个典型的问答系统通常包含三大核心模块:自然语言理解(NLU)、知识检索与推理、答案生成与优化。首先,系统通过自然语言理解模块对用户输入的提问进行分词、句法分析和语义建模,识别问题类型(如事实型、推理型或主观型)及关键实体。例如,对于问题“珠穆朗玛峰的高度是多少?”,系统需提取“珠穆朗玛峰”作为实体,并判断其属于事实型提问。随后,系统结合知识图谱、数据库或文档库进行多源信息检索,并通过规则引擎、机器学习模型或深度学习算法(如Transformer)对候选答案进行相关性排序与逻辑验证。最终,答案生成模块将结构化数据转化为符合语言习惯的自然文本,并优化表述形式(如摘要、列表或完整句子),确保输出结果简明易懂。

- 首先是问题理解模块,这一模块的核心任务是对用户输入的自然语言问题进行深度剖析。它需要运用自然语言处理技术,如词法分析、句法分析和语义分析等,精准地提取问题中的关键信息,包括问题的主题、所涉及的实体以及问题的类型(例如 “是什么”“为什么”“怎么做” 等不同类型的提问)。只有准确理解了问题的含义,后续的信息检索和答案生成才有了明确的方向。

- 接下来是信息检索模块,它在庞大的数据资源库中承担着寻找潜在答案来源的重任。这些数据资源库可能包括结构化的知识图谱、半结构化的网页数据以及非结构化的文本资料等。信息检索模块会依据问题理解模块提取的关键信息,运用高效的检索算法,如基于关键词匹配的检索、基于语义相似度的检索等,快速定位与问题相关的文档或知识片段。这一过程犹如在浩瀚的知识海洋中精准定位到可能藏有答案的 “岛屿”,大大缩小了答案搜索的范围,提高了问答系统的效率。

- 随后是答案生成模块,这是问答系统中最为关键且富有挑战性的部分。它需要从信息检索模块筛选出的众多候选答案中,进一步提炼出最准确、最符合用户需求的答案。在这一过程中,自然语言生成技术发挥着重要作用,它能够将检索到的信息进行整合、组织,以通顺、自然的语言形式呈现给用户。例如,当用户询问 “太阳系中最大的行星是哪个”,答案生成模块不仅要从知识库中找到 “木星” 这一答案,还要将其以清晰、简洁的方式表述出来,如 “太阳系中最大的行星是木星,它的体积和质量都远超太阳系中的其他行星”。

技术分类与应用场景

根据技术实现方式,问答系统可分为基于规则的模板匹配系统、基于统计学习的检索式系统以及基于深度学习的端到端生成系统。早期系统多依赖人工设计的规则与模板,例如限定领域的客服机器人,通过关键词匹配返回预设回答。随着机器学习的发展,以BM25、TF-IDF为代表的检索模型能够从大规模文档中提取答案片段,广泛应用于知识库问答(如维基百科问答)。近年来,基于预训练语言模型(如BERT、GPT)的端到端系统通过语义编码与生成技术,显著提升了开放域问答的灵活性与准确率,典型应用包括智能助手(如Siri、小爱同学)、教育答疑平台和医疗诊断辅助系统。早期的QA其实是个检索问题,答案已经预制好了就在answer池里面,用户提问以后只需要匹配最合适的答案即可。后来,随着信息抽取这些基础NLP任务的提高,生成式QA得到了更多的应用。

在评估一个QA系统时,我刚刚提到:很多QA系统是以匹配为基准的模型设计架构,因此,信息检索(IR)领域常用的准确率、precision-recall都可以用,以及Top K也可以用。但与此同时还需要注意,因为QA的回答是生成文本,生成文本的质量就需要用生成式任务的一些评价指标来衡量了。对于早期QA系统,它的生成式回答通顺性是用BLEU、ROUGE等指标进行评估的,就和机器翻译很像。

挑战与发展趋势

尽管问答技术已取得显著进展,仍面临诸多挑战。首先,复杂问题的多跳推理(如“特朗普的第一任妻子毕业于哪所大学?”)要求系统具备跨文档的关联分析与逻辑推断能力。其次,领域适应性不足、长尾问题覆盖有限、答案可解释性弱等问题制约了实际落地效果。此外,多模态问答(结合文本、图像、视频)与个性化问答(基于用户历史交互的上下文理解)成为新兴研究方向。未来,随着大模型技术与知识增强方法的融合,问答系统将进一步向人性化、专业化与场景化演进,成为人机协同的核心交互载体。

4.1.2 聊天机器人

对话系统(Dialogue System)与聊天机器人(Chatbot)是人工智能技术在人机交互领域的核心应用之一,其目标是通过自然语言实现机器与人类之间的多轮、动态且情境化的交流。与传统的单轮问答系统不同,对话系统需具备上下文理解、意图延续、情感感知及个性化反馈等能力,能够模拟人类对话的连贯性与灵活性,广泛应用于客服、教育、医疗、娱乐等场景。

系统架构与核心机制

一个完整的对话系统通常由自然语言理解(NLU)、对话管理(DM)、自然语言生成(NLG) 三大模块构成。用户输入的自然语言首先经过自然语言理解模块,通过实体识别、意图分类(如请求、咨询、闲聊)及情感分析转化为结构化语义表示。例如,用户提问“明天北京的天气怎么样?”会被解析为“意图:查询天气;实体:北京、时间:明天”。随后,对话管理模块基于上下文历史、领域知识库及用户画像,决定系统应采取的策略(如追问细节、切换话题或调用外部API)。例如,若用户补充“带伞需要吗?”,系统需关联前序对话中的“天气查询”意图,进一步调用湿度或降水概率数据。最终,自然语言生成模块将结构化决策转化为符合语法、语境与用户风格的自然语言回复,并融入口语化表达或情感修饰(如“明天北京有阵雨,记得带伞哦!”)。

技术演进与类型划分

根据技术路径,对话系统可分为基于规则与模板的系统、检索式系统及生成式系统。早期系统依赖人工编写的对话流程与固定模板,例如电话银行中的菜单导航,其交互范围受限但可控性强。检索式系统通过匹配用户输入与预存对话库中的候选回答(如聊天记录、电影台词)实现交互,常见于社交娱乐机器人(如微软小冰)。而基于深度学习的生成式系统(如GPT、LaMDA)利用序列到序列(Seq2Seq)模型、注意力机制及强化学习,能够动态生成新颖回复,支持开放域对话的多样性与创造性。此外,混合式系统结合检索与生成技术,在保证安全性的同时提升应答丰富度,逐渐成为主流方案。

应用挑战与未来方向

当前对话系统仍面临多重挑战。在技术层面,长程上下文依赖(如多轮对话中的指代消解)、领域迁移能力(如从医疗咨询切换到购物场景)及隐性意图识别(如用户未明确表达的深层需求)是主要瓶颈。在伦理与实用层面,生成内容的偏见控制、用户隐私保护及错误应答的风险管理亦需持续优化。未来,随着多模态交互(融合语音、图像、手势)、个性化自适应学习(基于用户行为实时更新模型)及知识增强技术(结合领域专家系统)的发展,对话系统将逐步突破“工具性交互”的局限,向“情感化伙伴”与“专业化顾问”演进,成为人机共生的关键纽带。

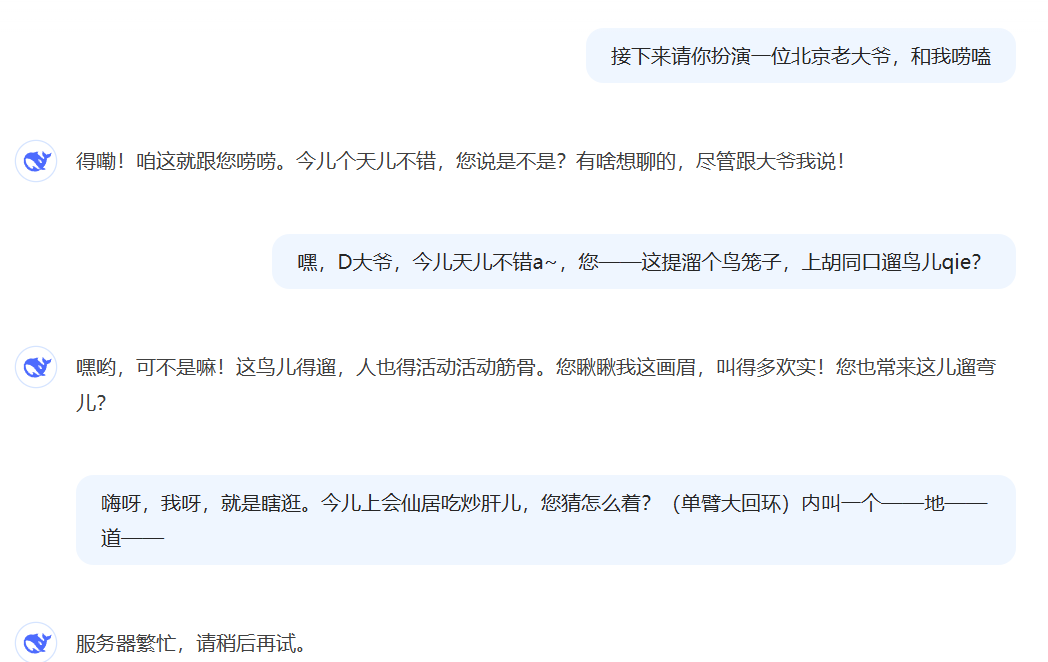

看来deepseek的北京话,还是不太行,都给干蒙了。

4.2 文本阅读

4.2.1 机器阅读理解

机器阅读理解(Machine Reading Comprehension, MRC)是自然语言处理领域的核心任务之一,旨在使计算机通过理解文本内容,针对特定问题生成准确答案或推理结果。其本质是模拟人类阅读与信息提取能力,要求机器从给定的篇章中识别语义关联、逻辑结构及隐含知识,并基于此完成问题求解。例如,给定一段关于“光合作用”的科普文本,系统需回答“植物通过什么过程将光能转化为化学能?”,答案需精准定位原文中的关键描述或通过推理得出结论。

机器阅读理解任务的评估通常围绕答案的准确性与完整性展开。常用指标包括精确匹配(Exact Match, EM)和模糊匹配(F1值),前者要求答案与标注完全一致,后者则衡量词汇重叠度;对于需推理的开放性问题,还需结合人工评价判断逻辑合理性。技术难点主要体现在三方面:一是篇章与问题的语义对齐,尤其是代词指代、省略补全等上下文依赖问题;二是多步推理能力,如从分散段落中整合信息并推导答案(如“某事件的原因与结果分别是什么?”);三是领域泛化性,即模型在训练数据未覆盖的主题或文体中表现易显著下降。

基于深度学习的机器阅读理解发展经历了从传统特征工程到端到端模型的演变。早期方法依赖规则模板与统计模型(如支持向量机),通过人工设计特征(如词性、句法树)匹配问题与篇章片段。随着神经网络的兴起,2016年后,以注意力机制为核心的模型(如BiDAF)逐步成为主流,其通过编码器-解码器架构实现问题与篇章的动态交互,显著提升语义建模能力。2018年后,预训练语言模型(如BERT、RoBERTa)通过大规模无监督学习捕获深层语言规律,进一步推动MRC性能突破。例如,BERT采用掩码语言建模与下一句预测任务,使模型在微调阶段能快速适应特定阅读理解任务,并在SQuAD等基准数据集上接近人类水平。

大语言模型(LLMs)的出现为机器阅读理解带来了范式革新。以GPT-3、PaLM为代表的生成式模型,凭借千亿级参数与海量训练数据,展现出强大的零样本(Zero-shot)与小样本(Few-shot)学习能力。此类模型无需针对特定任务进行精细微调,仅通过提示(Prompt)设计即可完成复杂推理,例如从长文档中提取答案并解释依据。此外,大模型通过思维链(Chain-of-Thought)技术可模拟多步推理过程,解决传统MRC中难以处理的数学推导或因果分析问题。当前研究方向聚焦于增强模型的可解释性(如可视化注意力权重)、减少幻觉(即生成与原文矛盾的答案)以及多模态扩展(如图文结合的理解与推理),推动机器阅读理解向更通用、鲁棒的人机协作工具演进。

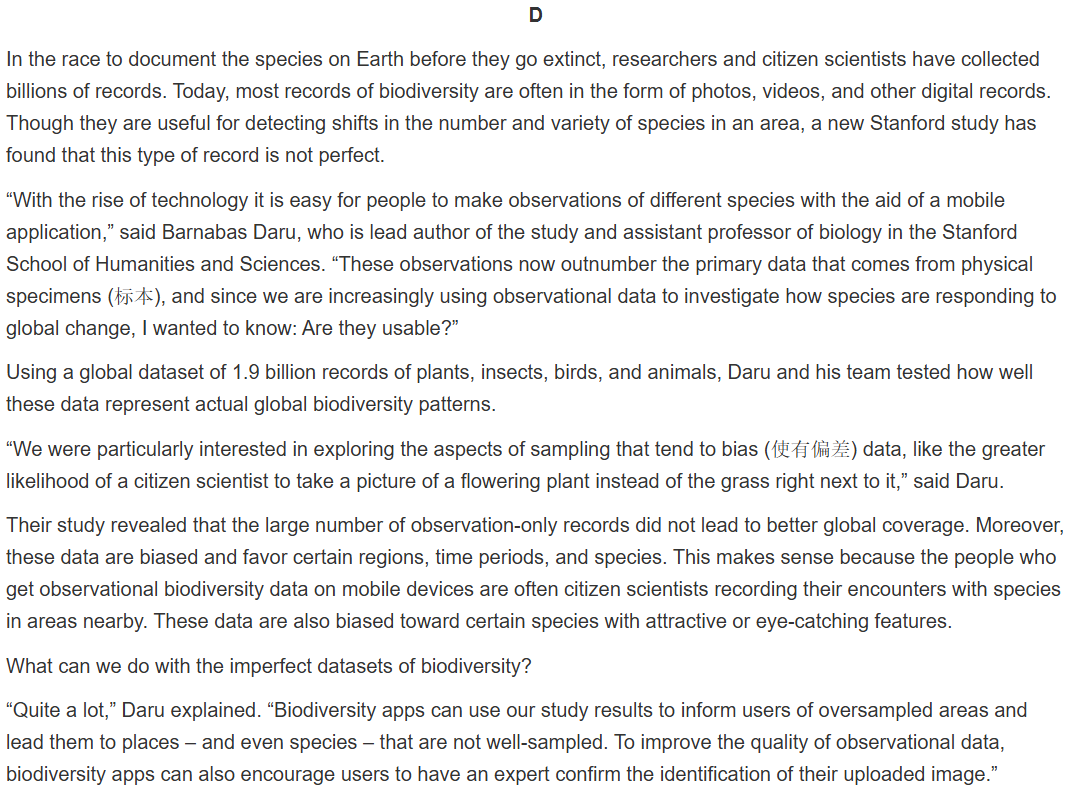

让我们来试试让大模型做点高考题看看准确率:

user-prompt:假设你现在是一个在高考考场上的考生,下面两张图是阅读理解的文章和题目,请你运用你的英语语言能力和逻辑能力做一做这四道题并返回你的答案。

让我们来看看AI的回复:

Okay, let's tackle these questions one by one. First, I'll read through the article again to make sure I understand the main points. The article is about how researchers and citizen scientists are collecting billions of biodiversity records, mostly in digital form like photos and videos. However, a Stanford study found that these records have biases and don't represent global biodiversity well. The study by Barnabas Daru looked at 1.9 billion records and found that the data favors certain regions, times, and species because citizen scientists tend to take pictures of more attractive or noticeable species. The article also mentions that biodiversity apps can use the study's results to guide users to less sampled areas and species, and encourage expert confirmation of uploaded images.Now, let's look at question 32: "What do we know about the records of species collected now?" The options are A. They are becoming outdated, B. They are mostly in electronic form, C. They are limited in number, D. They are used for public exhibition. From the first paragraph, it says "Today, most records of biodiversity are often in the form of photos, videos, and other digital records." So that clearly supports option B. The other options aren't mentioned as facts in the article. So I'm pretty confident that the answer is B.Next, question 33: "What does Daru's study focus on?" The options are A. Threatened species, B. Physical specimens, C. Observational data, D. Mobile applications. The article mentions that Daru and his team used a global dataset of 1.9 billion records of plants, insects, birds, and animals to test how well these data represent actual global biodiversity patterns. It also says they were interested in exploring aspects of sampling that bias data, like citizen scientists taking pictures of certain species. So the study is focused on observational data, which is option C. The other options aren't the main focus of the study. So I think the answer is C.Moving on to question 34: "What has led to the biases according to the study?" The options are A. Mistakes in data analysis, B. Poor quality of uploaded pictures, C. Improper way of sampling, D. Unreliable data collection devices. The article states that the study revealed biases in the data because citizen scientists are more likely to take pictures of certain species, like flowering plants instead of grass. This is an improper way of sampling, which is option C. The other options aren't mentioned as causes of bias in the article. So I believe the answer is C.Finally, question 35: "What is Daru's suggestion for biodiversity apps?" The options are A. Review data from certain areas, B. Hire experts to check the records, C. Confirm the identity of the users, D. Give guidance to citizen scientists. The article says that biodiversity apps can use the study's results to inform users of oversampled areas and lead them to less sampled places and species. It also mentions encouraging users to have an expert confirm the identification of their uploaded image. So the suggestion is to give guidance to citizen scientists, which is option D. The other options aren't directly stated as Daru's suggestions. So I think the answer is D.

After going through each question carefully and referring back to the article, I feel confident about these answers.Answer:

B. They are mostly in electronic form.

C. Observational data.

C. Improper way of sampling.

D. Give guidance to citizen scientists.

答案全是对的。这说明,大模型不仅能处理基本的语言要素,对于复杂的长文本语义逻辑,也能很快定位到线索。不仅理解语义,还能进行简单的推理。这才是真正的智能。现在,大家应该知道人工智能时代第一个被干掉的职业是什么了吧(笑)。

4.2.2 逻辑推理

在自然语言处理领域,自然语言模型中的逻辑推理是一个极具挑战性且富有前景的研究方向。它旨在赋予机器理解和运用逻辑推理的能力,使其能够在面对复杂的自然语言文本时,像人类一样进行合理的推断和判断。

从任务定义来看,自然语言模型中的逻辑推理任务通常是指给定一段文本或一系列陈述,模型需要根据已有的知识和逻辑规则,推断出文本中隐含的信息、判断陈述之间的逻辑关系,或者对特定问题给出合乎逻辑的答案。例如,在阅读理解任务中,模型不仅要理解文本的表面意义,还要能够通过逻辑推理挖掘文本背后的深层含义,回答诸如 “根据文章内容,可以推断出作者对某个观点的态度是……” 这样的问题。再如,在知识图谱问答任务中,模型需要依据知识图谱中的实体关系和逻辑规则,对用户提出的复杂问题进行推理,从而得出准确的答案。

然而,实现自然语言模型中的有效逻辑推理面临着诸多难点。首先,自然语言的复杂性和模糊性给逻辑推理带来了巨大挑战。人类语言中存在着大量的歧义、隐喻、委婉语等现象,这些都使得文本的语义理解变得困难重重,进而影响逻辑推理的准确性。例如,一句话可能有多种不同的解读,模型需要根据上下文和常识知识来确定最合理的语义理解,才能进行正确的逻辑推理。其次,逻辑推理往往需要依赖大量的背景知识和领域知识。在现实世界中,各种事物之间存在着错综复杂的关系,模型需要具备足够的知识储备才能做出合理的推断。然而,目前的知识获取和知识表示仍然是自然语言处理中的难题,如何让模型有效地学习和运用这些知识进行逻辑推理是一个亟待解决的问题。此外,逻辑推理的深度和多样性也是一个难点。有些逻辑推理可能只需要简单的一步推断,而有些则需要多步复杂的推理过程,模型需要具备足够的推理能力和灵活性来应对不同类型的逻辑推理任务。

在技术发展脉络方面,早期的自然语言模型主要基于规则的方法来实现逻辑推理。研究人员通过手工编写大量的语法规则和逻辑规则,让模型根据这些规则对文本进行分析和推理。然而,这种方法存在明显的局限性,规则的编写往往依赖于专家知识,难以覆盖自然语言中的各种复杂情况,而且规则之间的相互冲突和组合也使得模型的可扩展性和适应性较差。随着机器学习技术的发展,基于统计的方法逐渐兴起。这种方法通过从大量的标注数据中学习文本的统计规律和模式,从而实现逻辑推理。例如,利用条件随机场、隐马尔可夫模型等统计模型来对文本中的序列标注和结构化预测任务进行建模,进而进行逻辑推理。虽然这种方法在一定程度上提高了模型的性能,但它仍然面临着数据稀疏性和泛化能力不足的问题。

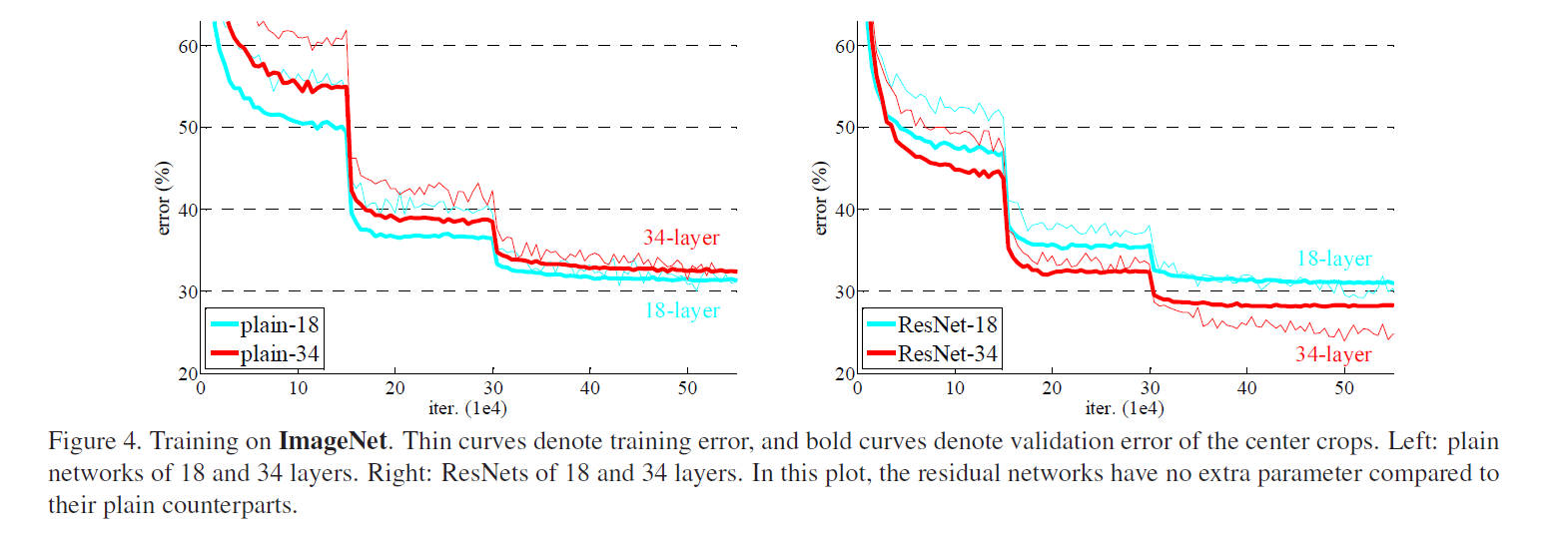

近年来,深度学习技术的迅猛发展为自然语言模型中的逻辑推理带来了新的突破。神经网络模型,尤其是基于Transformer架构的预训练语言模型,如BERT、GPT等,在自然语言处理的各个任务中都取得了显著的成果。这些模型通过在大规模的无监督文本上进行预训练,学习到了丰富的语言知识和语义信息,为逻辑推理任务提供了强大的基础。研究人员通过对这些预训练模型进行微调,使其能够适应特定的逻辑推理任务。例如,在自然语言推理任务中,通过在预训练模型的基础上添加一个分类层,并在标注的推理数据集上进行微调,模型就能够根据文本之间的语义关系进行逻辑推理,判断文本之间的蕴含、矛盾或中立关系。此外,为了进一步提高模型的逻辑推理能力,研究人员还在不断探索将符号主义和连接主义相结合的方法。一方面,利用神经网络模型的学习能力和表示能力来自动学习逻辑规则和知识表示;另一方面,引入符号逻辑和知识图谱等结构化的知识来增强模型的推理能力和可解释性。例如,通过将知识图谱嵌入到神经网络模型中,使模型能够在进行逻辑推理时充分利用知识图谱中的实体关系和逻辑规则,从而提高推理的准确性和可靠性。

总之,自然语言模型中的逻辑推理是一个充满挑战和机遇的研究领域。尽管目前还面临着诸多难点,但随着技术的不断发展和创新,相信未来自然语言模型将能够更好地理解和运用逻辑推理,为各种自然语言处理应用提供更加强大和智能的支持。

让我们来通过几个复杂逻辑谜题来探索一下LLM在逻辑问题上的表现吧。

甲、乙、丙、丁四个人上大学的时候在一个宿舍住,毕业10年后他们又约好回母校相聚。老朋友相见分外热情。四个人聊起来,知道了这么一些情况:只有三个人有自己的车 ;只有两个人有自己喜欢的工作;只有一个人有了自己的别墅;每个人至少具备一样条件;甲和乙对自己的工作条件感觉一样;乙和丙的车是同一牌子的;丙和丁中只有一个人有车。如果有一个人三种条件都具备,那么,你知道他是谁吗 ?

大模型开始推理:

这个问题开始把LLM脑袋干懵了,很推理了一些时间。但是这比纯QA语言模型无脑出结果而言,有了一个思维和逻辑推理,真的有一些具备“类人”智慧了。

**答案:丙****解析:**

根据题目条件逐一分析如下:1. **车辆分配**: - 共有3人有车,且丙和丁中仅1人有车。 - 若丙有车,则丁无车;乙与丙车同品牌,故乙也必有车。剩余1车需分配给甲,因此**甲、乙、丙有车**,丁无车。2. **工作分配**: - 共有2人有喜欢的工作。 - 甲和乙工作状态相同,若两人都有工作,则已占满名额,丙、丁无工作。但丁无车,需至少满足一个条件(别墅),但别墅仅1人拥有,可能导致矛盾。 - 若甲和乙均无工作,则工作由丙、丁承担。此时丙有车且需有工作,丁无车但需有工作或别墅。3. **别墅分配**: - 仅1人有别墅。若丙拥有别墅,则其具备车、工作、别墅三种条件,满足题目要求。 - 丁无车,但需至少有一个条件,故丁必须有工作(与丙同为工作者)。**最终结论**:

- **丙**同时拥有车(与乙同品牌)、工作(与丁共同)、别墅,符合“三种条件均具备”的要求。

- 其他条件验证:甲、乙有车但无工作;丁有工作但无车;所有个体至少满足一个条件,无冲突。 因此,唯一满足所有条件的人为**丙**。

换个弱智吧问题,看看如果没有深度思考与推理,deepseek还能这么机智吗?

user-prompt: 被门夹过的核桃还能补脑吗?

deepseek: 被门夹过的核桃仍然可以补脑,但其效果和安全性可能受到一定影响。以下是具体分析:1. **营养价值**:核桃的营养成分主要包含不饱和脂肪酸、蛋白质、维生素和矿物质等,这些成分在核桃被夹后通常不会发生显著变化。因此,从营养角度来看,被夹过的核桃仍然具有补脑的作用。2. **物理状态**:如果核桃被夹后外壳破裂,果肉暴露在外,可能会受到污染或氧化,导致营养价值下降或产生有害物质。因此,食用前需要检查核桃是否完好,避免食用变质的部分。3. **安全性**:如果核桃被夹后外壳破损,可能会滋生细菌或霉菌,食用后可能对健康造成影响。因此,建议在食用前仔细检查核桃的状态,确保其安全。总结来说,被门夹过的核桃在未受污染或变质的情况下,仍然可以补脑,但需注意其物理状态和安全性。如果核桃外壳破损或果肉暴露,建议谨慎食用。

你看,这就很无聊了。完全没get到我的幽默。

4.3 文本生成

4.3.1 摘要生成

文本摘要作为自然语言处理领域中的关键技术,旨在将长篇文本的核心内容以简洁、精炼的形式呈现给用户。这一任务不仅能够帮助人们快速获取信息,还能在信息过载的时代中提高阅读效率。文本摘要的实现方式主要分为抽取式摘要和生成式摘要两大类,每种方法都有其独特的任务定义、难点和技术发展脉络。

从任务定义来看,抽取式摘要的任务是从原始文本中直接选取关键句子或短语,按照一定顺序组合成摘要。这种方法的核心在于如何准确地识别和选择那些能够代表原文核心内容的句子或短语。例如,在一篇新闻报道中,抽取式摘要可能会选取包含关键事件和主要人物的句子,直接组合成摘要,以确保摘要内容的真实性和可靠性。生成式摘要则不同,它的任务是基于对原文的理解,生成全新的句子来表达核心内容。这种方法不仅需要准确理解原文,还需要具备一定的语言生成能力,以确保生成的摘要既准确又通顺。例如,在学术论文中,生成式摘要可能会用简洁的语言重新表述研究的目的、方法和结论,而不是直接引用原文的句子。

文本摘要技术的难点主要集中在以下几个方面。首先,自然语言的复杂性和多样性给文本摘要带来了巨大的挑战。语言中存在大量的同义词、多义词以及复杂的句式结构,这些都增加了理解和处理文本的难度。例如,同一个意思可以用不同的词汇和句式来表达,模型需要具备足够的语言理解能力才能准确识别和处理这些情况。其次,信息抽取和筛选的难度也不容忽视。在长篇文本中,如何从大量信息中准确地抽取关键内容,并按照逻辑顺序进行组织,是一个复杂的过程。这不仅需要模型具备良好的文本分析能力,还需要有一定的逻辑推理能力。此外,生成式摘要还面临着语言生成的挑战。生成的摘要不仅要准确传达原文的核心内容,还要保证语言的流畅性和可读性,这对模型的语言生成能力提出了很高的要求。

从技术发展脉络来看,抽取式摘要的发展经历了多个阶段。早期的抽取式摘要方法主要基于统计和规则,例如通过计算词频、句频等统计信息来确定关键句子。这些方法简单直观,但往往缺乏灵活性和准确性。随着机器学习技术的发展,基于机器学习的方法逐渐兴起,例如利用支持向量机、朴素贝叶斯等算法对句子进行分类和排序,从而选取关键句子。这些方法在一定程度上提高了摘要的质量,但仍存在一些局限性。近年来,随着深度学习技术的迅猛发展,基于深度学习的抽取式摘要方法取得了显著的成果。例如,利用循环神经网络(RNN)和长短期记忆网络(LSTM)对文本进行编码和解码,能够更好地捕捉文本的语义信息和上下文关系,从而提高关键句子的抽取效果。

生成式摘要的发展也经历了类似的过程。早期的生成式摘要方法主要基于模板和规则,通过预定义的模板和规则生成摘要,这种方法的灵活性和适应性较差。随着深度学习技术的发展,基于深度学习的生成式摘要方法逐渐成为主流。例如,利用序列到序列(Seq2Seq)模型和生成对抗网络(GAN),能够自动生成流畅、准确的摘要。这些模型通过学习大量的文本数据,能够更好地理解文本的语义和结构,从而生成高质量的摘要。

综上所述,文本摘要技术在自然语言处理领域中具有重要的地位和广泛的应用前景。抽取式摘要和生成式摘要作为文本摘要的两大主要方法,各有其特点和优势。抽取式摘要通过直接选取原文中的关键句子或短语,保证了摘要的真实性和可靠性;生成式摘要则通过生成全新的句子,能够更灵活、更准确地表达文本的核心内容。随着技术的不断发展,文本摘要技术将在更多领域发挥重要作用,为人们提供更加高效、便捷的信息获取方式。

我们可以拿一篇长文章来试试大语言模型的摘要写作能力:

模型这样回答:

The article discusses whether comprehension is the same when reading onscreen versus on paper and whether listening to or viewing content is as effective as reading. It concludes that generally, comprehension is better when reading on paper, especially for longer texts and tasks requiring mental abstraction. The benefits of print reading are attributed to both the physical properties of paper, such as the tactile experience and visual geography of pages, and the mental aspect, where people tend to concentrate more on print than on digital texts. The "shallowing hypothesis" suggests that people approach digital texts with a less serious mindset, leading to reduced mental effort. While audio and video can be engaging, studies show that adults remember more content when reading than when listening to or viewing it. The article emphasizes that while digital media have educational roles, educators should not assume all media are equally effective for learning that requires focus and reflection.

似乎还有点长了,我还希望进一步精简:

The article states that reading on paper generally leads to better comprehension, especially for longer texts and tasks needing mental abstraction. This is due to the physical feel of paper and a more focused mindset. In contrast, digital reading often results in a less serious approach and reduced mental effort. While audio and video can be engaging, they are less effective for retention compared to reading. Educators should recognize that different media have distinct impacts on learning and not treat them as equally effective.

这下就更加精简了。但可能有同学会说:这种玩具式的任务怎么能应用到实际工作中呢?别急,大家打过数学建模竞赛吧?我是教这个的。我拿怎么写大论文和比赛论文摘要为例给大家展示一下大模型对document-level text生成摘要的能力:

user-prompt:

假设你是参加中国研究生数学建模竞赛的一个选手,需要写一篇数学建模比赛论文。现在你和你的队友已经一起把正文部分写好了,现在需要写摘要。我下面将会提供一个好的摘要示例,请你仿照示例对我提供的文件生成一篇好的摘要。

---

**示例摘要**

在无线局域网(WLAN)的广泛部署中,尤其是在高密度场景下,网络吞吐量成为评估系统性能的关键指标。然而,以往的研究并未对网络拓扑结构、节点间接收信号强度(RSSI)、信道接入机制以及干扰等因素对数据传输速率和吞吐量的影响进行深入分析,存在简化模型和理想化条件的局限性。如何准确预测和优化WLAN系统的吞吐量,成为当前亟待解决的关键问题。基于此,本文对以下问题进行探究。

对于问题一,这是一个回归问题,需要对AP发送机会也就是对Seq_time进行预测。针对这一问题,提出了APSelector模型,基于改进粒子群算法将特征重要性、模型性能、计算负载、网络环境视作优化目标,计算负载降低了15%。为了提高预测精度,设计了一种基于改进梯度提升树模型的方法,达到R2为0.89。但这一方法仍然面临高维稀疏数据与不定长序列场景下的挑战。对此,从真实物理场景的角度出发,提出了基于马尔可夫随机过程的MAC帧引导的数据流传输时间修正模型,将预测模型的R2分数提高到0.93。最终得到的CDF曲线中,当P>0.9时我们的误差值为0.2731。

对于问题二,这是一个分类问题。在对数据的分析过程中,发现样本失衡问题显著,这种现象会降低模型性能。针对这一问题,提出了基于改进CTGAN算法进行面向网络场景下的数据增强方法,基于生成对抗网络实现数据增强,将分类模型的F1分数分别从0.50和0.63均提升至0.95以上。与此同时,为了提高分类器预测性能,通过蒙特卡洛搜索法针对发送机会进行有约束优化,发现这一框架同时促进了分类模型和回归模型的性能,F1分数分别进一步提高了0.012和0.025,seq_time的回归模型R2分数提高了0.04。

对于问题三,这是一个回归问题。前面的分析成果实现了对系统吞吐量的建模与预测,这对网络规划、资源调度和性能优化提供了科学依据。但通过对模型的进一步分析发现,模型在处理时空特性数据时存在局限性,因此,设计了一种基于STGCN的节点RSSI时空信息表示模型,将时空特征引入模型从而实现了对系统吞吐量的更准确预测,R2达到了0.96742。最终得到的CDF曲线中,当P>0.9时我们的误差值为0.3780。

模型的建立与求解,不仅提高了WLAN系统吞吐量预测的准确性,而且能面向实际网络部署实现性能优化,具有重要的现实意义。相关预测结果已经写入附件中。关键词:WLAN,系统吞吐量预测,改进粒子群算法,改进梯度提升树模型,马尔可夫随机过程,CTGAN,蒙特卡洛搜索法,STGCN

---

**解析**:摘要采用了总分总结构

- 第一段是总括段,开头先介绍问题背景,然后迅速笔锋一转切入研究意义问题上来。紧接着,开始引出本文对这几个问题的研究。

- 第二段开始分论点,先开门见山直接说问题一的问题类型(也就是作者对问题的分析与洞察,或者说一个定性)。然后,作者分析了问题的技术难点,针对具体的问题(这很重要,是学术论文的核心,论文的根本就是解决问题)用了什么方法、为什么用这种方法、达到了怎样的效果、反映了怎样的问题。

- 后面几段分论点非常类似。写作过程中比较细节,对整个实验流程有一个整体把握,并且在环节中出现的问题进行了探讨,给出了自己的技术方案创新。

- 最后一段收束总结,完成总分总的闭环,对整个工作进行了客观评价,点出研究意义。

- 最后带上几个核心关键词。

---

请根据上面的要求和示例,为我给你的文件撰写摘要。

这种带有明确的结构化、场景化的提示,还附带少量案例作为上下文信息,并且告诉了案例的判断与推理标准,这种设计模式就是一种思维链(CoT)。让我们看看R1模型的生成结果会怎么样,我们拿2022年全国大学生数学建模竞赛A题的一篇文章来试试:

在波浪能利用研究中,如何通过动力学分析获取波浪能装置的最大能量转化功率是一个关键问题。本文针对浮子和振子构成的波浪能装置,通过构建和求解二阶常微分方程组,结合元启发算法,对不同运动情况下的能量转化功率进行了深入分析。

对于问题一,这是一个动力学建模与数值求解问题。通过分析浮子和振子在垂荡运动中的受力情况,基于牛顿第二定律构建了动力学方程组。利用改进欧拉法对二阶常微分方程组进行数值推演,得到了浮子和振子在40个波浪周期内的位移和速度变化关系,结果表明系统呈现周期性运动。

对于问题二,这是一个参数优化问题。在问题一的基础上,通过建立数学模型,利用遗传算法和模拟退火算法对直线阻尼器的最优阻尼系数进行求解。结果表明,模拟退火算法的收敛速度更快,能够得到更高的平均输出功率。情形一的最优功率为228.89W,对应最优阻尼系数37000;情形二的最优功率为235W,对应最优阻尼系数比值41800,幂指数0.05。

对于问题三,这是一个扩展到纵摇运动的复杂动力学问题。在考虑浮子和振子的垂荡和纵摇运动后,构建了包含角动量定理的多元二阶常微分方程组。由于浮子旋转时浮力变化难以求解,采用蒙特卡洛模拟方法求解浮力与倾角和浮子质心高度之间的关系。通过数值求解,得到了浮子和振子在40个波浪周期内的垂荡位移、速度以及纵摇角度和角速度。

对于问题四,这是一个联合优化问题。在问题三的基础上,通过建立数学模型,利用遗传算法和模拟退火算法对直线阻尼器和旋转阻尼器的最优阻尼系数进行联合求解。结果表明,最优功率为364.5W,直线阻尼器的最优阻尼系数为61400,旋转阻尼器的最优阻尼系数为100000。

通过灵敏度分析,发现振子的质量和弹簧的弹性系数对最优功率有显著影响。适当减小振子的质量或弹簧弹性系数可以显著提升最优功率。本文构建的模型不仅在数值求解上保证了一定精度,还与实际物理过程相契合,具有重要的参考价值和实际应用意义。

关键词:波浪能,动力学分析,数值求解,遗传算法,模拟退火算法,蒙特卡洛模拟

我们发现:还可以诶!对吧,就这样的这种提示词模式,给大模型,它能成为你很好的学术小助手。

4.3.3 文本写作

文本生成与写作是自然语言处理领域中的重要任务之一,它旨在让计算机能够自动生成符合人类语言习惯、具有特定主题和逻辑结构的文本。这一技术在众多领域都有着广泛的应用,如自动写作新闻报道、生成故事、撰写技术文档、创建聊天机器人回复等,不仅能够提高文本创作的效率,还能在一定程度上保证文本的质量和连贯性。

从任务定义来看,文本生成与写作的核心是根据给定的输入信息,如主题、关键词、上下文等,生成一段通顺、连贯且有意义的文本。输入信息可以是多样化的,例如,给定一个新闻事件的标题和相关要点,生成一篇完整的新闻报道;或者给定一个故事的开头和一些情节线索,生成后续的故事内容。任务的关键在于模型需要理解输入信息的含义,并将其转化为符合语言规则和逻辑结构的自然语言表达。

然而,文本生成与写作面临着诸多难点。首先,自然语言的复杂性和多样性给文本生成带来了巨大的挑战。人类语言中存在着丰富的词汇、多样的句式结构以及复杂的语义关系,模型需要准确地掌握这些语言要素,并能够根据具体的语境灵活运用。例如,在生成新闻报道时,模型需要使用正式、客观的语言风格,而在生成故事时,则需要更具创意和生动性的表达。其次,保证文本的连贯性和逻辑性也是一个难点。生成的文本不仅要句子通顺,还要在段落和篇章层面保持连贯,使读者能够清晰地理解文本所传达的信息和观点。此外,文本生成还需要考虑到文本的创造性和多样性,避免生成千篇一律的内容,这对于模型的创新能力提出了较高的要求。

在技术发展方面,文本生成与写作经历了从早期的基于规则的方法到现代的基于深度学习的方法的转变。早期的文本生成主要依赖于手工设计的规则和模板,通过填充预定义的模板来生成文本。这种方法虽然能够生成结构化的文本,但缺乏灵活性和创造性,难以应对复杂的语言现象和多样化的文本需求。随着机器学习技术的发展,基于统计的方法逐渐兴起,通过从大量的文本数据中学习语言的统计规律,如词频、句法结构等,来生成文本。这些方法在一定程度上提高了文本生成的灵活性和质量,但仍存在局限性,如对语义理解的不足和生成文本的连贯性问题。

近年来,深度学习技术的迅猛发展为文本生成与写作带来了新的突破。神经网络模型,尤其是基于Transformer架构的预训练语言模型,如GPT(Generative Pretrained Transformer)系列模型,在文本生成任务中展现出了强大的性能。这些模型通过在大规模的无监督文本上进行预训练,学习到了丰富的语言知识和语义信息,能够生成高质量、连贯且具有创造性的文本。例如,GPT-3模型在多项文本生成任务中取得了令人瞩目的成果,能够生成新闻报道、故事、诗歌等多种类型的文本,且生成的文本在语法、语义和风格上都与人类写作的文本非常接近。

除了预训练语言模型,研究人员还在不断探索其他文本生成技术,如基于检索的方法、基于规划的方法以及结合强化学习的方法等。基于检索的方法通过从大量的文本库中检索与输入信息相似的文本片段,然后进行组合和调整来生成新的文本,这种方法能够生成较为准确和连贯的文本,但可能缺乏创造性。基于规划的方法则先构建文本的结构和内容框架,然后根据框架生成具体的文本,这种方法能够更好地控制文本的逻辑结构和信息组织。结合强化学习的方法通过让模型在生成文本的过程中不断学习和优化策略,以提高文本生成的质量和效率。

总之,文本生成与写作是一项具有挑战性和广阔应用前景的技术。随着深度学习和人工智能技术的不断发展,文本生成模型的性能将不断提升,未来有望在更多领域实现高质量的自动文本生成,为人们的生活和工作带来更多的便利和创新。

我们来做点好玩的。比如在LLM诞生以前,就有人尝试使用RNN训练诗歌生成模型了,比如我用torch下的LSTM来做一个:

import torch

import torch.nn as nn

import torch.optim as optim

import numpy as np# 1. 数据准备

# 假设我们有一个简单的诗歌数据集,每行是一句诗

poems = ["床前明月光,疑是地上霜。","举头望明月,低头思故乡。","白日依山尽,黄河入海流。","欲穷千里目,更上一层楼。","朝辞白帝彩云间,千里江陵一日还。","两岸猿声啼不住,轻舟已过万重山。",

]# 将诗歌分词

tokenizer = torchtext.data.utils.get_tokenizer("basic_english")

vocab = torchtext.vocab.build_vocab_from_iterator(tokenizer(poem) for poem in poems)

vocab_size = len(vocab)# 将诗歌转换为序列

def poem_to_sequence(poem):return [vocab[token] for token in tokenizer(poem)]sequences = [poem_to_sequence(poem) for poem in poems]# 2. 构建模型

class PoetryGenerator(nn.Module):def __init__(self, vocab_size, embedding_dim, hidden_dim):super(PoetryGenerator, self).__init__()self.embedding = nn.Embedding(vocab_size, embedding_dim)self.lstm = nn.LSTM(embedding_dim, hidden_dim, batch_first=True)self.fc = nn.Linear(hidden_dim, vocab_size)def forward(self, x):x = self.embedding(x)out, _ = self.lstm(x)out = self.fc(out)return out# 3. 训练模型

embedding_dim = 64

hidden_dim = 128

model = PoetryGenerator(vocab_size, embedding_dim, hidden_dim)criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)# 准备训练数据

def prepare_data(sequences, seq_length):X, y = [], []for seq in sequences:for i in range(len(seq) - seq_length):X.append(seq[i:i+seq_length])y.append(seq[i+seq_length])return torch.tensor(X), torch.tensor(y)seq_length = 5

X, y = prepare_data(sequences, seq_length)# 训练循环

epochs = 100

for epoch in range(epochs):model.train()optimizer.zero_grad()outputs = model(X)loss = criterion(outputs.view(-1, vocab_size), y)loss.backward()optimizer.step()if (epoch+1) % 10 == 0:print(f"Epoch [{epoch+1}/{epochs}], Loss: {loss.item():.4f}")# 4. 诗歌生成

def generate_poem(model, vocab, start_text, seq_length, temperature=1.0):model.eval()input_seq = [vocab[token] for token in tokenizer(start_text)]input_seq = torch.tensor(input_seq).unsqueeze(0)for _ in range(seq_length):with torch.no_grad():outputs = model(input_seq)probs = torch.softmax(outputs[:, -1, :] / temperature, dim=-1)next_token = torch.multinomial(probs, 1)input_seq = torch.cat([input_seq, next_token], dim=1)generated_text = [vocab.itos[token] for token in input_seq.squeeze(0)]return ''.join(generated_text)# 生成诗歌

start_text = "床前"

generated_poem = generate_poem(model, vocab, start_text, seq_length=10)

print("生成的诗歌:")

print(generated_poem)

当然,这种生成任务大语言模型是最擅长的。比如,如果我们让大模型帮我写小说,只要我给出小说大概设定和剧情,我就可以让大模型帮我写。比如,我以韩剧《财阀家的小儿子》为蓝本,给出提示:

user-prompt

**角色**:你是一名著名的网络小说作家,现在想写一部穿越爽文,故事的背景设定在韩国首尔。

**小说人物与设定**:男主人公陈道俊,是顺洋集团董事长私生子的小儿子,实际上是三十年后被陈星俊派人杀害的尹组长死后穿越而来。自带金手指,一次又一次帮助顺洋集团度过危机,最后得到爷爷认可成为顺洋集团董事长的故事。男主的爷爷有三子一女,大伯陈荣基有一个儿子陈星俊(原定接班人),二伯陈动基有一个女儿陈睿俊(在美国留学,后半本故事才会回国),三姑未育,有一个上门女婿的姑父后来通过选举当上了首尔市检查厅长,爸爸是最小的私生子,经营电影公司,生了两个儿子,哥哥陈星俊和男主。一家人为了爷爷陈养哲的顺洋集团董事长位置展开了勾心斗角。

**任务**:请帮我写小说的第一集。

我们看看AI能给我写出什么玩意:

第一集:穿越时空的继承者

第一章:神秘车祸

韩国首尔,夜幕低垂,华灯初上。陈道俊坐在自己的跑车里,望着窗外的车水马龙,心中却是一片迷茫。他是顺洋集团董事长陈养哲的私生子的小儿子,虽然出身豪门,却从未得到过真正的认可。他的父亲陈明俊经营着一家电影公司,虽然在业界小有名气,但在顺洋集团这样的庞然大物面前,却显得微不足道。

陈道俊的母亲早年去世,他和哥哥陈星俊相依为命。陈星俊是父亲的骄傲,也是顺洋集团的原定接班人。然而,陈道俊却对自己的未来充满了疑惑。他不知道自己在这个家族中究竟扮演着怎样的角色,也不知道自己能否得到爷爷的认可。

就在这时,陈道俊的手机响了起来。他拿起手机一看,是哥哥陈星俊打来的。陈星俊在电话中告诉他,爷爷陈养哲正在召开家族会议,讨论顺洋集团的接班人问题。陈道俊心中一紧,他知道这次会议对自己和哥哥来说至关重要。

挂断电话后,陈道俊立刻驱车前往家族会议的地点。然而,当他行驶到一条偏僻的道路上时,突然一辆卡车从侧面冲了过来。陈道俊猛地踩下刹车,但已经来不及了。两车相撞,发出一声巨响。陈道俊只觉得眼前一黑,便失去了知觉。

当他再次醒来时,发现自己躺在一个陌生的房间里。他的头剧烈地疼痛着,记忆也变得模糊不清。他努力回忆起自己是谁,为什么会在这里。这时,一个穿着白大褂的医生走了进来,告诉他自己是因为车祸而受伤的,需要在这里休养一段时间。

陈道俊心中充满了疑惑,他不知道自己为什么会穿越时空,也不知道自己该如何回到原来的世界。他决定先在这个陌生的世界里生存下去,寻找回到原来世界的方法。

第二章:神秘身份

在医院休养了几天后,陈道俊的身体逐渐恢复了。他决定离开医院,去寻找自己的身份和过去的记忆。他来到首尔的街头,望着熟悉的建筑和陌生的人群,心中充满了迷茫。

就在这时,他看到了一个熟悉的身影。那是他的哥哥陈星俊。陈道俊心中一喜,立刻跑了过去。然而,当他走近时,却发现陈星俊正和一个陌生的女人在一起。陈道俊心中一沉,他知道哥哥已经有了未婚妻,这个女人是谁?

陈星俊看到陈道俊,脸上露出惊讶的表情。他走上前去,问道:“你怎么会在这里?”陈道俊心中充满了疑惑,他不知道哥哥为什么会出现在这里,也不知道这个女人是谁。

陈星俊解释说,这个女人是他的未婚妻,名叫尹素妍。陈道俊心中一震,他知道尹素妍是顺洋集团的千金,也是爷爷陈养哲的孙女。他不知道哥哥为什么会和尹素妍在一起,也不知道他们之间发生了什么。

陈星俊告诉陈道俊,他和尹素妍已经订婚了,很快就会举行婚礼。陈道俊心中充满了疑惑,他不知道哥哥为什么会突然和尹素妍订婚,也不知道这背后隐藏着什么秘密。

就在这时,陈道俊的手机响了起来。他拿起手机一看,是爷爷陈养哲打来的。陈养哲在电话中告诉他,家族会议已经结束,顺洋集团的接班人已经确定了。陈道俊心中一紧,他知道这次会议对自己和哥哥来说至关重要。

陈养哲告诉陈道俊,顺洋集团的接班人是他的哥哥陈星俊。陈道俊心中充满了失落,他知道自己的梦想已经破灭了。然而,陈养哲却告诉他,他还有一个机会,那就是在电影公司做出成绩,证明自己的能力。

陈道俊心中充满了希望,他知道这是自己唯一的机会。他决定回到电影公司,努力做出成绩,证明自己的能力。

第三章:电影公司的挑战

陈道俊回到电影公司后,立刻投入到了工作中。他努力学习电影制作的知识,积极参与公司的项目。然而,他却发现电影公司正面临着巨大的危机。由于市场竞争激烈,公司的票房收入不断下滑,资金链也出现了问题。

陈道俊心中充满了焦虑,他知道如果不能解决这些问题,电影公司就会破产。他决定寻找新的突破口,带领公司走出困境。他想到了一个大胆的计划,那就是拍摄一部以穿越时空为主题的电影。

陈道俊将这个计划告诉了父亲陈明俊,陈明俊却对此表示怀疑。他认为这个计划太过冒险,可能会导致公司破产。然而,陈道俊却坚持自己的想法,他认为这是公司唯一的出路。

陈道俊开始寻找合适的编剧和导演,希望能够将这个计划付诸实践。他找到了一位年轻的编剧,名叫李敏镐。李敏镐对这个计划非常感兴趣,他决定加入陈道俊的团队。

在李敏镐的帮助下,陈道俊开始编写电影的剧本。他们花了很长时间,终于完成了剧本的初稿。陈道俊将剧本拿给父亲陈明俊看,陈明俊却对此表示不满。他认为剧本太过离奇,不符合市场的需求。

陈道俊心中充满了失望,他知道父亲的担忧是有道理的。然而,他却不愿意放弃自己的梦想。他决定寻找其他的投资人,希望能够得到他们的支持。

就在这时,陈道俊遇到了一位名叫金泰熙的女演员。金泰熙对陈道俊的计划非常感兴趣,她决定加入他的团队。在金泰熙的帮助下,陈道俊开始寻找其他的投资人。

经过一段时间的努力,陈道俊终于找到了一位愿意投资的富商。富商对陈道俊的计划非常感兴趣,他决定投资这部电影。陈道俊心中充满了希望,他知道这是公司唯一的出路。

第四章:电影的成功

在富商的支持下,陈道俊开始拍摄这部电影。他邀请了韩国著名的导演和演员,希望能够将这部电影拍成一部经典之作。在拍摄过程中,陈道俊遇到了很多困难,但他始终坚持自己的梦想,不断努力。

经过几个月的努力,电影终于拍摄完成了。陈道俊将电影拿给父亲陈明俊看,陈明俊却对此表示怀疑。他认为这部电影太过离奇,不符合市场的需求。然而,陈道俊却坚持自己的想法,他认为这部电影一定会成功。

电影上映后,立刻引起了轰动。观众们对这部电影的评价非常高,认为它是一部经典之作。电影的票房收入也不断攀升,成为了当年的票房冠军。

陈道俊心中充满了喜悦,他知道自己的梦想终于实现了。他回到电影公司,将这个好消息告诉了父亲陈明俊。陈明俊对陈道俊的成功感到非常惊讶,他没有想到自己的儿子能够取得这样的成绩。

陈道俊告诉父亲,他希望能够继续拍摄更多的电影,为公司创造更多的价值。陈明俊对陈道俊的提议表示赞同,他认为儿子已经证明了自己的能力。

陈道俊心中充满了希望,他知道自己的未来已经不再迷茫。他决定继续努力,为公司创造更多的价值,证明自己的能力。

第五章:家族的认可

陈道俊的成功引起了家族的注意。爷爷陈养哲对陈道俊的表现非常满意,他认为陈道俊已经证明了自己的能力。他决定给陈道俊一个机会,让他参与到顺洋集团的管理中来。

陈道俊心中充满了喜悦,他知道这是自己一直梦寐以求的机会。他决定抓住这个机会,努力证明自己的能力。他开始参与到顺洋集团的管理中来,积极参与公司的决策。

在陈道俊的努力下,顺洋集团的业绩不断攀升,成为了韩国的龙头企业。陈养哲对陈道俊的表现非常满意,他认为陈道俊已经具备了接班人的能力。

陈道俊心中充满了希望,他知道自己的未来已经不再迷茫。他决定继续努力,为公司创造更多的价值,证明自己的能力。

然而,陈道俊的成功却引起了哥哥陈星俊的嫉妒。陈星俊认为陈道俊抢走了自己的机会,他决定采取行动,阻止陈道俊的崛起。

陈星俊开始在家族中散布谣言,诋毁陈道俊的声誉。他告诉家族成员,陈道俊的成功是因为运气,而不是能力。他还告诉家族成员,陈道俊在电影公司的工作中存在很多问题。

陈道俊心中充满了愤怒,他知道哥哥的嫉妒是无理取闹的。然而,他却不愿意与哥哥发生冲突。他决定继续努力,用自己的成绩证明自己的能力。

在陈道俊的努力下,顺洋集团的业绩不断攀升,成为了韩国的龙头企业。陈养哲对陈道俊的表现非常满意,他认为陈道俊已经具备了接班人的能力。

陈道俊心中充满了希望,他知道自己的未来已经不再迷茫。他决定继续努力,为公司创造更多的价值,证明自己的能力。

第六章:最终的胜利

经过一段时间的努力,陈道俊终于得到了家族的认可。爷爷陈养哲宣布,陈道俊将成为顺洋集团的接班人。陈道俊心中充满了喜悦,他知道自己的梦想终于实现了。

然而,陈道俊的成功却引起了哥哥陈星俊的嫉妒。陈星俊认为陈道俊抢走了自己的机会,他决定采取行动,阻止陈道俊的崛起。

陈星俊开始在家族中散布谣言,诋毁陈道俊的声誉。他告诉家族成员,陈道俊的成功是因为运气,而不是能力。他还告诉家族成员,陈道俊在电影公司的工作中存在很多问题。

陈道俊心中充满了愤怒,他知道哥哥的嫉妒是无理取闹的。然而,他却不愿意与哥哥发生冲突。他决定继续努力,用自己的成绩证明自己的能力。

在陈道俊的努力下,顺洋集团的业绩不断攀升,成为了韩国的龙头企业。陈养哲对陈道俊的表现非常满意,他认为陈道俊已经具备了接班人的能力。

陈道俊心中充满了希望,他知道自己的未来已经不再迷茫。他决定继续努力,为公司创造更多的价值,证明自己的能力。

最终,陈道俊成功地成为了顺洋集团的董事长。他用自己的努力和智慧,证明了自己的能力。他成为了家族的骄傲,也成为了韩国商界的传奇人物。

看看,满满的那种美式英雄主义的味道,说明它的写作故事性风格还是比较单一。如何激发模型创造性还是需要一点提示词工程,一旦涉及那种爽文就开始漫威风。不过这并不排斥人机协同写作。我在番茄上写小说有时也会用AI帮我一块想剧情。

![[AI/GPT/LLM] 大模型评估的综述:现状、挑战与未来方向](https://blog-static.cnblogs.com/files/johnnyzen/cnblogs-qq-group-qrcode.gif?t=1679679148)