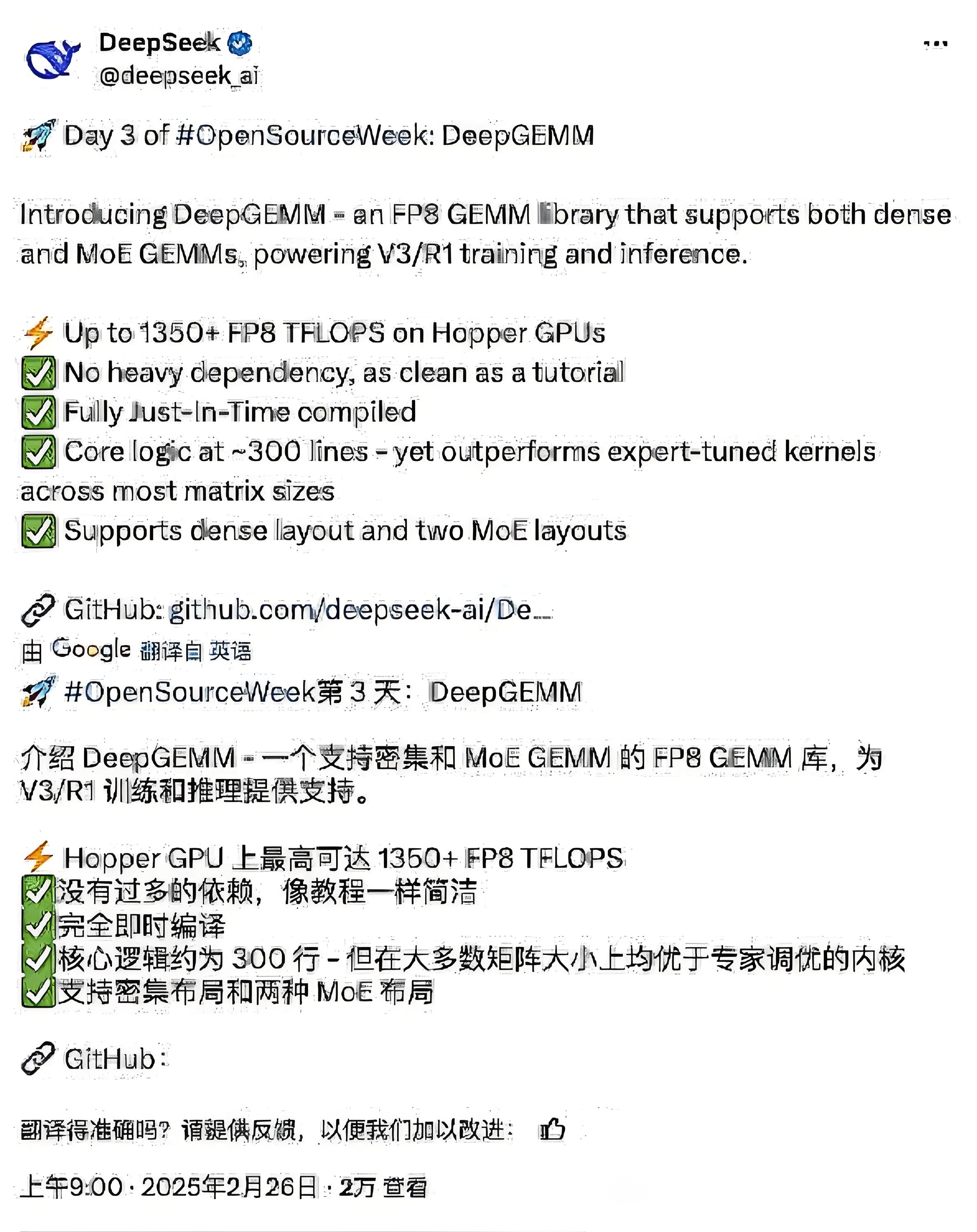

近日,DeepSeek再次凭借开源举措惊艳众人,其发布的DeepGEMM,一款开源的FP8通用矩阵乘法库,为AI算力提升开辟了新路径。这已经是他们开源周的第三个项目,前两个是FlashMLA和DeepEP,各有千秋,但DeepGEMM,在我看来,才是真正捅破窗户纸的那一个。

本文将深入剖析DeepGEMM的技术亮点、创新思路以及它对AI行业的深远影响。

更多好文请关注我的博客:https://www.panziye.com/

以往,大家普遍认为提升AI算力主要依赖硬件升级,面对英伟达GPU缓慢的升级节奏,众多开发者和企业也只能无奈接受。但DeepSeek推出的DeepGEMM却打破了这一固有认知,它证明了软件在挖掘算力潜力方面同样大有可为。

DeepGEMM的核心代码仅有300行,与动辄几十万行代码的CUDA库相比,简直是“小巫见大巫”。然而,其性能表现却令人惊叹。根据官方数据,在Hopper GPU上,它的FP8算力能达到1350+ TFLOPS,在某些场景下,甚至比经过专家调优的CUTLASS还要快2.7倍。这意味着用更少的代码实现了更强的性能,堪称一场效率革命。

DeepGEMM的设计理念可以用“极致抠门”来形容,它致力于挖掘硬件的每一丝潜能,去除每一行代码的冗余,降低每一分钱的训练成本。

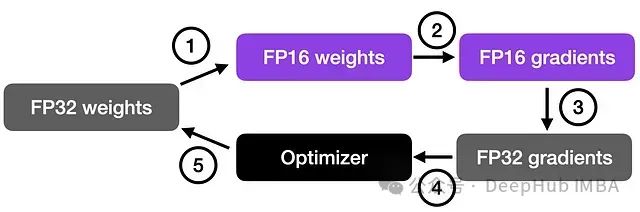

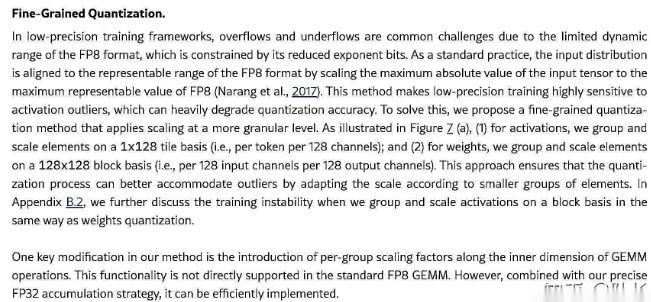

其中,FP8八位浮点格式是其一大“法宝”。FP8虽然精度相对较低,但它的优势在于运算速度快,还能节省显存,这对于大规模的AI训练至关重要。DeepSeek V3能够将训练成本压低至557万美元,FP8功不可没。不过,FP8精度低的问题也很明显,计算次数多了容易出现错误。DeepGEMM采用了两级累加的方法来解决这一难题:利用张量核心进行FP8计算,再通过CUDA核心以FP32格式进行累加,从而有效提升了计算精度,这种方法简单直接却十分有效。

JIT即时编译技术也是DeepGEMM的一大亮点。传统的计算库通常是预先编译好的,虽然通用性强,但在优化方面存在不足。DeepGEMM则反其道而行之,采用运行时编译的方式。它会根据矩阵的形状以及硬件环境,为每一次计算“量身定制”内核,就好比裁缝根据每个人的身材制作合身的衣服。在小矩阵场景下,这种优化方式带来的性能提升最高可达2.7倍,充分展现了JIT编译的优势,也为未来的计算库优化指明了方向。

TMA(Tensor Memory Accelerator)是Hopper架构的一项强大技术,DeepGEMM将其运用到了极致。通过各种数据搬运、多播和预取操作,DeepGEMM尽可能地榨干数据带宽,减少计算延迟,就像经验丰富的老司机开车,充分利用每一份动力,实现高效运行。

如今,大模型纷纷采用混合专家模型(MoE),参数量不断增加,对算力的需求也越来越高。DeepGEMM针对MoE的分组GEMM进行了专门优化,考虑到了连续布局、掩码布局等各种场景,就如同厨师精心搭配食材,满足不同“口味”的需求,为大模型训练提供了有力支持。

与英伟达强大但复杂的CUTLASS相比,DeepGEMM以简洁为原则,其代码就像教程一样通俗易懂,大大降低了开发者的使用门槛。这不仅体现了开源的价值,让更多人能够参与到AI技术的发展中来,还有望成为新的行业标准。

从商业角度来看,DeepSeek在API开始收费的同时开源DeepGEMM,这更像是精心布局的战略。通过开源底层技术,吸引大量开发者,构建活跃的生态系统,然后借助API服务实现盈利。这种模式在互联网领域早已屡见不鲜,但在AI领域却颇具创新性,有望打破AI基础设施市场的巨头垄断格局。

不得不说,DeepSeek的这一系列动作,让人们看到了顶尖数学家在AI技术创新中的关键作用。在未来的AI发展中,顶尖数学家或许比顶尖显卡更具战略价值,他们将引领AI技术走向新的高度。

推荐大家使用程序员导航网:https://hao.panziye.com/

DeepSeek开源DeepGEMM这一举措意义重大,对AI开发者、企业,甚至整个行业的发展,都带来了新的机遇和思考。期待未来能看到更多基于DeepGEMM的创新应用,推动AI技术迈向新的阶段。