在我们已经训练好BERT后,BERT就可以对输入的每一个词元返回抽取了上下文信息的特征向量(也就是对于任意一个词元,将这个词元当做查询,所有词元当做键值对)

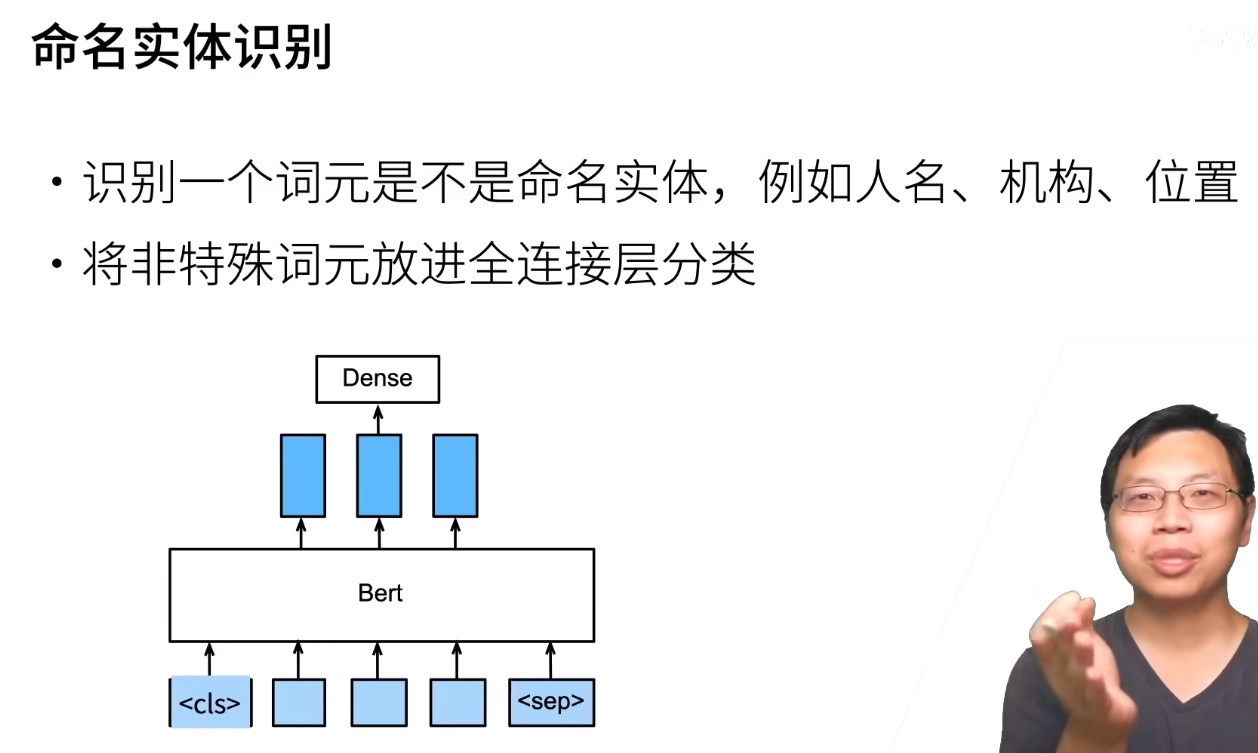

一些任务如下

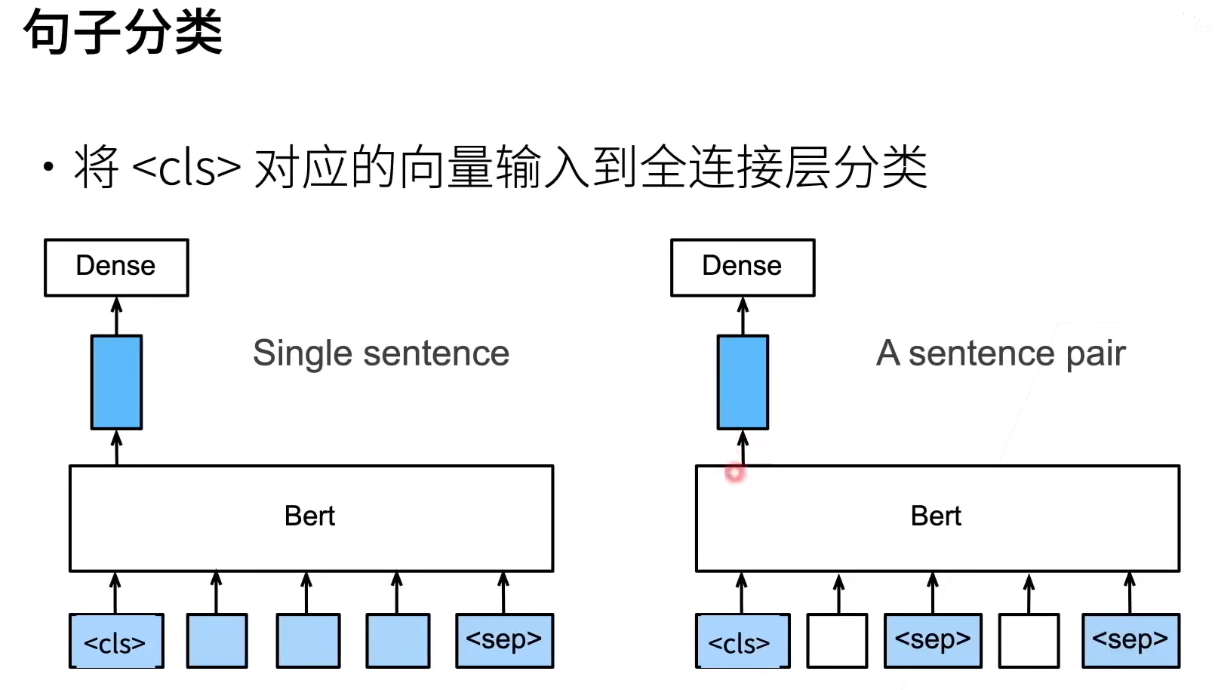

这里将<cls>的特征向量传递给全连接层的原因就是因为<cls>本来就是用来分类的,所以肯定传这个。当然也可以传其他的,反正我们的全连接层都是用来微调的

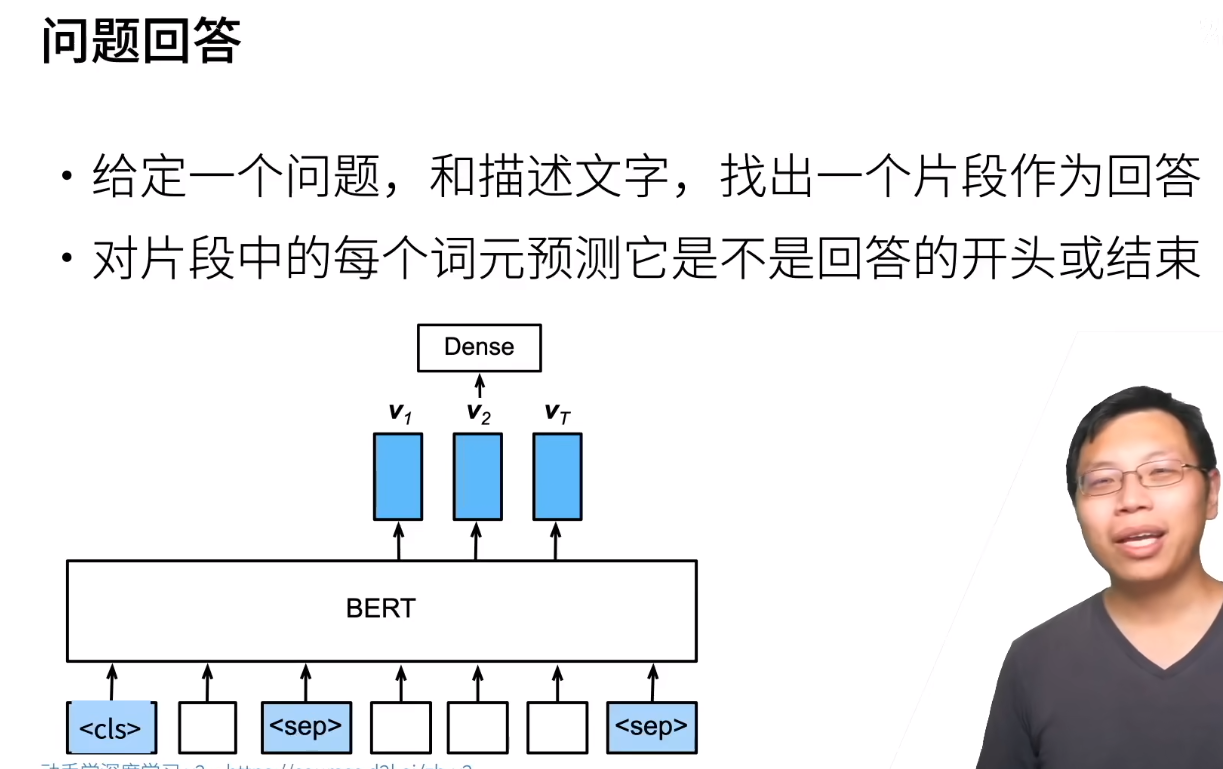

注意这个任务中的描述和问题都是我们给的,相当于让模型做阅读理解。模型的目的是将我们给的描述进行三分类:回答的开头,回答的结尾以及其他的

这里输入的表示和使用BERT的特征就是上面说的拿什么词放到BERT里面,以及全连接层最后输出的是什么

15.7.2 微调BERT的数据集

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.hqwc.cn/news/893266.html

如若内容造成侵权/违法违规/事实不符,请联系编程知识网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

【分享】FTP为何被摒弃,如何选择适配的国产FTP传输软件?

在数字化浪潮中,文件传输是日常工作里不可或缺的一环。提及文件传输,FTP(文件传输协议)大家都不陌生,它就像一位勤勤恳恳的老邮差,多年来一直承担着文件传输的重任。凭借着简单易用、广泛支持、兼容性好以及成本低廉的优点,FTP在全球各地广泛应用,成为许多企业和个人进…

DeepSeek 开源周回顾「GitHub 热点速览」

上周,DeepSeek 发布的开源项目用一个词形容就是:榨干性能!由于篇幅有限,这里仅列出项目名称和简介,感兴趣的同学可以前往 DeepSeek 的开源组织页面,深入探索每个项目的精彩之处!第一天 FlashMLA:基于 Hopper GPU 的高效 MLA 解码内核

第二天 DeepEP:专为 MoE 和 EP 设…

怎样配置blazor才能提高吞吐量

怎样配置blazor才能提高吞吐量

为了提高 Blazor 应用的吞吐量,可以从以下几个方面进行配置和优化:启用响应压缩:通过压缩传输的数据量来减少带宽消耗。

配置 SignalR:调整 SignalR 的配置以提高数据传输效率。

优化 Circuit 选项:调整 Blazor Server 的 Circuit 配置以提高…

咨询公司:趁着AI人工智能的浪潮还能持续,好好享受吧……

在人工生成式智能热潮的喧嚣与狂热之中,咨询行业正经历一场基本未被察觉却极具变革性的革命,这场变革将塑造它的未来。

传统咨询依赖于由高素质专业人士组成的团队,他们专注于研究、数据分析,并提供定制化建议。这是一种昂贵且缓慢的商业模式,而咨询公司发现,通用人工智能…

意识是从大脑的导航系统里出现的—AI的意识会不会也这样出现的?

人类意识是从我们大脑的导航系统里出现的——AI的意识会不会也是这么出现的?

Rick Mammone科幻电影《机械姬》里,由艾丽西亚维坎德扮演的科幻人形机器人艾娃。图片来源:电影剧照

那句很有名的话,

“我思,故我在”,

是笛卡尔说的。简单来说,就是说,如果我有足够的自我意…

读DAMA数据管理知识体系指南09数据建模(上)

读DAMA数据管理知识体系指南09数据建模(上)1. 数据建模

1.1. 数据建模是发现、分析和确定数据需求的过程,用一种称为数据模型的精确形式表示和传递这些数据需求

1.2. 数据建模是数据管理的一个重要组成部分

1.3. 建模过程中要求组织发现并记录…

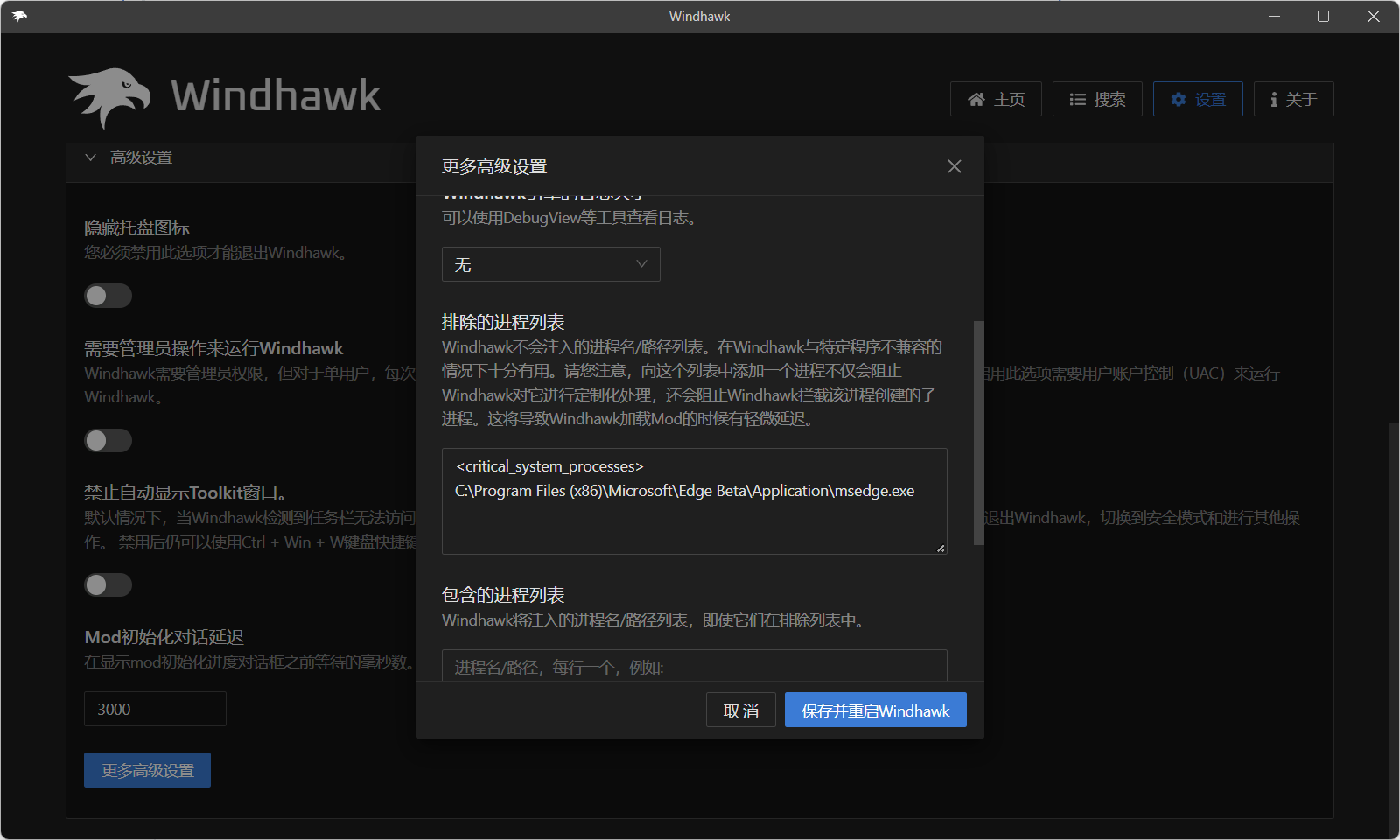

Win11侧边任务栏

7+ taskbar tweaker 不适配

ExplorerPatcher 太丑

startallback 收费

Windhawk 完美的解决方案!加个下面的mod即可记得排除edge浏览器,不然会卡(v1.5.1)