Batch Normalization(批量归一化)是一种在深度学习中常用的技术,特别是在训练卷积神经网络(CNN)时。它由 Sergey Ioffe 和 Christian Szegedy 在 2015 年提出,旨在加速训练过程,减少对初始化的依赖,并有助于缓解梯度消失和梯度爆炸问题。Batch Normalization 主要通过规范化层的输入来实现这些目标。

Batch Normalization 的工作原理

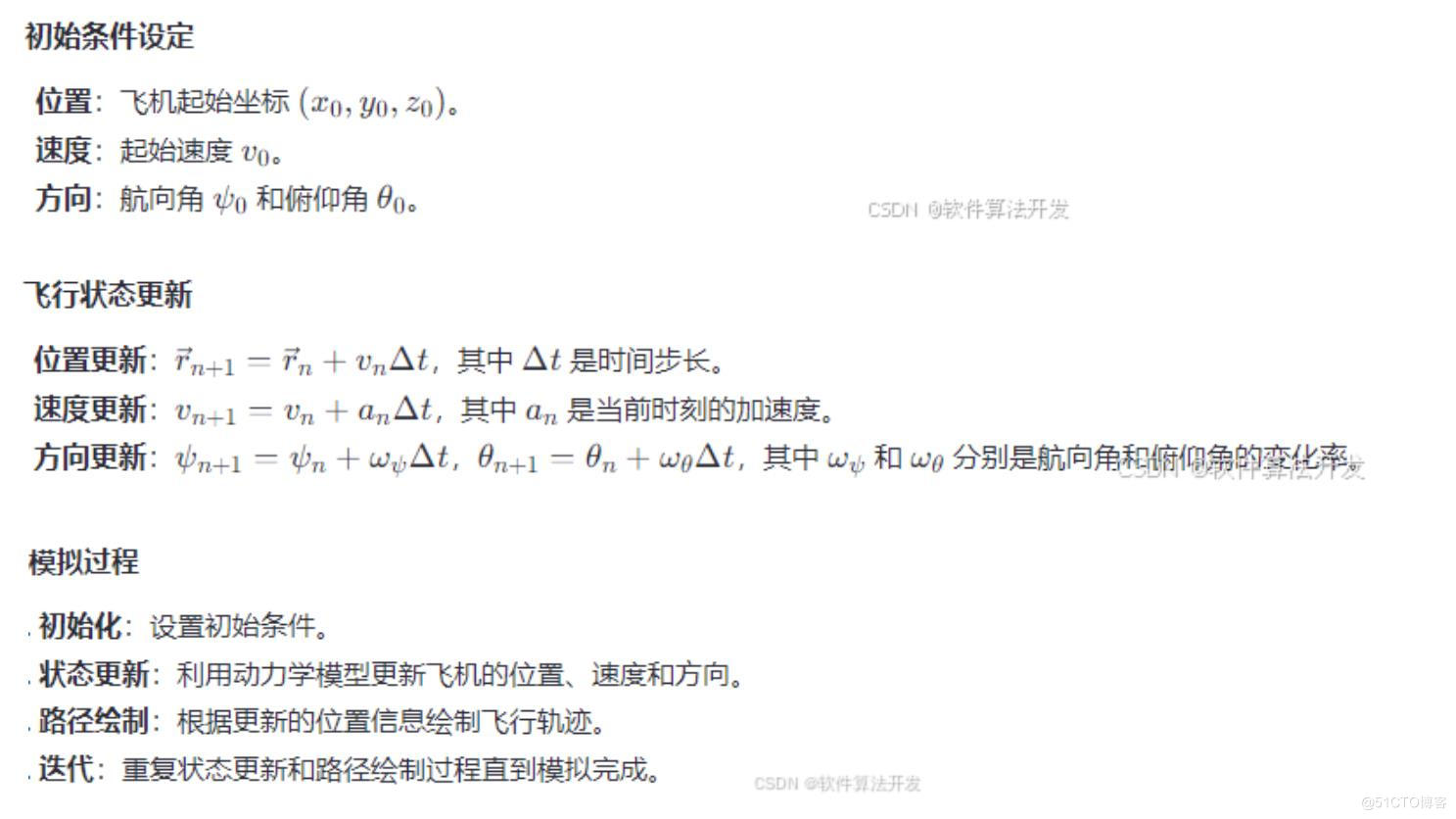

Batch Normalization 在神经网络的每个小批量(batch)上进行操作,对每个特征维度(channel)的输入进行规范化处理。具体步骤如下:

-

计算均值和方差:

-

对于每个特征维度,计算该维度在当前小批量中的均值 μ 和方差 σ2。

-

-

归一化:

-

使用计算得到的均值和方差对输入进行归一化处理,公式如下:x^=σ2+ϵ其中,x 是输入,x^ 是归一化后的输出,ϵ 是一个很小的常数(防止除以零),通常取 10−5。

-

-

缩放和平移:

-

归一化后的数据可以通过两个可学习的参数 γ(缩放因子)和 β(平移因子)进行缩放和平移,公式如下:y=γx^+β其中,y 是最终的输出。

-

Batch Normalization 的优点

-

加速训练:

-

通过减少内部协变量偏移(Internal Covariate Shift),Batch Normalization 可以加速网络的训练过程。

-

-

允许使用更高的学习率:

-

由于训练过程更加稳定,可以使用更高的学习率,进一步加速训练。

-

-

减少对初始化的依赖:

-

Batch Normalization 使得网络对权重初始化的依赖性降低,从而简化了网络设计。

-

-

有助于缓解梯度消失和梯度爆炸问题:

-

通过规范化层的输入,Batch Normalization 有助于保持梯度的稳定性。

-

-

提高模型的泛化能力:

-

在某些情况下,Batch Normalization 可以提高模型的泛化能力,减少过拟合。

-

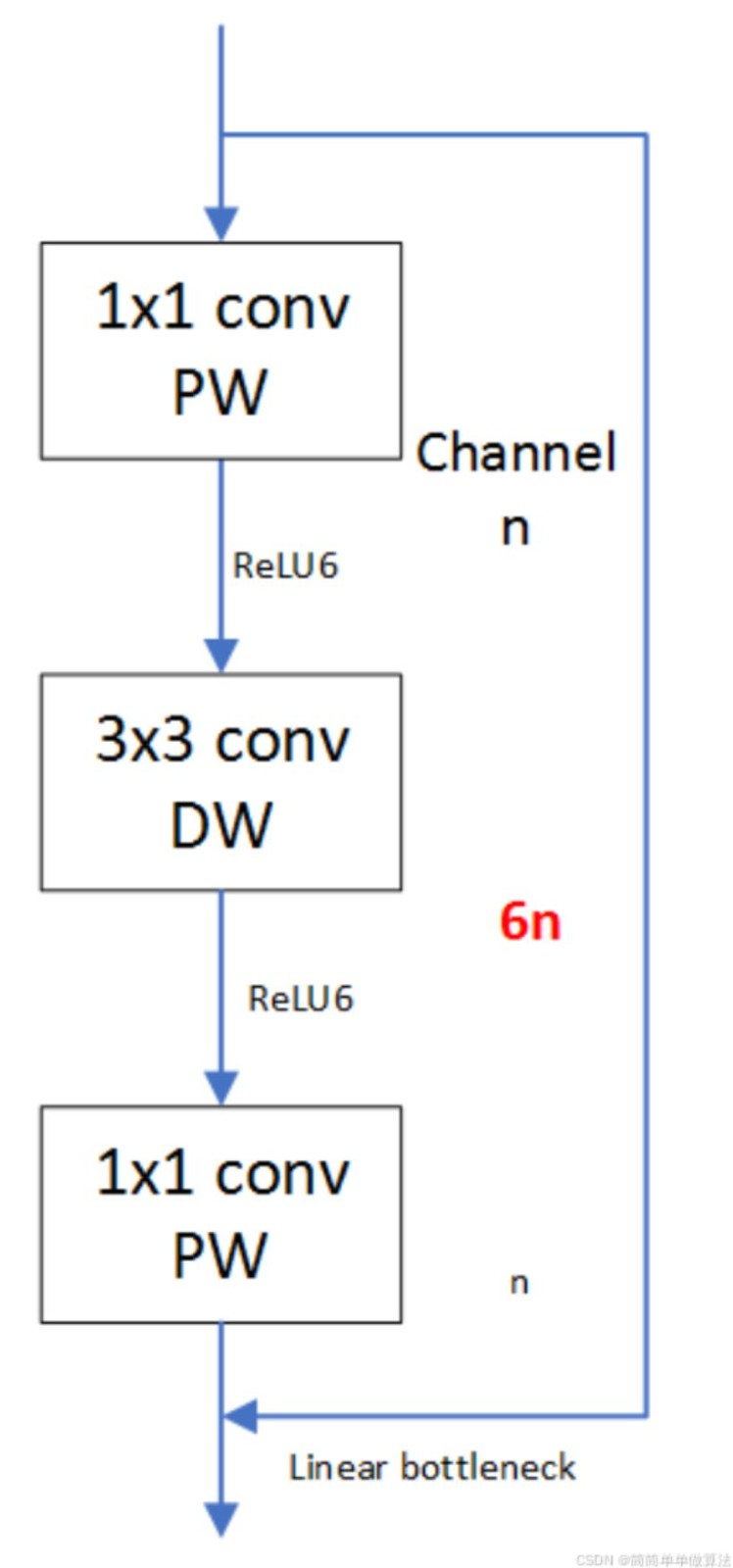

Batch Normalization 的应用

Batch Normalization 通常应用于深度神经网络的各个层之间,特别是在卷积层和全连接层之后。在实际应用中,Batch Normalization 已经成为许多深度学习模型(如ResNet、VGG等)的标准组件。

注意事项

-

Batch Normalization 在小批量数据上进行操作,因此它依赖于小批量的大小。如果小批量的大小变化,Batch Normalization 的效果可能会受到影响。

-

在某些情况下,如在训练数据增强或测试时,Batch Normalization 可能需要使用不同的策略来处理单个样本或小批量数据。

总之,Batch Normalization 是一种非常有效的技术,它通过规范化层的输入来加速训练过程,提高模型的稳定性和泛化能力。

![[AI/GPT/综述] AI Agent的设计模式综述](https://blog-static.cnblogs.com/files/johnnyzen/cnblogs-qq-group-qrcode.gif?t=1679679148)