魔塔社区平台介绍

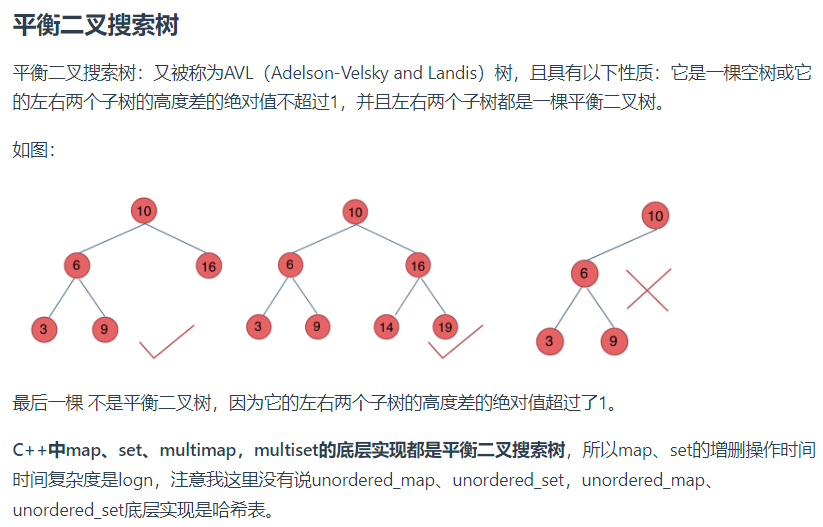

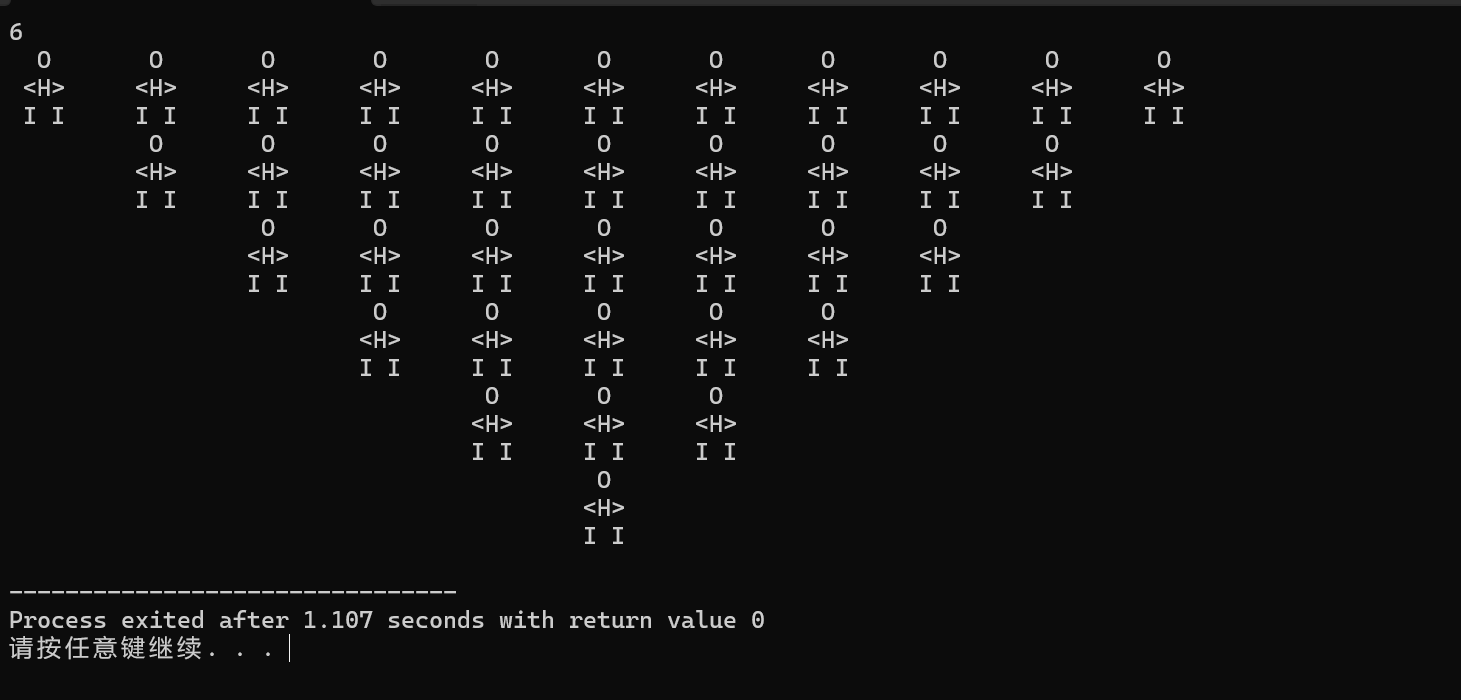

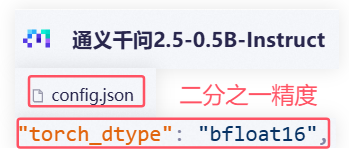

量化:将高精度数值转换成低精度表示的过程(通常用于减少模型的内存和提高推理速度)

Ollama部署大模型

linux安装miniconda

# 下载 Miniconda 安装脚本 wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh # 运行安装脚本 bash Miniconda3-latest-Linux-x86_64.sh # 跟随安装向导 输入“yes”以接受许可协议,选择安装路径,并选择是否将 Miniconda 添加到 PATH 环境变量 # 激活更改 source ~/.bashrc

现在服务器上面创建一个虚拟环境

conda create -n ollama

conda activate ollama

ollama list 显示本地ollama下载的模型

ollama run qwen2.5:0.5b(后面直接跟你要跑的模型)

ollama跑不了本地的模型,只支持GGUF格式的模型(GGUF指的是量化之后的模型)

ollama针对是个人用户

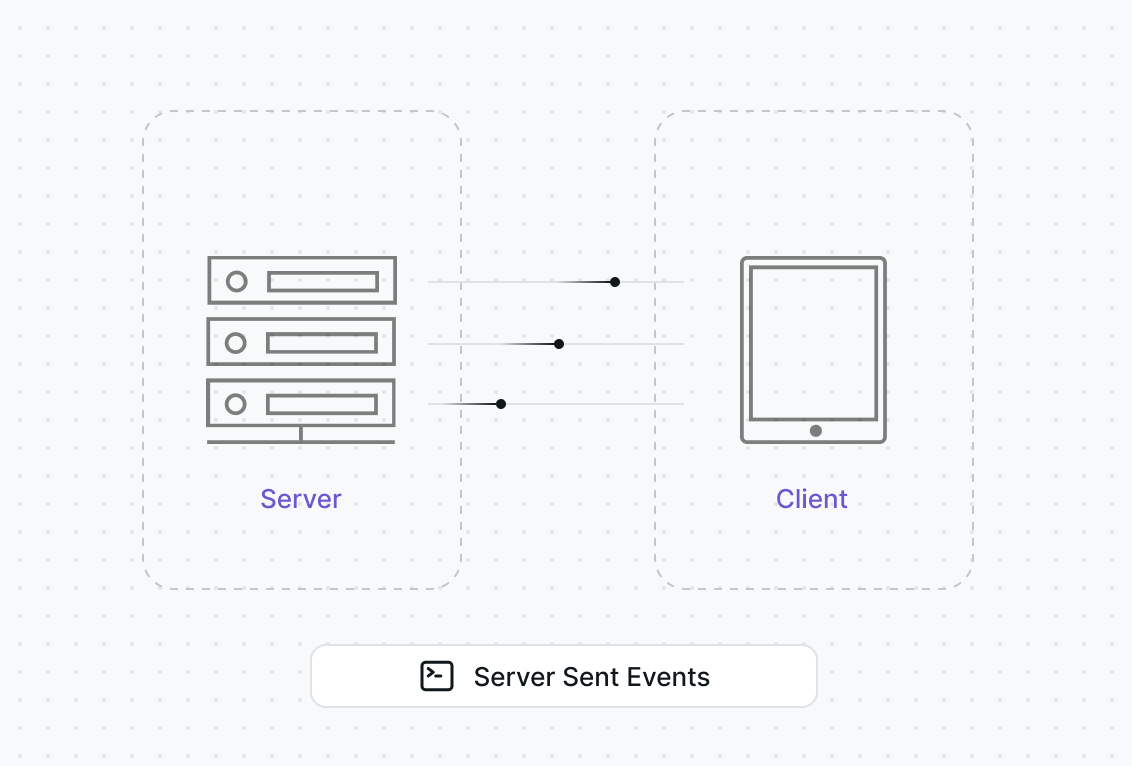

vLLM部署大模型

LMDeploy部署大模型