广义优势估计(Generalized Advantage Estimation, GAE)由Schulman等人在2016年的论文中提出,是近端策略优化(PPO)算法的重要基础理论,也是促使PPO成为高效强化学习算法的核心因素之一。

GAE的理论基础建立在资格迹(eligibility traces)和时序差分λ(TD-λ)之上,为深入理解GAE的核心价值,我们需要先分析其解决的根本问题。

强化学习中的核心问题

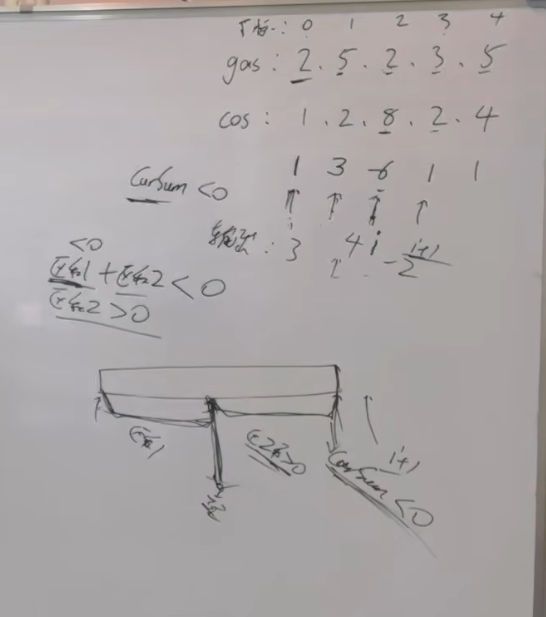

在策略梯度方法及广义强化学习框架中,信用分配问题(credit assignment problem)始终是一个关键挑战:当系统中的奖励延迟出现时,如何准确地判定哪些历史动作应当获得强化?

这一问题本质上是寻求偏差(bias)与方差(variance)之间的最佳平衡点。当算法考虑远期回报以强化当前动作时,会引入较大方差,因为准确估计真实期望回报需要大量采样轨迹。当算法仅关注短期回报时,会导致估计偏差增大,特别是当我们将状态价值估计为较小步数(如TD残差为1时)的n步回报加权平均时。

https://avoid.overfit.cn/post/dac142ef48c149d0bf30066535727cb0