https://liweinlp.com/13092

一段话总结

大型语言模型(LLMs)的“黑箱”特性(因复杂参数和层级结构导致决策过程难以追踪)引发信任、伦理和监管挑战。“Logits Lens”技术通过解码模型中间层的隐藏状态,将其转化为词元(token)的概率分布,直观展示模型在不同层级对下一个词的预测演变,从而揭示信息流动和关键决策节点。该技术在视觉-语言模型中可检测幻觉,并与图像生成领域的扩散模型可视化形成类比,为提升模型透明度和安全性提供了重要工具。

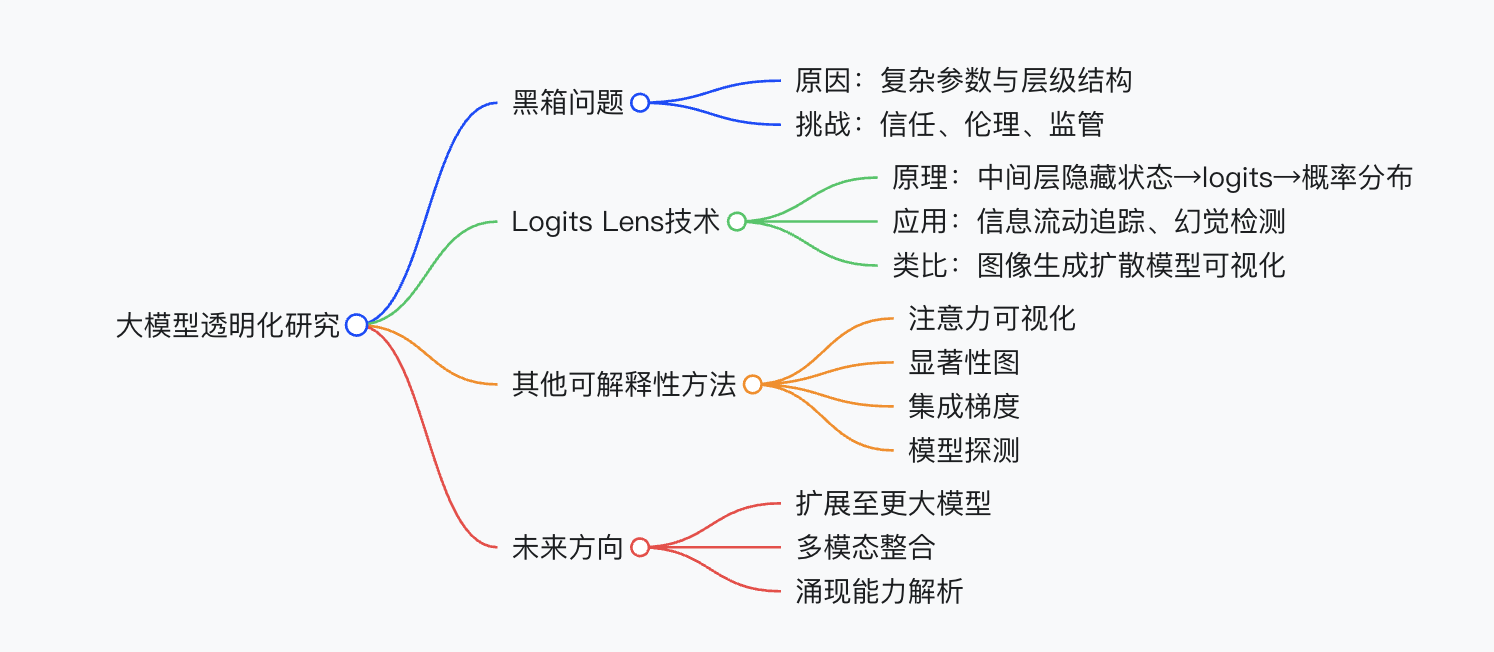

思维导图

- 大模型透明化研究- 黑箱问题- 原因:复杂参数与层级结构- 挑战:信任、伦理、监管- Logits Lens技术- 原理:中间层隐藏状态→logits→概率分布- 应用:信息流动追踪、幻觉检测- 类比:图像生成扩散模型可视化- 其他可解释性方法- 注意力可视化- 显著性图- 集成梯度- 模型探测- 未来方向- 扩展至更大模型- 多模态整合- 涌现能力解析

详细总结

一、大模型“黑箱”问题的核心挑战

- 不透明性根源:

- 模型含数百万至数十亿参数,层级间信息传递复杂(如Transformer的自注意力和前馈神经网络)。

- 类似高炉冶炼,内部2300℃环境依赖经验判断,难以直观观测。

- 影响与风险:

- 信任危机:医疗、金融等高风险领域决策无法追溯。

- 伦理问题:招聘、信贷中的偏见难发现与纠正。

- 监管压力:欧盟AI法案等要求透明度标准。

二、Logits Lens技术解析

- 核心原理:

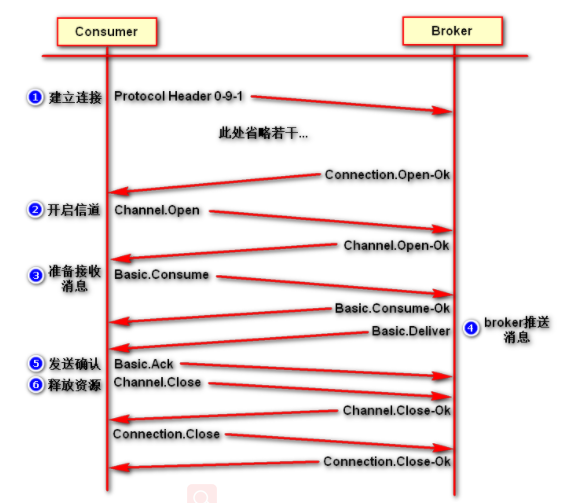

- 将模型中间层隐藏状态通过语言模型头(LM Head)投影为logits向量,经Softmax转化为token概率分布。

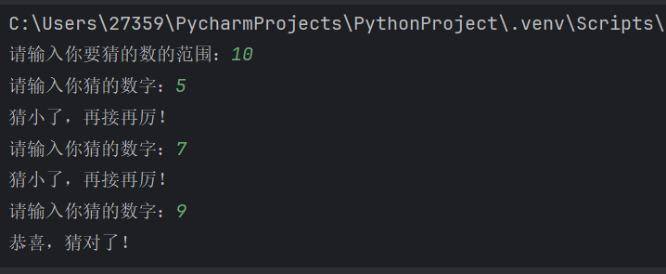

- 示例:输入“埃菲尔铁塔位于哪个城市?”,早期层级预测宽泛(如“法国”),后期收敛至“巴黎”。

- 应用场景:

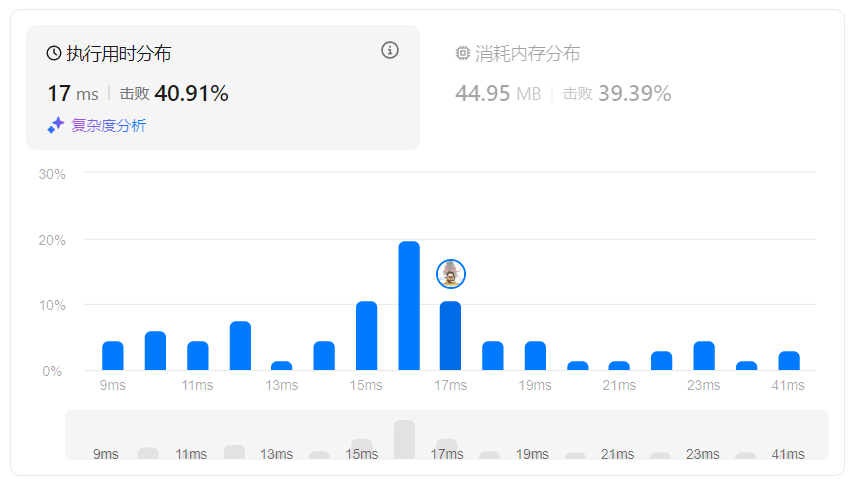

- 信息流动分析:追踪模型在不同层级的预测演变(如NNsight工具的热力图可视化)。

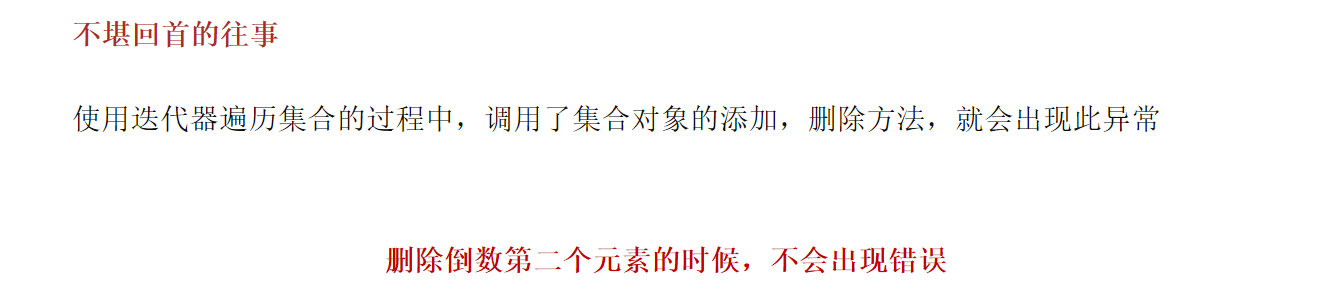

- 幻觉检测:在视觉-语言模型中定位异常token生成阶段(注意力权重差异可作指标)。

- 类比与启示:

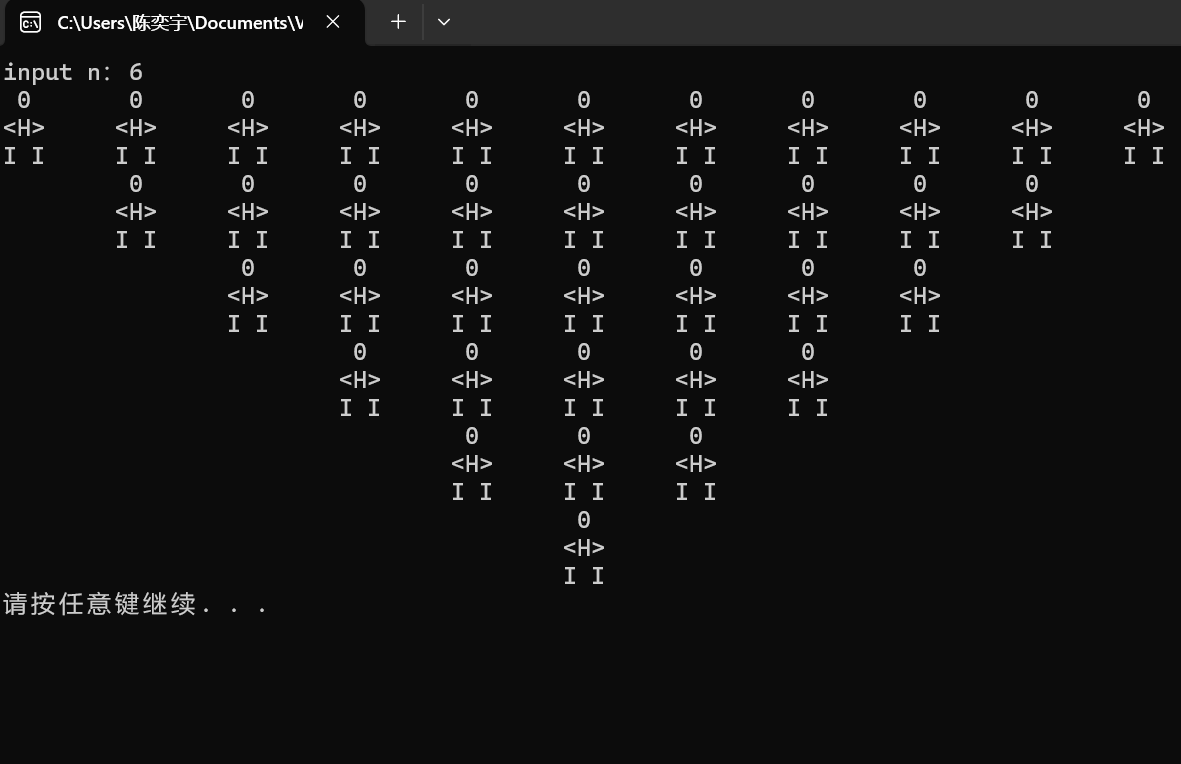

- 图像生成扩散模型的逐步骤去噪可视化,与Logits Lens的层级分析异曲同工。

三、与其他可解释性技术的对比

| 技术名称 | 核心思想 | 优点 | 局限性 | 示例应用 |

|---|---|---|---|---|

| Logits Lens | 中间层隐藏状态→token概率分布 | 简单易实现,跨模型兼容性强 | 简化视角,依赖下一个token预测 | 追踪预测演变、检测幻觉 |

| 注意力可视化 | 展示token间注意力权重 | 直观显示依赖关系 | 权重≠因果关系 | 翻译任务中的上下文聚焦 |

| 显著性图 | 输入token对输出的贡献度 | 快速定位关键特征 | 对输入变化敏感,易产生噪声 | 情感分析中的关键词识别 |

| 集成梯度 | 特征重要性的梯度积分 | 精确评估非线性模型 | 计算成本高 | 检测模型偏差 |

| 模型探测 | 训练分类器探测内部属性 | 揭示编码的语言学信息 | 依赖探测器设计 | 分析层级中的句法结构编码 |

四、未来展望

- 技术扩展:

- 开发自动化工具(如LogitLens4LLMs)应对更大模型。

- 多模态整合(如视觉-语言模型的深度分析)。

- 涌现能力研究:

- 解析大模型中不具备的新能力(如复杂推理)的产生机制。

- 安全对齐:

- 结合可解释性技术识别有害行为,提升模型安全性。

关键问题与答案

问题1:Logits Lens如何帮助理解大模型的决策过程?

答案:Logits Lens通过将中间层隐藏状态转化为token概率分布,直观展示模型在不同层级对下一个词的预测演变。例如,输入“法国的首都”时,早期层级可能预测“巴黎”概率低,但深层级会显著提升,揭示模型逐步聚焦正确答案的过程。

问题2:Logits Lens与注意力可视化技术的主要区别是什么?

答案:

- Logits Lens:关注模型内部层级的token预测概率变化,揭示信息流动和决策收敛过程。

- 注意力可视化:展示模型生成特定token时关注的输入token,反映上下文依赖关系。

- 示例:前者可追踪“巴黎”在各层级的预测概率,后者可显示“法国”对“巴黎”的注意力权重。

问题3:Logits Lens在视觉-语言模型中的具体应用是什么?

答案:在VLMs中,Logits Lens可分析图像token的隐藏状态,检测幻觉(如生成图像中不存在的对象)。通过对比真实与幻觉token的注意力权重,识别异常生成阶段,为模型优化提供依据。