| Title:Grounded Language-Image Pre-training |

| Code |

文章目录

- 1. 背景

- 2. 方法

- (1)Unified Formulation

- 传统目标检测

- grounding目标检测

- (2)Language-Aware Deep Fusion

- (3)Pre-training with Scalable Semantic-Rich Data

- 3. 实验

- (1)数据集简介

- (2)GLIP消融实验

- 参考

1. 背景

目前的视觉识别任务通常是在一个预先定义好的类别范围内进行的,这样限制了其在真实场景中的扩展。CLIP的出现打破了这一限制,CLIP利用image-text对进行训练,从而使得模型可以根据文字prompt识别任意类别。CLIP适用于分类任务,而GLIP尝试将这一技术应用于目标检测等更加复杂的任务中。

在本文中,作者提出了phrase grounding的概念,意思是让模型去学习图片和句子短语之间更加精细的联系。

GLIP的主要贡献如下:

- 将phrase grounding和目标检测任务统一,将image和text prompt同时输入到目标检测网络中,prompt中带有图片中所有类别的详细描述。

- GLIP采用了丰富的预训练数据,使得它的预训练模型可以更轻松地迁移到下游任务中。预训练的GLIP在COCO数据集上finetune之后达到了60.8 AP(2017val)和61.5AP(test-dev),超过了目前的SOTA模型。

- One model for all,GLIP可以迁移到多样化的任务中。它在不使用额外标注的情况下,在coco val2017和LVIS数据集上分别达到了49.8AP和26.9AP。

2. 方法

(1)Unified Formulation

传统目标检测

一个典型的目标检测网络的结构如下:

- 将图片输入到visual encoder E n c I Enc_I EncI 中提取特征 O O O,visual encoder通常是CNN、Transformer等backbone;

- 将特征 O O O 输入到classifier C C C 和bbox regressor R R R 中得到分类结果和bbox回归结果;

- 分别计算分类损失和框回归损失,整体Loss公式: L = L c l s + L l o c L=L_{cls}+L_{loc} L=Lcls+Lloc

上述计算分类Loss的流程可以用公式表达为:

其中 T T T 代表target; W W W 是分类器参数。

grounding目标检测

与上述分类器不同,GLIP将目标检测任务与phrash grounding统一,将目标检测中的每个region/bbox与text prompt进行匹配以实现分类效果。

举例来说,假设我们有[person, bicycle, car, ..., toothbrush]等类别,我们可以设计一个这样的prompt,其中每一个类别名字都是一个phrase:

grounding模型中的分类流程可以用公式表示为:

其中 P P P 是language encoder得到的文字特征, S g r o u n d S_{ground} Sground 的计算过程如下如图示:计算图像的region和prompt中的word之间的对齐分数:

然而,在计算对齐分数时,一个短语(phrase)可能包含多个word tokens,这就导致一个类别可能对应多个子单词(sub-words)。针对这个问题,本文是这样做的:当这些sub-words的phrase与目标region匹配时,每个positive sub-word都与目标region所匹配。**例如,吹风机的phrase是“Hair dryer”,那么吹风机的region就会与“Hair”和“dryer”这两个词都匹配,**如下图所示:

(2)Language-Aware Deep Fusion

在CLIP等算法中,image和text特征通常只在最后用于计算对比学习的loss,我们称这样的算法为late-fusion model。在本文中,作者在image和text特征之间引入了更深层次的融合(deep fusion),在最后几个encoder layer中进行了image和text的信息融合,如下图所示:

deep-fused encoder可以用以下公式来表示:

其中, X-MHA代表跨模态多头注意力模块(multi-head attention module),L代表DyHead中DyHeadModule的个数,BERTLayer是额外添加在预训练BERT模型之上的层, O 0 O^0 O0 是vision backbone提取的图像特征, P 0 P^0 P0 是language backbone提取的文字特征。

X-MHA是用于跨模态信息融合的关键模块 (cross attention) ,它的公式如下所示:

deep-fused有两个优点:

- 提升了phrase grounding的表现;

- 使得图像特征的学习与文字特征产生关联,从而让text prompt可以影响到检测模型的预测。

(3)Pre-training with Scalable Semantic-Rich Data

- 同时使用目标检测和grounding数据;

- 另外通过利用gold data训练教师GLIP,使用这个教师模型来预测24M web image-text数据,为image caption数据得到了检测伪标签;

- 也就是说,GLIP可以同时利用目标检测数据集,grounding数据集,image caption数据集,极大丰富了训练数据量;

3. 实验

(1)数据集简介

- COCO:目标检测数据集,包含80个常见对象类别;

- LVIS:目标检测和实例分割数据集,涵盖1203个对象类别;

- Object365:是一个大规模的目标检测数据集,总共包含63万张图像,覆盖365个类别,高达1000万框数;

Microsoft COCO Captions 数据集:该数据集为超过 33 万张图片提供了超过 150 万条人工生成的图片描述。- Flickr30k:给定了31783张图像以及158915个文本注释,一张图片对应5个注释,并将它们与 276K 个手动标注的边界框关联起来。

- Visual Genome(VG)是斯坦福大学李飞飞组于2016年发布的大规模图片语义理解数据集,数据集汇总最主要的构成是Region Description,每个region/bbox都有与其对应的一句自然语言描述。

- GQA数据集包含22,669,678个问题和113,018张图片,数据集中覆盖的词汇量有3,097个,答案类型有1,878个,同时也包含对应的bbox注释;

- Conceptual Captions (CC)是一个数据集,由约 330 万张带有字幕注释的图像组成。

- SBU Captions数据集最初将图像字幕作为一个检索任务,包含 100 万个图片网址 + 标题对。

最后使用的数据集有:

- FourODs (2.66M data): 4 detection datasets including Objects365, OpenImages, Visual Genome (excluding COCO images), and ImageNetBoxes

- GoldG (0.8M): human-annotated gold grounding data curated by

MDETR, including Flickr30K, VG Caption and GQA. - Cap4M / Cap24M

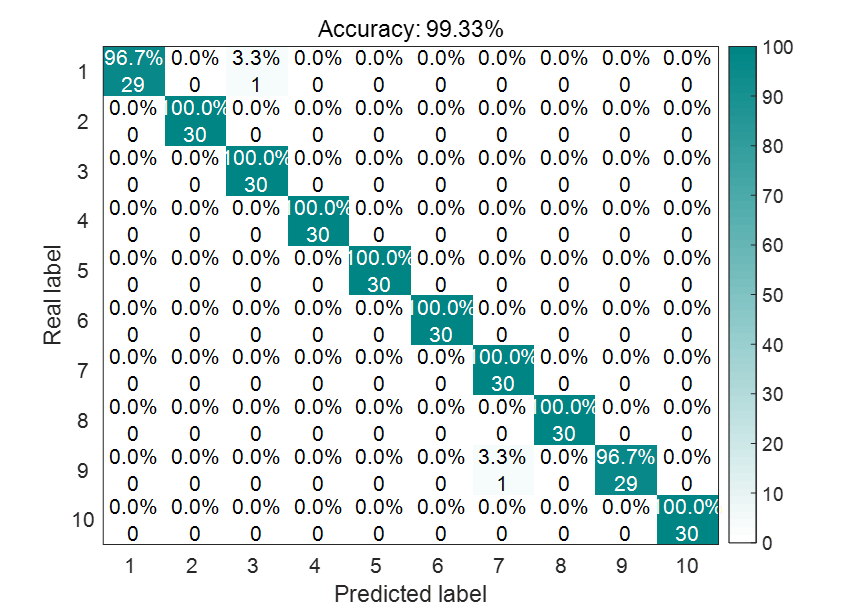

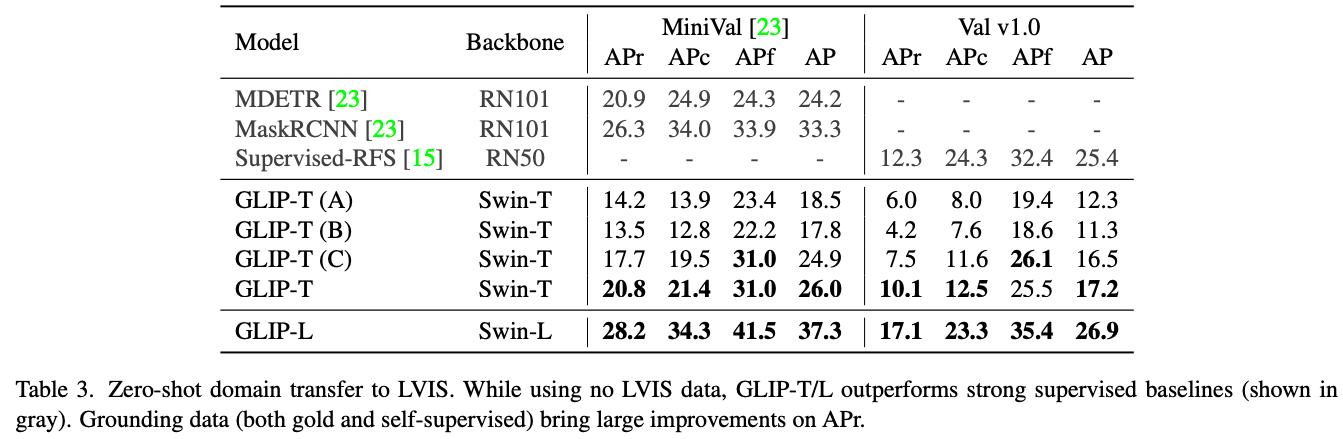

(2)GLIP消融实验

作者设计了多个版本的GLIP用于对比试验:

- GLIP-T(A):基于SoTA模型Dynamic Head,将其中的分类损失替换为GLIP的alignment loss,预训练数据为Objects365(66万人工标注数据);

- GLIP-T(B):在GLIP-T(A)的基础上加入deep fusion;

- GLIP-T©:在预训练数据中加入GoldG(80万人工标注数据);

- GLIP-T:加入更多数据:Cap4M(400万网上爬取的数据);

- GLIP-L:基于Swin-Large,并采用更大量的数据集,包含:FourODs(2.66M)、GoldG(0.8M)、Cap24M(24M);

由于 Objects365 覆盖了 COCO 中的所有类别,因此Objects365 预训练的 DyHead-T 在COCO上表现优异,达到了43.6AP; 若将模型重新构建为grounding模型,性能略有下降 (GLIP-T (A)); 添加深度融合将性能提升 2AP (GLIP-T (B)); GoldG数据对性能的提升贡献最大,GLIP-T © 达到 46.7 AP。 虽然添加图像-文本数据对 COCO 有轻微或没有改进(GLIP-T 与 GLIP-T ©),作者发现它对于推广到稀有种类至关重要,并在LVIS 实验中进一步展示了这一现象。

Gold grounding数据使 Mini-Val APr (GLIP-T© 与 GLIP-T (B)) 相比提高了 4.2 个点。这进一步表明grounding数据对性能的提升有显著的贡献。另外,添加图像-文本数据进一步提高了 3.1 个点的性能。因此,基础数据的语义丰富性可能有助于模型识别稀有物体。

参考

- 如何看待微软的Grounded Language-Image Pre-training(GLIP)?