目录

- 1. 本质联系:都是“数学函数拟合器”

- 2. Transformer vs 传统神经网络

- (1) 传统神经网络的局限

- (2) Transformer的突破

- 3. Transformer如何借鉴并改进神经网络?

- 4. 直观例子:翻译任务

- 5. 结构对比图

- 传统RNN(如LSTM)

- Transformer

- 6. 为什么Transformer更强大?

- 7. 总结:进化关系

Transformer 和传统神经网络(如RNN、CNN)的核心目标是一致的——通过数学模型学习数据中的规律,但Transformer通过独特的结构解决了传统神经网络的许多痛点。以下是它们的联系和区别的通俗解析:

1. 本质联系:都是“数学函数拟合器”

- 共同目标:将输入数据(如文本、图像)映射到输出(如翻译结果、分类标签)。

- 核心方法:通过层层非线性变换(权重计算 + 激活函数)逐步提取高级特征。

- 训练方式:都用梯度下降优化参数,最小化预测误差。

2. Transformer vs 传统神经网络

(1) 传统神经网络的局限

-

RNN(循环神经网络)

- 问题:必须逐字处理序列,速度慢且难以记住长距离依赖(比如段落开头的关键词影响结尾)。

- 例子:翻译长句子时,RNN可能忘记开头的主语。

-

CNN(卷积神经网络)

- 问题:擅长捕捉局部特征(如图像边缘),但难以建模全局关系(如文本中远距离的词关联)。

(2) Transformer的突破

-

自注意力机制(Self-Attention):

- 直接计算序列中所有元素两两之间的关系,无论距离多远。

- 例子:翻译句子时,动词可以直接关联到句首的主语,无视中间隔了多少词。

- 效果:解决了RNN的“记忆短”和CNN的“局部视野”问题。

-

并行计算:

- 传统RNN必须串行计算,Transformer像CNN一样并行处理所有输入,极大加速训练。

3. Transformer如何借鉴并改进神经网络?

| 组件 | 传统神经网络 | Transformer的改进 |

|---|---|---|

| 信息传递 | RNN靠隐藏状态逐步传递信息(易丢失) | 自注意力直接关联任意位置(全局建模) |

| 特征提取 | CNN用卷积核扫描局部特征 | 多头注意力多角度捕捉局部和全局特征 |

| 位置处理 | RNN依赖顺序输入,CNN隐含位置信息 | 显式添加位置编码(保留顺序信息) |

| 层次结构 | 深层网络梯度消失/爆炸 | 残差连接(Residual)+ 层归一化稳定训练 |

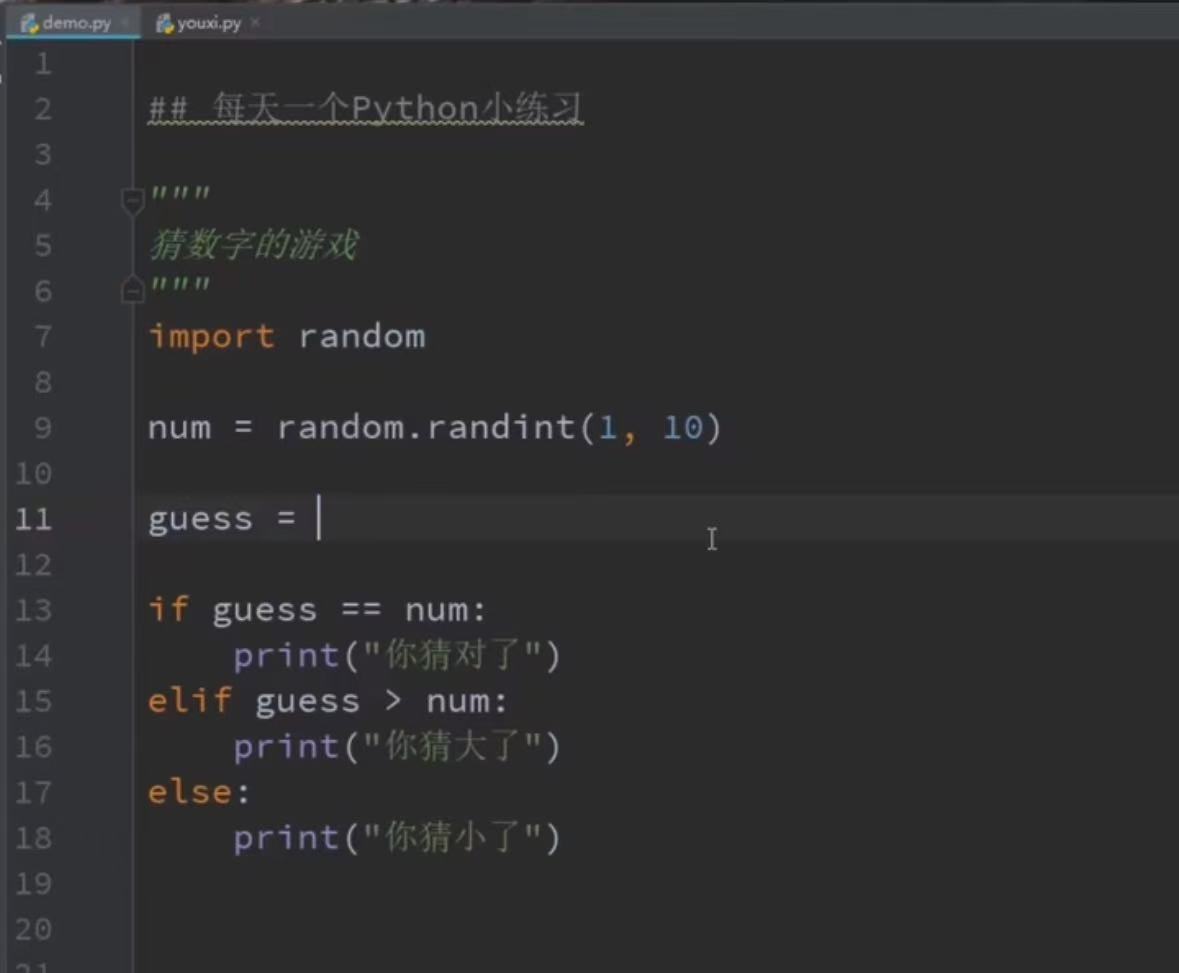

4. 直观例子:翻译任务

-

RNN的做法:

"The cat sat on the mat" → 逐词输入,隐藏状态传递 → 输出翻译- 问题:读到“mat”时可能已忘记“cat”是主语。

-

Transformer的做法:

- 同时看所有词,计算“sat”与“cat”、“mat”的关联权重。

- 直接建立“cat→sat→mat”的语义链,无视距离。

- 输出更准确的翻译。

5. 结构对比图

传统RNN(如LSTM)

graph LR

A["词1"] --> B["LSTM"]

B --> C["隐藏状态1"]

A --> D["词2"] --> E["LSTM"] --> F["隐藏状态2"]

C --> E

- 信息单向流动,依赖隐藏状态传递。

Transformer

graph TD

A["词1"] --> B[自注意力]

A --> C["词2"] --> B

A --> D["词3"] --> B

B --> E[全连接层]

- 所有词直接交互,通过注意力权重动态聚焦关键信息。

6. 为什么Transformer更强大?

- 长处:

- 处理长文本(如GPT-4支持128K上下文)。

- 并行计算(训练速度比RNN快数倍)。

- 可扩展性(模型参数可达万亿级)。

- 代价:

- 计算资源需求高(需要GPU集群)。

- 数据饥渴(依赖海量训练数据)。

7. 总结:进化关系

- 神经网络是基础框架(如人的神经系统)。

- RNN/CNN是早期专用模型(各有所长,但缺陷明显)。

- Transformer是新一代通用架构(结合全局理解+并行计算,成为当前AI基石)。

就像从“自行车(RNN)”→“汽车(CNN)”→“高铁(Transformer)”的升级,速度、容量和效率全面提升! 🚄