目录

- 1. 核心作用

- (1) 引入非线性

- (2) 增强特征表达能力

- 2. ReLU的独特优势

- (1) 缓解梯度消失问题

- (2) 计算高效

- (3) 稀疏激活

- 3. 在活体猪IMF预测中的应用

- (1) 网络结构中的位置

- (2) 实际效果

- 4. ReLU的局限性及改进

- (1) 神经元死亡(Dead ReLU)

- (2) 输出非零中心化

- 5. 与其他激活函数对比

- 6. 总结

激活函数是神经网络中的核心组件,其作用是为模型引入非线性变换,使网络能够学习复杂的特征和关系。以ReLU(Rectified Linear Unit)为例,以下是其具体作用及原理:

1. 核心作用

(1) 引入非线性

- 问题:如果没有激活函数,神经网络仅是线性变换的堆叠(无论多少层,最终等效于一个线性模型)。

- 解决:激活函数(如ReLU)通过非线性映射,使网络可以拟合任意复杂函数(如CT图像中脂肪分布的复杂模式)。

- 例如:ReLU的函数为

f(x) = max(0, x),在正值区间线性,在负值区间截断,整体非线性。

- 例如:ReLU的函数为

(2) 增强特征表达能力

- 卷积层提取的特征(如边缘、纹理)通过ReLU过滤:

- 保留重要特征(正值部分被激活)。

- 抑制噪声(负值部分置零,减少干扰)。

- 例如:在CT图像中,ReLU可能强化脂肪区域的像素响应,弱化无关背景。

2. ReLU的独特优势

(1) 缓解梯度消失问题

- 传统激活函数(如Sigmoid、Tanh):在输入极大或极小时,梯度接近0,导致深层网络难以训练。

- ReLU的梯度:

- 正区间梯度恒为1,反向传播时梯度稳定传递。

- 负区间梯度为0,但实践中稀疏性反而有助于减少过拟合。

(2) 计算高效

- Sigmoid/Tanh:需计算指数,耗时较高。

- ReLU:仅需比较和取最大值,速度极快,适合大规模数据(如3D CT影像)。

(3) 稀疏激活

- 负输入输出0,使得部分神经元被“关闭”,网络更轻量且更具解释性。

- 例如:在IMF预测中,可能只有特定肋骨切片的神经元被激活,与脂肪分布相关。

3. 在活体猪IMF预测中的应用

(1) 网络结构中的位置

- 每个3D卷积层后接ReLU:

Conv3D → BatchNorm → ReLU → MaxPooling - 作用流程:

- 卷积提取局部特征(如脂肪纹理)。

- ReLU保留显著特征,抑制无关噪声。

- 池化进一步压缩特征维度。

(2) 实际效果

- 特征选择:ReLU帮助模型聚焦于CT图像中HU值(亨氏单位)较高的区域(如脂肪、骨骼)。

- 加速收敛:相比Sigmoid,ReLU使训练更快达到稳定状态(论文中RMSE快速下降)。

4. ReLU的局限性及改进

(1) 神经元死亡(Dead ReLU)

- 问题:若输入持续为负,神经元永久输出0,无法更新权重。

- 解决:

- Leaky ReLU:负区间引入微小斜率(如0.01x),保留少量梯度。

- Parametric ReLU (PReLU):斜率作为可学习参数。

(2) 输出非零中心化

- 问题:ReLU输出均≥0,可能导致梯度更新效率降低。

- 解决:

- 配合Batch Normalization(如论文中每个Conv后接BN),标准化输入分布。

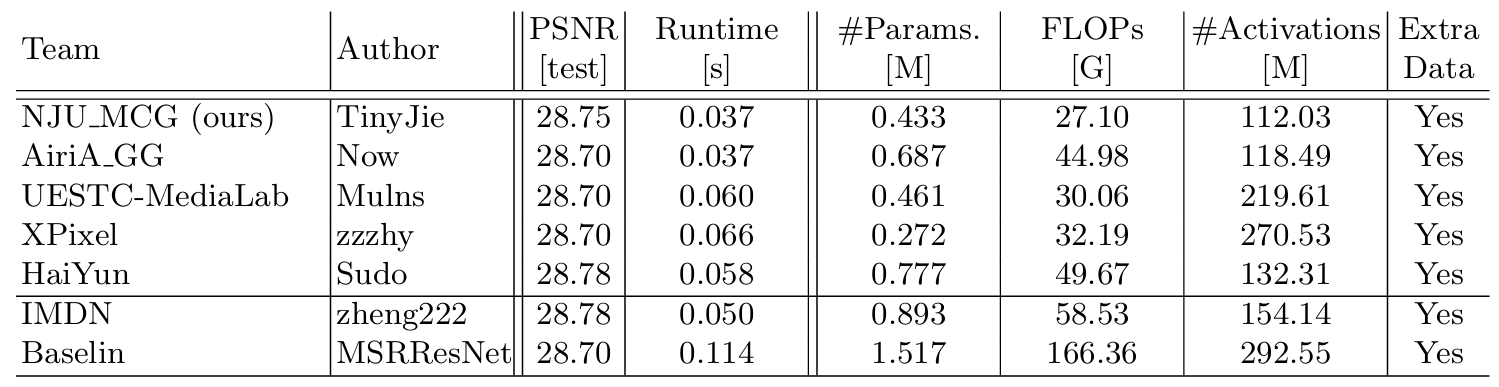

5. 与其他激活函数对比

| 激活函数 | 公式 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|---|

| ReLU | max(0, x) |

计算快,缓解梯度消失 | 神经元死亡 | 深度网络(主流选择) |

| Sigmoid | 1 / (1 + e⁻ˣ) |

输出平滑(0~1) | 梯度消失,计算慢 | 二分类输出层 |

| Tanh | (eˣ - e⁻ˣ)/(eˣ + e⁻ˣ) |

输出零中心化(-1~1) | 梯度消失 | RNN/LSTM |

| Leaky ReLU | max(αx, x) (α=0.01) |

缓解神经元死亡 | 需调参α | 替代ReLU |

6. 总结

- 核心作用:ReLU通过非线性变换,使神经网络能够拟合复杂数据(如CT影像的脂肪分布)。

- 在IMF预测中的价值:

- 与3D卷积结合,高效提取肋骨区域的空间特征。

- 加速训练,提升模型对活体猪IMF含量的回归精度。

- 改进方向:若模型出现神经元死亡,可尝试Leaky ReLU或调整BN层参数。

通过合理使用激活函数,3D CNN能够从CT序列中学习到区分脂肪与非脂肪区域的关键特征,最终实现高精度的无损检测。