模型上下文协议(MCP)简介

人工智能的快速发展,特别是大型语言模型(llm),在生成类人文本、解决复杂问题和提高各行业生产力方面释放了前所未有的潜力。然而,一个持续存在的挑战仍然存在:这些模型通常与为现代工作流程提供动力的实时动态数据隔离。将 AI 连接到外部系统-无论是数据库,api 还是生产力工具。它们通常需要特定

的集成,创造了一个碎片化的环境,扼杀了可扩展性和创新。模型上下文协议(MCP),由 Anthropic 开创的一个开放标准,以弥合这一差距。

MCP 由 Anthropic 提出,承诺通过为无缝数据集成提供通用的标准化框架,重新定义 AI 与工具的交互方式。就像 TCP/IP 标准化网络通信或 ODBC 改变数据库连接一样,MCP 渴望成为互联 AI 生态系统的支柱。

本文描述了 MCP 的理论基础、架构和变革潜力,探讨了为什么它可以标志着智能系统进化的转折点。

- 什么是模型上下文协议(MCP)?

- MCP是如何工作的?

- MCP(模型上下文协议)详细分析

- MCP解决了什么问题?

- MCP体系结构

- 关键组件和功能

- 假设用例

- MCP的好处

- MCP的采用

- 结论

什么是模型上下文协议(MCP)?

模型上下文协议(MCP)是一个框架,旨在使 AI 模型,特别是大型语言模型(llm)更容易与外部数据(如文件、数据库或 api)连接。它就像一个通用插头,让 AI与不同的系统“交谈”,而不需要为每个系统定制设置。

模型上下文协议标志。

由 Anthropic 开发的 MCP 是开源的,这意味着任何人都可以使用和改进它,它旨在通过访问实时数据帮助 AI 给出更好、更相关的答案。

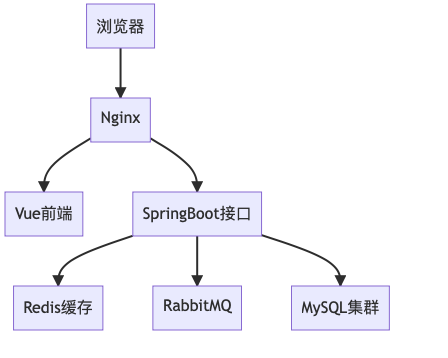

MCP 是如何工作的?

MCP 在client-server模型上运行。AI 应用程序(“host”,如聊天工具或 IDE)使用 MCP 客户端连接到 MCP 服务器,这些服务器是暴露特定功能的程序,例如获取数据或运行工具。

通信通过 JSON-RPC 2.0 进行,这是一种发送请求和获取响应的标准方式,使其对本地和远程连接都很灵活。例如,AI 助手可以使用 MCP 检查你的日历是否有空闲时段,服务器处理数据获取,客户端将其传递给 AI。

MCP(模型上下文协议)详细分析

MCP 通过标准化连接简化了开发,使扩展 AI 应用程序和在不同 AI 模型之间切换变得更容易。它还注重安全性,确保用户同意和数据隐私,这对敏感数据至关重要。

Block 和 Apollo 等早期采用者已经在使用它,在现实世界的工具中展示了它的实用价值。

MCP 解决了什么问题?

MCP 解决了“MxN”集成问题,即 M 个不同的 llm 需要连接 N 个不同的工具,从而导致定制解决方案的组合爆炸。通过提供单一协议,MCP 将这种复杂性降低到 N+M。

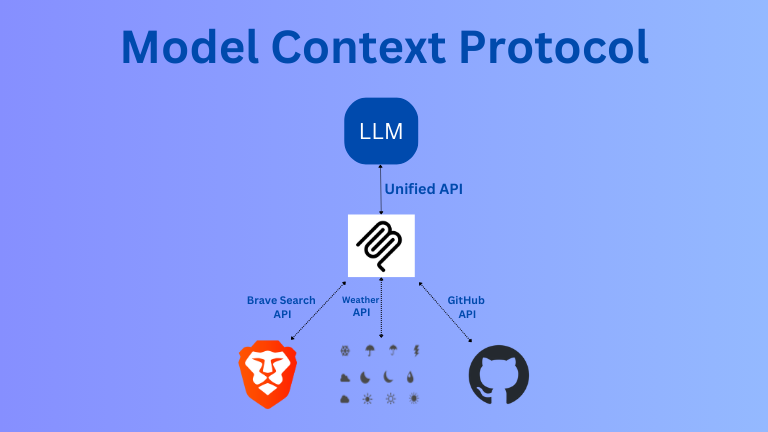

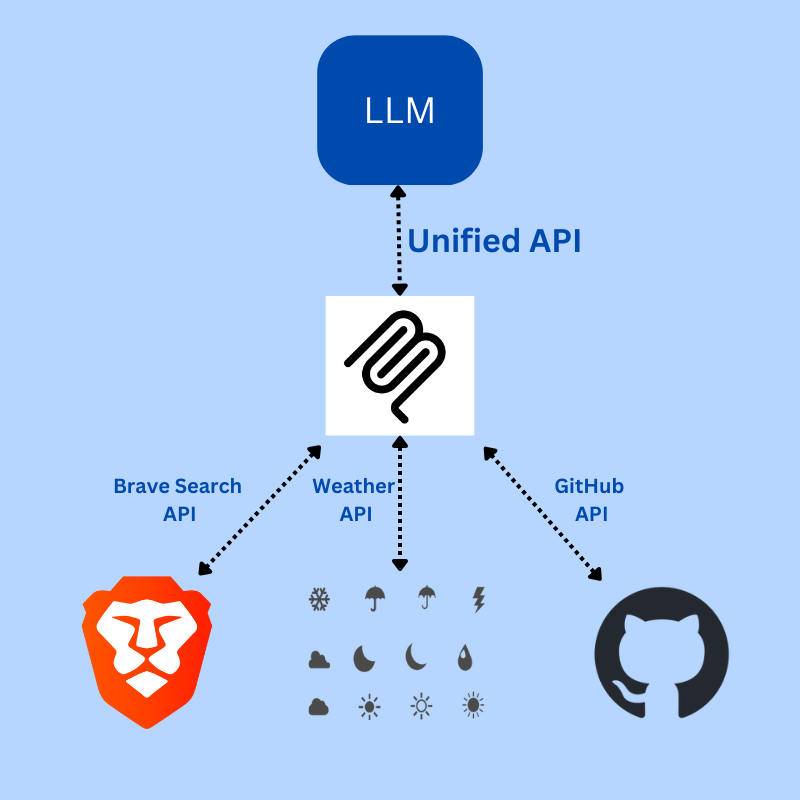

MCP 通过统一的 API 将 LLM 连接到各种应用程序。

其主要目的是通过打破信息孤岛和遗留系统障碍,增强前沿模型产生相关响应的能力。

由于 MCP 是开源的,有一个 GitHub 仓库,它的开放方法使得它成为 LLM 集成工具的下一个标准至关重要。

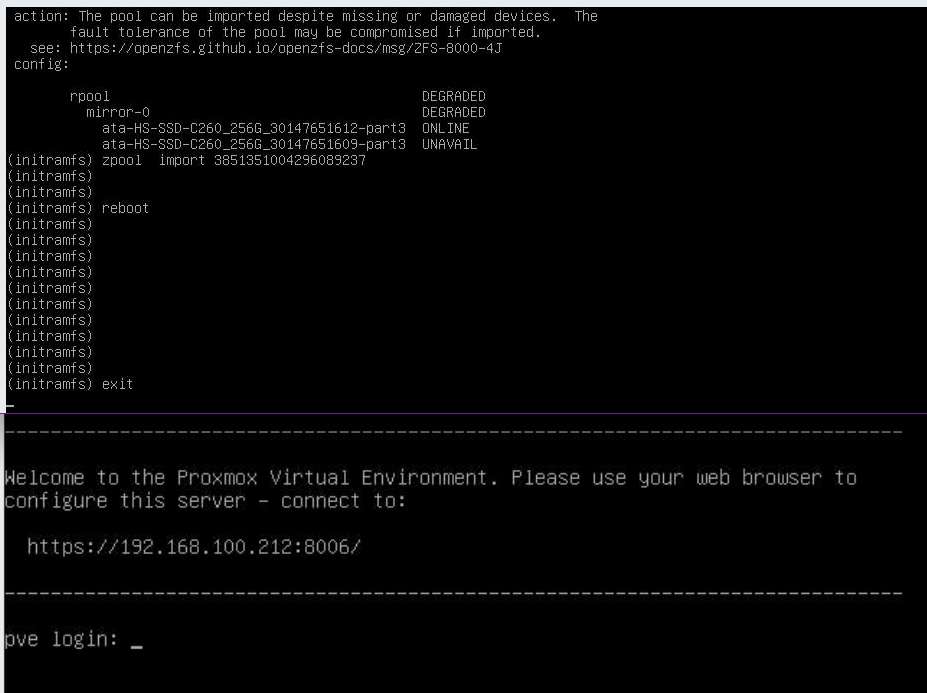

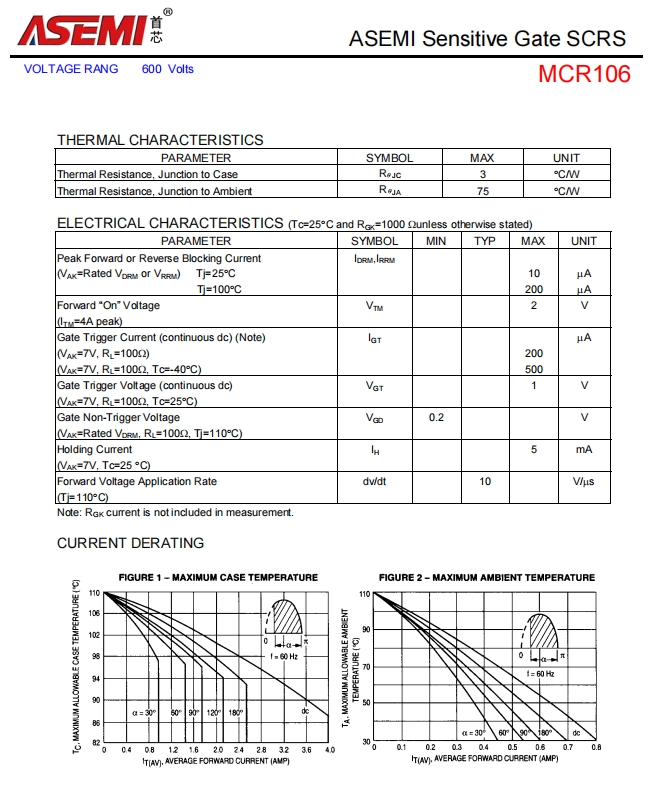

MCP 体系结构

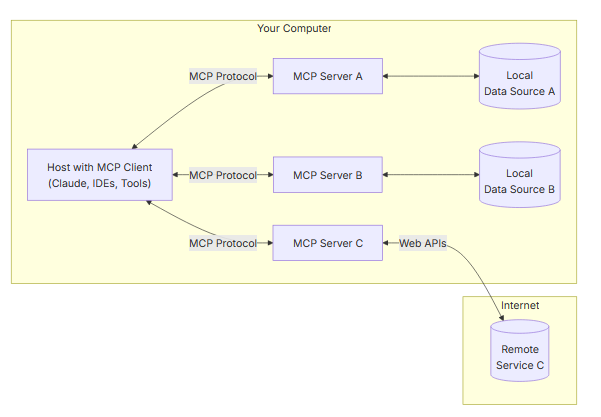

MCP 在client-server架构上运行,在模型上下文协议规范中有详细说明。

MCP架构。

该体系结构包括三个主要部分:

| 组件 | 描述 |

|---|---|

| Host Process | 管理 MCP 客户端、控制权限、生命周期、安全性和上下文聚合的主要 AI应用程序(例如 Claude Desktop、IDE)。 |

| MCP Clients | host内的中介体,每个中介体连接到一个 MCP 服务器,通过 JSON-RPC 2.0处理通信,确保安全性和沙箱。 |

| MCP Servers | 轻量级程序通过 MCP 公开功能(资源、提示、工具),支持本地的 studio和使用服务器发送事件(SSE)进行远程通信的 HTTP。 |

JSON-RPC 2.0 促进了通信,其灵感来自于语言服务器协议,如规范中所述。这允许请求、结果、错误和通知,确保健壮的交互。

关键组件和功能

MCP server提供三种主要功能:

| 能力 | 描述 |

|---|---|

| Resources | 数据源,如文件、数据库记录或 API 响应,为 AI 提供上下文。 |

| Prompts | 模板消息或工作流指导 AI 响应或任务,增强交互。 |

| Tools | 执行 AI 的功能,例如发送电子邮件或与服务交互,启用可操作性。 |

另一方面,客户端支持采样,允许服务器发起的代理行为进行递归 LLM 交互。配置、进度跟踪、取消、错误报告和日志记录等实用程序确保了平稳的操作和管理。

假设用例

为了说明这一点,请考虑一个 AI 助手通过访问用户的日程来安排会议。Host(例如,Claude Desktop)使用 MCP 客户端连接到与日程服务接口的 MCP 服务器。AI 通过客户端发送请求,服务器获取并返回数据(例如,空闲槽),AI 使用它来生成响应。

另一个例子是医疗环境中的 AI 安全地访问患者记录。MCP 服务器确保获得用户同意、数据加密和访问记录,符合 MCP 的用户控制、数据隐私、工具安全和 LLM采样控制的安全原则。

MCP 的好处

MCP 的标准化降低了集成的复杂性。它增强了可伸缩性,允许通过 MCP 服务器轻松添加新数据源,并且与模型无关,便于在 LLM 提供商之间切换。

MCL 支持 Python、TypeScript、Java 和 Kotlin 的 sdk。在 Anthropic 的新闻中提到的 Block、Apollo、Zed、Replit、Codeium 和 Sourcegraph 等早期采用者都展示了实际的采用

MCP 的采用

MCP 的多功能性在跨领域的用例中是显而易见的:

| Domain | Examples |

|---|---|

| Productivity Tools | 管理文件、电子邮件、日历和 Slack 等协作平台。 |

| Development | 与 Git、GitHub、数据库进行交互,用于编码、调试、部署。 |

| Customer Support | 检索 CRM 数据,创建票据,通过 AI 聊天机器人更新记录。 |

| Research/Analysis | 查询数据库,获取 API 数据以获取见解和报告。 |

预先构建的谷歌 Drive, Slack, GitHub, Git, Postgres 和 Puppeteer 的 MCP 服务器已经可用,易于集成。

结论

模型上下文协议(MCP)代表了 AI 集成的重大飞跃,解决了互操作性、可扩展性和安全性方面的长期挑战。通过提供标准化的开源框架,MCP 简化了将 llm 连接到外部数据源、工具和工作流的过程,消除了复杂的一次性集成的需要。

随着 AI 的不断发展,与动态、真实数据无缝交互的能力对于构建真正智能和响应性强的应用程序至关重要。MCP 为更加互联的 AI 生态系统奠定了基础,使开发人员能够以最小的摩擦创建更智能,更强大的 AI 系统。随着越来越多的采用和不断的创新,MCP 有可能成为 AI 工具集成的行业标准,就像 TCP/IP 在网络中的作用一样。

![B3708 [语言月赛202302] 神树大人挥动魔杖](https://img2024.cnblogs.com/blog/3619440/202503/3619440-20250328141952449-312541226.png)