一、Tair KVCache 简介

Tair KVCache 是阿里云瑶池旗下云数据库 Tair 面向大语言模型推理场景推出的 KVCache 缓存加速服务。

随着互联网技术的演进与流量规模的激增,缓存技术逐渐成为系统架构的核心组件。该阶段催生了 Redis 等开源缓存数据库,阿里巴巴基于自身业务需求自主研发了 Tair 分布式缓存系统。历经十年技术沉淀,该系统已支撑阿里云百万企业客户及阿里巴巴集团双11等核心场景的超高并发需求。

当前大语言模型(LLM)推理的快速发展推高了算力需求,与此同时,推理过程中的 KVCache 技术所需的巨大显存消耗成为显著瓶颈。KVCache 技术通过缓存历史 Token 的 Key/Value 向量矩阵避免重复计算,虽将时间复杂度从 O(n²) 降至 O(n),却导致显存占用随生成长度线性暴增,成为制约长文本生成和批量推理的核心瓶颈。

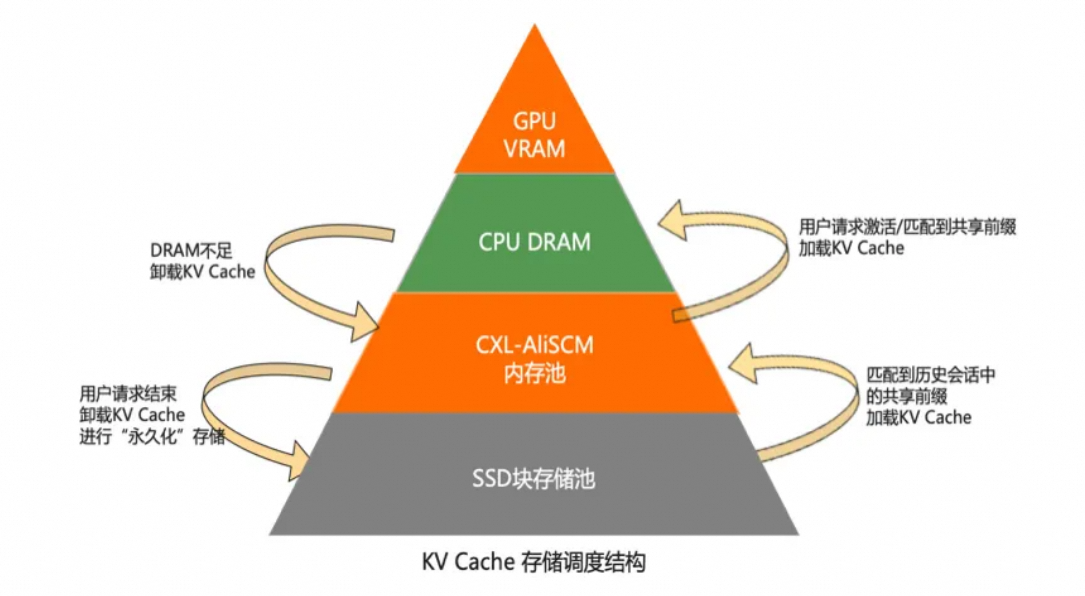

Tair KVCache 通过构建显存-内存-存储三级缓存体系,实现 KVCache 动态分层存储,将 KVCache 由“纯显存驻留”升级为“分级缓存架构”,在提升计算效率的同时显著扩展上下文长度,成为加速 LLM 推理的核心组件。

二、AI 场景对内存的需求

(一) HBM容量瓶颈

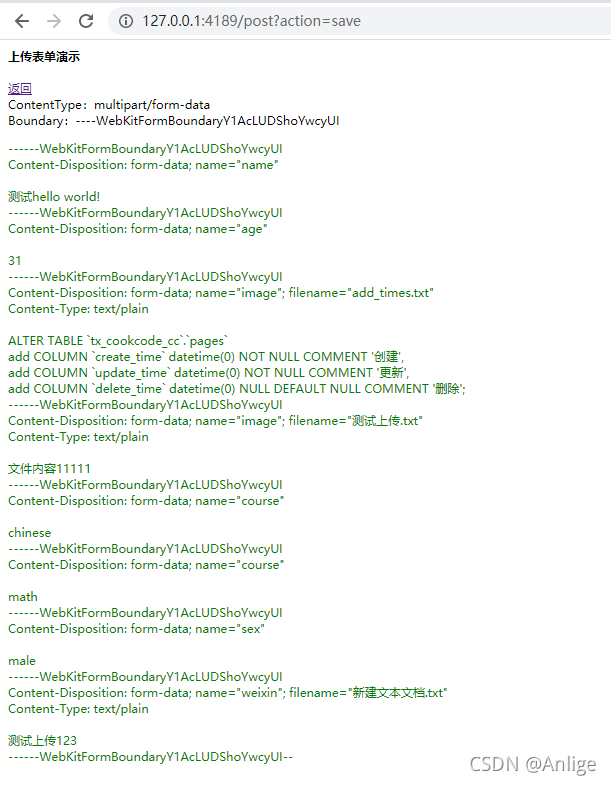

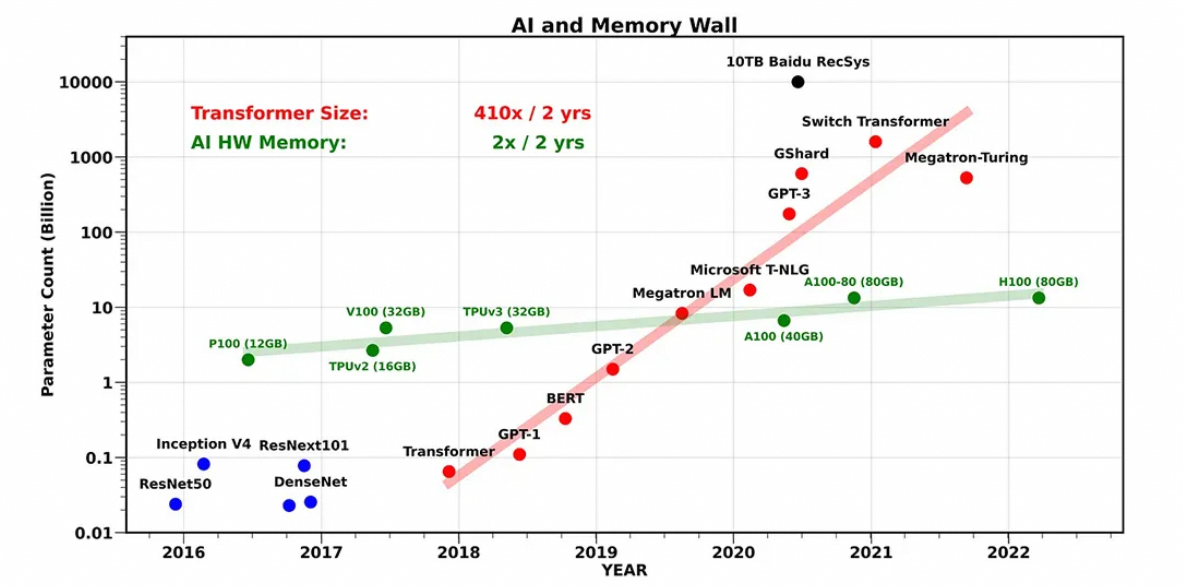

当前人工智能模型的规模扩张已彻底脱离硬件发展的线性轨道,存储容量与算法需求间的代际鸿沟日益凸显。以 Transformer 架构为核心的尖端模型(如 DeepSeek-R1、ChatGPT4.5)正以两年 240 倍的指数级速度突破参数边界,逐步挺进万亿参数时代,而同期主流AI硬件的高带宽存储器(HBM)容量却仅能维持两年约 1.8 倍的缓慢爬升(如 NVIDIA GPU 从 A100 的 80GB 到 H100 的 141GB)。这意味着:容量增速脱节 —— 模型参数量增速达 240 倍/两年 vs. HBM 容量增速仅 1.8 倍/两年,二者相差超过 130 倍;硬件与算法间的失衡发展,成为了 AI 算力进化的基础性约束条件。

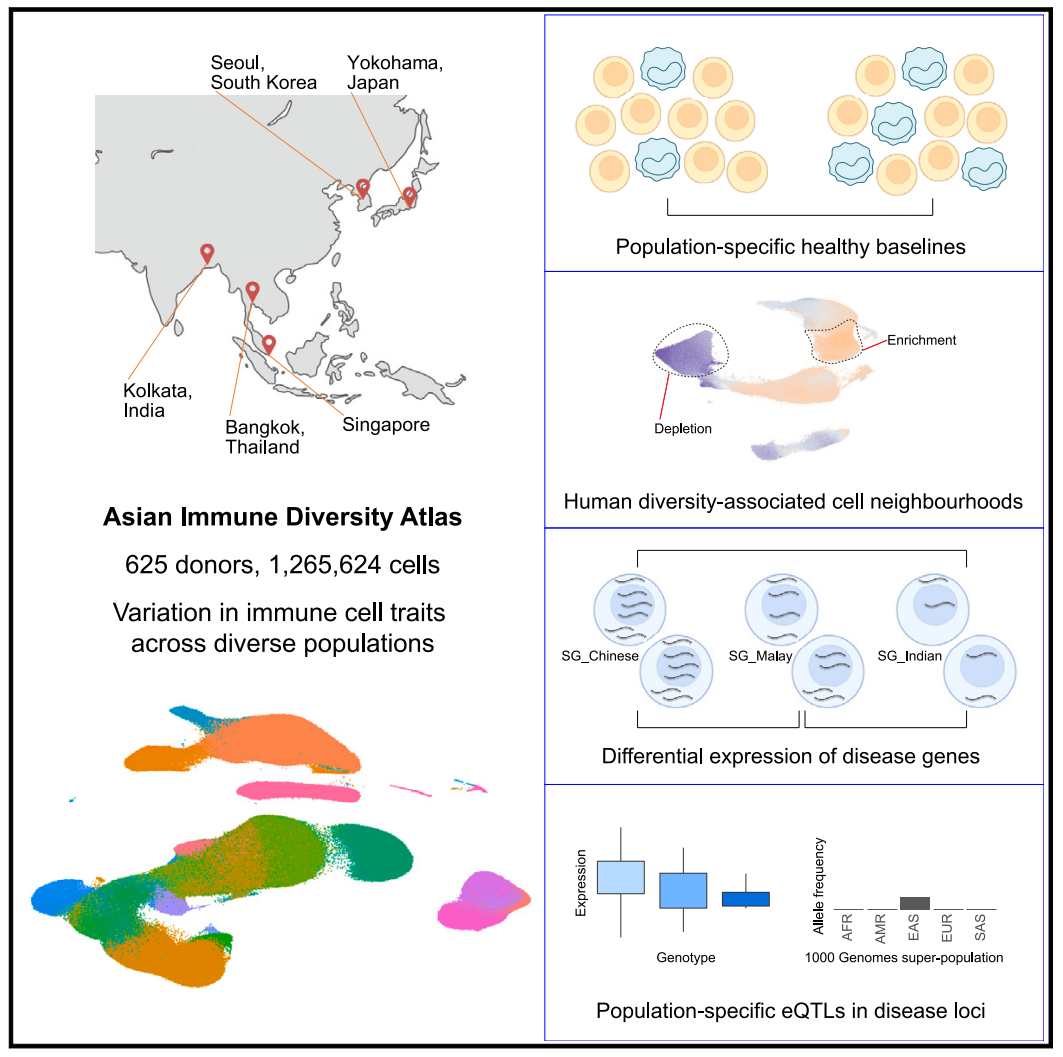

图1:AI和内存墙 [1]

(二)带宽瓶颈

在大语言模型推理场景中,当尝试将部分计算数据从高速 HBM 内存扩展到本地DRAM、SSD 或通过 RDMA 协议扩展至远端存储时,带宽资源的约束成为核心挑战。由于模型参数和推理过程中动态生成的 KVCache 通常优先驻留在 HBM 中,当模型规模超出 HBM 容量上限时,数据被迫向 DRAM 或 SSD 换入换出,此类低速存储介质的带宽(例如 SSD 带宽仅为 HBM 的百分之一)会严重拖累推理效率。若存储层级间的带宽不足,会导致计算单元频繁因数据等待而空闲,显著降低硬件利用率。

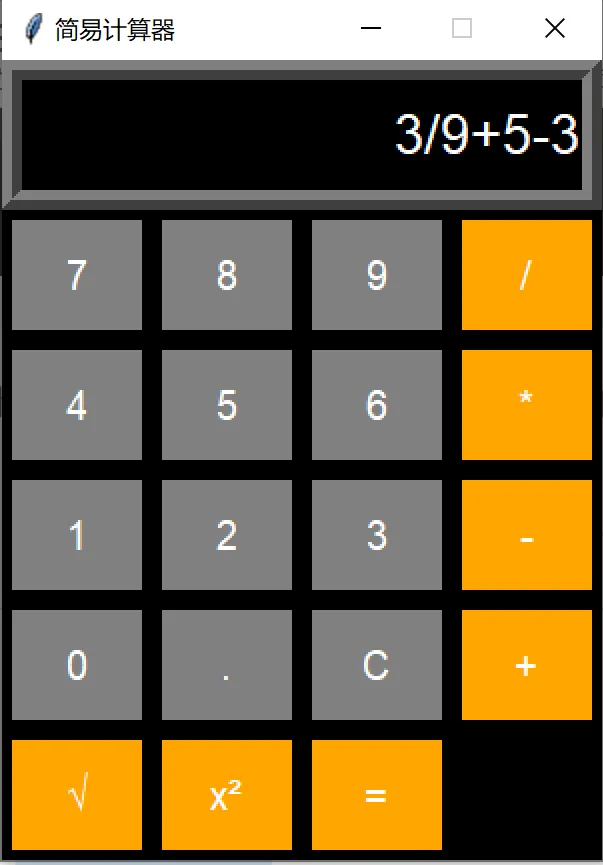

表1:存储介质带宽

为应对这一矛盾,如何基于有限带宽充分挖掘 DRAM 和 SSD 的容量潜力以加速推理服务,成为亟待突破的技术难点。即使通过本地资源扩展技术缓解容量压力,仍可能面临以下问题:

- 资源利用率不均衡:不同负载场景下易出现局部资源闲置;

- 本地容量天花板:超大规模模型仍需跨节点资源协同;

- 分布式扩展代价:构建资源池化架构虽能提升弹性,但会加剧网络带宽竞争,需通过数据亲和性调度优化通信路径。

(三)产品服务化内存加速需求

当推理服务从单机扩展到分布式提供产品化服务,通常还需要使用相关的内存加速服务:

• 队列化负载均衡:由于单个推理请求特别是 Reason 类的模型执行耗时较长(秒级至分钟级),需通过内存队列实现请求缓冲。

• 分布式协同开销:多节点推理需同步处理任务切分、中间状态同步、结果聚合,跨节点通信延迟易成为吞吐量提升的瓶颈。

• 多轮对话缓存:针对 LLM 生成式任务(文本续写、多轮问答),需在内存中维持会话状态缓存(Session Cache),支持历史上下文快速检索以保障前端交互流畅性。

• 动态限流控制:基于令牌桶之类算法实施请求速率限制,防止恶意高频请求(如 DDoS 攻击)过度抢占 GPU 计算资源。

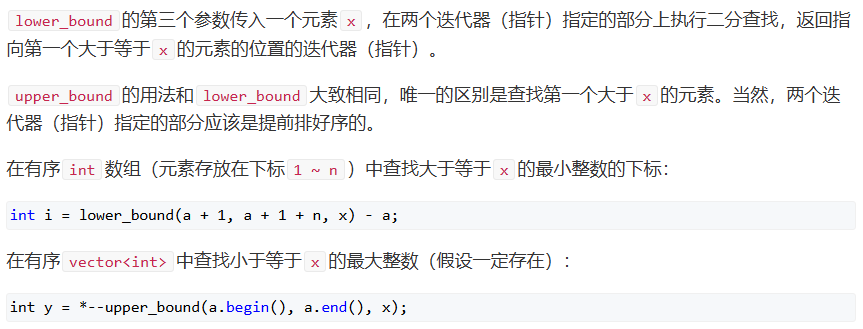

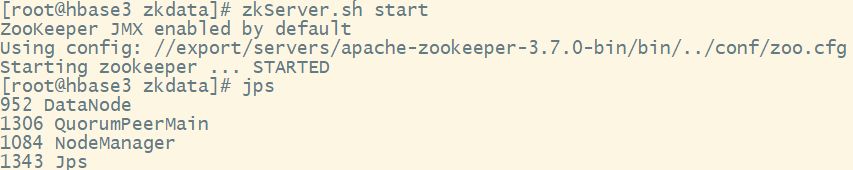

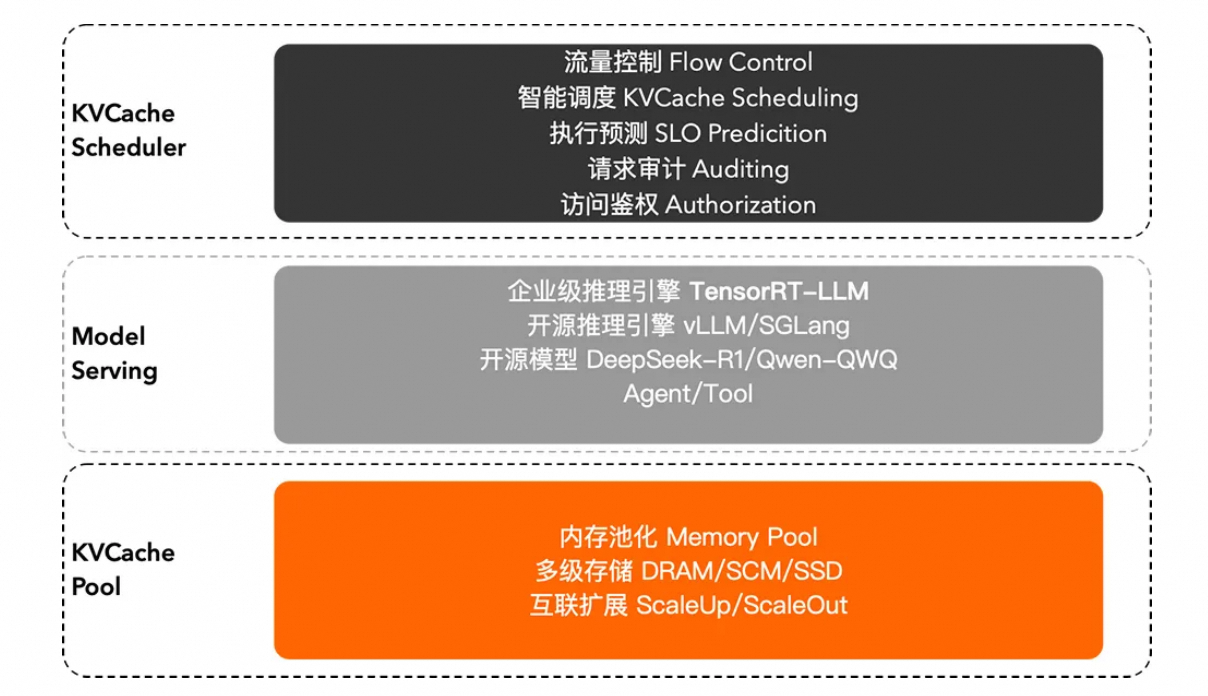

三、面向 AI 推理的 KVCache

Tair KVCache 通过软硬协同设计的池化实现,完成显存容量的灵活扩展与计算资源的高效解耦;同时上层的调度组件充分利用内存的加速能力,支持如限流、亲和性调度、对话缓存加速、执行预测等产品化服务需求。基于通用的模型和推理引擎,无缝兼容主流大语言模型架构,达成端到端百 GB 级 KVCache 吞吐与毫秒级响应,满足高并发、低延迟的生成式 AI 场景需求。

图2:Tair KVCache 介绍

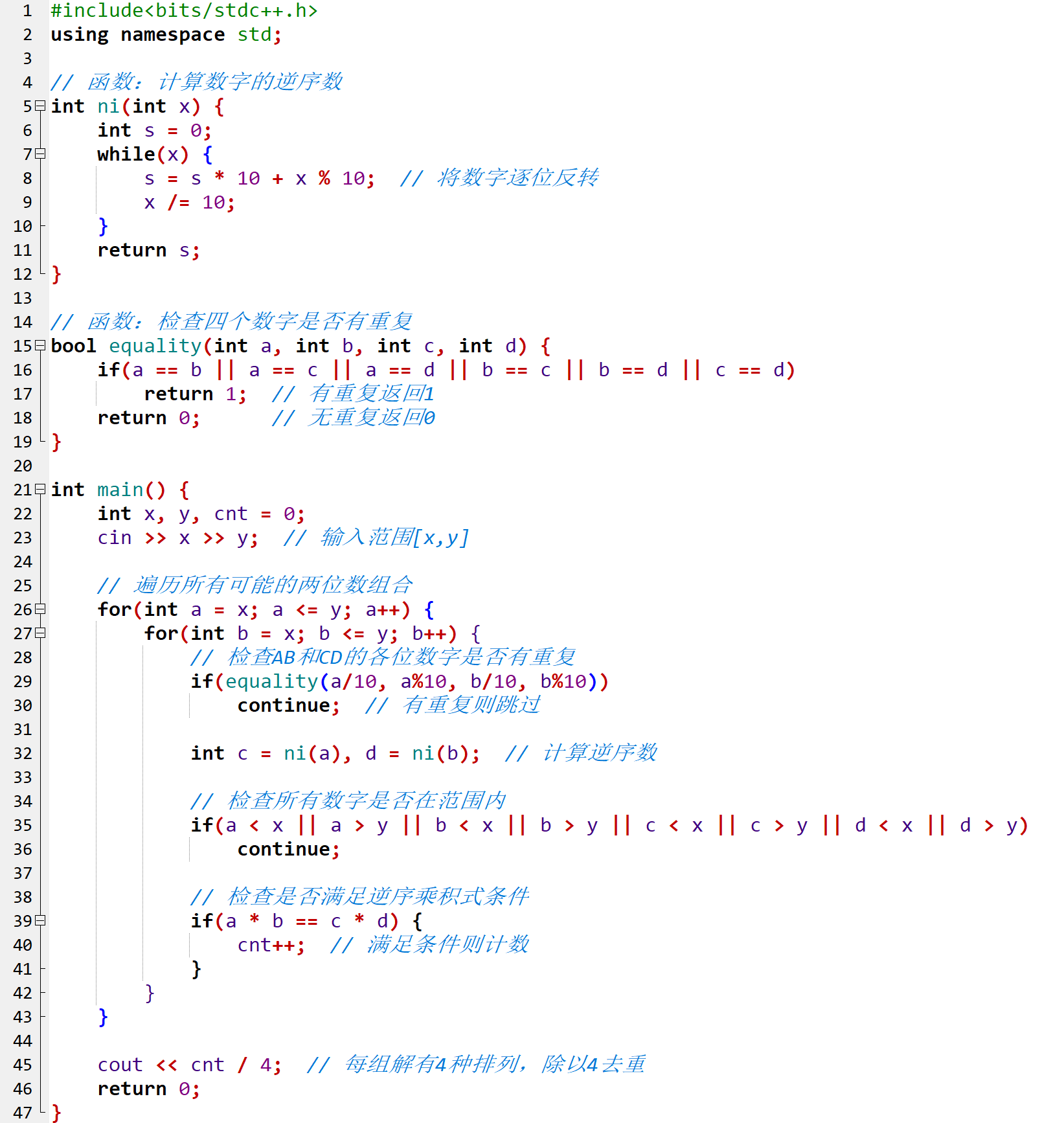

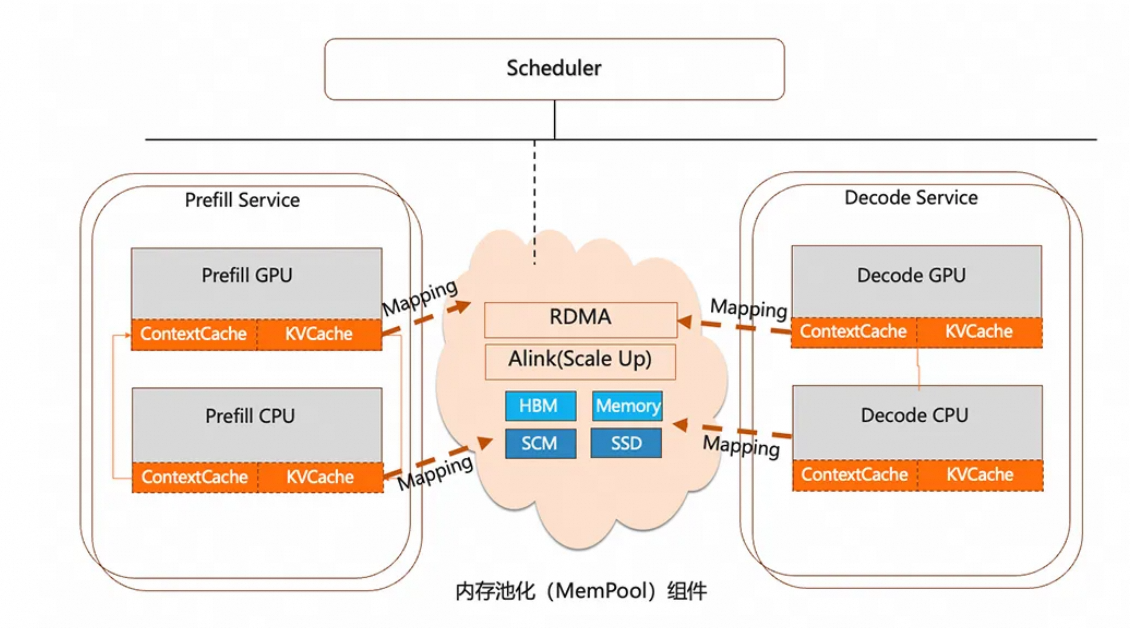

(一)分布式内存池化

Tair KVCache 利用 GPU 集群空闲内存组成分布式内存池, 按需计费节省单机空闲内存,同时可以突破单机内存瓶颈。

分布式内存池化的核心目标是通过统一管理多级存储资源(GPU 显存、CPU 内存、SSD、远端存储),实现显存容量扩展 与 计算资源解耦。

KVCache 是 Transformer 推理中除权重以外显存占用主体,其 Offload 设计直接影响大模型推理效率:

• 通过将 KVCache 卸载至分布式池化存储,单卡显存仅需保留热数据,达到支持:

1)更大 Batch Size:实验显示批处理规模提升 5-10 倍;

2)长上下文处理:如百万 Token 级输入(需数百 GB KVCache)。

• 计算与带宽优化,以存代算:复用历史 KVCache(如对话缓存),减少重复计算,加速推理,TTFT(首 Token 时间)缩短为原来的 1/10。

(二)多级 KVCache 分配管理

Tair KVCache 通过软硬协同设计实现存储资源的最优调度。核心围绕三大目标展开:易用性统一抽象、性能极致优化、架构前瞻扩展,结合分层存储特性与新型硬件协议,打造适应大模型推理的高吞吐多级 KVCache 池化方案。

• 易用性:提供统一的调用接口与错误处理接口,屏蔽底层物理差异,支持上层 Cache 调度与管理。

• 高性能:内存热点 Locality 感知,与调度器结合,提高内存资源利用率,充分发挥 KVCache 复用的性能优势,提高算力效率;根据底层互联特性,提供高效数据交互机制实现高带宽的 KVCache 共享。

• 可扩展:随着后续物理介质和互联协议的持续发展,能充分利用底层内存语义介质(AliSCM)和互联协议(Alink)系统平滑迁移,为 KVCache 提供极致高带宽与低成本,同时支持多样拓扑与分级 KVCache 的调度和管理机制。

图3:内存池化 MemPool 系统

图4:多级 KVCache 分配管理

(三)服务化支持

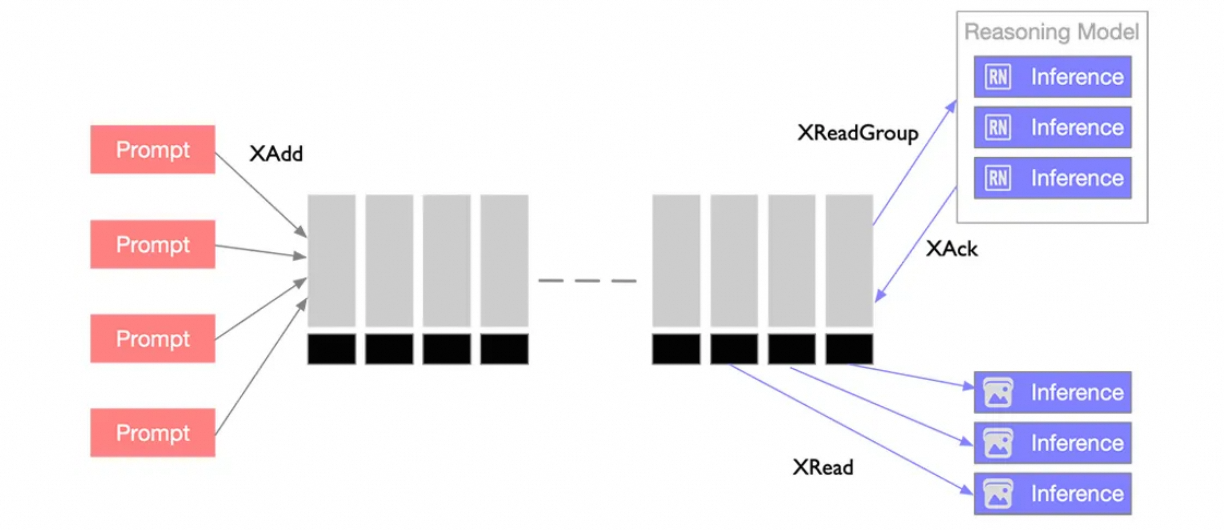

接着继续看看如何用基于内存的 Redis 语义接口来支持分布式服务,例如队列负载均衡、多轮对话缓存和动态限流控制。

- 队列化负载均衡

利用内存队列 Stream 可以把推理任务投递到 Stream 中,推理引擎做为消费者使用 XREADGroup 命令从所属任务组中按需拉取任务。支持阻塞式读取(等待新任务到达)或批量拉取,避免频繁轮询。多个推理引擎消费者属于同一任务时,Stream 自动将消息分配给不同的消费者,实现并行处理。每个消费者独立维护未确认(Pending)消息列表,确保任务不会被重复消费。

图5:队列推理负载均衡

2.多轮对话缓存

在多轮对话场景(如聊天机器人、客服系统)中,大模型推理服务需要依赖历史上下文生成连贯回复。可以利用内存的Hash结构来满足:1)快速存取——毫秒级响应,避免对话卡顿;2)上下文关联——支持按会话 ID(Session ID)快速检索完整历史;3)高并发支持——应对海量用户同时发起对话。

• 初始化会话生成唯一对话标识符session_id。

• 创建 Hash 结构并设置初始元数据,如HSET session:123 metadata '{"user_id": "abc", "model": "XXX"}'。

• 设置 TTL 实现自动过期,如EXPIRE session:123 3600。

• 存储多轮对话,如SET session:123:turn:5 "What's the capital of France?"。

- 限流控制

以恒定速率处理请求,超出桶容量的请求被丢弃或排队。用于:1)防止资源过载:避免计算资源被恶意或异常流量耗尽。2)保障服务质量:确保高优先级请求(如付费用户)的响应时间符合 SLA。

使用List结构模拟漏桶:

• 入队:新请求通过LPUSH加入队列。

• 出队:通过定时任务以固定速率PROP处理请求。

• 溢出控制:检查队列长度(LLEN),超过容量则拒绝新请求。

图6:限流服务

(四)兼容性

Tair KVCache 提供内存语义的访问接口,可以通过类似 Jemalloc 的内存分配器进行管理和分配,主流推理引擎如 TensorRT-LLM、vLLM、SGLang 均可以进行方便的适配。

四、总结

作为阿里云数据库为大语言模型推理场景量身打造的技术产品,Tair KVCache 凭借其创新的分布式内存池化和分级缓存体系,成功突破了大语言模型推理中的显存墙与带宽瓶颈问题。

通过软硬协同设计,Tair KVCache 实现了显存容量的灵活扩展与计算资源的高效解耦,支持更大 Batch Size 和长上下文处理,显著提升了推理效率和资源利用率。同时,其服务化支持与兼容性设计,为分布式推理场景提供了统一的 Redis 语义接口,能够轻松适配主流推理引擎。

Tair KVCache,不仅为万亿参数模型的高效推理提供了技术保障,也为 AI 算力的持续进化和规模化应用开辟了新的可能。