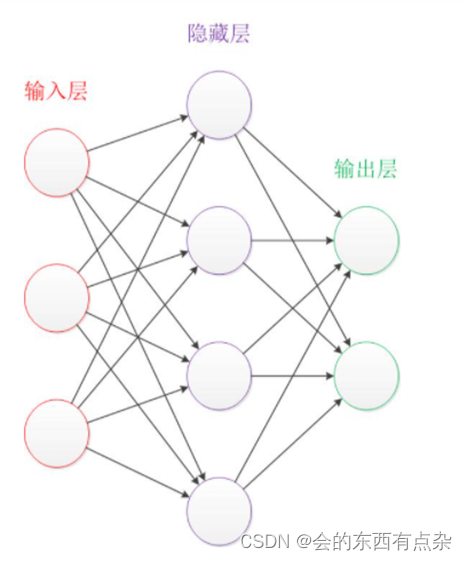

多层神经网络的结构

多层神经网络就是由单层神经网络进行叠加之后得到的,所以就形成了层的概念,常见的多层神经网络有如下结构:

1)输入层(Input layer),众多神经元(Neuron)接受大量非线形输入消息。输入的消息称为输入向量。

2)输出层(Output layer),消息在神经元链接中传输、分析、权衡,形成输出结果。输出的消息称为输出向量。

3)隐藏层(Hidden layer),简称 “隐层”,是输入层和输出层之间众多神经元和链接组成的各个层面。隐层可以有一层或多层。隐层的节点(神经元)数目不定,但数目越多神经网络的非线性越显著,从而神经网络的强健性(robustness)更显著。

4)全连接层,当前一层和前一层每个神经元相互链接,所谓的全连接层就是在前一层的基础上进行一次 Y=Wx+b 的变化(不考虑激活函数)。

激活函数

不管是单层还是多层神经网络,都只能线性地划分数据,此时,如果在感知机的基础上加上非线性激活函数,输出的结果就不在一条直线上了。激活函数可以增加模型的非线性分割能力。常见的激活函数有:

激活函数的作用除了前面说的增加模型的非线性分割能力外,还有:提高模型鲁棒性、缓解梯度消失问题、加速模型收敛等。